resnet34结构图

时间: 2024-01-30 10:02:54 浏览: 327

ResNet-34是一种深度残差网络,它由多个BasicBlock组成。每个BasicBlock包含两个卷积层和一个跳跃连接。下面是ResNet-34的结构图:

```

输入层 -> 卷积层 -> 批量归一化 -> ReLU激活函数 -> 残差块1 -> 残差块2 -> 残差块3 -> 全局平均池化层 -> 全连接层 -> 输出层

```

其中,残差块由多个BasicBlock组成,每个BasicBlock的结构如下:

```

输入 -> 卷积层 -> 批量归一化 -> ReLU激活函数 -> 卷积层 -> 批量归一化 -> 跳跃连接 -> ReLU激活函数 -> 输出

```

在ResNet-34中,每个残差块由两个BasicBlock组成。这些残差块通过跳跃连接将输入直接添加到输出中,以便在训练过程中更好地传播梯度。这种结构使得ResNet-34能够更深地训练,并且在解决深度神经网络中的梯度消失问题方面表现出色。

相关问题

RESnet34结构图

### ResNet34 网络架构图

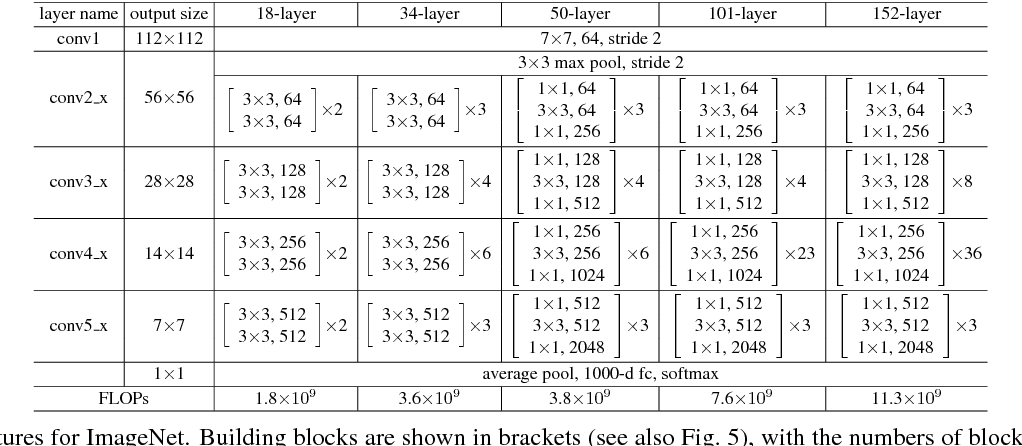

ResNet34 属于残差网络系列,该系列由何凯明等人开发,在2015年的ILSVRC竞赛中获得冠军[^3]。ResNet通过引入跳跃连接解决了深层网络中的梯度消失问题。

#### 架构概述

ResNet34 是一种较浅版本的残差网络,总共有34层深。相比更深的变体如ResNet50或ResNet101, ResNet34更适合用于理解基本原理和小型实验项目。

#### 主要组件

- **输入层**: 接收大小为\(224 \times 224\)像素的RGB图像作为输入。

- **初始卷积层**: 使用7x7滤波器执行一次大步幅(Stride=2)的卷积操作,并接一个最大池化(Max Pooling),进一步减半特征图尺寸。

- **四个阶段的残差块**:

- Stage 1: 包含三个基础卷积层;

- Stages 2~4: 各自包含多个相同的残差单元(每个单元内有两个3×3的小型卷积核),其中Stage 2有4个这样的单元;Stages 3和4分别扩展到6个和3个单元。

每经过一个新的stage都会改变通道数量以及空间分辨率(通常是缩小一半)。这种设计使得模型能够在保持较低参数量的同时捕捉更复杂的模式。

#### 特殊之处

与其他传统CNN不同的是,ResNet利用了所谓的“捷径连接”或者叫作skip connections。这些额外路径允许信息绕过某些层直接传递给后续层,从而缓解了训练过程中可能出现的退化现象。

以下是简化版的ResNet34架构示意:

```plaintext

Input -> Conv7x7 s/2 -> MaxPool3x3 s/2 ->

BasicBlock x3 (conv3x3) ->

BasicBlock x4 (conv3x3) ->

BasicBlock x6 (conv3x3) ->

BasicBlock x3 (conv3x3) ->

AvgPool -> FC Layer -> Output

```

对于具体的可视化图表展示,通常会看到如下形式的结构图:

此图为PyTorch官方文档提供的ResNet34架构示意图,展示了各部分之间的连接关系及其维度变化情况。

resnet34和resnet50结构图

ResNet(Residual Network)是一种非常流行的深度卷积神经网络架构,它在解决深度神经网络训练过程中的梯度消失和模型退化问题上取得了重大突破。ResNet34和ResNet50是ResNet的两个不同版本,它们的主要区别在于网络的深度和参数量。

ResNet34的结构图如下所示:

```

输入层 -> 卷积层 -> 批归一化层 -> ReLU激活函数 -> 残差块 * 10 -> 全局平均池化层 -> 全连接层 -> 输出层

```

其中,每个残差块由两个卷积层和一个跳跃连接组成。ResNet34总共有10个残差块,因此网络的深度为34层。

ResNet50的结构图如下所示:

```

输入层 -> 卷积层 -> 批归一化层 -> ReLU激活函数 -> 残差块 * 3 -> 残差块 * 4 -> 残差块 * 6 -> 残差块 * 3 -> 全局平均池化层 -> 全连接层 -> 输出层

```

与ResNet34相比,ResNet50的网络更深,包含了更多的残差块。具体来说,ResNet50有3个残差块的组合,每个组合包含了4个残差块,最后还有一个额外的残差块。因此,ResNet50总共有50层。

阅读全文