首页(1)基于给定的trainingData目录中的数字符号存储文件,构建K最近邻模型(使用汉明距离)。数字符号文件的命名规则如下:数字符号_序号.txt(如0_6.txt),其中数字符号表示文件中存储的数字,序号表示是该数字符号存储文件的编号,注意不同数字的存储文件个数是不一样的。

(1)基于给定的trainingData目录中的数字符号存储文件,构建K最近邻模型(使用汉明距离)。数字符号文件的命名规则如下:数字符号_序号.txt(如0_6.txt),其中数字符号表示文件中存储的数字,序号表示是该数字符号存储文件的编号,注意不同数字的存储文件个数是不一样的。

时间: 2024-04-05 11:35:27 浏览: 61

好的,您的问题是如何基于给定的trainingData目录中的数字符号存储文件,构建K最近邻模型(使用汉明距离)。

首先,我们需要将每个数字符号存储文件转换为一个向量。我们可以使用诸如像素值之类的特征来表示这些向量。对于本问题,假设每个数字符号存储文件都是一个 32x32 的像素矩阵。我们可以将每个像素看作是一个特征,并将整个矩阵表示为一个 1024 维向量。

然后,我们需要计算每个向量之间的汉明距离。汉明距离是两个等长字符串之间对应位置上不同字符的个数。在我们的例子中,每个向量都是 1024 维的,因此我们可以使用二进制字符串来表示这些向量,并计算它们之间的汉明距离。

接下来,我们可以将所有向量和它们所代表的数字符号存储文件的标签放入一个 KD 树中。这个 KD 树可以用于快速查找最近的 K 个邻居。

最后,我们可以使用 K 个邻居的标签来预测测试向量所代表的数字符号。最常见的标签被视为预测结果。

实现这个算法需要一些编程技巧和算法知识。您可以使用 Python 中的 scikit-learn 库来实现 KNN 模型。

阅读全文

CSDN会员

开通CSDN年卡参与万元壕礼抽奖

大家在看

Handbook of PI and PID Controller Tuning Rules 3e

The vast majority of automatic controllers used to compensate industrial processes are PI or PID type. This book comprehensively compiles, using a unified notation, tuning rules for these controllers proposed from 1935 to 2008. The tuning rules are carefully categorized and application information about each rule is given. This book discusses controller architecture and process modeling issues, as well as the performance and robustness of loops compensated with PI or PID controllers. This unique publication brings together in an easy-to-use format material previously published in a large number of papers and books. This wholly revised third edition extends the presentation of PI and PID controller tuning rules, for single variable processes with time delays, to include additional rules compiled since the second edition was published in 2006.

hanlp 自然语言处理入门

hanlp 自然语言处理入门 资料全

多无人机和实时局部轨迹规划最佳防撞算法附matlab代码.zip

1.版本:matlab2014/2019a,内含运行结果,不会运行可私信

2.领域:智能优化算法、神经网络预测、信号处理、元胞自动机、图像处理、路径规划、无人机等多种领域的Matlab仿真,更多内容可点击博主头像

3.内容:标题所示,对于介绍可点击主页搜索博客

4.适合人群:本科,硕士等教研学习使用

5.博客介绍:热爱科研的Matlab仿真开发者,修心和技术同步精进,matlab项目合作可si信

Code-Generation-ARM-Compiler-V5.05update

最新版keil 编译器无法通过之前的编译

一定要用我这个编译器 编译之前的工程才有用

《STM32开发指南》第四十一章 摄像头实验

使用 STM32 驱动 ALIENTEK OV7670 摄像头模块,实现摄像头功能。

最新推荐

python实现写数字文件名的递增保存文件方法

在Python编程中,有时我们需要按照特定的规则保存文件,例如以递增的数字作为文件名的一部分。这样的需求在处理批量数据或序列化操作时非常常见。本文将详细讲解如何使用Python实现数字文件名的递增保存文件的方法。...

Python实现查找数组中任意第k大的数字算法示例

在Python编程中,查找数组中第k大的数字是一项常见的任务,尤其在数据分析和算法竞赛中。这个任务通常涉及到数组操作,排序以及高效的查找技术。在给定的示例中,介绍了一个利用分治思想实现的算法,类似于快速排序...

Android遍历所有文件夹和子目录搜索文件

在示例代码中,使用`Environment.getExternalStorageDirectory().getPath()`获取外部存储(通常是SD卡)的根目录。在Android 10(API级别29)及以上版本,这种方法可能不再可靠,因为Android引入了存储访问框架,...

Python中py文件引用另一个py文件变量的方法

在Python编程中,有时我们需要在一个Python模块(`.py`文件)中使用另一个模块中的变量或函数。这可以通过导入(`import`)机制实现。在给定的标题和描述中,我们探讨的是如何在一个`.py`文件中引用另一个`.py`文件...

javascript去除字符串中所有标点符号和提取纯文本的正则

在JavaScript中,处理字符串时,有时我们需要去除其中的标点符号,或者提取纯文本内容,以便进行进一步的数据处理或分析。这通常涉及到正则表达式(Regular Expression)的应用。正则表达式是一种强大的文本处理工具...

Pokedex: 探索JS开发的口袋妖怪应用程序

资源摘要信息:"Pokedex是一个基于JavaScript的应用程序,主要功能是收集和展示口袋妖怪的相关信息。该应用程序是用JavaScript语言开发的,是一种运行在浏览器端的动态网页应用程序,可以向用户提供口袋妖怪的各种数据,例如名称、分类、属性等。"

首先,我们需要明确JavaScript的作用。JavaScript是一种高级编程语言,是网页交互的核心,它可以在用户的浏览器中运行,实现各种动态效果。JavaScript的应用非常广泛,包括网页设计、游戏开发、移动应用开发等,它能够处理用户输入,更新网页内容,控制多媒体,动画以及各种数据的交互。

在这个Pokedex的应用中,JavaScript被用来构建一个口袋妖怪信息的数据库和前端界面。这涉及到前端开发的多个方面,包括但不限于:

1. DOM操作:JavaScript可以用来操控文档对象模型(DOM),通过DOM,JavaScript可以读取和修改网页内容。在Pokedex应用中,当用户点击一个口袋妖怪,JavaScript将利用DOM来更新页面,展示该口袋妖怪的详细信息。

2. 事件处理:应用程序需要响应用户的交互,比如点击按钮或链接。JavaScript可以绑定事件处理器来响应这些动作,从而实现更丰富的用户体验。

3. AJAX交互:Pokedex应用程序可能需要与服务器进行异步数据交换,而不重新加载页面。AJAX(Asynchronous JavaScript and XML)是一种在不刷新整个页面的情况下,进行数据交换的技术。JavaScript在这里扮演了发送请求、处理响应以及更新页面内容的角色。

4. JSON数据格式:由于JavaScript有内置的JSON对象,它可以非常方便地处理JSON数据格式。在Pokedex应用中,从服务器获取的数据很可能是JSON格式的口袋妖怪信息,JavaScript可以将其解析为JavaScript对象,并在应用中使用。

5. 动态用户界面:JavaScript可以用来创建动态用户界面,如弹出窗口、下拉菜单、滑动效果等,为用户提供更加丰富的交互体验。

6. 数据存储:JavaScript可以使用Web Storage API(包括localStorage和sessionStorage)在用户的浏览器上存储数据。这样,即使用户关闭浏览器或页面,数据也可以被保留,这对于用户体验来说是非常重要的,尤其是对于一个像Pokedex这样的应用程序,用户可能希望保存他们查询过的口袋妖怪信息。

此外,该应用程序被标记为“JavaScript”,这意味着它可能使用了JavaScript的最新特性或者流行的库和框架,例如React、Vue或Angular。这些现代的JavaScript框架能够使前端开发更加高效、模块化和易于维护。例如,React允许开发者构建可复用的UI组件,Vue则提供了数据驱动和组件化的编程方式,而Angular则是一个全面的前端框架,提供了模板、依赖注入、客户端路由等功能。

在文件名称列表中提到了"Pokedex-main",这很可能是应用程序的主文件或者项目的根目录名称。在这种情况下,主文件可能包含程序的入口点,即整个JavaScript应用程序开始执行的地方,它通常会包含对其他JavaScript文件的引用,以及初始化应用程序的代码。

综上所述,Pokedex作为一个JavaScript应用程序,涉及了前端开发的多个关键技术和概念。通过JavaScript,开发者能够实现一个功能丰富、响应用户交互、动态更新内容的应用程序,为用户提供口袋妖怪的详细信息和互动体验。

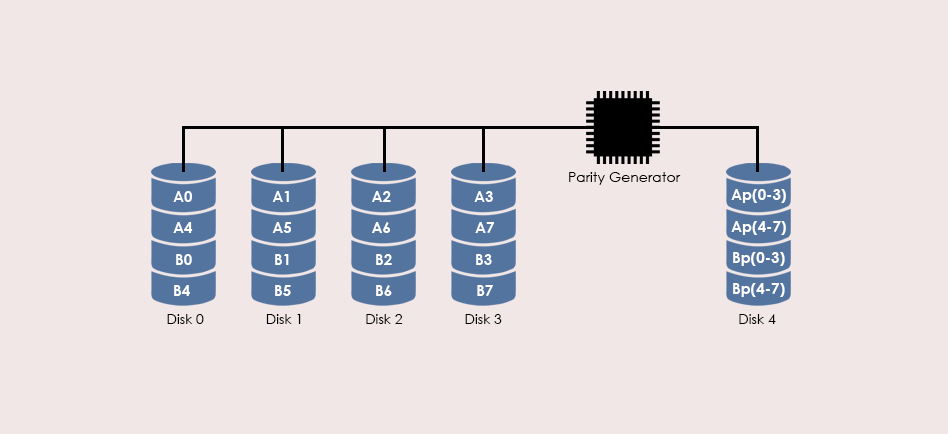

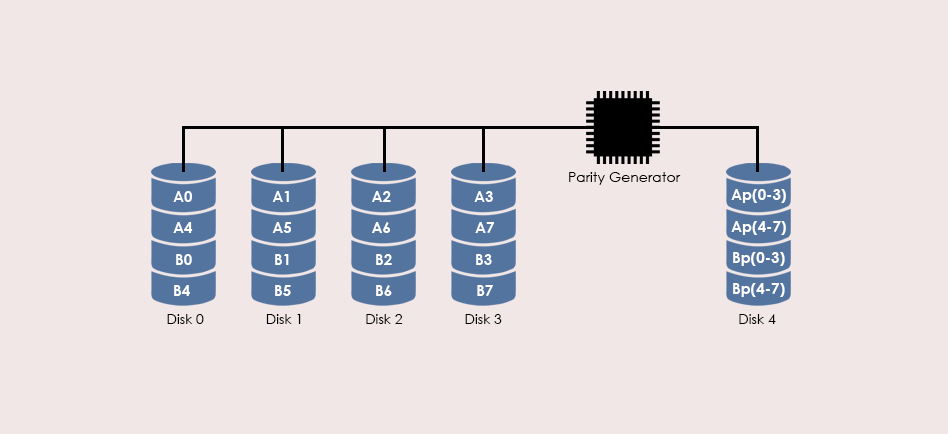

【提升R-Studio恢复效率】:RAID 5数据恢复的高级技巧与成功率

# 摘要

RAID 5作为一种广泛应用于数据存储的冗余阵列技术,能够提供较好的数据保护和性能平衡。本文首先概述了RAID 5数据恢复的重要性,随后介绍了RAID 5的基础理论,包括其工作原理、故障类型及数据恢复前的准备工作。接着,文章深入探讨了提升RAID 5数据恢复成功率的高级技巧,涵盖了硬件级别和软件工具的应用,以及文件系统结构和数据一致性检查。通过实际案例分析,

帮我写一段Python代码:sin波生成,设定rate,fin,size,幅值

当然可以。在Python中,我们可以使用`numpy`库来创建正弦波,并通过`tqdm`库添加进度条。下面是一个简单的示例代码,它会生成指定频率(rate)、持续时间(fin),以及样本大小(size)的正弦波,幅度可以自定义:

```python

import numpy as np

from tqdm import trange

# 定义函数生成sin波

def generate_sine_wave(rate=44100, fin=5, size=None, amplitude=1):

# 检查参数是否合理

if size is None:

size =

Laravel实用工具包:laravel-helpers概述

资源摘要信息:"Laravel开发-laravel-helpers 是一个针对Laravel框架开发者的实用程序包,它提供了许多核心功能的便捷访问器(getters)和修改器(setters)。这个包的设计初衷是为了提高开发效率,使得开发者能够快速地使用Laravel框架中常见的一些操作,而无需重复编写相同的代码。使用此包可以简化代码量,减少出错的几率,并且当开发者没有提供自定义实例时,它将自动回退到Laravel的原生外观,确保了功能的稳定性和可用性。"

知识点:

1. Laravel框架概述:

Laravel是一个基于PHP的开源Web应用框架,遵循MVC(Model-View-Controller)架构模式。它旨在通过提供一套丰富的工具来快速开发Web应用程序,同时保持代码的简洁和优雅。Laravel的特性包括路由、会话管理、缓存、模板引擎、数据库迁移等。

2. Laravel核心包:

Laravel的核心包是指那些构成框架基础的库和组件。它们包括但不限于路由(Routing)、请求(Request)、响应(Response)、视图(View)、数据库(Database)、验证(Validation)等。这些核心包提供了基础功能,并且可以被开发者在项目中广泛地使用。

3. Laravel的getters和setters:

在面向对象编程(OOP)中,getters和setters是指用来获取和设置对象属性值的方法。在Laravel中,这些通常指的是辅助函数或者服务容器中注册的方法,用于获取或设置框架内部的一些配置信息和对象实例。

4. Laravel外观模式:

外观(Facade)模式是软件工程中常用的封装技术,它为复杂的子系统提供一个简化的接口。在Laravel框架中,外观模式广泛应用于其核心类库,使得开发者可以通过简洁的类方法调用来执行复杂的操作。

5. 使用laravel-helpers的优势:

laravel-helpers包作为一个辅助工具包,它将常见的操作封装成易于使用的函数,使开发者在编写Laravel应用时更加便捷。它省去了编写重复代码的麻烦,降低了项目的复杂度,从而加快了开发进程。

6. 自定义实例和回退机制:

在laravel-helpers包中,如果开发者没有提供特定的自定义实例,该包能够自动回退到使用Laravel的原生外观。这种设计使得开发者在不牺牲框架本有功能的前提下,能够享受到额外的便利性。

7. Laravel开发实践:

在实际的开发过程中,开发者可以通过引入laravel-helpers包来简化代码的编写。例如,该包可能提供了一系列用于验证输入数据的快速方法,或者是一些处理常见任务的辅助函数,如快速生成响应、执行数据库查询、发送邮件等。

8. 开源贡献和社区支持:

laravel-helpers作为一个开源包,它的维护和更新依赖于社区的贡献。开发者在使用过程中也可以参与到包的开发与改进中,为Laravel社区做出贡献,并从社区中获取帮助和反馈。

总结而言,laravel-helpers包通过提供一系列的getters和setters工具函数,极大地提升了Laravel开发的效率与便利性。它不仅遵循了Laravel的核心设计理念,还通过回退机制保证了与框架原生功能的兼容性。对于希望优化其开发流程的Laravel开发者来说,这无疑是一个宝贵的资源。

【R-Studio技术路径】:从RAID 5数据恢复基础到高级操作

# 摘要

随着信息技术的发展,数据丢失问题日益突出,RAID 5作为常见的数据存储解决方案,其数据恢复技术显得尤为重要。本文首先介绍了RAID 5数据恢复的基础知识,然后详细解析了R-Studio软件的界面和核心功能,重点探讨了其在RAID 5数据恢复中的应用实践,包括磁盘镜像创建、数据提取、数据重组策略及一致性验证。进一步,本文还涉及了R-Studio的进阶技术,如脚本编