【Anaconda数据科学实战手册】:24个技巧助你成为专家

发布时间: 2024-12-09 14:53:42 阅读量: 8 订阅数: 11

Python 数据科学工具 Anaconda 的全面安装与使用指南

# 1. Anaconda数据科学概述

在数据科学的世界里,Anaconda是一个强大的工具,它以一种简单、高效的方式,将数据科学家日常所需的各种工具和库打包集成。本章将介绍Anaconda的总体概念、其在数据科学中的作用以及它如何为数据分析和机器学习工作流提供便利。

Anaconda不仅仅是Python的一个发行版,它还是一个完整的包管理和环境管理系统。这使得用户能够轻松地安装、更新和管理多个包和软件库,同时,Anaconda允许用户创建和管理独立的虚拟环境,以隔离不同项目所需的依赖。

从初学者到经验丰富的数据科学家,Anaconda都能提供支持,从快速开始数据科学项目到进行大规模的机器学习实验,Anaconda都有其独特的优势。接下来的章节,我们将深入探讨Anaconda环境管理的技巧,以及它如何帮助我们更好地进行数据科学工作。

# 2. Anaconda环境管理技巧

Anaconda是一个非常流行的数据科学和机器学习平台,它提供了一种简便的方式来管理和部署数据科学环境。在本章中,我们将深入了解如何利用Anaconda进行高效的环境管理,包括安装与配置、高级用法以及深入理解Conda命令。

## 2.1 Anaconda安装与配置

在数据科学工作流中,安装和配置Anaconda是一个基础却至关重要的步骤。Anaconda可以跨平台使用,支持Linux、Windows和MacOS。

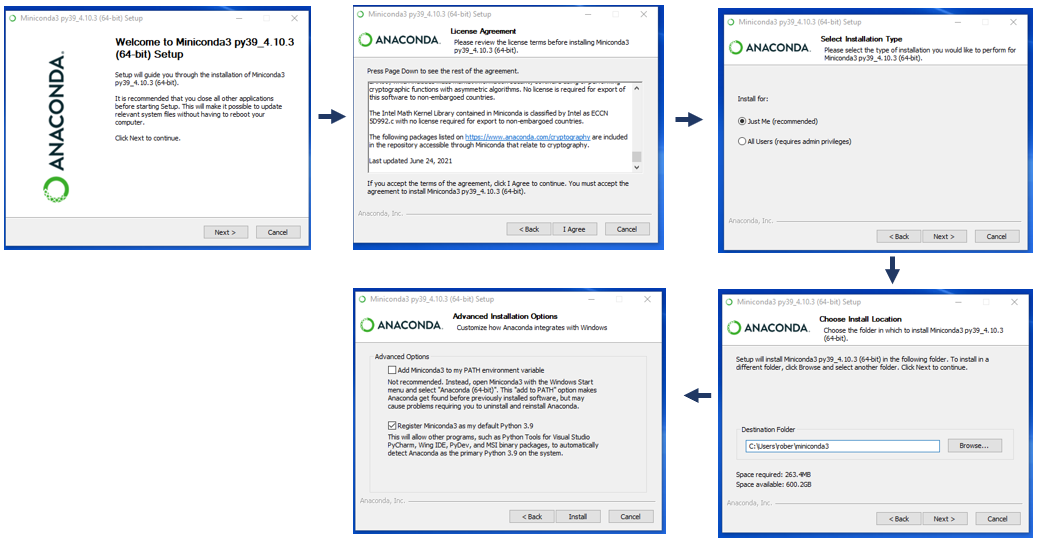

### 2.1.1 Anaconda的安装过程

Anaconda安装过程相对简单,却需要针对不同的操作系统进行不同的步骤。以下是通用的安装流程,以及对应操作系统的具体指导。

- 下载Anaconda安装包

- 访问[Anaconda官方网站](https://www.anaconda.com/products/distribution)选择合适的Python版本进行下载。

- 对于Windows用户,下载.exe安装程序;对于Linux或MacOS用户,下载.sh脚本。

- Windows平台安装步骤

- 双击下载的.exe文件开始安装程序。

- 点击“Next”接受许可协议。

- 选择安装路径,建议使用默认路径以避免潜在问题。

- 选择是否将Anaconda添加至PATH环境变量。

- 点击“Install”完成安装。

- Linux/MacOS平台安装步骤

- 打开终端,切换到下载文件的目录。

- 通过命令`chmod +x Anaconda3-<version>-Linux-x86_64.sh`修改下载脚本的权限使其可执行。

- 运行脚本`./Anaconda3-<version>-Linux-x86_64.sh`按照提示进行安装。

- 安装过程中,按照提示操作,确保Anaconda安装在合适的位置。

### 2.1.2 环境配置与虚拟环境创建

安装完成Anaconda后,可以通过配置环境变量和创建虚拟环境来开始我们的数据分析之旅。

- 环境变量配置

- Windows系统在安装时可以选择自动配置环境变量,如果需要手动配置,将Anaconda的路径添加到系统变量`Path`中。

- Linux/MacOS用户需要将Anaconda的安装路径和`bin`目录添加到环境变量中。

- 创建和管理虚拟环境

- 创建虚拟环境:`conda create -n <env_name> python=<version>`。

- 激活环境:`conda activate <env_name>`。

- 离开环境:`conda deactivate`。

- 删除环境:`conda env remove -n <env_name>`。

虚拟环境是隔离Python项目的有效方法,它允许每个项目拥有独立的依赖包和Python版本,从而避免不同项目间的依赖冲突。

## 2.2 环境管理的高级用法

随着项目的深入,我们会发现环境管理中还有很多高级技巧,包括环境的克隆、备份、恢复等操作。

### 2.2.1 环境的克隆、备份和恢复

- 环境克隆:复制现有环境以用于不同的项目。

- 克隆环境:`conda create --clone <env_name> --name <new_env_name>`。

- 此命令会创建一个名为`<new_env_name>`的新环境,该环境是`<env_name>`的一个完整副本。

- 环境备份和恢复

- 备份环境:可以使用`conda env export`命令导出环境配置到一个文件中,例如`environment.yml`。

- 恢复环境:使用`conda env create -f environment.yml`命令根据备份文件创建环境。

通过这些操作,我们可以轻松地管理和复用项目环境,保证数据科学工作的连贯性和可重复性。

### 2.2.2 多环境间的包管理

在不同的环境间管理和迁移包是数据科学家的日常。以下是如何有效地管理和迁移包的技巧。

- 安装、更新和卸载包

- 安装包:`conda install <package_name>`。

- 更新包:`conda update <package_name>`。

- 卸载包:`conda remove <package_name>`。

- 将包从一个环境迁移到另一个

- 为了迁移包,可以先导出环境配置,然后在新环境中创建相同的包列表。

- 注意:确保新环境安装了相同的Python版本。

## 2.3 深入理解Conda命令

Conda是Anaconda的核心,它提供了一系列命令来管理包和环境。理解这些命令对于高效使用Anaconda至关重要。

### 2.3.1 Conda命令的核心功能

Conda命令提供了丰富的选项来管理包和环境。

- 列出当前可用的环境:`conda env list`。

- 查看特定环境的包列表:`conda list -n <env_name>`。

- 搜索可用包:`conda search <package_name>`。

- 验证环境的完整性:`conda env check`。

### 2.3.2 系统优化与性能调整

Conda还可以帮助我们优化系统性能,例如通过清理不再需要的包和缓存。

- 清理不再需要的包:`conda clean --packages`。

- 删除缓存的包:`conda clean --tarballs`。

- 调整Conda性能设置:可以通过`conda config`命令配置Conda的性能相关设置。

通过上述技巧,我们可以确保系统运行流畅,同时管理好环境和包的依赖关系。

以上是Anaconda环境管理的一些核心技巧和高级用法。在接下来的章节中,我们将继续深入了解如何使用Conda命令进行高效的环境管理,并探索其更深层次的性能调整方法。

```mermaid

graph TD

A[Anaconda安装] -->|下载安装包| B[下载]

B --> C[Windows安装]

B --> D[Linux/MacOS安装]

C --> E[环境变量配置]

D --> E

E --> F[创建虚拟环境]

F --> G[激活环境]

G --> H[环境管理高级用法]

H -->|克隆环境| I[环境克隆]

H -->|备份和恢复| J[备份与恢复]

H -->|包管理| K[包管理]

I --> L[Conda命令核心功能]

J --> L

K --> L

L --> M[系统优化与性能调整]

```

表格:Anaconda安装与环境管理步骤总结

| 步骤 | 描述 |

| --- | --- |

| 下载安装包 | 访问Anaconda官方网站下载适合你操作系统的安装包。 |

| Windows安装 | 双击下载的.exe文件并按照安装向导进行安装。 |

| Linux/MacOS安装 | 运行下载的.sh脚本,并根据提示完成安装。 |

| 环境变量配置 | 将Anaconda的路径添加到系统的环境变量中。 |

| 创建虚拟环境 | 使用`conda create -n <env_name>`命令创建新环境。 |

| 激活环境 | 使用`conda activate <env_name>`命令激活环境。 |

| 环境克隆 | 使用`conda create --clone <env_name>`命令克隆环境。 |

| 备份与恢复 | 使用`conda env export`导出环境配置并使用`conda env create`恢复。 |

| 包管理 | 安装、更新、卸载包或使用`conda install`、`conda update`、`conda remove`命令。 |

| 系统优化 | 清理不再需要的包和缓存使用`conda clean`命令。 |

```python

# 代码示例:创建和管理虚拟环境的Conda命令

!conda create --name myenv python=3.8

!conda activate myenv

!conda install numpy pandas matplotlib

!conda deactivate

```

在上文提到的代码块中,我们展示了如何使用Conda命令创建名为`myenv`的虚拟环境,并激活它安装一些常用的数据科学包,然后退出环境。每个命令都有其作用和意义,在此不再赘述。

# 3. Python编程在数据科学中的应用

Python已经成为数据科学领域的主导语言,这得益于它简洁的语法以及众多的科学计算库。在这一章节中,我们将探讨Python在数据科学应用中的关键方面,包括基础数据结构、数据分析与处理,以及数据可视化。这些技能是数据科学家日常工作的核心内容,掌握这些技能将能够提高工作效率并构建出高效的分析流程。

## 3.1 Python基础数据结构

Python提供了丰富的数据结构,其中列表(list)、字典(dict)和集合(set)是最为常用的数据结构之一。这些结构能够处理各种数据,并且能够支持高效的数据操作。

### 3.1.1 列表、字典和集合的高级用法

列表是一种有序的集合,可以随时添加和删除其中的元素。字典是一种通过键来存储数据的结构,它存储的是键值对。集合是一个无序的不重复元素序列。在数据科学中,我们需要灵活运用这些结构来处理数据。

```python

# 列表的高级用法

fruits = ['apple', 'banana', 'cherry']

fruits.append('orange') # 添加元素

print(fruits)

fruits.remove('banana') # 移除元素

print(fruits)

# 字典的高级用法

person = {'name': 'John', 'age': 25, 'city': 'New York'}

person['email'] = 'john@example.com' # 添加键值对

print(person)

if 'age' in person:

del person['age'] # 删除键值对

print(person)

# 集合的高级用法

unique_numbers = set([1, 2, 2, 3, 3, 4])

unique_numbers.add(5) # 添加元素

print(unique_numbers)

unique_numbers.remove(1) # 移除元素

print(unique_numbers)

```

在列表操作中,我们通常会用到列表推导式(list comprehension)来简化循环和条件判断的代码。字典和集合也支持类似的推导式,用以创建新的字典或集合。列表推导式的使用可以极大地提高代码的可读性和执行效率。

### 3.1.2 NumPy数组的操作技巧

NumPy是Python中用于科学计算的核心库,它提供了一个强大的数组对象ndarray。NumPy数组是处理大规模数值数据的基石。

```python

import numpy as np

# 创建一个3x3的数组

array = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

print(array)

# 数组切片

sub_array = array[1:3, 1:3]

print(sub_array)

# 数组的基本运算

matrix1 = np.array([[1, 2], [3, 4]])

matrix2 = np.array([[5, 6], [7, 8]])

result = matrix1 + matrix2

print(result)

```

NumPy提供的数组操作能力远超Python原生的列表和数组,特别是在矩阵运算、数组广播和向量化操作方面。利用这些操作技巧,可以大幅提升数据处理的效率,尤其是在处理大规模数据集时。

## 3.2 数据分析与处理

数据分析的目的是从数据中获取洞察和信息,而数据处理则是数据分析的前提条件。Python中的Pandas库为数据处理提供了强大的工具。

### 3.2.1 Pandas的数据筛选与清洗

Pandas库是基于NumPy构建的一个数据处理库,它提供了DataFrame和Series两种主要的数据结构,专门用于处理结构化数据。

```python

import pandas as pd

# 创建一个DataFrame

data = {

'Name': ['Alice', 'Bob', 'Charlie'],

'Age': [24, 30, 18]

}

df = pd.DataFrame(data)

print(df)

# 数据筛选

print(df[df['Age'] > 20])

# 数据清洗

df.dropna(inplace=True) # 删除缺失值

df.fillna(0, inplace=True) # 填充缺失值

```

数据筛选和清洗是数据预处理的重要步骤。使用Pandas的条件筛选功能可以快速选择满足特定条件的数据子集。而处理缺失值、重复数据等问题是清洗数据的关键,只有经过清洗的数据,才能进行有效的分析。

### 3.2.2 数据透视表和分组操作

数据透视表(pivot table)和分组(grouping)是数据分析中非常有用的工具,它们可以对数据进行聚合和重塑。

```python

# 数据透视表

pivot_table = df.pivot_table(values='Age', index='Name', columns='Sex', aggfunc='sum', fill_value=0)

print(pivot_table)

# 分组操作

grouped = df.groupby('Sex')

for name, group in grouped:

print(f"Sex: {name}")

print(group)

```

数据透视表可以快速对数据进行汇总,以方便地进行统计分析。分组操作则是将数据集按照一个或多个列进行分组,并对每个组应用聚合函数。Pandas中的分组操作允许数据科学家按照任何标准对数据集进行划分,从而能够深入地了解数据集中的分布和趋势。

## 3.3 可视化数据的探索

数据可视化是数据分析的重要组成部分,它可以帮助我们直观地理解数据,发现数据中的模式和趋势。Matplotlib和Seaborn是Python中两个非常流行的可视化库。

### 3.3.1 Matplotlib与Seaborn的基本作图技巧

Matplotlib库可以绘制各种静态、动态和交互式图表。而Seaborn则是基于Matplotlib,提供了高级接口,用于绘制更美观的统计图形。

```python

import matplotlib.pyplot as plt

import seaborn as sns

# 使用Matplotlib绘制散点图

plt.scatter([1, 2, 3, 4, 5], [2, 3, 5, 7, 11])

plt.title('Scatter Plot Example')

plt.xlabel('x-axis')

plt.ylabel('y-axis')

plt.show()

# 使用Seaborn绘制散点图

sns.set()

tips = sns.load_dataset('tips')

sns.scatterplot(x='total_bill', y='tip', data=tips)

plt.title('Seaborn Scatter Plot Example')

plt.show()

```

在绘制图表时,Matplotlib允许用户自定义几乎所有的图表元素,包括颜色、字体、轴线等。Seaborn则提供了一些预设的样式和主题,能够简化绘图过程。两者结合使用,可以满足不同的可视化需求。

### 3.3.2 交互式数据可视化工具的实践

除了静态图形,交互式可视化工具在探索数据时也扮演着重要的角色。例如,Plotly是一个可以创建交互式图表的库。

```python

import plotly.express as px

# 创建交互式散点图

fig = px.scatter(tips, x='total_bill', y='tip', color='day')

fig.show()

```

交互式可视化工具可以帮助用户通过动态的方式来探索数据,例如缩放、拖动和点击图表中的数据点,以及展示数据的详细信息。这些功能对于理解复杂数据集特别有帮助。

通过本章节的介绍,读者应能够掌握Python在数据科学中的核心应用,包括基础数据结构的使用、数据的分析与处理,以及可视化数据的探索。这些技能是构建数据科学工作流程的基础,也是数据科学从业者必须掌握的关键能力。在下一章节中,我们将进一步深入机器学习的实战应用,介绍如何在项目中应用这些数据科学技能。

# 4. 机器学习项目实战

机器学习项目是数据科学领域的重要组成部分,它涉及从数据的收集、处理,到模型的训练、评估、部署等一系列步骤。在本章中,我们将深入探讨机器学习项目的实战流程,涵盖特征选择、模型训练、深度学习技巧,以及案例研究等重要环节。

## 4.1 机器学习工作流程

### 4.1.1 特征选择与工程

在机器学习中,选择合适的特征是提高模型性能的关键步骤。特征选择和工程旨在找出与目标变量最相关的特征,并通过转换原始数据来构建新的特征,以提高模型的预测能力。

**重要步骤包括:**

- **相关性分析:** 通过统计测试如皮尔逊相关系数来衡量特征与目标变量之间的线性相关性。

- **特征重要性评分:** 使用基于树的模型如随机森林和梯度提升机来获取特征重要性评分。

- **降维技术:** 如主成分分析(PCA)来减少特征数量同时保留数据的大部分变异度。

- **特征构造:** 基于业务理解构造新特征,例如通过时间序列分析构造滞后变量。

**代码示例:**

```python

from sklearn.feature_selection import SelectKBest, f_classif

# 假设 X 是特征数据,y 是目标变量

selector = SelectKBest(f_classif, k='all') # 选择最佳的 k 个特征

X_new = selector.fit_transform(X, y)

# 输出选中的特征及其分数

selected_features = list(selector.get_support(indices=True))

print("Selected features:", selected_features)

print("Feature scores:", selector.scores_)

```

**参数说明与逻辑分析:**

- `SelectKBest` 是一个选择最佳特征的类,其中 `f_classif` 是基于ANOVA F值的特征选择。

- `k='all'` 表示选择所有特征,可以根据需要设置具体的 k 值。

- `fit_transform` 方法不仅拟合选择器到数据上,还返回新的特征矩阵。

- `get_support(indices=True)` 方法获取选中特征的索引。

通过上述步骤和代码示例,我们可以有效地选择和构建特征,从而为模型训练准备更优质的输入数据。

### 4.1.2 模型训练与评估

一旦我们准备好了数据,下一步就是选择合适的模型并进行训练。选择模型需要考虑问题的类型(分类、回归等)、数据的特性以及性能要求。

**关键活动包括:**

- **模型选择:** 根据问题的性质选择不同的算法,如支持向量机、随机森林、神经网络等。

- **交叉验证:** 使用交叉验证来评估模型在未知数据上的泛化能力。

- **性能指标:** 精确度、召回率、F1分数、ROC曲线下面积(AUC)等,针对不同问题选择合适的评价指标。

- **超参数调优:** 使用网格搜索或随机搜索方法来找到最佳超参数。

**代码示例:**

```python

from sklearn.model_selection import train_test_split, GridSearchCV

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import classification_report

# 假设 X_train, X_test, y_train, y_test 已经准备好了

# 创建随机森林分类器实例

rf = RandomForestClassifier()

# 设置超参数的搜索范围

param_grid = {

'n_estimators': [10, 50, 100, 200],

'max_depth': [None, 10, 20, 30],

}

# 使用GridSearchCV进行交叉验证和超参数搜索

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5)

grid_search.fit(X_train, y_train)

# 输出最佳参数组合和对应的分数

print("Best parameters set found on development set:")

print(grid_search.best_params_)

print("Grid scores on development set:")

means = grid_search.cv_results_['mean_test_score']

stds = grid_search.cv_results_['std_test_score']

for mean, std, params in zip(means, stds, grid_search.cv_results_['params']):

print("%0.3f (+/-%0.03f) for %r" % (mean, std * 2, params))

# 使用最佳模型对测试数据进行预测,并输出报告

best_model = grid_search.best_estimator_

predictions = best_model.predict(X_test)

print(classification_report(y_test, predictions))

```

**参数说明与逻辑分析:**

- `train_test_split` 用于分割数据集为训练集和测试集。

- `GridSearchCV` 同时执行网格搜索与交叉验证,帮助我们找到模型最佳的超参数组合。

- `param_grid` 定义了要搜索的超参数及其值。

- `cv` 参数设置交叉验证的折数。

通过模型训练与评估,我们可以对比不同模型在验证集上的表现,选择最佳模型并进一步进行测试集上的评估。

## 4.2 深度学习的入门技巧

深度学习,作为机器学习的一个子领域,通过多层的神经网络学习数据的复杂模式,尤其在图像和声音识别等任务中表现出色。

### 4.2.1 TensorFlow与Keras的快速搭建

TensorFlow是一个开源的深度学习框架,而Keras是其高层API,用于快速搭建和训练神经网络模型。两者都广泛被数据科学家和研究人员使用。

**入门步骤包括:**

- **环境搭建:** 安装TensorFlow和Keras。

- **模型构建:** 使用Keras的Sequential API快速搭建一个简单的神经网络。

- **模型训练:** 使用fit方法训练模型,并在训练过程中监控性能指标。

**代码示例:**

```python

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 构建简单的神经网络模型

model = Sequential([

Dense(64, activation='relu', input_shape=(X_train.shape[1],)),

Dense(32, activation='relu'),

Dense(10, activation='softmax') # 假设是分类问题,有10个类别

])

# 编译模型,定义优化器、损失函数和性能指标

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

history = model.fit(X_train, y_train, epochs=10, validation_split=0.2)

# 评估模型性能

test_loss, test_acc = model.evaluate(X_test, y_test)

print('Test accuracy:', test_acc)

```

**参数说明与逻辑分析:**

- `Sequential` API允许我们顺序地添加层,构建模型。

- `Dense` 是全连接层,`input_shape` 指定了输入数据的形状。

- `compile` 方法配置训练过程,其中`'adam'`是一种常用的优化器。

- `fit` 方法用于训练模型,其中 `validation_split` 指定了一部分数据用于验证。

**快速搭建神经网络的好处在于:**

- **易用性:** Keras的高层API使得模型搭建更加简单直观。

- **灵活性:** 可以轻松地试验不同的网络架构和参数。

- **效率:** 利用TensorFlow的底层优化,加快了训练和推理速度。

### 4.2.2 神经网络的构建与调试

构建神经网络时,我们可能需要调试以确保模型的性能达到预期。调试时重点关注的问题包括过拟合、欠拟合、网络的初始化和激活函数的选择。

**调试技巧包括:**

- **正则化:** 如使用L1、L2正则化减少过拟合。

- **早停:** 当验证集的性能不再提升时停止训练。

- **批量归一化:** 提高网络训练速度并减少对权重初始化的依赖。

- **学习率调整:** 如使用学习率衰减或自适应学习率优化器。

**代码示例:**

```python

from tensorflow.keras.callbacks import EarlyStopping

# 早停回调

early_stopping = EarlyStopping(monitor='val_loss', patience=3)

# 重新训练模型,并加入早停回调

history = model.fit(X_train, y_train, epochs=100, validation_split=0.2, callbacks=[early_stopping])

# 绘制训练过程中的损失曲线

import matplotlib.pyplot as plt

plt.plot(history.history['loss'], label='train')

plt.plot(history.history['val_loss'], label='validation')

plt.legend()

plt.show()

```

**参数说明与逻辑分析:**

- `EarlyStopping` 用于防止过拟合,其中 `patience` 参数表示在停止训练前,允许模型在验证集上的性能连续多少个epoch没有提升。

通过构建与调试神经网络的实践,我们可以掌握深度学习模型设计的关键技巧,并确保模型在各种数据集上都能取得良好的表现。

## 4.3 机器学习案例研究

### 4.3.1 实际问题的分析与建模

案例研究让我们能够将理论知识应用到实际问题中去。在分析与建模的实际问题时,数据探索、特征工程、模型选择和评估是核心环节。

**关键活动包括:**

- **业务理解:** 了解业务问题,确定模型的目标。

- **数据探索:** 分析数据的分布、缺失值和异常值。

- **特征工程:** 构建与业务问题相关的特征。

- **模型迭代:** 多次迭代,不断调整模型以适应数据。

**代码示例:**

```python

# 这里使用伪代码进行说明,具体代码取决于数据集和问题的复杂性

# ...

# 使用构建好的模型进行预测

predictions = model.predict(X_test)

# 结果分析与解释

# ...

```

### 4.3.2 模型的部署与监控

模型训练完成之后,需要将其部署到生产环境中,并对模型性能进行监控,以确保它在实际应用中能持续表现良好。

**关键步骤包括:**

- **模型持久化:** 将训练好的模型保存为文件,便于部署。

- **模型服务化:** 使用如Flask或Django等框架将模型封装为Web服务。

- **监控机制:** 设置监控指标,如延迟、吞吐量等,确保服务的稳定性。

**代码示例:**

```python

import joblib

from flask import Flask, request, jsonify

# 保存模型

joblib.dump(model, 'model.pkl')

# 创建 Flask 应用

app = Flask(__name__)

# 定义路由和预测逻辑

@app.route('/predict', methods=['POST'])

def predict():

data = request.get_json()

# 加载模型并进行预测

model = joblib.load('model.pkl')

predictions = model.predict([data])

return jsonify(predictions.tolist())

if __name__ == '__main__':

app.run()

```

通过模型的部署与监控,我们可以确保模型在面对实际应用时的稳定性和可靠性。

## 4.4 小结

在本章中,我们深入探讨了机器学习项目的实战流程,从特征选择与工程到模型训练与评估,再到深度学习技巧和案例研究。我们通过代码示例和分析来展示如何实际操作,并逐步构建起自己的机器学习模型。这些知识和技能是数据科学从业者必备的,也是推动业务决策向自动化、智能化转变的关键。

机器学习项目实战不仅需要理论知识的掌握,更需要实践经验和良好的业务理解。通过本章节的内容,您应该能够熟练地处理各种机器学习任务,并有效地将学习成果应用到真实世界的挑战中去。

# 5. 数据科学工具与资源

在数据科学领域,掌握正确的工具和资源对于提高工作效率、加速学习进程以及在专业领域内保持领先至关重要。本章将深入探讨一些最实用的数据科学工具与资源,以帮助数据科学从业者在职业生涯中更进一步。

## 5.1 版本控制与协作工具

### 5.1.1 Git的使用与团队协作

Git是一个广泛使用的版本控制系统,它使得在团队中协作开发项目变得高效且有序。在数据科学中,Git允许开发者追踪不同版本的数据处理脚本、模型文件以及分析报告,从而促进团队成员间的代码共享与协作。

#### 安装与配置Git

- **安装Git**:首先,我们需要在本地计算机上安装Git。对于大多数操作系统,可以通过Git的官方网站下载安装包并运行安装向导。

- **配置用户信息**:安装完成后,我们需要配置用户信息,这在提交(commit)更改时会用到。

```bash

git config --global user.name "Your Name"

git config --global user.email "your_email@example.com"

```

- **生成SSH密钥**:为了安全地访问GitHub等托管平台,建议生成SSH密钥。

```bash

ssh-keygen -t rsa -b 4096 -C "your_email@example.com"

```

#### 基本Git命令

- **初始化仓库**:在项目目录下运行`git init`命令来创建一个新仓库。

- **添加文件**:使用`git add <file>`来将文件添加到暂存区。

- **提交更改**:通过`git commit -m "Commit message"`来提交更改。

- **查看状态**:`git status`可以查看当前仓库的状态,了解哪些文件被修改了。

#### 远程仓库的使用

- **克隆仓库**:使用`git clone <repository-url>`可以克隆远程仓库到本地。

- **同步更改**:通过`git pull`来同步远程仓库的更改,而`git push`可以推送本地更改到远程仓库。

### 5.1.2 Jupyter Notebook的高级功能

Jupyter Notebook是一个开源的Web应用程序,它允许你创建和共享包含代码、可视化、数学公式等的文档。它在数据科学领域得到了广泛的应用。

#### Notebook的交互式特性

- **代码单元格**:在Notebook中,你可以添加代码单元格,并直接在其中编写和执行Python代码。

- **Markdown单元格**:用于添加格式化的文本、数学公式等,支持Markdown语法。

#### 扩展Jupyter Notebook

- **安装扩展**:Jupyter扩展允许你增加额外功能,如更丰富的文本编辑能力或数据可视化插件。

```bash

jupyter nbextension enable --py --sys-prefix widgetsnbextension

jupyter nbextension enable --py --sys-prefix collapsible_headings

```

- **管理扩展**:使用`jupyter contrib nbextension install --user`命令来安装由社区贡献的扩展。

#### 与Git结合使用

- **版本控制Notebook**:可以将Notebook文件纳入Git版本控制,这样可以追踪Notebook的更改历史。

- **Notebook diff工具**:安装扩展如`nbdime`可以提供差异比较和合并工具,帮助理解Notebook文件中的更改。

## 5.2 数据科学社区与开源项目

### 5.2.1 探索GitHub上的数据科学项目

GitHub是最大的代码托管平台,也是一个活跃的社区,这里汇集了世界各地的数据科学爱好者和专业人员。

- **搜索项目**:使用GitHub的搜索功能找到感兴趣的项目,可以根据语言、stars数量以及创建时间等条件进行筛选。

- **参与讨论**:加入相关项目的讨论,可以帮助理解项目背后的逻辑,并与他人建立联系。

### 5.2.2 社区资源的利用与贡献

- **利用资源**:从GitHub上获取的资源可能包括代码库、数据集、教程和文档等,这些都是学习和工作中非常宝贵的资源。

- **贡献代码**:如果你有能力并且愿意贡献代码,可以通过fork项目,创建分支并提交pull request的方式参与开源项目。

## 5.3 专业提升与学习路径

### 5.3.1 数据科学的学习资源与推荐

学习数据科学需要不断获取新知识,以下是一些推荐的学习资源:

- **在线课程**:如Coursera、edX、Udacity等提供的数据科学相关课程。

- **书籍**:阅读如《Python数据科学手册》、《统计学习基础》等经典教材。

- **博客与教程**:关注像Towards Data Science这样权威的博客平台。

### 5.3.2 行业认证与专家成长策略

- **获得认证**:一些专业认证如Cloudera Certified Associate等可以提升个人简历的含金量。

- **专家成长策略**:参加行业会议、研讨会,以及定期的自我评估来规划个人职业发展路线图。

通过本章的内容,您应该已经了解了如何利用重要的数据科学工具和资源来提升您的工作效率和专业水平。在下一章中,我们将深入探讨如何将这些工具和资源应用于数据科学项目中,以实现更高效的数据分析和决策制定。

0

0