【Python编码问题排查】:使用unicodedata库,文本编码难题迎刃而解

发布时间: 2024-09-29 21:14:27 阅读量: 2 订阅数: 23

# 1. Python编码问题概述

## 1.1 编码问题的重要性

Python作为一种广泛使用的编程语言,其编码问题对于保证程序的正确性和可维护性至关重要。理解编码问题可以帮助开发者避免数据损坏、乱码等常见问题。

## 1.2 常见的编码问题

在处理不同来源和格式的数据时,开发者可能会遇到字符编码不匹配、解码失败等问题。这些问题会直接影响程序的执行效率和输出结果。

## 1.3 编码问题的影响范围

编码问题不仅仅是技术细节,它还关系到数据的完整性、用户体验以及国际化软件的开发。正确处理编码问题,可以为软件提供更好的扩展性和稳定性。

## 1.4 文章的目标与结构

本文旨在通过分析和实践案例,详细讲解Python中的编码问题,提供实用的排查技巧和优化策略,帮助读者深化对编码问题的理解,并在实际开发中有效解决这些问题。文章将从编码基础开始,逐步深入到具体的库应用、排查技巧以及预防优化措施,最后讨论编码问题的未来发展趋势。

# 2. Python文本编码基础

## 2.1 Python中的字符编码理论

### 2.1.1 字符与编码的起源

字符是书写系统中最小的可独立运用的书写符号,用于文本的显示和输入。字符编码则是将字符映射到特定数值的过程,以便计算机处理。早期的计算机系统处理字符时面临着多种编码标准,如ASCII、ISO-8859、GB2312等,这造成了诸多不兼容的问题。

字符编码的起源可追溯至1960年代的ASCII,它是美国国家标准信息交换码(American Standard Code for Information Interchange),使用7位来表示128个字符,包括英文字母、数字、标点符号及控制字符。但随着计算机技术的全球普及,ASCII编码已不能满足所有语言字符的表示需求,从而衍生出更多的编码标准。

### 2.1.2 Unicode编码的介绍和优势

Unicode是为了取代各种已有的编码体系,提供一个统一的字符编码而设计的。Unicode使用16位的码点(code point)来表示每个字符,理论上可以表示超过65,000个字符,覆盖了几乎所有的书面语言字符。

Unicode的优势在于其标准化和通用性,它能够解决不同编码之间的转换问题,并减少了系统中字符处理的复杂性。然而,Unicode也会带来数据存储效率的问题,因为每个字符都需要16位或更多位来表示,相比7位的ASCII码,存储空间需求显著增加。

## 2.2 Python中字符串的内部表示

### 2.2.1 字符串编码的内部结构

Python中的字符串有两种类型:`str`和`bytes`。`str`类型代表字符串对象,使用Unicode编码,在内存中以一系列的码点存储。`bytes`类型则表示二进制序列,通常用于表示字节流或者文件内容。

在内部表示上,Python 3默认使用UTF-8编码,这是一个变长编码系统,允许以1到4个字节表示一个Unicode码点。UTF-8具有很好的兼容性,能与ASCII向后兼容,并且已经被广泛应用于网络通信和文本文件存储。

### 2.2.2 了解str和bytes的区别

`str`和`bytes`的区别不仅在于它们所代表的数据类型,还在于它们的使用场景和转换机制。在进行文件读写、网络传输等操作时,常常需要在这两种类型之间进行转换。

例如,从文本文件中读取内容时,默认得到的是`str`类型的数据。而当数据需要写入到一个二进制文件,或者通过网络发送时,则需要转换为`bytes`。反之亦然,在读取二进制文件或网络数据后,通常需要将其转换为`str`以方便处理。

## 2.3 Python默认编码与文件读写

### 2.3.1 默认编码的识别与设置

Python解释器在启动时,会根据环境变量或命令行参数来确定默认的编码方式。在不同操作系统中,Python的默认编码可能不同,例如在Windows中默认可能是cp1252或者cp1251,在Linux或MacOS中可能是UTF-8。

开发者可以通过在代码中显式设置来覆盖默认编码,确保在不同环境下代码的一致性。例如,在读取或写入文件时,显式指定文件的编码类型,可以避免在特定编码环境下发生编码错误。

### 2.3.2 文件读写中的编码转换问题

文件的编码转换是常见的编码问题之一。当打开一个文本文件时,如果文件的编码和Python的默认编码不一致,就会产生编码错误。为了解决这类问题,Python提供了`open`函数的`encoding`参数,通过这个参数可以明确指定文件的编码方式。

```python

# 打开一个UTF-8编码的文件,并且指定编码

with open('example.txt', 'r', encoding='utf-8') as f:

content = f.read()

```

在上面的代码中,我们明确地告诉Python解释器,我们正在读取一个UTF-8编码的文本文件。这样,无论Python默认的编码是什么,我们都能正确读取文件内容,避免了编码问题。

此外,在写入文件时同样需要考虑编码问题。如果把`str`类型的字符串直接写入文件,Python会使用默认的编码进行转换。如果想要使用特定的编码,需要在`open`函数中显式指定。

```python

# 打开一个文件,并用UTF-8编码写入字符串

with open('output.txt', 'w', encoding='utf-8') as f:

f.write('这是一段中文字符串')

```

在上述例子中,即使是中文等非ASCII字符,也可以正确地写入到文本文件中,而不会出现乱码问题。

总结起来,Python默认编码的识别与设置,以及文件读写中的编码转换问题,关键在于对编码方式的明确指定和对编码差异的充分理解。通过合理的编码处理,可以确保Python程序在不同环境下的兼容性和稳定性。

# 3. unicodedata库深入解析

在处理Python中的编码问题时,`unicodedata`库是解决字符标准化、规范化和特殊字符处理的重要工具。本章将深入探讨`unicodedata`库的功能与应用,并提供实用的字符处理策略。

## 3.1 unicodedata库的功能与应用

### 3.1.1 库的基本功能介绍

`unicodedata`模块属于Python的标准库,它提供了对Unicode字符数据库的访问,使得开发者能够查询字符的属性、执行字符的标准化操作等。该模块支持以下功能:

- 查询字符属性:例如类别、组合、大小写转换等。

- 字符标准化:支持NFC、NFD、NFKC、NFKD四种Unicode规范化形式。

- 字符分解和组合:对字符进行标准化分解和组合操作。

- 处理大小写转换:提供大小写转换和大小写映射的相关功能。

### 3.1.2 在编码问题中unicodedata的使用

在处理编码问题时,`unicodedata`库能极大简化字符规范化与处理工作。例如,要将字符串规范化到NFC形式,代码如下:

```python

import unicodedata

s = 'café'

normalized_s = unicodedata.normalize('NFC', s)

print(normalized_s) # 输出: café

```

在上述代码中,`normalize`函数将字符串`'café'`转换为其规范形式。使用`unicodedata`可以避免编码错误,确保数据在网络传输、数据库存储等方面的一致性。

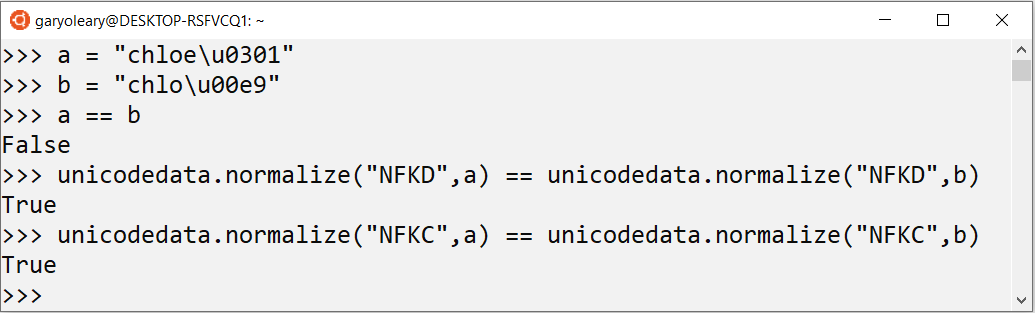

## 3.2 字符标准化与规范化

### 3.2.1 字符的标准化问题

字符标准化是将字符转换成一种标准格式的过程。例如,某些字符在Unicode中可以表示为多个码点的组合,称为字符的组合形式;而另外一些字符可以分解为单独的码点,称为字符的分解形式。标准化能够将这些表示方式转换为统一的形式,从而避免处理编码时的混淆。

### 3.2.2 规范化过程中的编码处理

在`unicodedata`库中,标准化主要通过以下四种形式进行:

- NFC (Normalization Form C):使用最少的码点,将字符组合。

-

0

0