【数据分析师的效率神器】:掌握Anaconda包管理与工作流程

发布时间: 2024-12-10 05:17:29 阅读量: 17 订阅数: 14

Anaconda安装全攻略:轻松上手Python数据分析与机器学习.zip

# 1. 数据科学与Anaconda简介

在当今快速发展的数据科学领域,Anaconda已成为数据科学家和开发者的首选工具。Anaconda不仅仅是一个Python发行版,它还包含了一个庞大的开源库集合,这些库支持数据科学的整个工作流程,从数据处理到机器学习,再到深度学习。

## 1.1 数据科学的含义

数据科学涉及从数据中提取知识和见解的一系列方法、过程和系统。它包括数据预处理、数据清洗、数据分析、统计分析、数据可视化,以及机器学习。数据科学家利用各种工具和技术来解决复杂的问题,并在商业、医学、科学研究等多个领域中应用这些解决方案。

## 1.2 Anaconda的作用

Anaconda为数据科学工作流程提供了一站式的解决方案。它预装了像NumPy、Pandas、Matplotlib这样的常用科学计算库,让开发者可以快速开始项目而不必担心配置环境的问题。同时,Anaconda还允许用户方便地安装和管理第三方包和库,包括深度学习框架如TensorFlow和PyTorch。

## 1.3 Anaconda的安装和配置

安装Anaconda非常简单,只需从[Anaconda官网](https://www.anaconda.com/download/)下载适合操作系统的安装包,然后按照提示完成安装。安装完成后,通过在命令行中运行`conda list`,可以查看已安装的包及其版本,从而验证安装是否成功。

对于更深入的配置和环境管理,下一章将详细介绍如何通过Anaconda进行环境的安装、管理和优化。这将为读者构建强大的数据科学工作环境打下基础。

# 2. Anaconda环境安装与管理

## 2.1 安装Anaconda及其组件

### 2.1.1 下载与安装过程

Anaconda 是一个用于科学计算的Python发行版,它提供了包管理和环境管理的功能,极大地简化了包与环境的管理。安装Anaconda的第一步是下载适合您操作系统的版本。Anaconda官方网站提供了Windows、macOS和Linux系统的不同安装包。点击下载按钮后,您可以获取一个安装脚本或一个安装程序。

对于Windows用户,下载的是一个`.exe`文件;而对于Linux和macOS用户,则下载的是`.sh`脚本文件。安装过程简单直接,但需要注意选择合适的选项,如将Anaconda添加到系统的PATH环境变量中。

以下是安装过程中可能采取的关键步骤:

```bash

# Linux 或 macOS 下的安装命令示例

bash Anaconda3-2023.02-Linux-x86_64.sh

```

安装过程中,您需要阅读并同意许可协议,然后可以选择安装路径,以及是否将Anaconda添加到PATH环境变量中。建议添加到PATH,这样可以方便地在任何目录下使用conda命令。

### 2.1.2 安装后的验证与配置

安装完成后,为了验证Anaconda是否正确安装,可以在终端执行以下命令:

```bash

# 检查conda版本确认安装成功

conda --version

# 列出conda配置信息,确认环境变量已正确设置

conda config --show

```

此外,进行一些初始配置也是很好的实践。比如设置conda的下载速度,可以使用如下命令:

```bash

# 设置国内镜像源,加速包的下载

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --set show_channel_urls yes

```

通过以上步骤,Anaconda安装后便可以进行环境管理以及包的安装了。

## 2.2 管理Anaconda环境

### 2.2.1 创建与激活环境

Anaconda的一个核心概念是环境(Environment),它允许用户在同一台机器上安装不同版本的包并独立使用。创建新环境可以使用`conda create`命令。

```bash

# 创建一个名为myenv的环境,Python版本为3.8

conda create --name myenv python=3.8

```

创建环境后,通过以下命令来激活环境:

```bash

# 激活名为myenv的环境

conda activate myenv

```

环境激活后,所有后续的包安装和运行操作都在这个环境下进行,不会影响到系统或其他环境。

### 2.2.2 环境的复制与导出

有时需要复制一个环境到另一台机器或备份当前环境,此时可以使用`conda env export`命令来导出环境配置到一个文件,然后在另一台机器上使用`conda env create`来创建相同的环境。

导出当前环境:

```bash

# 将当前激活的环境导出到文件

conda env export > environment.yaml

```

导出的`environment.yaml`文件将包含环境的详细配置,包括Python版本、包的依赖关系等。其他用户或在其他机器上可以通过以下命令来创建相同的环境:

```bash

# 使用环境配置文件创建环境

conda env create -f environment.yaml

```

### 2.2.3 环境的删除与清理

在环境不再需要时,可以通过以下命令删除:

```bash

# 删除名为myenv的环境

conda remove --name myenv --all

```

删除环境会移除所有相关包和环境配置,释放空间。如果在使用环境中出现包冲突或依赖问题,也可以使用`conda clean`命令进行清理:

```bash

# 清理不再需要的包和缓存

conda clean --all

```

## 2.3 包的安装与更新

### 2.3.1 安装第三方Python包

使用conda进行包的安装非常简单。例如,要安装名为`numpy`的包,可以使用以下命令:

```bash

# 安装numpy包

conda install numpy

```

conda会自动解决包依赖并安装,确保包能够在环境中正常工作。

### 2.3.2 更新Anaconda及其包

随着时间的推移,Anaconda和其中的包都需要更新到最新版本,以获取最新的功能和安全更新。更新Anaconda自身可以使用:

```bash

# 更新conda本身

conda update conda

```

更新特定包或者所有包,可以使用:

```bash

# 更新名为numpy的包

conda update numpy

# 更新环境中的所有包

conda update --all

```

### 2.3.3 解决依赖和冲突问题

在安装或更新包时,可能会遇到依赖或冲突问题。当conda无法自动解决依赖时,会显示错误信息,此时可以指定包的版本,或者使用`conda search`命令查看可用版本:

```bash

# 查询numpy包的可用版本

conda search numpy

```

安装时指定版本解决依赖:

```bash

# 安装特定版本的numpy包

conda install numpy=1.19.2

```

通过这些方法,你可以有效地管理Anaconda环境中的包,并解决可能遇到的依赖和冲突问题。

# 3. 数据处理与可视化

## 3.1 数据处理工具:Pandas

### 3.1.1 Pandas基本数据结构

Pandas是一个开源的Python数据分析库,提供了快速、灵活和表达能力强的数据结构,旨在使"关系"或"标签"数据的使用更加轻松。它主要用于数据挖掘和数据分析工作,并且是Python数据科学生态中的基石。

在Pandas库中,最核心的数据结构有两个,一个是`Series`,另一个是`DataFrame`。`Series`是一维数组结构,它可以容纳任何数据类型,例如整数、字符串、浮点数等。而`DataFrame`则是二维标签化数据结构,可以看作是一个表格,既有行索引,也有列索引。

让我们通过一些代码来了解如何使用Pandas创建和操作数据结构。

```python

import pandas as pd

# 创建一个Series对象

series_data = pd.Series([1, 2, 3, 4, 5])

# 创建一个DataFrame对象

data = {'Column1': [1, 2, 3], 'Column2': [4, 5, 6]}

df = pd.DataFrame(data)

print("Series:\n", series_data, "\n\nDataFrame:\n", df)

```

在上述代码中,我们首先导入了pandas库,并利用`pd.Series()`创建了一个一维数组结构,然后利用`pd.DataFrame()`创建了一个二维表格结构。创建完成后,我们打印了这两个对象,以便查看其内容。

### 3.1.2 数据清洗与预处理

数据清洗与预处理是数据分析过程中非常关键的一步。使用Pandas进行数据预处理,我们可以完成诸如缺失值处理、数据转换、特征工程等多种任务。

在Pandas中,常见的数据清洗与预处理方法包括:

- 处理缺失值:使用`fillna()`、`dropna()`等方法。

- 数据类型转换:使用`astype()`方法。

- 特征提取:使用字符串处理功能,如`str.split()`,`str.contains()`等。

- 重复数据处理:使用`duplicated()`和`drop_duplicates()`方法。

- 数据标准化与归一化:使用`sklearn.preprocessing`模块中的`StandardScaler`和`MinMaxScaler`等。

让我们来看一个具体的例子:

```python

# 假设df是之前创建的DataFrame

# 假设其中存在缺失值

# 填充缺失值

df_filled = df.fillna(0)

# 删除包含缺失值的行

df_dropped = df.dropna()

# 重置索引,避免因删除操作造成的索引混乱

df_dropped = df_dropped.reset_index(drop=True)

print("DataFrame after filling missing values:\n", df_filled, "\n\nDataFrame after dropping rows with missing values:\n", df_dropped)

```

在上述代码中,我们处理了假设中的`df` DataFrame的缺失值问题,使用了`fillna()`方法将所有缺失值填充为0,然后使用`dropna()`方法删除了包含缺失值的行,并使用`reset_index()`方法重置了DataFrame的索引,以避免在删除操作后索引混乱。

通过以上的步骤,我们可以看到,Pandas不仅提供了非常灵活的数据结构,还提供了强大的数据清洗和预处理功能,使得数据科学家可以高效地准备数据,为后续的数据分析和机器学习工作打下坚实的基础。

# 4. 机器学习工作流程

## 4.1 机器学习库:Scikit-learn

机器学习是一个实现智能系统预测、决策和学习的强大工具。而Scikit-learn是一个在Python中实现机器学习算法的库,它的API设计简洁、优雅并且拥有广泛的功能。在此小节,我们将深入探讨Scikit-learn库,并了解如何使用它进行模型选择、训练和验证。

### 4.1.1 Scikit-learn中的模型选择

Scikit-learn支持多种类型的机器学习模型,包括分类、回归、聚类、降维等。选择合适的模型是机器学习项目成功的关键。Scikit-learn的模型选择主要通过模型的算法类别来完成,每种模型都有其适用的场景。

```python

from sklearn.linear_model import LogisticRegression

from sklearn.svm import SVC

from sklearn.neighbors import KNeighborsClassifier

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import RandomForestClassifier

# 模型列表示例

models = {

'逻辑回归': LogisticRegression(),

'支持向量机': SVC(),

'K最近邻': KNeighborsClassifier(),

'决策树': DecisionTreeClassifier(),

'随机森林': RandomForestClassifier()

}

```

在上述代码中,我们创建了一个包含不同类型分类器的字典。选择模型时需要考虑多个因素,如数据的特征类型、数据集大小、模型的解释性、计算资源等。对于小规模数据集,决策树和K最近邻模型通常是不错的选择。而对于大规模数据集或者需要更好泛化能力的情况,支持向量机和随机森林可能是更好的选择。

### 4.1.2 模型训练、验证和测试

模型训练、验证和测试是机器学习项目中不可或缺的步骤。Scikit-learn提供了一系列工具,帮助我们简化这些过程。利用`train_test_split`函数可以轻松地将数据集分成训练集和测试集,而`cross_val_score`函数则用于执行交叉验证。

```python

from sklearn.model_selection import train_test_split, cross_val_score

from sklearn.metrics import accuracy_score

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

# 加载数据集

data = load_iris()

X, y = data.data, data.target

# 将数据集分割成训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建模型实例

model = RandomForestClassifier()

# 训练模型

model.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = model.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

# 执行交叉验证

cv_scores = cross_val_score(model, X, y, cv=5)

print("测试集准确率:", accuracy)

print("交叉验证分数:", cv_scores)

```

在上述例子中,我们使用了鸢尾花(Iris)数据集进行演示。我们首先将数据集分割为训练集和测试集,然后训练了一个随机森林分类器,并在测试集上评估了模型的准确率。交叉验证则提供了对模型泛化能力的进一步了解。通过这些步骤,我们可以验证模型的性能,并对其作出相应的调整。

## 4.2 Jupyter Notebook的使用

Jupyter Notebook是一个强大的工具,它允许我们创建和共享包含实时代码、方程、可视化和说明性文本的文档。对于数据分析、机器学习等领域的研究和开发工作来说,Jupyter Notebook是一个不可或缺的工具。

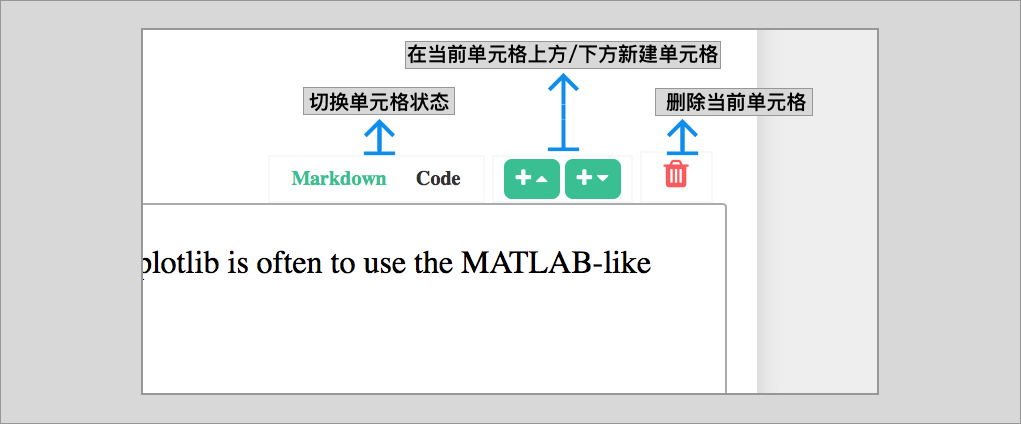

### 4.2.1 Jupyter Notebook入门

Jupyter Notebook提供了代码单元格和文本单元格两种类型的单元格。用户可以在代码单元格中编写和执行Python代码,并在文本单元格中插入Markdown格式的说明性文本。为了使用Jupyter Notebook,您需要首先安装Jupyter包:

```sh

pip install notebook

```

安装完成后,您可以使用以下命令启动Jupyter Notebook服务:

```sh

jupyter notebook

```

启动服务后,将自动在默认的Web浏览器中打开Jupyter Notebook的界面。您可以通过界面创建新的笔记本,并开始编写代码。

### 4.2.2 编写交互式数据分析代码

Jupyter Notebook最大的优点之一就是其交互式的特性,它允许用户逐步执行代码,并能够立即看到代码执行的结果。这种工作方式非常适合数据分析,因为它允许用户更直观地理解数据处理和分析过程中的每一个步骤。

```python

# 一个简单的数据分析代码示例

import pandas as pd

# 创建一个DataFrame

df = pd.DataFrame({

'A': [1, 2, 3],

'B': [4, 5, 6]

})

# 显示DataFrame

df.head()

```

在上述代码中,我们首先导入了pandas库,并创建了一个简单的DataFrame。使用`head()`函数可以快速查看DataFrame中的前几行数据。Jupyter Notebook会直接在单元格下方显示`head()`函数的输出结果,使得数据分析过程更加清晰和直观。

## 4.3 实践:构建一个完整项目

在机器学习的实践中,从数据获取到分析的整个流程需要精细的操作和反复的迭代。在此小节,我们将通过一个简单的项目案例来展示从数据获取到分析的整个流程。

### 4.3.1 从数据获取到分析的完整流程

构建一个完整的机器学习项目,需要经过以下步骤:数据获取、数据预处理、特征工程、模型训练、模型评估和结果解释。以下是一个项目流程的概述。

**数据获取**

数据获取是机器学习的第一步,我们可以通过API、爬虫、数据库、公开数据集等多种方式获得数据。在获取数据后,需要对数据的结构、质量和完整性进行初步的了解。

**数据预处理**

在数据预处理阶段,我们需要处理缺失值、异常值,并进行数据标准化或归一化。这个阶段是保证模型训练效果的关键。

```python

import numpy as np

# 假设df是我们的DataFrame

# 检测并处理缺失值

df.fillna(df.mean(), inplace=True)

# 异常值处理(这里使用一个简单的例子)

df = df[(np.abs(stats.zscore(df)) < 3).all(axis=1)]

```

在上述代码中,我们使用了`fillna`方法来填充缺失值,并通过`zscore`函数来识别并排除异常值。

**特征工程**

特征工程是提升模型性能的重要步骤。特征选择、特征构造、特征转换等都是特征工程的一部分。

```python

from sklearn.preprocessing import StandardScaler

# 特征转换示例

scaler = StandardScaler()

df_scaled = pd.DataFrame(scaler.fit_transform(df), columns=df.columns)

```

在上述代码中,我们使用了`StandardScaler`来进行特征的标准化处理。

**模型训练**

使用Scikit-learn等库进行模型训练:

```python

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import classification_report

# 将数据分为特征和标签

X = df_scaled.drop('target', axis=1)

y = df_scaled['target']

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练模型

model = RandomForestClassifier()

model.fit(X_train, y_train)

# 预测

y_pred = model.predict(X_test)

# 评估

print(classification_report(y_test, y_pred))

```

上述代码演示了如何使用随机森林分类器训练一个分类模型,并输出评估报告。

**结果解释**

模型训练完成后,需要对模型进行评估和解释。根据评估指标来解释模型的性能,并根据实际业务需求调整模型。

### 4.3.2 项目案例分析与总结

案例分析是将理论与实践相结合的过程。对于本章节的项目案例,我们采用了标准的机器学习工作流程:从数据获取开始,经过预处理、特征工程,到模型训练、验证和测试,最终通过评估来判断模型的好坏,并据此进行调整。这个流程不仅涵盖了机器学习的主要环节,而且还提供了深度理解和实践技巧。

通过对本案例的分析,我们了解到数据获取的途径和数据预处理的重要性,特征工程的技巧和模型训练的有效方法。更重要的是,我们学会了如何评估模型的性能,并根据性能指标对模型进行调整优化。这些知识和技能对于数据科学家和机器学习工程师来说,都是非常宝贵的。

最后,本项目案例也强调了模型解释的重要性。在某些应用领域,模型解释不仅是必要的,而且还是法律和伦理的要求。因此,构建一个可解释的模型也是整个项目工作流程中不可或缺的一部分。

通过完成以上内容的学习,您将掌握使用Scikit-learn构建机器学习模型的整个流程,并能够利用Jupyter Notebook进行交互式的数据分析和模型训练。这样的技能将大大提高您在实际工作中解决问题的效率和效果。

# 5. 深度学习与Anaconda

## 5.1 深度学习框架概览

### 5.1.1 TensorFlow和Keras简介

深度学习在数据科学领域迅猛发展,尤其是其在图像识别、自然语言处理、预测分析等方面的应用。TensorFlow是由Google开发的一个开源机器学习框架,其设计注重灵活性和可移植性,支持多种语言和平台。Keras则是一个高级神经网络API,可以运行在TensorFlow之上,它以其简洁、易用性而受到广泛欢迎。

TensorFlow 2.x版本开始,Keras已经成为了其默认的高阶API。这意味着用户在使用TensorFlow时,可以利用Keras简化模型的构建、训练、测试等过程。在安装和使用中,Keras也提供了更为直观的方法来设计深度学习模型,这使得它成为初学者和经验丰富的数据科学家们共同的选择。

### 5.1.2 PyTorch简介

PyTorch是Facebook的一个开源机器学习库,同样广泛应用于深度学习领域。相比于TensorFlow,PyTorch更注重动态计算图,使得网络设计更为灵活。这种设计特别适合研究和开发阶段,因为它允许用户在运行时改变网络结构,这在实验阶段是非常有用的。

PyTorch提供了强大的GPU加速功能,其易用性和灵活性使得它成为了研究者的新宠。此外,PyTorch有着活跃的社区和大量预训练模型,为实践者提供了便利。

## 5.2 安装和配置深度学习框架

### 5.2.1 安装TensorFlow和Keras

要安装TensorFlow和Keras,首先需要确保你已经正确安装了Anaconda。接下来,可以使用conda命令或pip来安装这些库。由于TensorFlow对依赖包有较多要求,使用conda命令可以更好地管理依赖。

```bash

# 使用conda安装TensorFlow和Keras

conda install -c anaconda tensorflow

```

上述命令会自动解决所有依赖并安装TensorFlow。Keras作为TensorFlow的高阶API,通常会随TensorFlow一起被安装。

### 5.2.2 安装PyTorch

PyTorch同样可以通过conda安装,但也可以使用其官方提供的安装脚本。PyTorch的安装过程同样需要确保系统的其他依赖项已经安装好,比如CUDA(如果你打算使用NVIDIA的GPU)。

```bash

# 使用conda安装PyTorch

conda install -c pytorch pytorch torchvision torchaudio

```

这个命令会安装PyTorch及其常用的附加包。如果你需要特定版本的PyTorch,可以访问其官方网站获取更多安装选项。

## 5.3 深度学习项目实践

### 5.3.1 构建一个简单的深度学习模型

构建深度学习模型需要定义网络结构、损失函数、优化器等。以下是一个使用TensorFlow和Keras构建简单神经网络的例子:

```python

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

from tensorflow.keras.optimizers import Adam

# 定义一个简单的序贯模型

model = Sequential()

model.add(Dense(12, input_dim=8, activation='relu'))

model.add(Dense(8, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 编译模型

model.compile(loss='binary_crossentropy', optimizer=Adam(learning_rate=0.001), metrics=['accuracy'])

# 打印模型概况

model.summary()

```

在上述代码中,我们创建了一个简单的三层神经网络。我们使用了激活函数ReLU和Sigmoid,以及Adam优化器。在`model.summary()`中,我们可以看到模型的每一层的输出形状和参数数量。

### 5.3.2 模型训练、评估和部署

训练模型是通过`model.fit()`方法来完成的,该方法需要输入训练数据和标签,同时还可以指定批处理大小和训练轮次(epochs)。

```python

# 假定x_train和y_train是已经准备好的数据和标签

model.fit(x_train, y_train, epochs=150, batch_size=10)

```

模型训练完成后,我们通常会使用验证集来评估模型的性能。最后,可以将模型保存,以便部署到生产环境中使用。

```python

# 评估模型

scores = model.evaluate(x_test, y_test)

print("\n%s: %.2f%%" % (model.metrics_names[1], scores[1]*100))

# 保存模型

model.save('model.h5')

```

保存后的模型可以使用`load_model`函数加载并进行预测:

```python

from tensorflow.keras.models import load_model

# 加载模型

new_model = load_model('model.h5')

# 进行预测

predictions = new_model.predict(x_test)

```

在上述实践过程中,我们详细了解了如何使用TensorFlow和Keras来构建、训练、评估和部署深度学习模型。这些步骤是深度学习项目的核心,了解它们对于任何希望深入这一领域的数据科学家来说都是至关重要的。

# 6. 自动化工作流与性能优化

在数据科学与AI开发的日常工作中,效率和性能是至关重要的。Anaconda提供了强大的工具和方法,可以大大提升我们的工作效率,并帮助我们优化项目性能。本章节,我们将探讨自动化工作流的建立,性能优化策略,以及如何确保环境的安全性和管理数据版本。

## 6.1 自动化工作流

自动化可以极大地减少重复性工作,提高工作效率。在Anaconda环境中,我们可以通过conda命令和pip,结合脚本来自动化管理环境和执行任务。

### 6.1.1 使用conda和pip命令自动管理环境

conda是一个强大的环境管理工具,它允许我们创建独立的环境,以管理不同项目的依赖关系。使用conda的命令行接口可以轻松地自动化环境管理过程。

#### 示例:创建并激活一个名为`myenv`的新环境,并安装所需的包

```bash

conda create --name myenv python=3.8

conda activate myenv

conda install numpy pandas

```

此外,我们可以编写一个`yaml`文件来指定依赖关系,然后使用`conda env create`命令来自动化创建环境。

#### 示例:创建环境的yaml文件内容(myenv.yaml)

```yaml

name: myenv

channels:

- conda-forge

dependencies:

- python=3.8

- numpy=1.20

- pandas=1.2.4

```

然后,执行以下命令来创建环境:

```bash

conda env create -f myenv.yaml

```

### 6.1.2 利用脚本自动化常见任务

对于重复性较高的数据处理任务,我们可以编写Python脚本来自动化处理流程。例如,利用Pandas进行数据清洗。

#### 示例:编写一个Python脚本(data_cleaning.py)来自动化数据清洗过程

```python

import pandas as pd

def clean_data(file_path):

# 读取数据

df = pd.read_csv(file_path)

# 数据清洗操作,如去除重复值

df.drop_duplicates(inplace=True)

# 保存清洗后的数据到新文件

df.to_csv('cleaned_data.csv', index=False)

if __name__ == "__main__":

file_path = 'raw_data.csv'

clean_data(file_path)

```

通过在脚本中设置定时任务或触发条件,我们可以自动化执行这类数据处理工作。

## 6.2 性能优化策略

性能优化是确保大型数据分析项目能够高效运行的关键。在使用Anaconda时,我们可以采取一些策略来监控和优化环境性能。

### 6.2.1 Anaconda环境性能监控

监控是性能优化的第一步。Anaconda环境中的性能监控可以借助一些工具来完成。例如,conda可以在安装包时显示环境信息,而Anaconda Navigator提供了一个图形界面,用于管理环境和包。

### 6.2.2 代码级别的性能优化技巧

在代码级别,性能优化主要依靠算法效率和资源管理。在Python中,我们可以使用一些内置的性能分析工具,比如`cProfile`,来分析代码的运行时间。

#### 示例:使用cProfile分析一段代码的性能

```python

import cProfile

def some_function():

# 假设这里是一段复杂的计算过程

pass

cProfile.run('some_function()')

```

这将输出函数`some_function`的性能报告,我们可以根据报告来优化代码。

## 6.3 安全与版本控制

在进行数据分析时,安全性和版本控制同样重要。确保环境的安全性和管理好版本可以提升项目整体的可靠性和可维护性。

### 6.3.1 Anaconda环境安全最佳实践

在创建新环境时,推荐使用`--strict-channel-priority`选项来确保包的依赖关系更清晰。

```bash

conda create --name secure_env --strict-channel-priority python=3.8

```

另外,不要在根环境下安装包,始终在隔离的环境中安装和管理包。

### 6.3.2 版本控制在数据分析中的应用

版本控制工具,如Git,对于团队协作和代码管理至关重要。在Jupyter Notebook中,我们可以使用`nbstripout`来保证每次提交都是干净的。

#### 示例:安装nbstripout

```bash

pip install nbstripout

nbstripout --install

```

在协作环境中,确保所有成员都安装了`nbstripout`,这样可以避免提交带有个人信息的未清理的Notebook。

通过本章的探讨,我们可以了解到如何通过自动化工作流来提升效率,如何监控和优化性能,以及如何确保我们的工作环境安全可靠。以上这些实践将帮助我们构建更加稳定和高效的分析工作流。

0

0