【文本生成中的注意力机制】:PyTorch实现的深入优化技巧

发布时间: 2024-12-11 15:38:08 阅读量: 9 订阅数: 11

chatbot_seq2seq:pytorch实现对话系统,参考官网项目

# 1. 注意力机制在文本生成中的作用和原理

在自然语言处理(NLP)领域,注意力机制是近年来的一个重大突破,它极大地提升了文本生成模型的性能和质量。注意力机制的作用和原理主要体现在以下几个方面:

## 1.1 概念引入

注意力机制最初由研究者在机器翻译任务中提出,其核心思想是模型能够在生成文本时,动态地聚焦于输入序列的不同部分。这模拟了人类在阅读或理解长文本时的行为,即我们通常会重点关注与当前任务相关的信息,而忽略无关的细节。

## 1.2 作用机制

在文本生成中,注意力机制帮助模型记住整个输入序列的信息,并在生成输出时灵活选择重要的输入部分。这样不仅提升了模型的准确性,还增强了其处理长距离依赖关系的能力,这对于处理自然语言的复杂性至关重要。

## 1.3 理论模型

从理论上讲,注意力模型通过一个权重分布来实现,这个分布衡量了输入序列中每个元素对于生成当前输出的重要性。在实践中,这通常通过加权求和的方式实现,其中权重是由注意力分数决定的,而这些分数是通过可学习的参数来计算的。

简而言之,注意力机制通过使模型能够“关注”输入序列的相关部分,极大地改进了文本生成的质量和模型的效率。在接下来的章节中,我们将深入了解如何在PyTorch中实现这一机制,并探讨如何在实际应用中对其进行优化和调试。

# 2. PyTorch基础及注意力机制实践

## 2.1 PyTorch简介及其在深度学习中的应用

### PyTorch的核心组件和基本操作

PyTorch是一个广泛使用的开源机器学习库,主要用于自然语言处理和计算机视觉任务。它的主要特点是灵活性和易用性,特别是对于研究人员而言,它提供了一种快速实验和原型开发的途径。PyTorch的核心组件包括张量(tensors)、自动微分(automatic differentiation)以及神经网络(neural network)模块。

在PyTorch中,张量类似于NumPy的多维数组,但可以在GPU上运行,这使得大规模数值计算变得非常快速和高效。自动微分是深度学习模型训练的关键,PyTorch的自动微分引擎可以根据数据流图自动计算梯度,极大地简化了反向传播算法的实现。

```python

import torch

import torch.nn as nn

# 创建一个3x3的矩阵张量

tensor = torch.tensor([[1, 2, 3], [4, 5, 6], [7, 8, 9]], dtype=torch.float)

# 张量的基本操作,例如计算梯度和维度变换

# 注意:为了启用梯度计算,需要调用tensor.requires_grad_(True)

tensor.requires_grad_(True)

# 对张量执行操作后,PyTorch会自动记录操作历史,用于后续梯度计算

output = tensor.mean()

# 反向传播计算梯度

output.backward()

# 打印梯度结果

print(tensor.grad)

```

在这段代码中,我们首先导入了PyTorch的相关模块,然后创建了一个张量并对其执行了均值计算。之后,调用`backward()`方法来自动计算梯度,并打印出来。这展示了PyTorch自动微分的核心功能。

### PyTorch与文本生成的关系

文本生成是深度学习中一个非常重要的应用领域,而PyTorch为实现复杂的文本生成模型提供了一个强有力的工具箱。借助于PyTorch的动态计算图(Dynamic Computational Graph),研究人员可以自由地设计网络结构,甚至在运行时更改它们,这为注意力机制等模型的实现提供了极大的便利。

下面展示了如何使用PyTorch构建一个简单的循环神经网络(RNN),该网络可以用于文本生成任务:

```python

class SimpleRNN(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim):

super(SimpleRNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.rnn = nn.RNN(embedding_dim, hidden_dim)

self.fc = nn.Linear(hidden_dim, vocab_size)

def forward(self, x, hidden):

embedded = self.embedding(x)

output, hidden = self.rnn(embedded, hidden)

output = self.fc(output)

return output, hidden

# 初始化模型参数

vocab_size = 1000 # 假设词汇表大小为1000

embedding_dim = 256

hidden_dim = 512

model = SimpleRNN(vocab_size, embedding_dim, hidden_dim)

```

在此代码中,我们定义了一个继承自`nn.Module`的简单RNN模型。模型包含嵌入层`embedding`、一个RNN层和一个全连接层`fc`。模型的`forward`方法描述了数据如何通过网络流动。

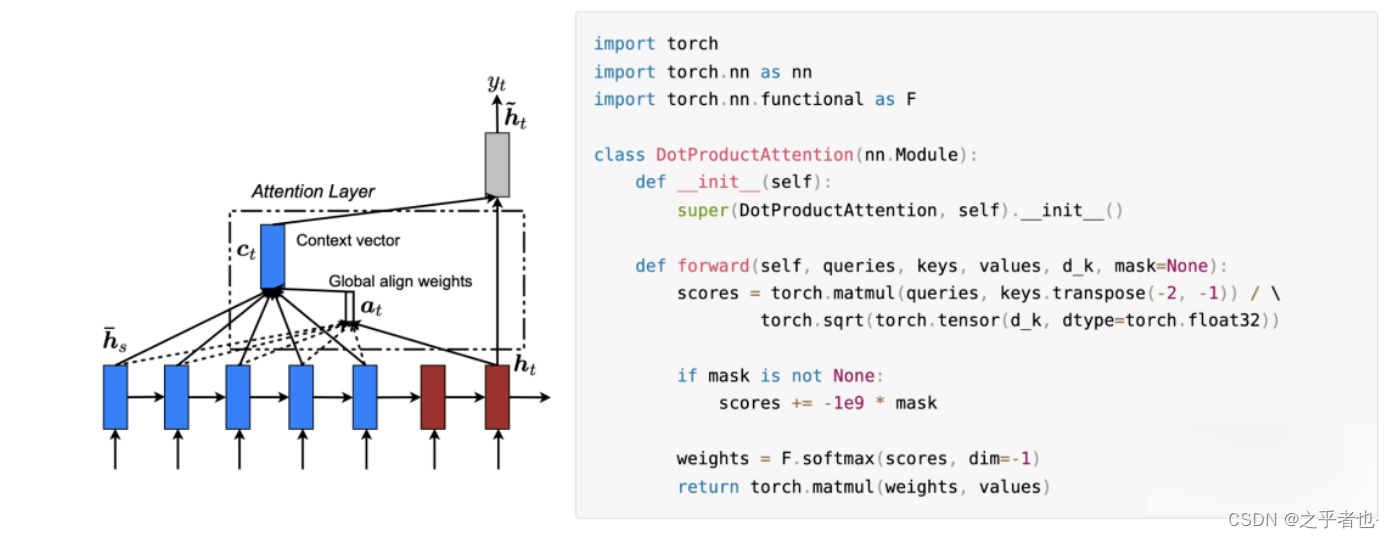

## 2.2 注意力机制的基础实现

### 注意力机制的基本概念和数学模型

注意力机制是一种模仿人类注意力过程的技术,它允许模型在处理序列数据时动态地关注序列的不同部分。注意力机制在文本生成任务中尤为重要,因为它可以帮助模型更好地捕捉到长距离依赖关系。

数学上,注意力机制涉及以下几个核心部分:查询(Query)、键(Key)、值(Value)以及它们的交互。一个基本的注意力计算可以概括为以下公式:

```

score(Q, K) = Q * K.T / sqrt(d_k)

```

其中`Q`是查询,`K`是键,`d_k`是键向量的维度。得到的分数(score)再通过softmax函数进行归一化,得到注意力权重(attention weights)。这些权重随后用于加权求和值(Value)向量,从而得到最终的输出。

### PyTorch中的注意力机制组件

PyTorch提供了一系列内置的组件来实现注意力机制。在PyTorch中,最常用的注意力模块是`nn.MultiheadAttention`,该模块可以实现多头注意力机制(Multi-Head Attention),这是Transformer模型的基础组件之一。

以下是使用`nn.MultiheadAttention`的一个例子:

```python

import torch

import torch.nn.functional as F

attn = nn.MultiheadAttention(embed_dim=256, num_heads=4)

src = torch.rand(10, 32, 256) # 示例输入序列,10个序列,每个序列长度为32,每个向量大小为256

attn_output, attn_output_weights = attn(src, src, src)

```

在这个例子中,我们创建了一个多头注意力模块`attn`,并用随机生成的数据测试了它。`src`是一个形状为`(10, 32, 256)`的张量,代表10个序列,每个序列有32个元素,每个元素有256个特征。`attn_output`是经过多头注意力处理后的序列,而`attn_output_weights`是注意力权重。

## 2.3 注意力机制的调试和优化

### 注意力模型的常见问题及解决策略

在实现注意力模型时,开发者可能会遇到各种问题。例如,注意力权重可能不均衡,导致模型过分依赖某些部分而忽视其它部分;或者模型可能在训练过程中变得不稳定,出现梯度消失或梯度爆炸的问题。

为了解决这些常见问题,有几个策略可以考虑:

1. 使用正则化技术,如权重衰减,以避免过拟合。

2. 采用梯度裁剪(Gradient Clipping)防止梯度爆炸。

3. 使用不同的学习率调度策略,如学习率衰减或循环学习率。

4. 在多头注意力中实现残差连接(Residual Connections)以稳定训练。

### 注意力模型性能的提升方法

为了提升注意力模型的性能,可以从以下几个方面着手:

1. 设计和实验不同的注意力架构,比如引入更多层次的注意力。

2. 调整超参数,如隐藏层维度、头数等。

3. 引入更复杂的激活函数,比如Swish或GELU。

4. 在模型训练后,进行详细的分析和测试,找出模型的弱点并针对性地改进。

## 下一步

在下一章节中,我们将深入探讨如何使用PyTorch实现注意力机制,并介绍在深度学习任务中的具体实践步骤。我们将通过代码实现来详细展示注意力机制的工作流程,并分析其在文本生成任务中的具体应用。

# 3. 文本生成的注意力模型优化技巧

随着深度学习技术的发展,文本生成任务的复杂性和精确性要求不断提升,对注意力模型的优化成为了提高生成质量的关键环节。本章节将深入探讨数据预处理、模型结构设计、训练策略等方面的优化技巧,以及如何通过这些技巧提升模型的性能和准确性。

## 3.1 数据预处理和特征提取

在深度学习模型中,数据预处理和特征提取是模型训练前的基础工作,对模型性能有着至关重要的影响。注意力模型同样受益于数据预处理和特征工程的精细化操作。

### 3.1.1 文本数据的清洗和编码

文本数据通常是原始的、非结构化的,包含噪声和不一致性,因此清洗和编码步骤对于提取有用的特征至关重要。

- **文本清洗**:包括去除HTML标签、标点符号、特殊字符、停用词和进行小写转换等,以统一文本格式。

- **文本编码**:将清洗后的文本转化为模型可以处理的数值形式,常用的编码方法有词袋模型、TF-IDF、Word2Vec等。

```python

# Python示例代码:文本预处理与编码

import nltk

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例文本

documents = ['The quick brown fox jumps over the lazy dog.',

'Never jump over the lazy dog quickly.']

# 文本清洗函数

def clean_text(text):

tokens = nltk.word_tokenize(text)

return [word.lower() for word in tokens if word.isalpha()]

```

0

0