【itertools与并发编程】:简化线程与进程间通信的黄金法则

发布时间: 2024-10-08 21:49:37 阅读量: 21 订阅数: 19

# 1. 并发编程与线程、进程间通信概述

在现代软件开发中,并发编程是提高应用性能和响应能力的关键技术之一。为了实现这一目标,开发者需要理解进程与线程这两种不同的执行单位,以及它们之间如何通过进程间通信(IPC)和线程间通信(TPI)进行高效的数据交流。

## 1.1 进程与线程的协作机制

进程是操作系统进行资源分配和调度的基本单位,它包含了代码和内存中的数据,能够独立执行。线程则是进程内的一个执行路径,它共享进程资源,可以并发执行。为了确保数据的一致性和任务的协调,进程和线程之间必须有效地进行通信。

## 1.2 线程间通信的必要性

线程间通信(TPI)通常涉及到线程同步和数据共享。同步机制(如锁、事件、信号量等)保证了多线程环境下的数据安全,而共享变量、队列、管道等是实现数据交流的常用方法。

## 1.3 进程间通信的重要性

进程间通信(IPC)解决了进程之间资源共享的问题。常见的IPC技术包括管道、消息队列、共享内存等。这些技术在保证数据安全的同时,允许不同进程访问和操作共享资源。

在下一章节中,我们将详细介绍itertools模块的基础知识及其在并发编程中的潜在应用。

# 2. itertools模块的基本原理与应用

## 2.1 itertools模块介绍

### 2.1.1 itertools的历史与设计哲学

itertools模块是Python标准库的一部分,其历史悠久,最早可以追溯到Python 2.3版本。这个模块的设计哲学是提供了一系列用于创建迭代器的工具,这些工具可以组合、扩展、筛选和操作数据流。

由于迭代器提供了一种惰性求值(lazy evaluation)的方式来处理数据,它可以有效地处理无限数据流,而无需在内存中存储整个数据集。itertools的设计让人们可以利用这种惰性求值的特性来构建高效且可读性高的代码。

### 2.1.2 itertools的核心功能与优势

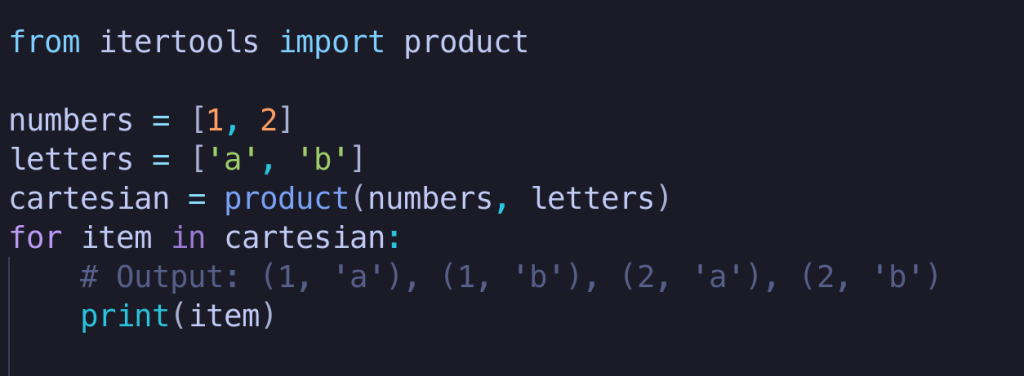

itertools的核心功能包括生成器(generators)、无限迭代器(infinite iterators)、迭代器组合器(iterators combinator)等。它允许开发者用很少的代码行创建复杂的迭代器逻辑。

itertools的优势在于它能够提供内存高效的解决方案,特别是在处理大量数据时。通过惰性求值,itertools不会一次性加载所有数据,而是按需生成,从而降低了内存使用。此外,itertools中的许多工具都是高度优化过的,因此在执行效率方面往往优于自定义的迭代器解决方案。

## 2.2 itertools的生成器工具

### 2.2.1 创建自定义生成器

自定义生成器是itertools的核心部分之一。通过创建自定义生成器,可以生成符合特定需求的数据序列。以下是一个创建自定义生成器的例子:

```python

import itertools

def my_custom_generator(max_value):

n = 0

while n < max_value:

yield n

n += 1

for value in my_custom_generator(5):

print(value)

```

这段代码定义了一个简单的生成器函数`my_custom_generator`,它按顺序产生小于`max_value`的整数。使用`yield`关键字,使得函数在每次调用时返回一个值,直到达到`max_value`。

### 2.2.2 利用itertools进行高效迭代

itertools模块提供的迭代器工具非常丰富,例如`count`, `cycle`, `repeat`等,它们可以用于创建迭代器,使开发者能够以一种高效的方式对数据进行迭代。

```python

import itertools

# 创建一个无限的迭代器,从1开始计数

counter = itertools.count(start=1)

# 取前10个元素

first_10 = itertools.islice(counter, 10)

print(list(first_10))

```

在上面的代码中,`count`函数创建了一个从1开始的无限迭代器。通过`islice`函数,我们可以从这个无限迭代器中取出前10个元素。`islice`是惰性求值的,所以它不会产生整个序列,而只会在迭代到需要的时候才计算出一个元素。

## 2.3 itertools与数据流处理

### 2.3.1 数据流处理的概念

数据流处理是指以连续的数据流作为输入和输出,并进行实时处理的一种计算模型。数据流处理非常适合于实时分析,事件驱动的系统以及需要高度并行化的场景。

数据流处理的一个关键特性是它的数据通常是无限的,例如实时采集的监控数据、日志流、传感器数据等,这些数据流要求系统能够持续地、实时地处理数据,而不是一次性地读取整个数据集。

### 2.3.2 itertools在数据流处理中的应用实例

itertools的工具在处理数据流方面表现卓越,尤其是在创建和操作数据流的场景中。

```python

import itertools

# 模拟实时数据流

def data_stream():

while True:

yield "data_event"

# 创建一个无限的数据流迭代器

stream = data_stream()

# 使用itertools.takewhile()来处理数据流,只处理5个数据事件

for i, data in enumerate(itertools.takewhile(lambda x: i < 5, stream)):

print(f"Processing event {data} - {i}")

```

在上述代码中,`data_stream()`函数是一个无限的数据流生成器,它模拟了一个实时数据流。`itertools.takewhile()`函数用于在处理数据时,只要满足条件(此处是处理的事件数小于5)就会从数据流中取数据进行处理。一旦处理的数据事件数量达到5个,迭代器就会停止。

通过利用itertools的这些工具,开发者能够构建出既优雅又高效的代码来处理实时数据流。这也展示了itertools在处理无限数据集时的能力,其作用不仅限于有限的数据集。

# 3. 并发编程的理论基础

并发编程是现代软件开发中不可或缺的一部分,尤其是在多核处理器日益普及的今天,有效地利用并发可以极大地提升应用程序的性能和响应速度。在深入了解并发编程的应用之前,我们需要先掌握其理论基础。

## 3.1 进程与线程的概念

### 3.1.1 进程与线程的定义与区别

在操作系统中,进程是应用程序的运行实例,它包含了一段程序代码及其运行时所需的资源。进程可以看作是操作系统分配资源的基本单位。每一个进程都有自己的地址空间、系统资源、线程集合以及安全上下文。它是程序执行的载体,可以加载代码、处理数据并与其他进程通信。

线程则位于进程内部,是进程中的一个执行路径,它是操作系统能够进行运算调度的最小单位。一个进程可以包含多个线程,这些线程共享进程的资源,如内存空间、文件句柄等。多线程允许同时进行多个任务,而多个进程间则需要通过进程间通信(IPC)机制才能交换数据。

简单来说,进程是资源分配的单位,而线程是执行的单位。进程间的资源隔离性更高,线程间则由于共享资源而需要更精细的同步和通信机制。

### 3.1.2 进程间通信IPC和线程间通信TPI的概念

由于进程拥有独立的地址空间,因此进程间的数据交换不像线程间那样直接,需要特殊的通信机制。进程间通信(IPC)是指两个或多个进程间传递数据或信号的通信方式。常见的IPC机制有管道(Pipes)、消息队列、共享内存、信号量、套接字(Sockets)等。

线程间通信(TPI)也称为线程同步,是指线程之间为了协调执行顺序,避免竞态条件、数据不一致等问题而进行的信息交换。线程同步的机制包括互斥锁(Mutexes)、读写锁(Read-Write Locks)、条件变量(Condition Variables)、信号量(Semaphores)等。

## 3.2 并发模型与同步机制

### 3.2.1 常见的并发模型

并发模型描述了如何构建并发程序的框架结构,是解决并发问题的基础。以下是几种常见的并发模型:

1. **多线程模型**:基于线程的并发执行,通常由编程语言或运行时环境提供对线程创建和管理的直接支持。

2. **事件驱动模型**:在这种模型下,程序的执行基于事件的发生,每个事件都关联着相应的回调函数。Node.js就是一个典型的事件驱动模型的例子。

3. **Actor模型**:Actor是一个并发模型中的基

0

0