【PCA降维技巧】主成分分析在简化数据结构中的应用:专家指南

发布时间: 2024-11-29 03:18:25 阅读量: 12 订阅数: 11

参考资源链接:[《机器学习(周志华)》学习笔记.pdf](https://wenku.csdn.net/doc/6412b753be7fbd1778d49e56?spm=1055.2635.3001.10343)

# 1. 主成分分析(PCA)基础概念

主成分分析(PCA)是数据科学中的一个重要工具,尤其在高维数据的降维处理领域具有重要应用。PCA的核心思想是通过正交变换将可能相关的变量转化为一组线性不相关的变量,这些新变量称为主成分。它不仅可以简化数据集,还能尽可能地保留原始数据的大部分信息。PCA的应用领域包括但不限于图像处理、生物信息学、金融分析以及市场研究等。在本章中,我们将探索PCA的定义、它的工作原理以及基本术语,为读者搭建起PCA初步理解的基础框架。

# 2. PCA的数学原理和理论

在深入探讨主成分分析(PCA)的实际应用和算法实现之前,本章节将为你揭开PCA背后的数学原理。理解这些理论基础,是掌握PCA工具并将其应用于实际问题解决的关键。我们将从数据的统计特性开始,逐步探讨主成分提取的数学模型,最终将方差最大化与PCA结合起来,形成完整的理论框架。

## 2.1 数据的统计特性

在处理实际数据集时,了解数据的基本统计特性是至关重要的。这有助于我们理解数据的分布情况、数据间的关系以及数据的中心位置和散布情况。 PCA是一种基于数据统计特性的降维技术,因此,深入研究数据的统计特性对于正确实现和应用PCA非常重要。

### 2.1.1 均值、方差和协方差

- **均值**:表示数据集中的中心位置,对于理解数据的中心趋势至关重要。

- **方差**:度量数据点与均值的偏离程度,反映了数据的离散程度。

- **协方差**:衡量两个变量之间的线性相关性。如果两个变量是正相关,那么它们的协方差是正的;如果是负相关,则是负的。

具体来说,如果我们有一个数据集X包含n个观测值,每个观测值有p个变量,那么均值向量(μ)和协方差矩阵(Σ)可以定义如下:

```mathematica

μ = (μ1, μ2, ..., μp)

Σ = Cov(X) = E[(X - μ)(X - μ)^T]

```

其中`E`代表期望值,`X`是一个p维随机变量,`T`表示矩阵的转置。

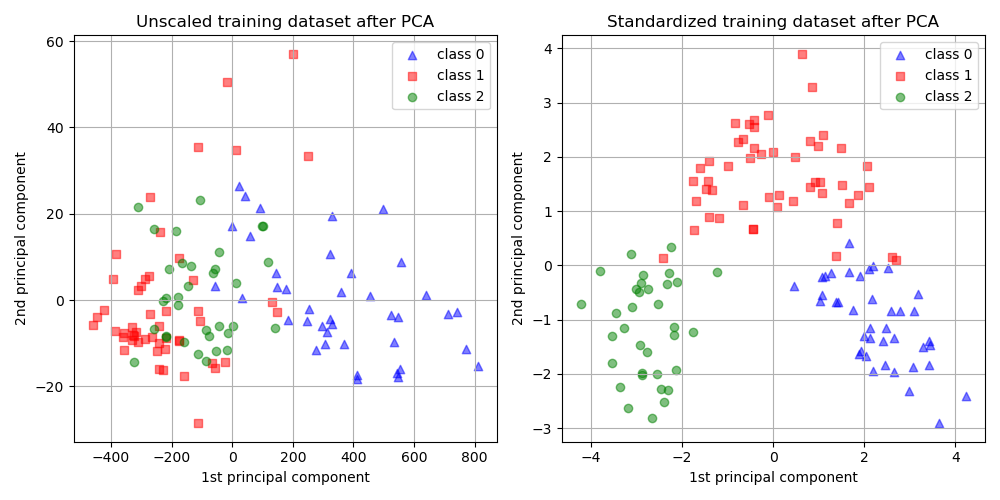

### 2.1.2 数据的标准化处理

为了使得PCA的结果更加可靠,需要对原始数据进行标准化处理。标准化处理主要是将数据转换为具有0均值和单位方差的形式。这样可以消除不同量纲的影响,并使得所有的特征具有同等的权重。

数据标准化处理的公式如下:

```mathematica

X' = (X - μ) / σ

```

其中`X'`是标准化后的数据,`μ`是原始数据的均值,`σ`是原始数据的标准差。

## 2.2 主成分提取的数学模型

主成分分析的核心思想是通过正交变换将原始数据转换到新的坐标系统中,使得数据的最大方差在第一个坐标(第一主成分)上,第二大方差在第二个坐标(第二主成分)上,依此类推。

### 2.2.1 特征值和特征向量

特征值和特征向量是PCA中的核心概念。在数据的协方差矩阵上应用特征值分解可以找到数据的主要成分。对于协方差矩阵Σ,若存在非零向量v和标量λ,使得:

```mathematica

Σv = λv

```

则称v为Σ的特征向量,λ为对应v的特征值。

### 2.2.2 降维的几何解释

几何上,PCA的降维过程可以看作是将原始数据点在高维空间中通过一个正交变换投影到一个低维子空间上。在这个过程中,我们希望保留最大的方差,即尽可能保持原始数据点的分布结构。

## 2.3 方差最大化与PCA

方差最大化是PCA的灵魂,它直接关联到主成分的提取。PCA的目标是在减小数据维度的同时,尽可能保留原始数据集的信息,而信息量主要由数据的方差来衡量。

### 2.3.1 方差在PCA中的作用

在PCA中,每个主成分都对应一个特征值,这个特征值的大小直接反映了该主成分所代表数据方差的大小。因此,通过选择那些具有最大特征值的主成分,PCA能够实现方差的最大化。

### 2.3.2 保留重要信息的策略

在实际应用中,我们常常面对着要选择多少个主成分的决策。太多的成分可能会导致模型复杂化,而太少则可能导致信息损失。一个常用的策略是,选择那些累计贡献率达到一定阈值(如85%或90%)的主成分。

通过保留具有最大特征值的前k个主成分,可以使得数据降维后的信息损失最小化。这里涉及到一个关键的概念——累计方差贡献率,它通过下面的公式来计算:

```mathematica

累计方差贡献率 = (Σ前k个特征值) / (Σ所有特征值)

```

接下来,在第三章中,我们将深入探讨PCA的算法实现和步骤,带你一步步理解并掌握如何通过编程实现PCA,并通过案例分析来加深理解。

# 3. PCA的算法实现和步骤

## 3.1 线性代数方法

在实现PCA算法时,线性代数方法是我们的核心工具。通过矩阵操作,我们能够高效地处理数据并提取主成分。

### 3.1.1 使用矩阵分解技巧

矩阵分解是线性代数中一种将矩阵分解成几个更小或更简单矩阵的方法。PCA的实现常常涉及到奇异值分解(SVD)和特征值分解(EVD)。

SVD允许我们将任意矩阵 \(A\) 分解为:

\[ A = U \Sigma V^T \]

其中,\(U\) 和 \(V\) 是正交矩阵,\(\Sigma\) 是一个对角矩阵。

在PCA中,通常我们会对数据矩阵 \(X\) 进行中心化处理,即减去其均值向量。然后,我们可以用\(X^TX\)(协方差矩阵)或\(XX^T\)(相关矩阵)进行EVD。

伪代码示例:

```python

import numpy as np

def svd_decomposition(X):

U, sigma, Vt = np.linalg.svd(X, full_matrices=False)

return U, np.diag(sigma), Vt.T

# 假设X是一个已经中心化的数据矩阵

U, sigma, V = svd_decomposition(X)

```

### 3.1.2 确定主成分的个数

确定主成分的个数是PCA实施中的关键步骤,这决定了降维的程度和数据重构的质量。

一种常用的方法是累计方差解释率。我们首先计算每个主成分的方差贡献率,然后按照贡献率的大小排序,最后选择累计贡献率达到一定阈值的主成分。

伪代码示例:

```python

# V是对角矩阵,包含了特征值

explained_variance = sigma**2 / np.sum(sigma**2)

cumulative_variance = np.cumsum(explained_variance)

# 设定一个阈值,例如95%

threshold = 0.95

num_components = np.argmax(cumulative_variance >= threshold) + 1

```

## 3.2 PCA的编程实现

### 3.2.1 编程语言选择和库函数

在实现PCA时,选择合适的编程语言和库函数可以大幅简化代码。例如,Python拥有强大的科学计算库NumPy,以及专门针对PCA的库如Scikit-learn。

```python

from sklearn.decomposition import PCA

pca = PCA(n_components=num_components)

X_reduced = pca.fit_transform(X)

```

### 3.2.2 实现PCA算法的伪代码

我们将通过伪代码来展示一个完整的PCA实现流程。此伪代码将结合实际编程语言中可能遇到的步骤。

```python

def pca_implementation(X):

# 数据中心化

X_mean = X.mean(axis=0)

X_centered = X - X_mean

# 执行矩阵分解

U, sigma,

```

0

0