【Linux数据分析优化】:Anaconda在Linux系统中的高级应用技巧

发布时间: 2024-12-10 05:59:00 阅读量: 7 订阅数: 14

在Linux服务器上安装Anaconda使用conda

# 1. Anaconda简介及环境配置

## 1.1 Anaconda概述

Anaconda是一个开源的Python发行版本,它旨在简化包管理和部署。Anaconda的管理器conda,可以快速安装、运行和升级包及其依赖关系。它还包含了一个名为Anaconda Navigator的图形界面,方便用户直观地进行环境配置和包管理。

## 1.2 Anaconda环境配置

### 1.2.1 安装Anaconda

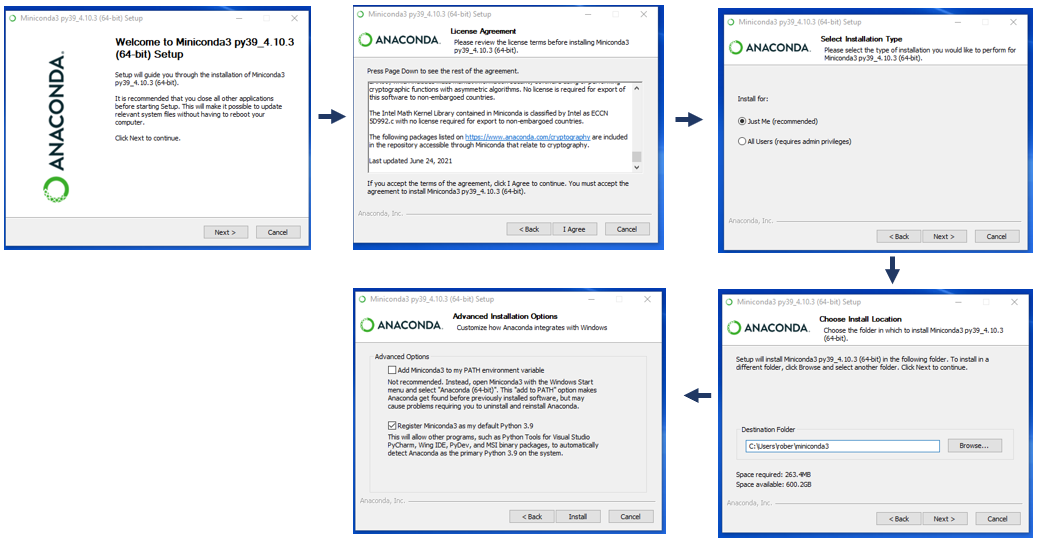

Anaconda的安装过程简单快捷。首先从[官方网站](https://www.anaconda.com/products/individual)下载对应操作系统的安装包,执行安装脚本并遵循提示操作即可。安装完成后,通过在命令行输入`conda --version`来验证安装是否成功。

### 1.2.2 配置Conda环境

环境管理是Anaconda的核心功能之一。通过以下命令,可以创建一个新的环境,安装特定版本的Python,并激活该环境:

```bash

conda create -n myenv python=3.8

conda activate myenv

```

通过环境管理,用户可以在隔离的环境中安装不同版本的库,避免版本冲突,同时也便于对项目依赖进行版本控制。

### 1.2.3 安装第三方包

使用conda命令可以安装各种第三方包:

```bash

conda install numpy pandas

```

这会自动处理好所有依赖,简化了包的安装流程。Anaconda还支持通过pip安装包,对于那些conda仓库中没有的包尤其有用。

本章介绍了Anaconda的基本概念和环境配置方法,为后续章节中进行Linux下的数据分析工作打下了基础。接下来的章节将深入探讨Linux下的数据分析工具和实践。

# 2. Linux数据分析基础

### 2.1 数据分析常用工具介绍

#### 2.1.1 Jupyter Notebook的基本使用

Jupyter Notebook是一个开源Web应用程序,允许你创建和共享包含实时代码、方程式、可视化和解释文本的文档。它支持多种编程语言,但是特别受到Python社区的青睐。对于数据分析师来说,Jupyter Notebook提供了一个交互式的环境,非常适合探索性数据分析和快速原型设计。

在Linux环境下安装Jupyter Notebook非常简单,可以使用Anaconda来快速搭建环境。首先,确保你已经安装了Anaconda,然后打开终端,执行以下命令创建一个新的环境并安装Jupyter:

```bash

conda create -n jupyter_env python=3.8 jupyter

```

激活环境:

```bash

conda activate jupyter_env

```

安装完成后,你可以通过以下命令启动Jupyter Notebook:

```bash

jupyter notebook

```

启动后,系统会自动打开默认的Web浏览器,呈现Jupyter Notebook的主界面。在那里,你可以创建新的笔记本,并开始编写和执行Python代码。

### 2.1.2 Pandas数据处理框架

Pandas是一个开源的Python数据分析库,提供了高性能、易用的数据结构和数据分析工具。它广泛应用于数据清洗、数据分析和数据可视化等任务。

Pandas的基本数据结构是DataFrame,可以看作是一个表格或二维数组,非常适合于处理结构化数据。下面是创建和操作DataFrame的一个简单示例:

```python

import pandas as pd

# 创建一个简单的DataFrame

data = {'Name': ['Alice', 'Bob', 'Claire'],

'Age': [24, 30, 25],

'Gender': ['Female', 'Male', 'Female']}

df = pd.DataFrame(data)

print(df)

```

输出结果将是:

```

Name Age Gender

0 Alice 24 Female

1 Bob 30 Male

2 Claire 25 Female

```

Pandas还提供了数据的导入和导出功能,支持多种文件格式,如CSV、Excel、JSON等。下面是一个读取CSV文件并进行数据处理的例子:

```python

# 读取CSV文件

df = pd.read_csv('data.csv')

# 数据清洗:去除空值

df.dropna(inplace=True)

# 数据预处理:添加新列

df['New Column'] = df['Existing Column'] * 10

# 数据分析:分组并计算平均值

grouped = df.groupby('Category').mean()

# 数据导出到新的CSV文件

grouped.to_csv('grouped_data.csv')

```

### 2.2 Linux系统中数据处理流程

#### 2.2.1 数据的导入与导出

在Linux系统中,数据的导入和导出是数据分析流程的第一步。Pandas提供了非常便捷的方法来实现这一过程。以下是一个将数据从CSV文件导入到DataFrame,并将处理后的数据导出到新的CSV文件的示例:

```python

# 导入数据

df = pd.read_csv('/path/to/input/data.csv')

# 数据处理代码...

# 导出数据

df.to_csv('/path/to/output/data.csv', index=False)

```

#### 2.2.2 数据清洗和预处理技巧

数据清洗和预处理是数据分析中非常重要的步骤。它包括去除重复数据、处理缺失值、异常值检测和纠正等。下面是一个数据清洗和预处理的示例:

```python

# 去除重复数据

df.drop_duplicates(inplace=True)

# 处理缺失值,这里简单地用平均值填充

df.fillna(df.mean(), inplace=True)

# 异常值处理,假设'Age'列中大于60的值为异常

df['Age'] = df['Age'].apply(lambda x: x if x <= 60 else np.nan)

```

#### 2.2.3 数据分析和可视化实践

数据可视化能够帮助我们更直观地理解数据。Pandas与Matplotlib、Seaborn等可视化库整合良好,可以轻松创建图表。下面是一个简单的例子,展示如何使用Pandas和Matplotlib绘制一个散点图:

```python

import matplotlib.pyplot as plt

# 假设我们有一个DataFrame 'df',包含'x'和'y'两列数据

df.plot(kind='scatter', x='x', y='y')

plt.show()

```

### 2.3 性能监控与系统资源优化

#### 2.3.1 系统资源监控工具

在Linux系统中,我们可以使用多种工具进行资源监控。例如,`top`、`htop`、`vmstat`、`iostat`等。这些工具可以帮助我们了解CPU、内存、磁盘I/O和网络I/O的使用情况。下面是一个使用`top`命令查看系统资源使用情况的例子:

```bash

top

```

该命令将提供一个实时更新的列表,其中列出了当前系统中资源使用率最高的

0

0