PyTorch调试秘籍:自定义模块高级技巧与问题排查(权威指南)

发布时间: 2024-12-11 18:14:49 阅读量: 8 订阅数: 10

自定义力量:在PyTorch中构建自定义层与模块的艺术

# 1. PyTorch自定义模块基础

## 1.1 概述PyTorch自定义模块

在构建深度学习模型时,自定义模块是创建复杂和特定任务网络架构的核心。PyTorch提供了强大的模块化工具,使得开发者可以轻松地设计自定义的神经网络层和完整模型。本章旨在引导读者理解PyTorch自定义模块的基本概念和实现方式,为后续深入学习打下坚实的基础。

## 1.2 创建第一个自定义模块

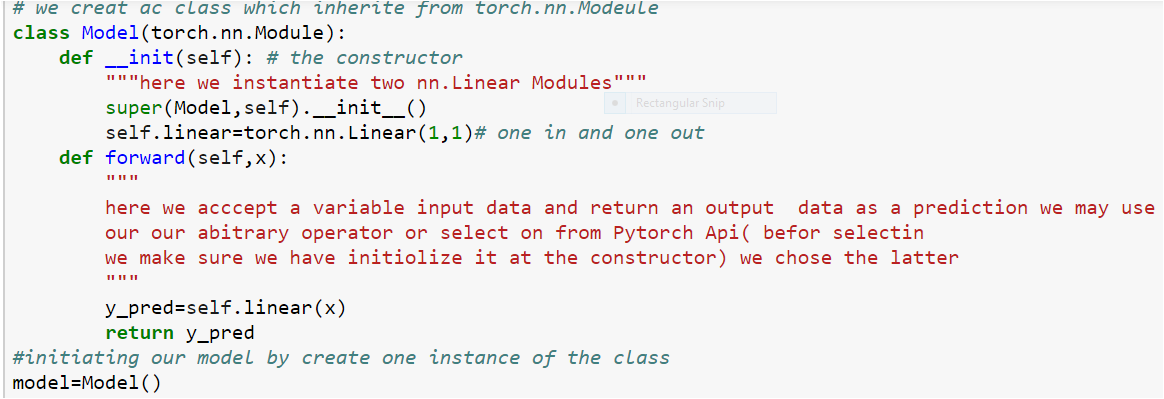

创建一个简单的自定义模块是学习过程中的重要一步。下面的代码展示了如何定义一个简单的线性自定义模块类,此类继承自`torch.nn.Module`,重写`__init__`和`forward`方法。

```python

import torch

import torch.nn as nn

class SimpleModule(nn.Module):

def __init__(self, input_size, output_size):

super(SimpleModule, self).__init__()

self.layer = nn.Linear(input_size, output_size)

def forward(self, x):

return self.layer(x)

# 实例化模块

input_size = 10

output_size = 5

model = SimpleModule(input_size, output_size)

print(model)

```

通过上述代码,我们可以看到自定义模块的基本结构和继承关系。自定义模块首先需要定义其参数(如输入输出大小),并在初始化方法中设置。之后,在`forward`方法中定义数据流通过模块的方式。这一节的内容是后续章节的基石,希望读者能仔细体会自定义模块的创建过程。

# 2. 深入理解PyTorch自定义模块

## 2.1 自定义模块的工作原理

### 2.1.1 模块化编程的概念

模块化编程是一种将程序拆分为独立的、可替换的模块或组件的编程范式。在这样的体系结构中,每个模块都有一个特定的功能,可以独立开发、测试和维护。模块化编程促进了代码的可读性、可复用性和可维护性。

在PyTorch中,模块化编程是构建深度学习模型的基础。通过定义自定义模块,开发者可以将复杂的网络结构分解为简单的组件,使得代码更加模块化,便于管理和优化。模块化的网络组件可以被重复使用,大大提高了开发效率和代码的稳定性。

### 2.1.2 PyTorch中的模块和类

在PyTorch中,`torch.nn.Module`类是构建所有神经网络模块的基础。它提供了一个框架,使得开发者可以定义自己的网络层、网络结构和其他组件。通过继承`torch.nn.Module`类,自定义模块可以轻松地组合并集成进现有的PyTorch框架中。

当定义一个自定义模块时,需要实现两个主要方法:`__init__()`和`forward()`。`__init__()`方法用于初始化模块的层和其他组件,而`forward()`方法则定义了数据通过模块时的前向传播行为。

下面是一个简单的自定义模块示例代码:

```python

import torch

import torch.nn as nn

class MyModule(nn.Module):

def __init__(self):

super(MyModule, self).__init__()

# 初始化模块的层

self.layer = nn.Linear(10, 1)

def forward(self, x):

# 定义前向传播行为

return self.layer(x)

# 创建模块实例并使用

my_instance = MyModule()

output = my_instance(torch.randn(1, 10))

```

在这段代码中,我们定义了一个名为`MyModule`的类,它继承自`nn.Module`。在`__init__()`方法中,我们创建了一个线性层`self.layer`,并在`forward()`方法中定义了如何通过这个线性层传递输入数据`x`。之后,我们实例化了这个模块,并使用了随机数据来测试它的前向传播行为。

## 2.2 构建复杂的自定义模块

### 2.2.1 组合内置模块的方法

构建复杂的神经网络结构通常需要将多种内置模块组合起来。为了实现这一点,可以在自定义模块的`__init__()`方法中实例化这些内置模块,并在`forward()`方法中按照前向传播的顺序将它们串联起来。

例如,创建一个简单的神经网络,该网络包含一个线性层和一个激活函数层:

```python

class ComplexModule(nn.Module):

def __init__(self):

super(ComplexModule, self).__init__()

# 实例化内置模块

self.linear = nn.Linear(10, 20)

self.relu = nn.ReLU()

def forward(self, x):

# 组合内置模块进行前向传播

x = self.linear(x)

x = self.relu(x)

return x

```

在这个例子中,`ComplexModule`首先在`__init__()`方法中初始化了一个线性层和ReLU激活函数。然后在`forward()`方法中,先通过线性层传递输入`x`,再应用ReLU函数,最后返回输出。

### 2.2.2 管理模块参数的技巧

在自定义模块中,正确管理和使用参数是构建深度学习模型时的关键部分。PyTorch提供了`torch.nn.Parameter`类,用于定义模型参数,它们可以自动被优化器处理。

当创建参数时,可以通过`Parameter`来明确指定,或者简单地在模块内声明一个`nn.Module`子类的实例。后一种方法会自动将实例注册为模块的参数,从而在优化时被更新。

下面的代码展示了如何在自定义模块中管理参数:

```python

class ParameterizedModule(nn.Module):

def __init__(self):

super(ParameterizedModule, self).__init__()

# 直接声明参数

self.weight = nn.Parameter(torch.randn(20, 10))

self.bias = nn.Parameter(torch.zeros(20))

def forward(self, x):

# 使用参数

return torch.matmul(x, self.weight.t()) + self.bias

```

在这个例子中,`ParameterizedModule`定义了两个参数:`weight`和`bias`。它们是通过`nn.Parameter`声明的,并在`forward()`方法中被使用。

### 2.2.3 状态保存与恢复的最佳实践

在深度学习训练过程中,经常需要保存模型的状态,以便之后可以恢复继续训练或用于模型部署。PyTorch提供了`torch.save`和`torch.load`用于序列化和反序列化模型的参数和状态。

最佳实践是保存整个模型的字典,包括模型的结构和参数状态。以下是如何保存和加载模型状态的示例:

```python

# 保存模型状态

torch.save(my_instance.state_dict(), 'model.pth')

# 加载模型状态

loaded_model = MyModule()

loaded_model.load_state_dict(torch.load('model.pth'))

```

在这个例子中,使用`state_dict()`方法获取模块的参数字典,并保存到磁盘上的`model.pth`文件中。加载状态时,创建一个新的模块实例,并使用`load_state_dict()`方法将之前保存的参数字典加载到新模块中,恢复模型的状态。

## 2.3 调试自定义模块的策略

### 2.3.1 理解调试流程与工具

调试是任何软件开发过程中的一个重要步骤,特别是在构建深度学习模型时,由于模型的复杂性和数据的不确定性,调试尤为关键。PyTorch提供了一系列工具和方法,帮助开发者理解和调试模型的行为。

在PyTorch中,可以使用`pdb`模块进行交互式调试。此外,还可以利用PyTorch的日志系统来打印中间层的输出,以便于观察数据流和捕捉错误。

### 2.3.2 错误信息的解读与应对

错误信息是调试过程中的宝贵资源。在PyTorch中,当模型的前向传播或反向传播出现问题时,会抛出错误信息。理解这些错误信息,并结合模型的结构和数据来定位问题所在。

例如,维度不匹配的错误信息会提示开发者检查输入张量和参数

0

0