PyCharm中的终极NumPy优化指南:数组操作性能提升的不传之秘

发布时间: 2024-12-12 04:33:29 阅读量: 11 订阅数: 2

PyCharm插件安装指南:提升开发效率的秘诀

# 1. NumPy数组操作概述

## 1.1 NumPy数组操作的重要性

在Python的科学计算领域,NumPy库是数据分析和处理的基础。NumPy的核心是N维数组对象(ndarray),它提供了一种高级的矩阵处理能力,使得在进行数据运算时更加高效、简洁。无论是在数据预处理、机器学习、还是深度学习中,对数组的操作无处不在。掌握NumPy数组操作,不仅能够提升数据处理的速度,而且是深入理解后续章节中高级技术的前提。

## 1.2 NumPy数组操作的初步认识

NumPy数组是由相同数据类型的元素构成的多维容器,它支持复杂的数学运算,并且能与多个库无缝对接,如Pandas、Matplotlib等。NumPy的操作通常比Python原生的数据结构如list要快得多,尤其是在执行向量和矩阵运算时。例如,简单的加法运算,使用NumPy比使用list循环计算要高效得多。

```python

import numpy as np

# 创建一个NumPy数组

a = np.array([1, 2, 3, 4, 5])

# 创建另一个NumPy数组

b = np.array([10, 20, 30, 40, 50])

# 使用NumPy进行数组加法

c = a + b

```

## 1.3 从列表到NumPy数组的转换

将Python的list转换成NumPy数组是进行高性能计算的第一步。在NumPy中,可以使用`numpy.array()`函数将list转换成数组。这种转换不仅可以利用NumPy的高效算法,还可以进一步运用其丰富的操作函数库。

```python

# 将Python的list转换为NumPy数组

Python_list = [1, 2, 3, 4, 5]

numpy_array = np.array(Python_list)

```

理解从list到NumPy数组的转换,是学习NumPy数组操作的基石,它为掌握接下来的高级操作打下坚实的基础。

# 2. 理论基础与性能分析

### 2.1 NumPy的内部结构

#### 2.1.1 数据类型的内部表示

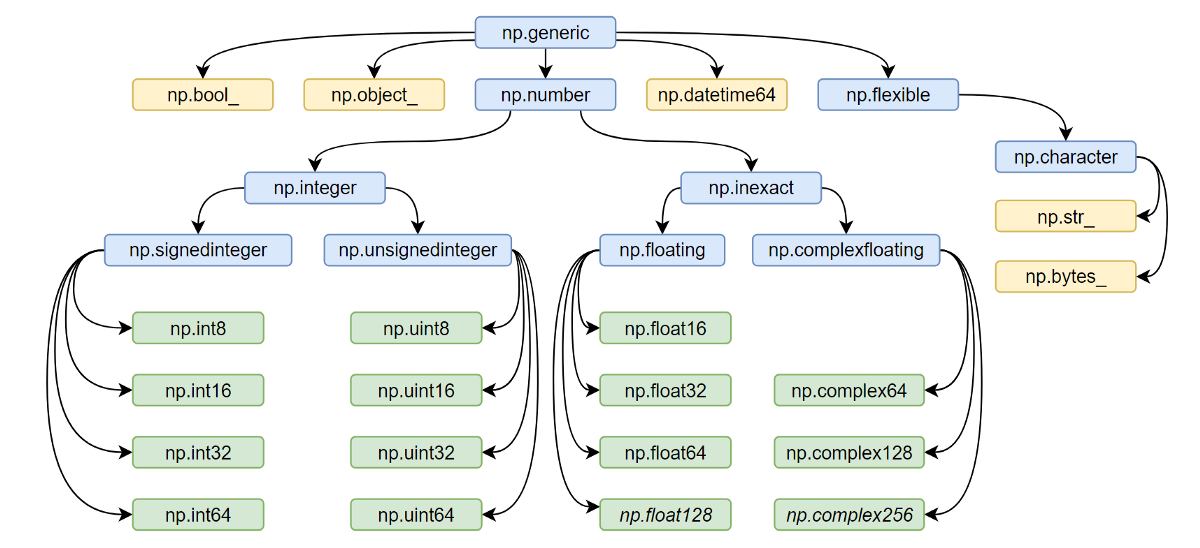

NumPy 数组是同质的,这意味着数组中的所有数据类型都是相同的。这种设计允许 NumPy 在内存中紧凑地存储数据,并且对数据进行高效的数学运算。数据类型在 NumPy 中通过 dtype 对象表示,它不仅定义了数据的大小,还定义了数据的字节布局和取值范围。

```python

import numpy as np

# 创建一个具有特定数据类型的数组

a = np.array([1, 2, 3], dtype=np.int32)

print(a.dtype) # 输出数据类型

```

在这个例子中,我们创建了一个整型数组,并且通过 `dtype` 属性查看了数组中元素的数据类型。NumPy 预定义了大量的数据类型,包括标准的整型、浮点型、复数、字符串等。

#### 2.1.2 数组存储的内存布局

NumPy 数组在内存中的存储顺序分为两种:C顺序和 Fortran 顺序。在 C顺序(默认)中,多维数组是按行存储的,这使得快速访问连续元素变得容易;而在 Fortran 顺序中,多维数组是按列存储的,这在某些情况下能够提供更好的性能。

```python

# 创建一个数组,同时指定内存布局

b = np.array([[1, 2], [3, 4]], order='F')

```

在上面的代码中,通过 `order='F'` 参数指定了数组 `b` 使用 Fortran 顺序存储。理解这两种内存布局对于编写高效的 NumPy 代码至关重要,尤其是当你需要对大型数组进行计算密集型任务时。

### 2.2 性能评估的科学方法

#### 2.2.1 基准测试的原理与实践

基准测试是衡量代码性能的一种方法。在 NumPy 中,我们通常关注数组操作的执行时间。Python 提供了 `timeit` 模块,可以帮助我们进行简单的性能测试。更高级的性能分析通常使用 IPython 的 `%%timeit` 魔法命令。

```python

# 使用 %%timeit 进行简单的性能测试

%timeit np.arange(10000).sum()

```

`%%timeit` 魔法命令可以多次执行代码块并计算平均执行时间。这是快速评估 NumPy 操作性能的有效手段。理解如何正确使用基准测试工具对于编写高性能代码至关重要。

#### 2.2.2 分析工具的使用和解读

除了基准测试,我们还需要对代码性能进行深入分析。Python 的 `cProfile` 模块可以用来分析整个脚本或函数的性能,它会报告每个函数调用的时间和次数。使用 `line_profiler` 可以得到更细致的性能分析结果,比如每一行代码的执行时间。

```python

# 使用 cProfile 进行性能分析

import cProfile

def heavy_function():

return sum(np.arange(10000))

cProfile.run('heavy_function()')

```

这段代码中,我们对一个执行耗时的函数 `heavy_function` 进行了性能分析。结果会提供每个函数的调用次数、总时间等信息。解读这些信息可以帮助我们识别出程序中的性能瓶颈。

### 2.3 优化理论基础

#### 2.3.1 算法复杂度分析

算法复杂度是指算法执行时间或空间随着输入数据的规模增长的趋势。在 NumPy 中,算法复杂度通常以大O表示法展示,比如 O(n)、O(n^2) 等。理解算法复杂度有助于我们预估代码在面对大数据集时的性能表现。

```python

# 示例:线性搜索与二分搜索的时间复杂度比较

def linear_search(arr, x):

for i in range(len(arr)):

if arr[i] == x:

return True

return False

def binary_search(arr, x):

# 假设 arr 已经排序

left, right = 0, len(arr) - 1

while left <= right:

mid = (left + right) // 2

if arr[mid] == x:

return True

elif arr[mid] < x:

left = mid + 1

else:

right = mid - 1

return False

```

在这个例子中,`linear_search` 函数的时间复杂度为 O(n),而 `binary_search` 函数的时间复杂度为 O(log n)。当处理大型数据集时,这种差异会导致显著的性能差异。

#### 2.3.2 向量化与并行计算基础

向量化是利用 NumPy 内置的函数来替代 Python 的循环,它可以显著提高性能,因为这些函数是用 C 语言实现的,并且能够更好地利用硬件加速。并行计算则是通过同时使用多个处理器核心来提高性能。

```python

# 使用 NumPy 的向量化操作替代循环

arr = np.array([1, 2, 3, 4])

squared = arr ** 2

```

在这个简单的例子中,我们通过 `**` 操作符对数组中的每个元素进行了平方运算。相比使用循环,向量化操作可以更快地执行,且代码更加简洁。

### 小结

在本章节中,我们讨论了 NumPy 的内部结构和性能评估的方法。通过理解数据类型、内存布局和性能测试工具,我们为编写高效的 NumPy 代码奠定了基础。我们还学习了性能优化的基本理论,包括算法复杂度和向量化技术。所有这些概念和工具将为我们在第三章中探索 NumPy 数组操作的优化实践提供支持。

# 3. NumPy数组操作的优化实践

## 3.1 基础操作的性能调优

### 3.1.1 常规数组操作的优化

在处理大规模数据时,常规的数组操作性能直接影响整体程序的效率。优化数组操作可以基于以下几个方面:

- **避免全复制**:尽量使用视图而不是副本。视图是对原数组的引用,而副本是数据的全复制,视图操作比副本操作节省大量内存和计算时间。

```python

import numpy as np

a = np.arange(1000000)

b = a.view() # 视图

c = a.copy() # 副本

```

- **减少重复计算**:预先计算不变的值,避免在循环中重复计算。

```python

def without_precomputation():

result = np.zeros((1000, 1000))

for i in range(1000):

for j in range(1000):

result[i, j] = some_function(i, j)

return result

def with_precomputation():

result = np.zeros((1000, 1000))

x, y = np.mgrid[0:1000, 0:1000] # 预先计算网格坐标

for i in range(1000):

for j in range(1000):

result[i, j] = some_function(x[i, j], y[i, j])

return result

```

- **使用向量化操作**:NumPy的内建函数比纯Python循环更高效。

```python

import numpy as np

# 避免以下Python循环

for i in range(a.shape[0]):

a[i] = b[i] + c[i]

# 使用向量化操作

a = b + c

```

### 3.1.2 利用广播机制进行高效计算

NumPy的广播机制能够让我们对不同形状的数组执行算术运算。正确使用广播,可以避免不必要的数据复制,从而提高性能。

```python

import numpy as np

a = np.array([[1, 2, 3], [4, 5, 6]])

b = np.array([1, 2, 3])

# 不使用广播

result = np.empty(a.shape)

for i in range(2):

for j in range(3):

result[i, j] = a[i, j] + b[j]

# 使用广播

result = a + b

```

## 3.2 高级索引与切片技巧

### 3.2.1 索引技巧的性能考量

在NumPy中,索引数组可以用来选取数据子集,但需要注意索引数组的类型和形状,因为它们对性能有直接影响。

```python

import numpy as np

# 使用布尔索引

a = np.random.rand(1000000)

mask = a > 0.5

filtered_a = a[mask]

# 使用整数索引

indices = np.argsort(a)[-100:] # 获取a中最大的100个值的索引

top_100_a = a[indices]

```

### 3.2.2 切片操作的优化策略

切片操作是NumPy数组中常用的一种高效操作,但如果操作不当,可能会导致效率下降。

```python

import numpy as np

a = np.arange(1000000)

# 不要对非常大的数组使用步长非常小的切片

# 这样会创建数组的大量副本

small_step_slice = a[::10]

# 使用布尔索引或者条件表达式直接生成新数组

# 而不是使用复杂的切片

filtered_a = a[a > 0.5]

```

## 3.3 函数和通用函数(UFUNCS)的高效应用

### 3.3.1 选择合适的通用函数

通用函数(Universal Functions,简称ufuncs)是NumPy中对数组进行逐元素操作的函数。根据操作类型和数据类型,选择最合适的通用函数至关重要。

```python

import numpy as np

# 使用通用函数进行数组操作

a = np.arange(1000000, dtype=np.float64)

b = np.arange(1000000, dtype=np.float64)

# 使用加法通用函数

c = np.add(a, b)

# 也可以直接使用加号操作

c = a + b

```

### 3.3.2 自定义通用函数来提升性能

如果内置的通用函数不能满足特定需求,可以利用`numpy.frompyfunc()`或者`numpy.vectorize()`创建自定义的通用函数。

```python

import numpy as np

# 自定义通用函数,用于计算每个元素的平方

def square(x):

return x * x

# 使用frompyfunc创建通用函数

ufunc = np.frompyfunc(square, 1, 1)

# 对数组中的每个元素执行平方操作

a = np.array([1, 2, 3, 4])

result = ufunc(a)

```

自定义通用函数虽然灵活,但通常比内置通用函数慢,因此仅在没有现成函数可用时使用。

# 4. 进阶技术与案例分析

## 4.1 利用Numexpr提升性能

### 4.1.1 Numexpr模块的工作原理

Numexpr模块是一个专门用于进行高效数值表达式计算的库,它在后台利用多核CPU的能力,将数组运算表达式优化并编译成底层的C代码,从而提高运算速度。Numexpr利用了延迟评估(Lazy evaluation)和内存效率优化来提升性能。延迟评估是指表达式不会立即计算,而是等到真的需要结果时才进行计算。这样做的好处是,对于中间结果不需要额外存储,因为它只存在于计算过程中的临时变量中。

Numexpr还通过一块块地计算数据,而不是一次性将所有数据加载到内存中,来减少内存的使用。这种分块策略对于处理大型数组时尤为重要,它避免了大型数组一次性占用过多内存而导致的性能问题。

### 4.1.2 在实际操作中应用Numexpr

为了更好地理解Numexpr的使用方式,我们可以考虑一个具体的应用案例。假设有大量的数值数据需要进行计算,比如对数组中的每个元素进行一个复杂的数学表达式计算,这在普通的NumPy操作中可能会消耗大量的时间。

以下是一个使用Numexpr进行优化的例子:

```python

import numpy as np

import numexpr as ne

# 创建一个大型的随机数组

a = np.random.rand(1000000)

b = np.random.rand(1000000)

# 使用Numexpr计算 a * b + sin(a)

result = ne.evaluate('a * b + sin(a)')

```

在上述代码中,Numexpr库通过自己的评估器 `evaluate` 方法替代了直接使用NumPy的 `sin` 和乘法操作。Numexpr会分析提供的字符串表达式,并尽可能高效地进行计算。对于复杂表达式,Numexpr能够更加高效地利用CPU的多个核心,并且由于其延迟评估的特性,它能够有效处理大型数据集的计算。

## 4.2 内存管理与缓存优化

### 4.2.1 内存布局的优化技巧

内存布局对于数组操作的性能有着重要影响。NumPy数组的内存布局通常是连续的,这种连续性对于缓存局部性和向量化操作非常有利。内存布局优化的目的在于确保数组操作能够最大限度地利用CPU缓存,从而降低内存访问的延迟。

常见的内存布局优化技巧包括:

- 避免步长(Strides)为非连续值的数组操作。

- 尽量使数组在内存中按列优先(C-order)存储,这对于NumPy的默认行为是天然成立的。

- 在进行复杂的数组操作时,预先分配足够的空间,避免动态增长数组带来的性能损失。

### 4.2.2 缓存友好的编程实践

缓存友好的编程意味着设计算法和数据结构,以便CPU缓存可以最大限度地利用。由于缓存的速度比主内存快得多,能够有效减少数据的加载时间,提高整体的运行效率。

以下是实现缓存友好编程实践的几个关键点:

- 尽量使用局部性原理,即访问当前数据时,也预先加载相邻的数据到缓存中。

- 尽量减少数据的复制,因为每次复制都会增加内存访问的次数。

- 使用循环展开(Loop unrolling)等技术,减少循环次数,从而减少循环控制开销。

## 4.3 并行计算与分布式处理

### 4.3.1 利用多线程和多进程提高性能

多核处理器的普及使得并行计算成为提升性能的一种有效手段。NumPy本身并不直接支持并行计算,但是可以利用Python的多线程或多进程来实现并行计算。

Python的全局解释器锁(GIL)使得多线程并不能充分利用CPU的多核资源。因此,多进程成了并行计算的首选。通过多进程模块(multiprocessing),我们可以在不同的进程间分配任务,达到并行计算的目的。

以下是一个使用多进程提升性能的简单例子:

```python

from multiprocessing import Pool

import numpy as np

def compute(x):

return x*x

def parallel_map(array, func):

pool = Pool(processes=4) # 创建一个包含4个进程的池

result = pool.map(func, array)

return result

# 创建一个大型数组

large_array = np.arange(1000000)

# 应用并行计算

result = parallel_map(large_array, compute)

```

在这个例子中,我们定义了一个`compute`函数,它将数组中的每个元素平方。然后定义了`parallel_map`函数,它接受一个数组和一个函数,并将数组分成几块分别计算。这样,我们利用了四个进程的并行计算能力来提高性能。

### 4.3.2 使用Dask进行分布式处理

Dask是一个灵活的并行计算库,它可以用来处理比内存大的数据集,并且可以轻松地在集群上进行分布式计算。Dask通过提供类似于NumPy和Pandas的接口,使得并行计算变得简单。

Dask通过Dask Array提供了一个类似NumPy的数组接口,但它在幕后将数组操作分解成任务图(Task Graphs),并利用并发来执行。Dask的这种设计使得它可以并行地执行复杂的计算,非常适合于大规模数据处理。

以下是一个使用Dask Array进行并行计算的例子:

```python

import dask.array as da

# 创建一个大型的Dask数组

darr = da.from_array(np.random.rand(10000000), chunks=(100000,))

# 计算数组的平方

result = darr ** 2

# 计算结果,自动并行处理

result_computed = result.compute()

```

在这个例子中,我们首先创建了一个非常大的Dask数组,这个数组是通过将一个非常大的NumPy数组分割成若干块(由`chunks`参数指定)来实现的。之后,我们对这个Dask数组进行平方计算,并调用`compute()`方法来并行执行计算任务。Dask会自动地在可用的计算资源上调度任务,尽可能地利用多核和分布式资源。

通过使用Dask,开发者可以以非常简单的方式实现大规模并行计算,而无需深入理解底层的并发和集群管理技术。

# 5. 工具和技巧的整合应用

在前面的章节中,我们深入了解了NumPy数组操作的基础、性能评估方法、优化理论以及具体的优化实践。本章将重点介绍如何将这些知识整合应用到实际的性能优化过程中。我们会探讨常用的性能分析工具、高级优化案例研究以及如何关注NumPy的未来趋势和社区资源。

## 5.1 常用的性能分析工具

性能优化的第一步是找出瓶颈所在。有许多工具可以帮助我们进行性能分析,从而识别并优化那些影响性能的代码段。

### 5.1.1 cProfile和line_profiler的使用

Python自带的`cProfile`模块是性能分析的得力工具。它能够帮助我们测量代码执行的时间,并提供了一个详细的报告来展示哪些函数调用最耗时。

```python

import cProfile

def example_function():

# 这里是一些耗时的操作

pass

cProfile.run('example_function()')

```

`line_profiler`是另一个强大的工具,它能够提供逐行代码的执行时间。这对于我们优化那些对性能影响较大的函数尤其有用。

安装`line_profiler`后,我们可以通过`kernprof`命令行工具以及装饰器`@profile`来使用它:

```shell

kernprof -l -v script.py

```

在代码中,我们这样做:

```python

from line_profiler import LineProfiler

def some_function():

# 这里是一些耗时的操作

pass

profiler = LineProfiler()

profiler.add_function(some_function)

profiler.enable_by_count()

some_function()

profiler.print_stats()

```

### 5.1.2 通过性能分析指导优化

性能分析的结果需要我们去解读和行动。下面是一些基于性能分析结果的优化建议:

- **热点优化**:关注最耗时的函数或代码块,并优先对其进行优化。

- **算法替换**:如果发现某些操作非常耗时,考虑是否有更快的算法或数据结构可以使用。

- **I/O优化**:如果分析显示大量的时间花在I/O操作上,那么考虑缓存机制或异步I/O可能是值得的。

## 5.2 高级优化案例研究

我们将通过两个案例来说明如何将性能分析和优化技巧结合起来。

### 5.2.1 复杂数组处理的优化实例

假设我们有一个复杂的数组处理操作,例如矩阵运算或者图像处理。我们会首先使用性能分析工具来找到瓶颈。然后,我们可以利用NumPy的广播机制,通用函数(ufuncs),以及可能的并行计算库如`multiprocessing`来优化这个操作。

### 5.2.2 真实世界问题的性能优化流程

在面对真实世界的问题时,性能优化可能需要多个步骤。首先,我们需要理解问题和数据结构,然后根据性能分析的结果,逐步优化代码。这可能包括数据预处理、算法选择、代码重构、多线程或多进程应用,甚至使用像Dask这样的库进行分布式处理。

## 5.3 未来趋势与社区资源

为了持续提升性能优化的能力,我们需要关注NumPy的最新进展和社区资源。

### 5.3.1 关注NumPy的最新进展

NumPy社区非常活跃,不断有新特性被添加,旧特性被改进。我们可以订阅NumPy的邮件列表,关注GitHub上的议题和PRs,以及参加相关的会议和研讨会。

### 5.3.2 有效利用社区资源进行深度优化

NumPy社区提供了大量的资源,包括文档、教程和示例代码。我们可以利用这些资源来学习更高级的技巧,如自定义通用函数,以及参与到库的开发和优化中去。

在这个过程中,我们可以贡献代码、报告问题,甚至成为NumPy核心团队的一部分。通过这些方式,我们可以不断提高自己的技能,并为整个Python科学计算社区做出贡献。

在本章中,我们介绍了性能分析工具的使用,高级优化案例研究,以及如何利用NumPy社区资源进行深度优化。这些知识和技能的整合将帮助IT从业者更有效地进行代码优化,提升应用程序的性能。

0

0