【数据分析师Python工具箱】:Anaconda深度使用技巧曝光

发布时间: 2024-12-07 09:34:44 阅读量: 6 订阅数: 11

Python 数据科学工具 Anaconda 的全面安装与使用指南

# 1. 数据分析师Python工具箱概述

在当今数据驱动的世界中,Python已经成为数据分析师不可或缺的工具。这一章旨在为读者提供一个关于Python在数据分析中所使用的一系列核心工具和库的概览。我们将讨论工具箱中最重要的组件,包括数据操作、分析、可视化,以及在大数据环境中的应用。通过了解这些组件,读者将能够构建起自己的高效数据分析工作流,并为后续章节更深入的学习打下坚实的基础。

## 1.1 数据操作与分析的Python库

Python强大的数据操作和分析能力主要来自于其丰富的第三方库。这些库经过精心设计,能够支持从基本的数据处理到复杂分析的所有需求。以下是一些数据分析中最为重要的库:

- **NumPy**: 提供了高性能的多维数组对象和一系列处理数组的工具。

- **Pandas**: 简化数据的结构化操作,提供数据框(DataFrame)对象,非常适合处理表格数据。

- **Matplotlib** 和 **Seaborn**: 这两个库是数据可视化的利器,支持生成多种静态、动态、交互式的图表。

## 1.2 数据可视化的重要性

数据可视化在数据分析师的工作中占有核心地位。通过可视化,复杂的分析结果可以被直观地展现,决策者也能更快捷地理解数据背后的洞察。Matplotlib和Seaborn等库提供了强大的自定义和交互功能,使得用户可以根据需要创建高度定制化的图表。

## 1.3 大数据环境下的应用

随着数据量的激增,如何在大数据环境下高效地进行数据处理和分析变得越来越重要。Anaconda作为一个完整的工作流程解决方案,提供了许多用于大数据处理的扩展库和工具,如Hadoop、Spark等。在第六章中,我们将深入了解这些集成方案,以及如何在大数据环境中优化性能并解决可能出现的问题。

# 2. Anaconda的安装与环境管理

## 2.1 安装Anaconda

安装Anaconda是开展Python数据分析工作的第一步。Anaconda是一个包含了许多数据科学常用库的Python分发版,它可以帮助我们快速搭建数据分析环境。

### 2.1.1 选择合适的安装版本

安装Anaconda时,首先面临的一个选择是选择合适的版本。Anaconda提供了Python 2.x和Python 3.x两种版本。由于Python 2.x已经在2020年1月1日停止官方支持,因此建议新手直接选择Python 3.x版本进行安装。此外,Anaconda提供了不同操作系统的安装包,例如Windows、macOS和Linux系统。开发者需要根据自己的操作系统和硬件配置选择合适的版本进行下载和安装。

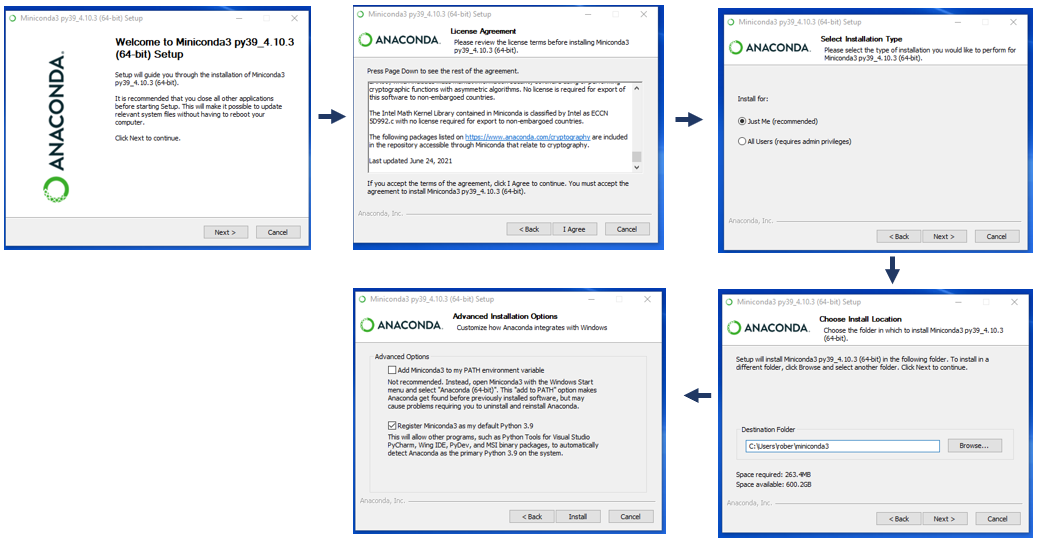

### 2.1.2 安装过程的注意事项

安装过程看似简单,但以下几个注意事项可以帮助避免一些常见的问题:

- 确保你的计算机上安装了最新版本的系统支持软件,如Windows上的.NET Framework,以避免兼容性问题。

- 使用管理员权限运行安装程序,尤其是Windows用户,以便Anaconda能够正确地安装在系统路径中。

- 在安装过程中,可以选择将Anaconda路径添加到系统环境变量中,这样可以方便地在任何目录下使用conda命令。

- 对于有特殊需求的用户,可以选择自定义安装,指定安装路径和额外的包,但默认安装路径通常已经足够使用。

安装Anaconda后,可以通过在终端或命令提示符中输入`conda --version`或`python --version`来检查是否安装成功。

## 2.2 管理Conda环境

安装Anaconda后,管理Conda环境成为日常工作的主要内容。Conda环境允许你在同一台机器上安装和使用不同版本的Python和库,这对于解决包版本冲突非常有用。

### 2.2.1 创建和删除环境

创建一个Conda环境的命令如下:

```shell

conda create --name myenv python=3.8

```

这里`myenv`是环境的名字,`python=3.8`指定了环境使用的Python版本。创建环境后,使用`conda activate myenv`激活环境。

删除一个Conda环境则需要使用:

```shell

conda remove --name myenv --all

```

这将移除名为`myenv`的环境,包括其中的所有包。

### 2.2.2 环境的激活和切换

要切换到一个已存在的环境,只需使用命令:

```shell

conda activate myenv

```

如果想要查看所有可用的环境,可以使用:

```shell

conda info --envs

```

或者

```shell

conda env list

```

这将列出所有Conda环境及其路径。在不同项目之间切换环境时,这一功能非常有用。

## 2.3 包管理与版本控制

在数据分析过程中,安装和管理第三方包是非常重要的。Conda不仅管理Python包,还管理包的依赖关系和环境,确保不同包之间不会发生冲突。

### 2.3.1 安装和更新第三方包

安装第三方包的命令非常简单:

```shell

conda install numpy pandas

```

这条命令会安装`numpy`和`pandas`包及其依赖。如果想要安装特定版本的包,可以指定版本号:

```shell

conda install numpy=1.19.2

```

更新包与安装包的命令类似:

```shell

conda update numpy

```

这条命令会将`numpy`更新到最新版本。Conda允许同时更新多个包:

```shell

conda update numpy pandas

```

### 2.3.2 版本冲突解决策略

版本冲突是数据分析中常见的问题,特别是当多个包依赖于不同版本的同一个包时。Conda提供了版本冲突解决策略,它会尝试解决依赖问题,但仍需谨慎使用。

```shell

conda update --all

```

这个命令会尝试更新环境中所有包到最新版本,但在多依赖的环境中可能会导致某些包不再兼容。如果你确定要更新所有包,可以加上`--force`参数强制更新:

```shell

conda update --all --force

```

请注意,强制更新可能会导致环境中的其他包出现问题。

在使用Conda时,合理地创建和管理不同的环境,安装和更新所需的包,可以大大提高工作效率和项目稳定性。接下来的章节中,我们将深入了解数据分析的核心库,并探索它们的高级用法。

# 3. 数据分析核心库深入

在数据科学领域,高效的数据分析能力往往依赖于对核心库的深入理解和熟练应用。本章我们将深入探讨NumPy、Pandas和Matplotlib与Seaborn库的高级用法,揭示这些库在数据分析过程中的强大能力。

## 3.1 NumPy库的高级用法

NumPy是一个用于科学计算的Python基础库,它提供了高性能的多维数组对象和相关工具。深入掌握NumPy不仅能够提升数据处理速度,还能在数据分析中实现复杂的数据操作。

### 3.1.1 多维数组操作技巧

在处理大规模数据集时,NumPy的多维数组(ndarray)成为了不可或缺的数据结构。了解数组操作技巧能够极大地提高数据处理效率。

```python

import numpy as np

# 创建一个三维数组

a = np.array([[[1, 2], [3, 4]], [[5, 6], [7, 8]]])

# 使用reshape方法改变数组的形状

b = a.reshape((4, 2))

# 使用数组的切片操作

c = b[1:, :] # 选取第二行之后的所有行和所有列

print(c)

```

上述代码展示了如何创建一个多维数组并对其进行重塑和切片操作。NumPy的切片操作非常灵活,可以对数组的任意维度进行操作。在多维数组中,使用切片而非索引能够有效地处理数据子集,这对于数据分析来说是一个重要的技巧。

### 3.1.2 高性能计算的内存管理

NumPy数组是存储在连续内存空间中的,这使得它们在计算时能够获得较高的性能。但这也意味着对数组的某些操作可能会创建数组的副本,进而增加内存消耗。理解并掌握内存管理是提高程序性能的关键。

```python

# 生成一个大型随机数组

large_array = np.random.rand(1000000)

# 使用切片创建视图

small_view = large_array[::10]

# 使用copy创建数组的副本

small_copy = large_array[::10].copy()

print(f"View size: {large_array.nbytes / 1024:.2f} KB")

print(f"Copy size: {small_copy.nbytes / 1024:.2f} KB")

```

通过内存地址分析,我们可以确定`small_view`和`small_copy`在内存中是否占据不同的位置。`small_view`只是一个内存视图,而`small_copy`是数据的完全副本。在进行数据操作时,合理使用视图而非复制数据能够节省大量内存。

## 3.2 Pandas库的数据处理

Pandas是另一个强大的Python库,专门用于数据分析和数据处理。它提供了易于使用的数据结构和数据分析工具。掌握Pandas的高级用法,对于数据清洗、分组、透视表等方面至关重要。

### 3.2.1 数据清洗与准备

数据清洗是数据分析的重要步骤。Pandas通过多种方法简化了这一过程,比如使用`dropna()`去除缺失值,使用`fillna()`填充缺失值等。

```python

import pandas as pd

# 创建一个含有缺失值的DataFrame

df = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, None, 8],

'C': [9, 10, 11, 12]

})

# 去除含有缺失值的行

df_cleaned = df.dropna()

# 填充缺失值

df_filled = df.fillna(0)

print(df_cleaned)

print(df_filled)

```

上述代码展示了如何去除含有缺失值的行和填充缺失值。掌握`dropna()`和`fillna()`方法,能够在数据清洗过程中提高效率。

### 3.2.2 数据分组与透视表

Pandas的数据分组功能允许我们根据某些标准将数据分组,并对每组执行聚合操作。透视表则提供了一种对数据集进行总结和可视化的方式。

```python

# 使用groupby方法对数据进行分组

grouped = df.groupby('A')

# 计算每个分组的平均值

grouped_mean = grouped.mean()

# 创建透视表

pivot_table = df.pivot_table(index='A', columns='B', values='C', aggfunc='mean')

print(grouped_mean)

print(pivot_table)

```

代码中使用`groupby()`方法按照某一列的值进行分组,并计算每组数据的平均值。透视表的创建则使我们能够从多个维度观察数据。这些高级用法为数据分析提供了极大的灵活性。

## 3.3 Matplotlib与Seaborn的可视化技术

可视化是数据分析过程中不可或缺的一环。Matplotlib提供了丰富的绘图功能,而Seaborn基于Matpl

0

0