PyTorch内存管理:自定义模块避免内存泄漏的必学策略

发布时间: 2024-12-11 19:03:07 阅读量: 7 订阅数: 10

pytorch_memlab:在pytorch中分析和检查内存

# 1. PyTorch内存管理基础

内存管理是深度学习框架性能调优的重要方面,尤其对于像PyTorch这样的库,它在数据和模型操作时需要频繁地分配和释放内存。了解PyTorch的内存管理机制可以帮助开发者编写更高效、更稳定的深度学习应用程序。

## 1.1 PyTorch内存管理的基本概念

在PyTorch中,内存管理依赖于其内部的缓存机制和自动化垃圾回收机制。PyTorch使用一个称为`Autograd`的引擎来追踪计算图中的操作,这使得它可以自动计算梯度,并且在适当的时候释放不再使用的中间变量以节省内存。开发者可以使用`torch.no_grad()`来暂时停止梯度计算,减少内存占用。

## 1.2 内存分配与释放

PyTorch采用懒加载(lazy loading)的方式来分配内存,即内存是在实际需要时才分配,这有助于减少不必要的内存占用。当不再需要某个张量时,PyTorch并不会立即释放内存,而是等待Python的垃圾回收器确定该张量不再被使用时,才将其内存回收。开发者可以使用`del`语句手动删除不再需要的张量,从而促进内存的及时释放。

```python

import torch

# 创建一个大张量

x = torch.randn(10000000)

# 删除张量并强制进行垃圾回收

del x

torch.cuda.empty_cache()

# 手动调用垃圾回收器

import gc

gc.collect()

```

这段代码展示了如何创建一个大张量,使用`del`语句删除它,并调用`torch.cuda.empty_cache()`来释放与该张量相关的GPU内存。`gc.collect()`则是用来触发Python的垃圾回收器。

以上内容为第一章的概要,它将为读者建立起对PyTorch内存管理的初步了解,并为后续章节深入探讨内存泄漏、诊断工具和内存管理策略打下基础。

# 2. ```

# 第二章:内存泄漏的成因与影响

内存泄漏是指程序在分配内存后,未能适时释放不再需要的内存,导致随着时间的推移,程序占用的内存不断增加,最终可能导致程序崩溃、系统资源耗尽等问题。内存泄漏的成因多种多样,其影响同样深远。了解内存泄漏的概念和特征,以及在PyTorch中的具体表现,对于维护系统性能和稳定性至关重要。

## 2.1 内存泄漏的概念和特征

### 2.1.1 内存泄漏的定义

内存泄漏是内存管理问题中的一种常见错误,它发生在程序运行期间,当分配的内存未能通过正常的释放流程被回收时。虽然程序可能继续正常工作,但是分配给它的内存区域却逐渐减少,直到无法满足正常运行的要求。

在Python和PyTorch的上下文中,内存泄漏通常与对象的创建和删除有关。当一个对象被创建后,如果没有适当的引用计数管理或者垃圾回收策略,这个对象可能不会从内存中移除,即使它已经不再被任何其他对象引用。

### 2.1.2 内存泄漏的常见迹象

内存泄漏的迹象包括但不限于:

- **程序占用内存随时间增加**:这是最直观的迹象,可以通过任务管理器或使用监控工具(如`top`、`htop`或`nvidia-smi`)观察。

- **性能下降**:随着可用内存减少,程序可能会频繁地触发垃圾回收机制,造成性能下降。

- **程序崩溃或不可预测的行为**:最终,内存泄漏可能耗尽所有可用内存,导致程序意外终止或出现不可预测的行为。

- **日志文件大小迅速增长**:如果泄漏的内存被用于日志记录,文件大小的迅速增长可能是内存泄漏的迹象。

## 2.2 内存泄漏在PyTorch中的表现

### 2.2.1 PyTorch内存分配机制

PyTorch是一种基于Python的深度学习框架,它使用了Python的标准内存管理机制,并且添加了自己特有的内存分配和管理策略。PyTorch使用`torch.Tensor`对象来存储数据,这些对象在内存中是连续分配的。通过引用计数,Python管理这些对象的生命周期。当一个`Tensor`对象不再被引用时,它所占用的内存应该被释放。

然而,在深度学习训练或推理过程中,常常需要执行大量的操作,例如创建临时变量、中间计算结果等。如果这些操作未能得到适当的管理,就会导致内存泄漏。

### 2.2.2 内存泄漏的典型例子

一个典型的内存泄漏例子是在使用PyTorch的`autograd`功能时,循环使用张量(Tensors)但未能释放它们。例如:

```python

import torch

for _ in range(1000000):

a = torch.randn(1000, 1000)

b = torch.randn(1000, 1000)

c = a @ b # @ is matrix multiplication

```

上面的代码段在每次迭代中都会创建两个大型的张量`a`和`b`,以及它们的乘积`c`。因为`a`和`b`在矩阵乘法后被丢弃,但在某些情况下,如果底层的内存分配策略设计不当,它们可能会导致内存泄漏,尤其是当迭代次数非常巨大时。

## 2.3 内存泄漏对性能的影响

### 2.3.1 运行时性能下降

内存泄漏的一个直接后果是程序运行时性能的下降。随着程序运行时间的增加,泄漏的内存会不断积累。尽管现代操作系统和Python都有垃圾回收机制来回收不再使用的内存,但这个过程需要时间,可能会导致程序在执行时产生延迟。特别是在实时应用和大规模数据处理场景中,性能的下降可能是不可接受的。

### 2.3.2 资源浪费和系统的不稳定性

长期运行的应用程序如果出现内存泄漏,会导致系统资源的浪费。内存泄漏不仅消耗了宝贵的内存资源,还可能导致物理内存耗尽,这时操作系统不得不使用交换空间(swap),这会进一步降低系统性能。在极端情况下,内存泄漏会耗尽所有可用的内存,导致系统崩溃或其他不可预测的行为。

在多用户环境中,内存泄漏可能会导致整个系统的不稳定,因为资源的浪费会导致资源分配不公平,从而影响其他正在运行的应用程序。

通过以上内容的分析,我们可以看到内存泄漏对程序性能和系统稳定性的影响是深远的。在下一章节,我们将探讨如何使用各种工具来诊断和解决PyTorch中的内存泄漏问题。

```

# 3. PyTorch内存泄漏诊断工具

在深度学习模型的训练过程中,内存泄漏是一个潜在的问题,它会导致程序的性能逐渐下降,甚至崩溃。PyTorch提供了丰富的工具和方法来诊断和处理内存泄漏问题。本章将详细介绍如何使用这些诊断工具,以确保模型的高效运行和资源的有效管理。

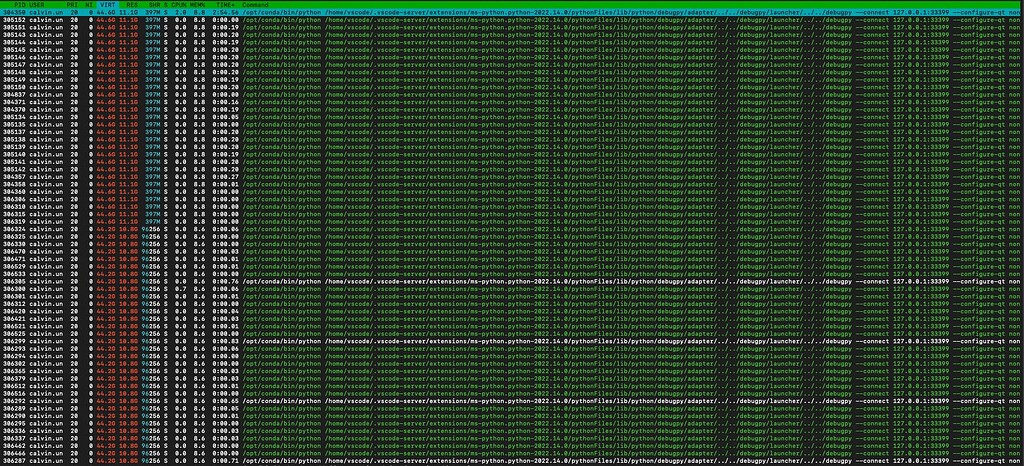

## 3.1 使用nvidia-smi监控内存使用

### 3.1.1 nvidia-smi工具简介

NVIDIA System Management Interface(nvidia-smi)是一个命令行工具,用于监视NVIDIA GPU设备的状态。它提供了设备、驱动程序、NVML库的信息和GPU利用率、温度、电力消耗、功耗限制、GPU内存占用、进程信息等详细信息。对于PyTorch开发者来说,nvidia-smi是监控GPU内存使用情况的有力工具。

### 3.1.2 实践案例:监控GPU内存

使用nvidia-smi来监控GPU内存,可以遵循以下步骤:

1. 安装nvidia-smi工具:如果系统中未安装,可以通过包管理器或直接从NVIDIA官网下载安装。

2. 运行nvidia-smi命令:在终端中输入`nvidia-smi`,会显示出所有GPU的状态信息。

3. 实时监控内存使用:使用`watch`命令来周期性地显示GPU的状态信息,例如使用`watch -n 1 nvidia-smi`每秒刷新一次。

```bash

watch -n 1 nvidia-smi

```

输出将包括如下信息:

```plaintext

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 450.57 Driver Version: 450.57 CUDA Version: 11.0 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatil

```

0

0