【向量空间与子空间:探索维度的秘密】:《线性代数介绍》第五版习题的深度解析

发布时间: 2024-12-14 14:15:19 阅读量: 4 订阅数: 6

线性代数(第二版)(复旦社郝志峰版)课后习题答案详解大全

参考资源链接:[线性代数第五版习题解答手册——Gilbert Strang](https://wenku.csdn.net/doc/6401abf3cce7214c316ea169?spm=1055.2635.3001.10343)

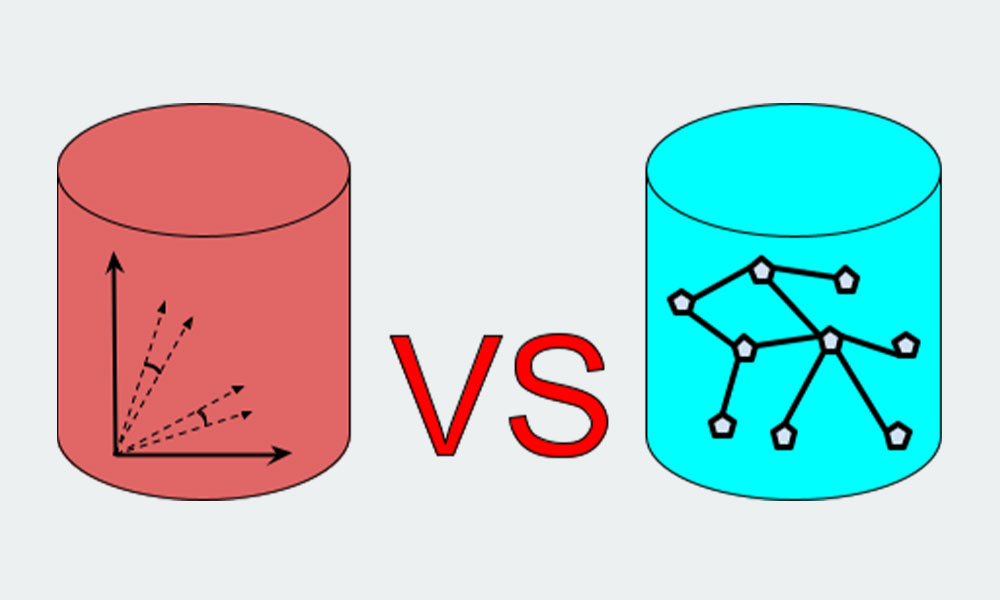

# 1. 向量空间基础概念

在现代数学和应用数学领域,向量空间是构成线性代数的核心概念之一,它不仅是理解更复杂数学结构的基础,也是许多工程技术问题中的关键组成部分。

## 1.1 向量与向量空间的定义

### 1.1.1 向量的基本概念

向量可以被理解为具有大小和方向的量。在数学中,它们通常被表示为箭头,从一个点指向另一个点,拥有起始点和终点。在实际应用中,向量可以代表力、速度、电场等物理量。在数学的抽象语境下,n维向量可以看作是n个数的有序数组。

### 1.1.2 向量空间的公理体系

向量空间,也被称为线性空间,是由一组向量构成的集合,满足以下公理体系:

- 封闭性:向量空间中的向量加法和标量乘法必须产生该空间内的向量。

- 结合律和交换律:向量加法必须满足结合律和交换律。

- 存在零向量:集合中必须存在一个零向量,使得任何向量与零向量相加都等于其自身。

- 存在负向量:对于集合中的每一个向量,都存在一个对应的负向量,使得二者相加等于零向量。

通过理解这些基础概念和公理,我们可以为后续章节中对向量空间性质、子空间以及维度与基的深入探讨打下坚实的基础。

# 2. 向量空间的性质与定理

## 2.1 向量空间的性质

### 2.1.1 封闭性、结合律和交换律

向量空间中的封闭性是指向量空间对于向量加法和标量乘法这两种运算的封闭性。换言之,如果我们有两个向量 **u** 和 **v** 都属于同一个向量空间 **V**,那么它们的和 **u + v** 也必须属于这个向量空间。同样,如果 **v** 是向量空间的一个元素,而 λ 是一个标量(即实数或复数),那么 λ**v** 也必须是向量空间的一个元素。

结合律是指在向量空间中加法运算满足结合律,即对于任意三个向量 **u**、**v** 和 **w**,都有 ( **u + v** ) + **w** = **u** + ( **v + w** )。交换律指的是加法运算满足交换律,意味着对于任意两个向量 **u** 和 **v**,都有 **u + v** = **v + u**。

### 2.1.2 零向量与负向量的存在性

零向量是指在向量空间中存在一个特殊的向量,它与任何其他向量相加都得到那个其他向量。在数学术语中,如果 **0** 是零向量,那么对于任意向量 **v**,都满足 **v + 0** = **v**。零向量的存在性是向量空间的公理之一。

对于向量空间中的每一个向量 **v**,必须存在一个对应的负向量(或称逆向量)**-v**,使得 **v + (-v)** = **0**。这个性质保证了向量空间中任意向量都可以通过加法运算与它的逆向量抵消。

## 2.2 向量空间的基本定理

### 2.2.1 基和维数定理

向量空间的一个重要概念是基,基是一组线性无关的向量,可以通过它们的线性组合生成整个向量空间。基的概念是向量空间理论的核心,因为它为理解向量空间的结构提供了框架。

维数定理告诉我们,同一个向量空间的不同基中包含的向量数量是相同的,这个固定的数量称为向量空间的维数。维数的概念帮助我们区分和分类向量空间,例如,二维空间包含两个维度,可以由两个线性无关的向量完全描述。

### 2.2.2 坐标与变换定理

向量在基下的表示称为坐标。具体而言,如果我们有向量空间 **V** 的一组基 B = {**b**1, **b**2, ..., **b**n},那么对于 **V** 中的任何向量 **v**,都可以找到唯一的一组标量 c1, c2, ..., cn,使得 **v** = c1**b**1 + c2**b**2 + ... + cn**b**n。这里的 (c1, c2, ..., cn) 就是向量 **v** 在基 B 下的坐标。

变换定理描述了向量从一个基变换到另一个基的过程。如果 B 和 B' 是向量空间的两组基,那么向量在这两个基下的坐标之间存在一个线性变换,这个变换可以通过基向量之间的关系来确定,并且可以通过一个矩阵来表示,这个矩阵称为过渡矩阵。

向量空间的这些性质和定理是线性代数的核心部分,不仅在理论上有深刻的意义,而且在实际应用中具有广泛的应用,如在计算机图形学、机器学习以及量子力学等领域。接下来,我们将深入探讨子空间的概念和应用,这将为我们后续探讨维度和基的理论与应用提供坚实的基础。

# 3. 子空间的探索与应用

子空间是向量空间概念的一个拓展,在数学、物理学和工程技术中扮演着核心角色。理解子空间的性质以及它如何与其他数学结构相互作用,对于深入理解更复杂的概念至关重要。本章将探索子空间的定义、生成、维数计算以及在各种实际应用中的作用。

## 3.1 子空间的概念与判断

### 3.1.1 子空间的定义和例子

在数学中,子空间是某个向量空间的一个子集,它自身也是一个向量空间。为了成为子空间,一个集合必须满足以下条件:

- 非空:至少包含一个向量,即零向量。

- 封闭性:如果集合中的两个向量被加在一起,或者集合中的一个向量被标量乘以,结果仍然在集合中。

以二维向量空间 \( \mathbb{R}^2 \) 为例,考虑所有形如 \( (x, 0) \) 的向量组成的集合,即所有在 x 轴上的向量。这个集合满足子空间的条件,因为两个这样的向量相加仍然是在 x 轴上,任意一个这样的向量乘以一个标量,结果同样在 x 轴上。

### 3.1.2 子空间的交与和的性质

子空间的交集和和集同样构成子空间:

- 交集:如果两个子空间的交集非空且对于集合内的任何两个向量,它们的加法和数乘操作结果仍然在这个交集中,那么这个交集就是子空间。

- 和集:两个子空间的和集是指所有可能的向量和(包括来自一个子空间和另一个子空间的任意向量的和)构成的集合。这个和集也形成一个子空间。

例如,假设 \( U \) 和 \( V \) 是 \( \mathbb{R}^3 \) 中的子空间,定义为:

U = \{(x, y, 0) \in \mathbb{R}^3 \mid x, y \in \mathbb{R}\}

V = \{(x, 0, z) \in \mathbb{R}^3 \mid x, z \in \mathbb{R}\}

显然,\( U \) 和 \( V \) 分别是 xz-平面和 xy-平面。它们的交集 \( U \cap V \) 是只有零向量的集合,因为唯一同时在 xz-平面和 xy-平面上的向量就是零向量。而它们的和集 \( U + V \) 是整个 \( \mathbb{R}^3 \) 空间,因为可以通过 \( U \) 中的向量和 \( V \) 中的向量组合成任意 \( \mathbb{R}^3 \) 中的向量。

## 3.2 子空间的生成与维数

### 3.2.1 生成集和基的概念

子空间可以由一组生成集生成,这组生成集是能够创建出子空间内所有向量的向量集。一个子空间的所有生成集中的最小集合称为基。基中向量的数量定义了子空间的维数。

例如,在 \( \mathbb{R}^3 \) 中,向量 \( (1,0,0) \),\( (0,1,0) \),和 \( (0,0,1) \) 组成这个空间的基,因为它们线性无关且任何 \( \mathbb{R}^3 \) 中的向量都可以表示为这三个向量的线性组合。

### 3.2.2 子空间维数的计算方法

计算子空间的维数,最直接的方法是找到它的基,并计算基中向量的数量。但是,有时候我们并不知道基,这时可以使用秩-零化度定理(Rank-Nullity Theorem)来间接计算维数。

对于一个子空间 \( W \) 由矩阵 \( A \) 的列空间生成,子空间的维数等于 \( A \) 的秩。例如:

```matlab

% MATLAB 示例

A = [1, 2, 3; 4, 5, 6; 7, 8, 9];

null_space = null(A);

rank_A = size(A, 1) - nullity(A);

```

在这个例子中,我们计算了矩阵 \( A \) 的零空间,然后使用秩-零化度定理来找出列空间的维数。

## 3.3 子空间的实际应用

### 3.3.1 子空间在解线性方程组中的应用

在解线性方程组时,我们通常得到的解集实际上构成了一个子空间。这个子空间的基向量可以作为原线性方程组的通解的表示。

以线性方程组为例:

\begin{align*}

x + 2y - z &= 0, \\

2x + 4y - 2z &= 0,

\end{align*}

我们可以发现第二个方程是第一个方程的两倍,这意味着这两个方程只定义了一个独立方程。因此,解集是通过以下向量生成的子空间:

\{(2, 1, 0)\},

这意味着,任何满足这个方程组的 \( x, y, z \) 向量都可以写成 \( (2t, t, 0) \) 的形式,其中 \( t \) 是任意标量。

### 3.3.2 子空间在数据压缩中的作用

在数据压缩中,我们尝试找到数据的内在子空间,并在这个低维空间内重构数据。例如,主成分分析(PCA)是一种用于数据压缩和降维的技术,它通过寻找数据的主成分(子空间的一组基)来实现。

子空间的基向量可以理解为数据变化的主要方向,而数据点在这个子空间中的投影则包含了数据的主要特征信息。例如:

```python

import numpy as np

from sklearn.decomposition import PCA

# 假定我们有一些二维数据

data = np.array([[1, 2], [3, 4], [5, 6]])

# 使用PCA降维到1维子空间

pca = PCA(n_components=1)

reduced_data = pca.fit_transform(data)

# 输出变换后的数据

print(reduced_data)

```

在这个例子中,PCA 通过将数据投影到它的主成分上,从而减少了数据的维度,同时还尽可能保留了数据的变异信息。

# 4. 维度与基的理论解析

## 4.1 维度的概念及其意义

### 4.1.1 维度的定义与直观理解

在数学中,特别是在线性代数和向量空间理论中,维度是衡量空间复杂性的一个关键概念。直观上讲,维度可以被视为描述一个空间所需要的独立坐标数量。例如,在我们的三维世界中,任何点的位置都可以通过三个坐标——经度、纬度和高度——来唯一确定。在向量空间的语境中,维度代表构成该空间的一组基向量的数量,这些基向量线性无关,并能够张成整个空间。

### 4.1.2 维度和自由度的关系

维度与自由度紧密相关,自由度通常指的是在给定条件下可以自由变化的量的数目。在统计学和机器学习中,自由度可能与样本大小和模型参数数量有关。在向量空间的上下文中,自由度往往与维度相同。例如,在一个由n个线性无关的向量生成的n维空间中,任意向量都可以通过这n个基向量的线性组合来唯一表示,也就是说我们有n个自由度来独立地改变这个向量。

## 4.2 基的选取与性质

### 4.2.1 基的唯一性与完备性

基是向量空间的一个概念,任何向量空间都可以有一组基。基的选取不是唯一的,但所有基的向量数量是相同的,这个共同的数量就是向量空间的维度。更重要的是,基向量集必须是完备的,这意味着空间中任意向量都可以由基向量的线性组合唯一表示,而不会出现冗余或缺失。换句话说,基是向量空间的一个最小生成集,没有多余的向量,也没有缺少能够生成空间中所有向量的向量。

### 4.2.2 标准正交基及其构造方法

标准正交基是应用非常广泛的一种基,其向量不仅线性无关,而且都是单位向量,并且两两正交。正交意味着基向量之间的点积为零,即它们彼此垂直。在线性代数中,Gram-Schmidt正交化过程是一种常用的构造标准正交基的方法。这个过程涉及以下步骤:

1. 选择一个线性无关的向量集。

2. 通过正交化过程生成一组正交向量。

3. 将正交向量归一化,使其成为单位向量,完成标准正交基的构建。

以下是Gram-Schmidt正交化过程的伪代码:

```python

def gram_schmidt(V):

n = len(V)

U = []

for i in range(n):

u = V[i]

for j in range(len(U)):

u = u - (U[j]*dot(U[j], V[i]))/dot(U[j], U[j])

U.append(u)

return [u/sqrt(dot(u,u)) for u in U]

```

这里的`V`是一个向量列表,`U`是正交化后的向量列表,`dot`函数计算两个向量的点积。这个过程在每个基向量被计算之后,都要确保其与之前所有基向量正交,并且最后还要进行归一化处理。

在实际应用中,标准正交基的性质使得很多运算变得更加简单,比如内积的计算和坐标变换等。标准正交基在物理、工程、信号处理以及许多其他领域都扮演着重要角色。

# 5. 维度与基的实践应用案例

## 5.1 维度在机器学习中的应用

### 5.1.1 特征空间与特征维度

在机器学习领域,特征空间代表了数据能够映射到的多维空间,而特征维度即为这个空间的维度。高维特征空间可以为模型提供更丰富的表示能力,但同时也可能带来过拟合的风险。理解特征维度对于优化模型性能至关重要。

在实践中,选择正确的特征维度是一个多方面权衡的过程。通过减少特征维度,我们可以消除冗余特征,减少噪声的影响,并加快计算速度。常用的方法包括主成分分析(PCA)、线性判别分析(LDA)等。

```python

import numpy as np

from sklearn.decomposition import PCA

# 假设X是一个已有的数据集,其特征维度为N

X = np.random.rand(100, 10) # 生成100个样本,每个样本10个特征的数据集

pca = PCA(n_components=2) # 将数据降维至2维

X_reduced = pca.fit_transform(X) # 执行降维操作

print("原始特征维度:", X.shape)

print("降维后的特征维度:", X_reduced.shape)

```

### 5.1.2 维度缩减技术简介

维度缩减技术旨在去除不重要的特征,以简化模型同时提高其性能。这不仅可以减少训练时间,还可以提高模型泛化能力。PCA、线性判别分析(LDA)等方法都是进行维度缩减的有效工具。

以PCA为例,它通过线性变换将原始数据变换到一组各维度线性不相关的数据上,这些新维度称为主成分。前几个主成分通常包含了数据的大部分变异信息,因此可以作为数据的降维表示。

## 5.2 基变换在信号处理中的角色

### 5.2.1 傅里叶变换与频域分析

傅里叶变换是一种将信号从时域转换到频域的数学方法。它允许我们分析信号在不同频率成分上的构成,这对于信号处理尤其重要。通过基变换,我们将复杂的信号分解为一系列简单的正弦波分量,使分析和处理更加直观。

```python

import numpy as np

import matplotlib.pyplot as plt

from scipy.fft import fft

# 生成一个信号

t = np.linspace(0, 1, 500, endpoint=False)

signal = np.sin(2 * np.pi * 50 * t) + 0.5 * np.sin(2 * np.pi * 120 * t)

# 进行傅里叶变换

signal_fft = fft(signal)

# 计算频率轴

freq = np.fft.fftfreq(t.shape[-1])

# 绘制频谱

plt.plot(freq, np.abs(signal_fft))

plt.xlabel('Frequency (Hz)')

plt.ylabel('Amplitude')

plt.title('Fourier Transform')

plt.show()

```

### 5.2.2 小波变换与多尺度分析

小波变换提供了一种与傅里叶变换不同的方式来分析信号。它在时间域和频率域都具有良好的局部化特性,因此非常适合处理具有非平稳特性的信号。小波变换可以被看作是一种在不同尺度上对信号进行分解的方法。

小波变换在图像处理、语音分析等领域有着广泛的应用,它使得在局部区域内分析信号成为可能,而这是傅里叶变换所无法做到的。

```python

import pywt

import numpy as np

# 生成一个简单的信号

t = np.linspace(0, 1, 1000)

signal = np.sin(2 * np.pi * 5 * t) + np.sin(2 * np.pi * 10 * t) + np.random.normal(0, 0.1, t.shape)

# 使用小波变换进行分析

coeffs = pywt.wavedec(signal, 'db1', level=3)

# 展示小波分解的结果

labels = ["Approximation", "Detail"]

plt.figure(figsize=(10, 6))

for i, coeff in enumerate(coeffs):

plt.subplot(3, 1, i + 1)

plt.plot(coeff)

plt.title(labels[i] + " level " + str(i))

plt.tight_layout()

plt.show()

```

## 5.3 线性代数软件工具的实际应用

### 5.3.1 MATLAB在向量空间分析中的应用

MATLAB是一个广泛使用的数值计算环境,提供了强大的线性代数计算能力。它在向量空间的分析与可视化方面提供了很多工具箱和函数。例如,MATLAB中使用`rank`函数来确定矩阵的秩,使用`eig`函数来计算矩阵的特征值和特征向量。

### 5.3.2 Python及其线性代数库的实际案例

Python作为一种开源的编程语言,在科学计算领域也越来越受欢迎。通过使用像NumPy、SciPy这样的库,Python能够执行复杂的线性代数运算,其在灵活性和易用性方面甚至超过了MATLAB。此外,Pandas库可以方便地处理数据,而Matplotlib和Seaborn库则提供了强大的数据可视化功能。

```python

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

# 使用NumPy创建矩阵

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 10]])

# 使用Pandas进行矩阵运算

df = pd.DataFrame(A)

# 进行矩阵求秩运算

rank_A = np.linalg.matrix_rank(A)

print("矩阵A的秩为:", rank_A)

# 可视化矩阵数据

plt.imshow(df, cmap='hot', interpolation='nearest')

plt.colorbar()

plt.title("Matrix Visualization")

plt.show()

```

通过以上示例,我们可以看到如何在机器学习、信号处理和数据处理中利用维度和基的概念进行实践应用,以及如何通过现代编程工具来辅助这些任务的完成。

0

0