【人工智能与矩阵】:加速深度学习的矩阵运算技术

发布时间: 2024-12-14 06:16:33 阅读量: 4 订阅数: 13

参考资源链接:[《矩阵理论及其应用》课后答案与解析](https://wenku.csdn.net/doc/4r610ic633?spm=1055.2635.3001.10343)

# 1. 人工智能与矩阵运算的关系

人工智能(AI)和矩阵运算紧密相关,尤其是在深度学习领域。矩阵运算不仅构成了神经网络的数学基础,而且是实现复杂算法和数据处理的关键技术。本章将介绍它们之间关系的背景,并探讨矩阵运算如何在AI领域内实现其核心功能。

## 1.1 矩阵运算的定义及其在AI中的重要性

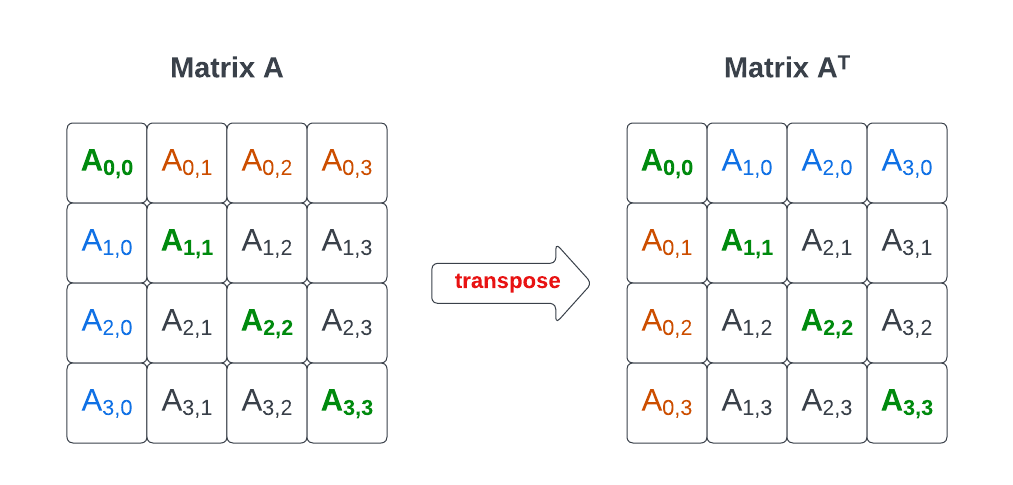

矩阵运算涉及到向量和矩阵的计算,如矩阵加法、乘法、转置等操作。在AI中,尤其是深度学习模型的训练和推断过程中,矩阵运算被广泛用于数据表示、变换、参数更新等环节。模型参数的权重更新往往依赖于大量的矩阵乘法操作,使得矩阵运算是实现深度学习模型的基石。

## 1.2 矩阵运算与数据的内在联系

从数据的角度看,矩阵运算能高效地处理多维数据结构,这在AI中的应用尤为重要。例如,图像处理中的卷积神经网络(CNN)就是通过一系列的矩阵运算来提取特征和模式。同样,在自然语言处理(NLP)中,矩阵运算用于文本数据的嵌入和转换,从而支撑复杂的语言模型。因此,理解矩阵运算的原理对于优化AI算法至关重要。

## 1.3 AI中矩阵运算的典型应用场景

矩阵运算在多个AI领域有其独特应用。例如,在推荐系统中,用户-物品交互矩阵被用来计算相似性和预测评分。在强化学习中,策略评估和更新过程中也大量使用了矩阵运算。这些场景展示了矩阵运算作为AI技术的重要组成部分,无处不在且功能强大。

# 2. 深度学习中的矩阵运算理论基础

在深度学习的理论基础中,矩阵运算不仅是算法实现的核心,更是优化和加速的关键。本章节将深入探讨深度学习中矩阵运算的理论基础,并通过具体的数学概念和应用实例,为读者构建一个扎实的理解基础。

## 2.1 线性代数基础知识回顾

### 2.1.1 向量和矩阵的基本概念

向量是深度学习中最基本的数据单元,而矩阵则是向量的扩展,由行和列组成的二维数组。在数学上,向量可以看作是具有方向和大小的量,而矩阵可以看作是向量的集合。

例如,一个m行n列的矩阵A可以表示如下:

```math

A =

\begin{bmatrix}

a_{11} & a_{12} & \cdots & a_{1n} \\

a_{21} & a_{22} & \cdots & a_{2n} \\

\vdots & \vdots & \ddots & \vdots \\

a_{m1} & a_{m2} & \cdots & a_{mn}

\end{bmatrix}

```

在深度学习中,矩阵A可以表示神经网络中的权重或输入数据。

### 2.1.2 矩阵运算及其性质

矩阵运算包括加法、减法、标量乘法和乘法等,每种运算都有其特定的规则。比如,矩阵加法要求矩阵具有相同的维度,而矩阵乘法则遵循行列配对原则。

- **矩阵加法**:两个同维度矩阵相加,对应元素相加。

- **矩阵乘法**:矩阵A的每一行与矩阵B的每一列对应元素相乘后求和。

矩阵乘法的一个重要性质是,它不满足交换律,即通常情况下AB ≠ BA。

## 2.2 深度学习中的张量操作

### 2.2.1 张量的定义和类型

在深度学习中,张量是矩阵概念的自然扩展,可视为一个高维的数组。一个张量可以包含一维的向量、二维的矩阵,甚至是多维的数据结构。

- **标量(0阶张量)**:单一数值。

- **向量(1阶张量)**:一个方向上的数值数组。

- **矩阵(2阶张量)**:通常用作表示数据特征或神经网络的权重。

- **高阶张量**:三个或更多维度的张量,常用于表示多维数据。

### 2.2.2 张量运算在深度学习中的应用

张量运算在深度学习中非常常见,尤其是在处理图像和视频等多维数据时。在卷积神经网络(CNN)中,张量运算用于实现卷积、池化和全连接层的计算。

例如,一个卷积操作可以表示为:

```python

# 伪代码,展示卷积操作

output = conv2d(input_tensor, kernel, strides, padding)

```

这里的`input_tensor`是一个四维张量,通常的形状为(N, C_in, H, W),其中N是批次大小,C_in是输入通道数,H和W分别是输入的高度和宽度。`kernel`是一个过滤器(卷积核),它的形状为(C_out, C_in, kernel_height, kernel_width),其中C_out是输出通道数。

## 2.3 矩阵分解技术在深度学习中的作用

### 2.3.1 主成分分析(PCA)

主成分分析(PCA)是一种常用的矩阵分解技术,它的目的是通过正交变换将可能相关的变量转换为一组线性不相关的变量,这些变量称为主成分。在深度学习中,PCA可以用于数据预处理,以便降维和去噪声。

### 2.3.2 奇异值分解(SVD)

奇异值分解(SVD)是另一种重要的矩阵分解技术,它可以将任意矩阵分解为三个特殊矩阵的乘积,这三个矩阵分别是单位正交矩阵U、对角矩阵Σ和单位正交矩阵V的转置。

```math

A = UΣV^T

```

在深度学习中,SVD可以用于推荐系统、文本分析等领域。

在本章节中,我们深入探讨了矩阵运算的理论基础,包括线性代数的基础知识、张量操作的定义和应用以及矩阵分解技术。这为理解深度学习中的矩阵运算提供了坚实的基础,为后续章节中将理论应用于实践奠定了基础。在接下来的章节中,我们将探索深度学习框架如何实现高效的矩阵运算,以及如何通过编程技巧和硬件加速提升矩阵运算的性能。

# 3. 深度学习框架中的矩阵运算实现

## 3.1 TensorFlow中的矩阵运算机制

### 3.1.1 TensorFlow的基本数据结构TF.Tensor

TensorFlow 是一个开源的软件库,专为数据流图和数值计算而设计。在 TensorFlow 中,数据的基本单位是张量(Tensor),它是一个多维数组,其类型和形状在构建图时定义。TF.Tensor 是 TensorFlow 的核心数据类型,用于在计算图中表示所有的数据,包括输入、输出以及中间计算结果。

#### 张量的属性和操作

张量拥有以下重要属性:

- **秩(Rank)**:代表张量的维度,例如,一个标量秩为0,向量为1,矩阵为2。

- **形状(Shape)**:一个整数元组,表示每个维度的大小。

- **类型(Type)**:张量中数据的类型,例如 int32,float32,string 等。

在 TensorFlow 中,可以通过如下代码创建一个张量:

```python

import tensorflow as tf

# 创建一个常量张量

a = tf.constant([[1, 2], [3, 4]], dtype=tf.float32)

# 创建一个变量张量

b = tf.Variable(tf.random.normal([2, 2]), name='b')

# 计算两个张量的乘法

c = tf.matmul(a, b)

```

**代码逻辑分析**:

- `tf.constant` 创建了一个不可变的张量,常用于模型的输入。

- `tf.Variable` 创建了一个变量张量,可以在优化过程中被更新,通常用于模型参数。

- `tf.matmul` 执行了两个张量的矩阵乘法,这是一个常见的深度学习矩阵运算。

### 3.1.2 高级矩阵运算API介绍

TensorFlow 提供了丰富的 API 来支持复杂的矩阵运算,不仅包括基本

0

0