【数据处理升级】:从Pandas到Dask,Anaconda中的性能飞跃秘籍

发布时间: 2024-12-09 18:33:15 阅读量: 9 订阅数: 12

Python中Pandas库的数据分析实战:从基础到进阶

# 1. 数据处理的挑战与解决方案

## 1.1 数据处理面临的问题

随着数据量的激增,传统的数据处理方法已经难以满足企业对效率和规模的需求。数据处理的主要挑战包括但不限于数据量大导致的内存不足问题、处理速度慢和并发处理能力弱等。此外,数据的多样性和非结构化问题也使得数据处理变得更加复杂。

## 1.2 挑战带来的影响

这些挑战给数据科学家和工程师带来了许多限制。例如,长时间的数据处理周期导致决策延迟,无法实时响应业务需求;数据处理瓶颈使得数据价值挖掘不充分;以及资源的低效使用导致成本的增加等。

## 1.3 解决方案概述

为应对这些挑战,需要采用更高级的数据处理技术和工具。这些解决方案包括但不限于:

- 使用内存高效的工具和库,如Dask。

- 利用分布式计算框架处理大规模数据集。

- 引入高效的数据清洗和预处理方法,以提高数据质量。

接下来的章节将深入探讨如何通过Pandas和Dask解决数据处理中的具体问题,并展示如何实现从Pandas到Dask的平滑过渡。

# 2. Pandas基础与高效数据处理

### 2.1 Pandas的数据结构

#### 2.1.1 Series和DataFrame的基本操作

Pandas库提供了两种基础的数据结构:Series和DataFrame。Series可以看作是一个一维数组,它能够存储任意类型的数据,比如整数、字符串、浮点数、Python对象等。DataFrame是一个二维标签化数据结构,可以看作是一个表格,有行索引和列索引。

```python

import pandas as pd

# 创建一个简单的Series

s = pd.Series([1, 2, 3, 4, 5])

print(s)

# 创建一个DataFrame

data = {'Name': ['Tom', 'Nick', 'John'],

'Age': [20, 21, 19]}

df = pd.DataFrame(data)

print(df)

```

在上述代码块中,我们创建了一个Series对象s,包含5个整数,并打印出来。紧接着,我们创建了一个DataFrame对象df,这是一个包含两列('Name'和'Age')和三行数据的表格。

#### 2.1.2 数据索引与选择技巧

索引和选择是Pandas中非常重要的操作,它们允许我们快速访问和操作数据集中的特定数据。

```python

# 使用索引访问Series中的元素

s_element = s[0]

print(s_element)

# 使用条件过滤来选择DataFrame中的行

df_age_over_20 = df[df['Age'] > 20]

print(df_age_over_20)

```

在代码块中,我们通过s[0]访问了Series s的第一个元素,并且通过df[df['Age'] > 20]筛选出了所有年龄大于20岁的人的数据行。Pandas使用方括号[]进行索引,这与Python原生的索引方式一致。

### 2.2 Pandas的数据清洗与准备

#### 2.2.1 缺失数据的处理方法

数据清洗是数据处理过程中的一项重要任务,其中处理缺失数据是核心之一。在Pandas中,缺失值通常用`NaN`表示。

```python

import numpy as np

# 创建一个包含缺失值的DataFrame

data = {'A': [1, np.nan, 3], 'B': [4, 5, np.nan]}

df = pd.DataFrame(data)

print(df)

# 删除含有缺失值的行或列

df_dropped = df.dropna()

print(df_dropped)

# 用特定值填充缺失值

df_filled = df.fillna(0)

print(df_filled)

```

在这些代码块中,我们首先创建了一个包含`NaN`的DataFrame,然后展示了如何删除含有缺失值的行或列,以及如何用零填充这些缺失值。`dropna`和`fillna`是Pandas中处理缺失数据的常用方法。

#### 2.2.2 数据合并与重塑技术

在数据处理中,合并数据集和重塑数据是常见的需求。Pandas提供了多种工具来实现这些操作。

```python

# 合并两个DataFrame

df1 = pd.DataFrame({'A': ['foo', 'bar'], 'B': ['one', 'two']})

df2 = pd.DataFrame({'C': ['three', 'four'], 'D': ['five', 'six']})

merged_df = pd.concat([df1, df2], axis=1)

print(merged_df)

# 使用melt函数重塑DataFrame

df_melted = pd.melt(df1, id_vars=['A'], value_vars=['B'])

print(df_melted)

```

在以上代码示例中,`pd.concat`函数用来沿指定轴合并多个DataFrame对象,这里是横向合并。`melt`函数则是将DataFrame从宽格式转换为长格式,非常适合数据重塑。

### 2.3 Pandas的高级功能

#### 2.3.1 分组、聚合与转换数据

分组(Grouping)是Pandas中用于对数据集中的数据进行聚合和转换操作的强大工具。它可以按照某个或某些列的值将数据集分割成多个组,并对每个组执行聚合函数。

```python

# 分组聚合操作

grouped = df.groupby('Name').sum()

print(grouped)

# 应用自定义函数进行转换

def custom_function(x):

return x.mean() - x.std()

transformed = df.groupby('Name').transform(custom_function)

print(transformed)

```

在这段代码中,我们首先对df按'Name'列进行了分组,并计算了每个分组的总和。然后定义了一个自定义函数`custom_function`,并使用`transform`方法对数据进行了一系列的转换操作。

#### 2.3.2 时间序列数据的处理

时间序列数据处理是Pandas的一个重要应用领域,其提供了丰富的工具来处理时间戳和时间周期。

```python

# 创建一个时间序列

index = pd.date_range('20230101', periods=5, freq='D')

ts = pd.Series(range(5), index=index)

print(ts)

# 时间序列的重采样操作

resampled_ts = ts.resample('M').sum()

print(resampled_ts)

```

在这段代码中,我们首先创建了一个以日期为索引的时间序列,然后演示了如何对时间序列进行重采样,这里是按月汇总。重采样是数据分析中常见的需求,尤其是涉及到将高频数据转换为低频数据时。

这些基础和高级功能的应用使得Pandas成为数据科学领域中不可或缺的工具,同时为高效数据处理提供了强大的支持。在下一章中,我们将介绍Dask的基础知识,探索其在大规模数据处理中的潜力。

# 3. Dask简介与安装配置

## 3.1 Dask的核心概念

### 3.1.1 Dask与Pandas的关系与差异

在处理大规模数据集时,Pandas作为Python数据分析的黄金标准,提供了简单而强大的数据结构和操作方法。然而,当数据集的大小超过内存限制时,Pandas的性能就会受到限制。这正是Dask诞生的背景。

Dask与Pandas在许多方面有着相似之处,例如它们都使用DataFrame和Series这两种数据结构来组织数据。但是,Dask是为了解决Pandas在处理大规模数据集时遇到的性能瓶颈而设计的。

主要差异如下:

- **并行计算能力**:Dask支持并行计算,可以通过多线程或多进程分散计算任务,有效利用机器资源。

- **内存管理**:Dask能够处理比内存大的数据集,因为它采用了延迟计算和分块(chunk)存储数据的方法。

- **扩展性**:Dask可以水平扩展,利用集群进行大规模数据处理,而Pandas一般限于单机。

- **执行引擎**:Dask使用一个任务调度器来管理任务依赖和执行流程,而Pandas通常是即时计算。

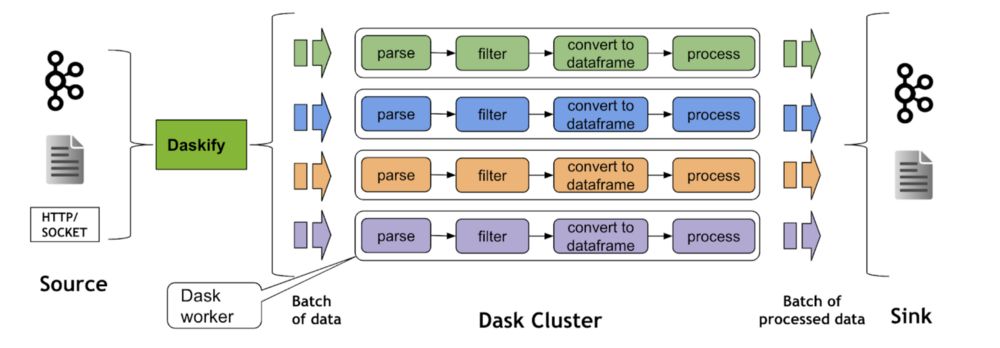

### 3.1.2 Dask的架构与优势

Dask的架构由三大部分组成:计算图(computational graph),任务调度器(task scheduler),以及可扩展的集群(scalable cluster)。

- **计算图**:Dask使用图来表示所有的计算任务及其依赖关系。每个节点代表一个任务,边代表数据依赖。这种图结构使得Dask能够优化任务执行顺序,减少重复计算。

- **任务调度器**:Dask的调度器负责根据计算图和机器的实际情况动态地分配任务,优化资源使用。

- **可扩展的集群**:Dask可以在单机、多机集群,甚至是云端容器中部署,无需修改代码,只需配置即可。

Dask的优势包括:

- **易于使用**:对于有Pandas基础的用户来说,Dask的API非常友好,可以快速上手。

- **灵活的集群管理**:支持本地多线程、多进程处理,也支持远程在集群或云上运行。

- **延迟计算**:Dask的计算是延迟

0

0