Python情感分析提升课:构建混合模型,深度挖掘文本情感

发布时间: 2024-12-07 06:46:01 阅读量: 7 订阅数: 16

基于微博评论的情感分析LDA主题分析和情感分析 完整数据代码可直接运行

# 1. Python情感分析概述

## 1.1 情感分析的定义与重要性

情感分析(Sentiment Analysis),也称为意见挖掘(Opinion Mining),是自然语言处理(NLP)领域的一个分支,旨在识别和提取文本数据中的主观信息。通过分析文本数据中的情感色彩,我们可以了解作者或公众对于某一话题或产品的态度是正面、中立还是负面。

情感分析广泛应用于市场研究、公关管理、政治分析等领域。尤其在互联网大数据时代,社交媒体、评论论坛等成为人们表达意见的重要平台,对这些海量信息进行有效的情感分析,对企业理解消费者情感、监测品牌声誉、优化产品和服务等方面具有重要意义。

## 1.2 Python在情感分析中的作用

Python由于其丰富的数据处理和机器学习库,在情感分析领域得到了广泛的应用。通过使用如NLTK、TextBlob、Scikit-learn、Keras等库,开发者能够轻松构建并训练复杂的模型,以完成从文本数据的预处理、特征提取到情感分类的全过程。

Python的易用性和灵活性为情感分析的研究和开发提供了便利。它不仅支持快速原型开发,还具备强大的社区支持和丰富的第三方资源,这让Python成为数据分析和NLP领域的首选语言。随着深度学习框架的完善,Python在情感分析中的作用愈发凸显,这也让更多的企业和研究机构倾向于采用Python作为情感分析工具。

在接下来的章节中,我们将详细探讨如何使用Python来构建情感分析的基础模型,并讨论在实践中如何优化这些模型以提高分析的准确性和效率。

# 2. 构建情感分析的基础模型

情感分析是自然语言处理(NLP)领域的一个重要分支,其核心目标是识别和提取文本数据中的主观信息。在本章中,我们将深入探讨构建基础情感分析模型的各个技术步骤。

## 2.1 文本预处理技术

文本预处理是情感分析中至关重要的一步,它直接关系到模型训练的效果和最终的情感识别精度。

### 2.1.1 分词和词性标注

在中文文本中,由于没有明显的单词边界,分词是文本预处理的第一步。分词之后,还需要进行词性标注,即识别每个词在句子中的语法功能。

```python

import jieba

sentence = "我爱北京天安门。"

words = list(jieba.cut(sentence))

print(words) # 输出分词结果

pos_tags = jieba.dt.postag(words)

print(pos_tags) # 输出词性标注结果

```

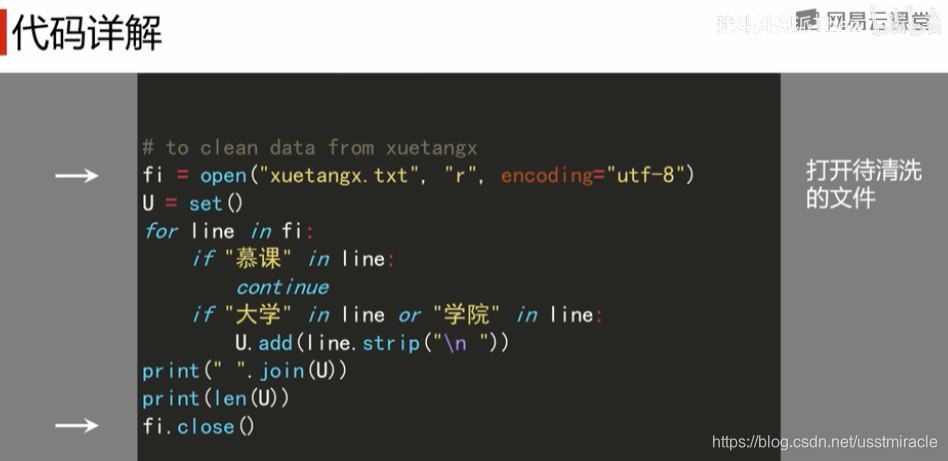

### 2.1.2 去除停用词和文本清洗

去除停用词是清理文本数据的重要步骤,停用词是指那些在文本中频繁出现但通常不承载有效信息的词,如“的”、“是”、“在”等。

```python

# 假设我们已经有了分词和词性标注的列表

filtered_words = [word for word, pos in pos_tags if pos not in ['u', 'x']]

print(filtered_words) # 输出过滤后的结果

```

## 2.2 基于机器学习的情感分析模型

在完成文本预处理之后,接下来的任务是构建一个基于机器学习的情感分析模型。

### 2.2.1 特征提取方法

文本数据需要转换为机器学习模型可以处理的数值特征。常用的特征提取方法有词袋模型(Bag of Words, BoW)、TF-IDF(Term Frequency-Inverse Document Frequency)等。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例句子列表

sentences = ["我爱我的祖国", "我讨厌下雨"]

# 初始化TF-IDF向量化器

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform(sentences)

feature_names = tfidf_vectorizer.get_feature_names_out()

print(feature_names) # 输出TF-IDF特征名称

print(tfidf_matrix.toarray()) # 输出TF-IDF特征矩阵

```

### 2.2.2 分类算法的选择与训练

在提取了文本特征之后,接下来就是选择合适的分类算法进行模型训练。常见的算法包括朴素贝叶斯、支持向量机(SVM)、随机森林等。

```python

from sklearn.svm import SVC

from sklearn.pipeline import make_pipeline

# 使用SVM算法进行分类

model = make_pipeline(TfidfVectorizer(), SVC(kernel='linear'))

model.fit(sentences, ["positive", "negative"])

# 对新的句子进行情感分析

new_sentences = ["我感到高兴", "我感到悲伤"]

predictions = model.predict(new_sentences)

print(predictions) # 输出预测结果

```

## 2.3 模型评估和优化

模型训练完成后,需要对其进行评估和优化,以确保它具有良好的泛化能力。

### 2.3.1 评估指标的选择

常用的评估指标有准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数等。

```python

from sklearn.metrics import classification_report

# 使用分类报告进行评估

print(classification_report(model.predict(sentences), ["positive", "negative"]))

```

### 2.3.2 模型调优策略

模型调优通常涉及调整模型参数、使用交叉验证等技术。其中,网格搜索(Grid Search)是一种常用的方法,它通过遍历预设的参数组合来找到最优模型配置。

```python

from sklearn.model_selection import GridSearchCV

# 设置SVM参数范围

parameters = {

'svc__C': [1, 10, 100],

'svc__gamma': [0.01, 0.1, 1]

}

# 使用网格搜索进行模型调优

grid_search = GridSearchCV(model, parameters, cv=3)

grid_search.fit(sentences, ["positive", "negative"])

# 输出最佳参数组合和交叉验证结果

print(grid_search.best_params_)

print(grid_search.best_score_)

```

在本章中,我们详细介绍了构

0

0