【大数据应用】:Anaconda在Hadoop到Spark的全栈应用指南

发布时间: 2024-12-07 06:02:12 阅读量: 7 订阅数: 11

虚拟机中使用的Anaconda,具体:Anaconda3-2021.05-Linux-x86-64,spark使用需要

# 1. 大数据基础与Anaconda简介

大数据时代已经到来,数据处理和分析的能力成为IT行业和个人技能中的核心部分。而Anaconda作为一个强大的Python数据科学平台,为处理大数据提供了一站式解决方案。在这一章,我们将首先介绍大数据的基本概念,包括大数据的特性(5V模型:Volume、Velocity、Variety、Veracity、Value)以及相关技术生态,例如Hadoop和Spark等。随后,我们将深入探讨Anaconda的安装、配置以及它的核心组件,如conda、pip和Jupyter Notebook,为后续章节中使用Anaconda搭建大数据处理环境做铺垫。通过本章内容,读者将对大数据技术有一个全面的了解,并掌握Anaconda的基本使用方法,为接下来的集成应用和深入实践打下坚实的基础。

# 2. Anaconda与Hadoop集成应用

### 2.1 Anaconda环境的搭建与配置

在大数据处理领域,Anaconda与Hadoop的结合能够提供一个功能强大的数据处理平台,Anaconda的强大在于其包管理和环境隔离功能,而Hadoop则提供了分布式存储和计算能力。接下来,我们将详细探讨如何搭建和配置这两个技术的集成环境。

#### 2.1.1 安装Anaconda与Hadoop环境

在安装Anaconda之前,确保系统满足最低要求,并已经安装了JDK。Anaconda的安装过程简单明了,以下是基于Linux环境的安装步骤:

```bash

# 下载Anaconda安装脚本

wget https://repo.anaconda.com/archive/Anaconda3-2021.05-Linux-x86_64.sh

# 执行安装脚本

bash Anaconda3-2021.05-Linux-x86_64.sh

```

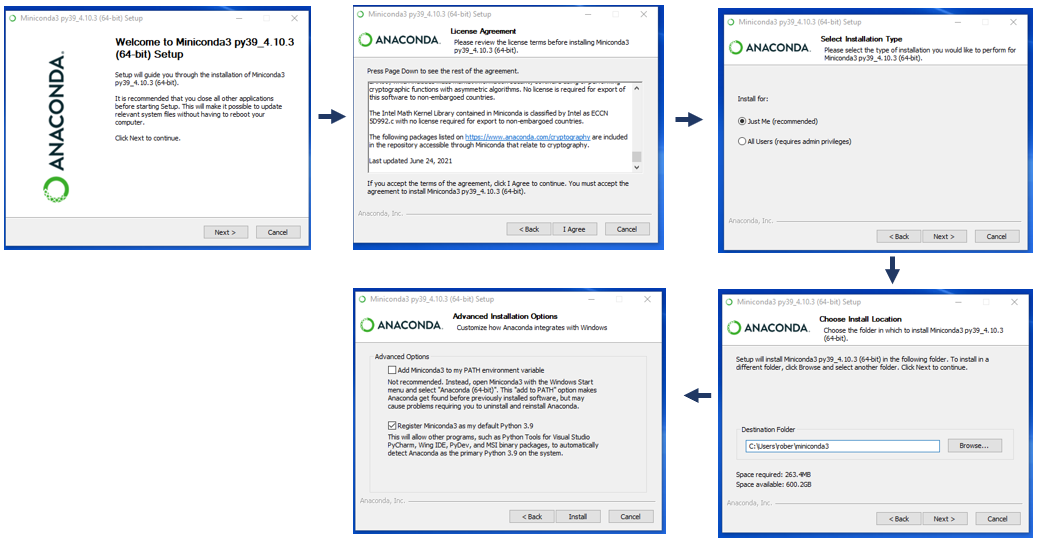

安装过程会要求用户阅读许可协议,确认安装路径,并询问是否将Anaconda的路径添加到`~/.bashrc`文件中。

对于Hadoop,可以从官方下载页选择适合的版本进行下载,并按照官方文档进行安装。在安装过程中,建议设置好环境变量,以便系统能够识别Hadoop的命令。

#### 2.1.2 配置Hadoop与Anaconda的集成

为了集成Hadoop与Anaconda,我们需要配置环境变量,以便在Anaconda环境中能够无缝使用Hadoop的相关命令。以下是配置的步骤:

```bash

# 编辑Anaconda环境的初始化文件

vim ~/.bashrc

# 在文件末尾添加Hadoop的环境变量

export HADOOP_HOME=/path/to/your/hadoop-installation

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export PYTHONPATH=$PYTHONPATH:$HADOOP_HOME/lib

# 使环境变量立即生效

source ~/.bashrc

```

以上步骤完成后,Hadoop环境已经在Anaconda环境中配置完毕。我们可以通过输入`hadoop version`来验证安装和配置是否成功。

### 2.2 基于Anaconda的Hadoop生态系统应用

#### 2.2.1 Anaconda与Hive的集成使用

Hive是Hadoop上的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供SQL查询功能。Anaconda提供了一个集成开发环境(IDE),支持Python和HiveQL的开发。

在Anaconda中,我们可以使用PyHive包来连接Hive,并执行操作。首先需要安装PyHive包:

```bash

pip install pyhive

```

以下是一个使用PyHive连接Hive并查询数据的示例代码:

```python

from pyhive import hive

import pandas as pd

# 连接Hive服务器

connection = hive.Connection(host='your_hive_server', port=10000, username='your_username')

# 执行查询

cursor = connection.cursor()

cursor.execute("SELECT * FROM your_table LIMIT 10")

# 使用pandas处理数据

data = cursor.fetchall()

df = pd.DataFrame(data, columns=[desc[0] for desc in cursor.description])

df.head()

```

#### 2.2.2 Anaconda与Pig的集成使用

Pig是一个高层次的数据流语言和执行框架,用于处理大规模数据。它提供了一个名为Pig Latin的脚本语言,用于描述数据流和转换。通过使用Anaconda,我们可以编写Python脚本来与Pig进行交互。

首先,我们需要安装PyPIG模块来在Anaconda中使用Pig:

```bash

pip install pyPIG

```

下面是一个使用PyPIG执行Pig脚本的Python示例:

```python

from pyPIG import Pig

# 初始化Pig实例

pig = Pig()

# 执行Pig脚本

pig_input = "register target.py"

pig_query = """

A = load 'input.txt' using PigStorage(',') as (x:chararray, y:int, z:int);

B = filter A by y > 10;

store B into 'output.txt' using PigStorage(',');

pig.exec_query(pig_input, pig_query)

```

#### 2.2.3 数据处理与分析案例分析

假设我们有一个大规模日志文件需要处理,日志中包含了用户的访问信息。我们将使用Anaconda与Hadoop生态系统的组件来完成数据的清洗、分析和报告。

1. **数据预处理**:使用HDFS存储原始日志文件,利用Hive对日志进行初步的ETL处理,提取出有用的字段。

2. **数据分析**:利用Pig脚本处理清洗后的数据,统计用户访问量、用户活跃时间段等指标。

3. **报告生成**:使用Python的matplotlib或seaborn库生成数据可视化报告,分析用户行为模式。

这一过程涵盖了从数据存储、处理到分析的整个工作流,Anaconda与Hadoop生态系统在此过程中发挥了协同作用。

### 2.3 Anaconda在Hadoop集群管理中的角色

#### 2.3.1 集群资源监控与管理

集群资源监控是确保Hadoop集群高效运行的关键。Anaconda可以通过集成Nagios、Ganglia等监控工具来实现对集群状态的实时监控。

Nagios是一个开源的系统和网络监控应用,它可以监控主机和服务。通过在集群中部署Nagios,并使用Anaconda来安装和配置Nagios插件,可以方便地进行集群状态的监控。

#### 2.3.2 性能优化与故障排查

性能优化和故障排查是集群管理的重要组成部分。Anaconda可以作为Python环境的载体,利用其丰富的科学计算库来进行性能分析,如线程分析、IO分析等。

性能调优涉及到集群的多个方面,包括HDFS、MapReduce、YARN等组件。使用Python编写的性能分析脚本可以集成到集群的监控系统中,自动化地监测和调优集群性能。

通过以上章节,我们了解了Anaconda与Hadoop集成应用的配置方法和使用案例,接下来将继续探讨Anaconda在Spark上的部署与实践。

# 3. Anaconda在Spark上的部署与实践

## 3.1 Spark环境的搭建与配置

### 3.1.1 安装与设置Anaconda与Spark环境

在大数据处理领域,Apache Spark作为一个快速的分布式计算系统,已成为处理大规模数据集的工业标准。在本小节中,我们将介绍如何安装与设置Anaconda与Spark环境。

首先,确保您的系统已经安装了Java,因为Spark依赖于Java运行环境。可以通过以下命令安装Java:

```bash

# 安装Java

sudo apt-get update

sudo apt-get install openjdk-8-jdk

```

接下来,安装Anaconda。Anaconda是一个基于Python的数据科学平台,它包含了成千上万个科学计算软件包。以下是在Ubuntu系统中安装Anaconda的步骤:

```bash

# 下载Anaconda安装脚本

wget https://repo.anaconda.com/archive/Anaconda3-2022.10-Linux-x86_64.sh

# 运行安装脚本

bash Anaconda3-2022.10-Linux-x86_64.sh

```

完成安装后,重启终端或者在当前终端执行`source ~/.bashrc`来激活conda。

然后,下载并安装

0

0