Python数据清洗:9个最佳实践让新手快速上手

发布时间: 2024-12-07 05:24:00 阅读量: 16 订阅数: 14

# 1. 数据清洗的必要性和方法概述

在当今信息爆炸的时代,数据无处不在。然而,数据的质量直接关系到其分析结果的准确性与可靠性。因此,数据清洗,作为优化数据质量、提升数据价值的必要步骤,显得尤为关键。数据清洗的目的是为了消除数据中的错误和不一致性,确保数据的完整性、准确性和一致性,从而提高数据挖掘和分析的效率和质量。

数据清洗的方法多种多样,从简单的数据类型转换到复杂的数据校验与数据重塑,每一步都要求数据分析者具备高度的专业技能。接下来的章节将会介绍数据清洗的目标和重要性、常规步骤、以及理论框架等关键概念,为后续深入探讨Python数据清洗技巧和工具打下坚实的基础。

# 2. 理解数据清洗的基本理论

## 2.1 数据清洗的目标与重要性

### 2.1.1 数据质量对分析的影响

数据质量是数据分析和机器学习模型结果准确性的基石。在没有正确理解数据清洗的重要性之前,我们可能会忽视数据在原始状态下的缺陷。不准确、不完整或格式不当的数据可以导致错误的分析结果,这些结果可能会误导决策者做出不正确的商业决策,甚至影响到整个业务策略的制定。

数据清洗的目标就是识别并纠正或删除数据集中的错误和不一致,保证数据质量,从而提高数据分析和数据挖掘任务的准确性。

### 2.1.2 数据清洗的角色和好处

数据清洗的角色主要体现在以下几个方面:

- **提高数据质量**:通过处理缺失值、异常值和重复数据,确保数据集中包含的信息准确无误。

- **提升分析效率**:准确且干净的数据可以降低处理过程中的时间成本和资源浪费。

- **强化决策支持**:清洁的数据支持生成可靠报告和预测,为科学决策提供有效支持。

- **保障模型性能**:在机器学习任务中,数据清洗是提高模型准确度和稳定性的关键步骤。

数据清洗的好处显而易见,但实际操作中需要掌握一定的理论知识和实践经验,才能有效地进行数据清洗。

## 2.2 数据清洗的常规步骤

### 2.2.1 数据预处理的基本流程

在进行数据清洗之前,必须了解数据预处理的基本流程,这通常是迭代的,并涉及以下步骤:

1. **数据集成**:从不同数据源搜集数据,将它们整合为单一的、一致的数据存储。

2. **数据选择**:根据分析目标,挑选出相关数据子集。

3. **数据清洗**:执行上述提到的数据清洗操作,包括处理缺失值、异常值等。

4. **数据转换**:转换数据格式,以适应分析工具的需求。

5. **数据归约**:减小数据集规模,同时保持数据完整性。

这个流程不是线性的,可能需要多次循环,以达到预期的数据质量。

### 2.2.2 数据集中的常见问题及分类

数据集可能包含以下常见问题,它们通常可以被分类为以下类型:

- **数据不一致性**:例如,同一个人的名字在不同的记录中有不同的写法。

- **数据不完整性**:一些记录可能缺少重要信息。

- **数据重复**:数据集中包含重复的记录。

- **噪声数据**:数据中包含随机误差或偏差。

- **异常值**:由于错误或罕见事件导致的不符合常规的数据点。

这些分类有助于我们系统地对数据问题进行识别和处理。

## 2.3 数据清洗的理论框架

### 2.3.1 数据清洗流程图的构建

构建数据清洗流程图是为了可视化和标准化数据清洗过程。这有助于开发者、分析师和数据科学家理解每个步骤的目的,以及它们如何相互关联。流程图通常包括以下组件:

- **输入**:原始数据源。

- **处理步骤**:清洗操作的具体活动。

- **输出**:清洗后的数据。

使用mermaid流程图,我们能绘制出一个基本的数据清洗流程图,如下所示:

```mermaid

graph LR

A[开始] --> B[识别数据问题]

B --> C[处理缺失值]

B --> D[处理异常值]

B --> E[处理重复数据]

C --> F[统一数据格式]

D --> F

E --> F

F --> G[数据转换]

G --> H[数据归约]

H --> I[最终数据输出]

I --> J[结束]

```

### 2.3.2 理论到实践的转化策略

从理论到实践的转化需要以下几个步骤:

1. **理解数据**:在清洗之前,要先了解数据集的特点和内容。

2. **策略选择**:根据数据集的特点,选择合适的数据清洗策略。

3. **工具应用**:使用诸如Pandas、NumPy等工具来实际操作数据。

4. **效果验证**:通过统计分析和可视化手段检验数据清洗的效果。

5. **迭代改进**:根据验证结果,不断迭代改进数据清洗策略。

这个转化过程需要反复进行,直到满足分析或模型训练的需要。

第二章已经介绍了数据清洗的基本理论,为数据清洗的实践应用奠定了理论基础。在下一章中,我们将详细探讨Python在数据清洗中的应用,以及如何通过Python进行数据清洗的具体技术实现。

# 3. Python在数据清洗中的实践应用

## 3.1 Python数据清洗的基础库和工具

### 3.1.1 Pandas库的安装与基本操作

Pandas是一个功能强大的Python数据分析库,提供了易于使用的数据结构和数据分析工具。在数据清洗中,Pandas通过提供快速、灵活和表达式丰富的数据结构,专门设计为方便操作结构化(表格、多维、异质)和时间序列数据。

安装Pandas库非常简单,使用pip命令即可完成安装:

```bash

pip install pandas

```

安装完成后,Pandas库中最重要的数据结构是DataFrame,可以理解为一个表格,是二维的、大小可变的、潜在异质型的表格型数据结构。我们通过一个简单的例子来展示如何创建一个DataFrame并进行基本操作:

```python

import pandas as pd

# 创建一个DataFrame

data = {'Name': ['Tom', 'Nick', 'John', 'Harry'],

'Age': [20, 21, 19, 18],

'City': ['New York', 'Los Angeles', 'Chicago', 'Houston']}

df = pd.DataFrame(data)

# 查看前5行数据

print(df.head())

# 查找特定列的数据

print(df['Name'])

# 基于条件的筛选

print(df[df['Age'] > 20])

# 添加一列新数据

df['Salary'] = [50000, 55000, 48000, 49000]

print(df)

# 删除一列数据

df = df.drop('Salary', axis=1)

print(df)

```

通过上述代码,我们创建了一个包含名字、年龄和城市的DataFrame,并演示了如何进行查看、筛选、添加和删除列等操作。Pandas还提供了丰富的方法和函数,能够高效完成数据的清洗工作。

### 3.1.2 NumPy库在数据处理中的作用

NumPy是Python中用于科学计算的核心库。它提供了高性能的多维数组对象和这些数组的操作工具。虽然在数据清洗的某些方面Pandas已经足够强大,但在处理数值计算密集型任务时,NumPy提供的方法会更加高效。

安装NumPy库:

```bash

pip install numpy

```

NumPy数组比Python标准的列表更加高效,因为它们在内存中是连续存储的。这使得NumPy在执行数学运算时能够利用现代CPU中的SIMD(单指令多数据)指令集。下面是一个简单的NumPy操作示例:

```python

import numpy as np

# 创建一个一维的NumPy数组

array = np.array([1, 2, 3, 4, 5])

# 创建一个二维的NumPy数组

matrix = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 数组的基本运算

print(array + 2) # 数组内每个元素加2

# 矩阵乘法

print(np.dot(matrix, matrix.T)) # 矩阵和它的转置相乘

# 计算矩阵中非零元素的数量

print(np.count_nonzero(matrix))

```

NumPy是数据预处理的基础,特别是在进行大规模数据处理时,使用NumPy可以大幅度提高效率。在Pandas中,底层很多操作也是基于NumPy来实现的,因此熟悉NumPy对于使用Pandas进行数据清洗是非常有帮助的。

## 3.2 数据清洗的具体技术实现

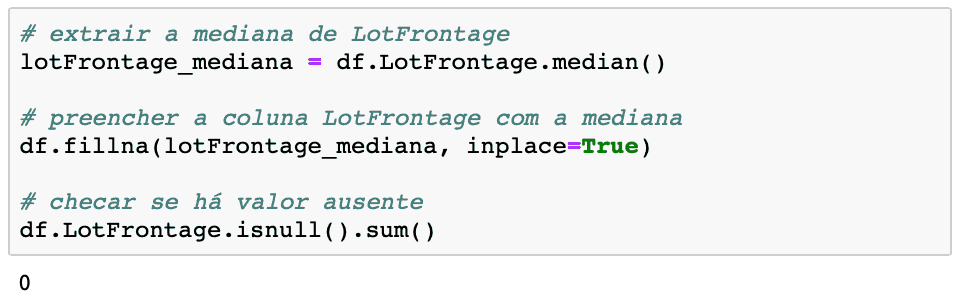

### 3.2.1 缺失值的处理方法

数据集中存在缺失值是一种常见的现象,处理缺失值是数据清洗中重要的一步。在Pandas中,我们可以使用一系列方法来检测和处理缺失值。

首先,我们通过一个实例数据集来演示如何识别和处理缺失值:

```python

import pandas as pd

# 创建一个包含缺失值的DataFrame

data = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, None, 8],

'C': [9, 10, None, 12]

})

# 查找缺失值

print(data.isnull())

# 删除包含缺失值的行或列

print(data.dropna()) # 删除包含缺失值的行

print(data.dropna(axis=1)) # 删除包含缺失值的列

# 填充缺失值

data_filled = data.fillna(0) # 用0填充缺失值

print(data_filled)

```

在处理缺失值时,选择删除数据还是填充数据取决于数据的特性和缺失值的数量。如果数据集很大且缺失值不多,可以选择删除缺失值的行或列;如果缺失值较多,通常使用统计方法(如均值、中位数、众数)或者使用特定值(如0)进行填充。

### 3.2.2 异常值的检测与处理

异常值是指数据中与其它数据点显著不同的值。这些值可能由测量误差、输入错误、或真正的异常事件引起。在数据清洗中,我们需要检测并处理这些异常值。

检测异常值通常可以使用标准差、四分位数范围(IQR)等统计技术。下面的代码展示了如何使用IQR检测和处理异常值:

```python

import pandas as pd

# 创建一个包含异常值的DataFrame

data = pd.DataFrame({

'A': [1, 2, 3, 100, 5]

})

# 使用IQR检测异常值

Q1 = data.quantile(0.25)

Q3 = data.quantile(0.75)

IQR = Q3 - Q1

# 找到异常值

outliers = (data < (Q1 - 1.5 * IQR)) | (data > (Q3 + 1.5 * IQR))

# 处理异常值

data_clean = data[~outliers['A']]

print(data_clean)

```

处理异常值的方法包括:将其设置为缺失值后进行填充、将其设置为某一统计量(如均值、中位数)或直接删除含有异常值的数据点。选择哪种方法取决于数据特性和分析需求。

### 3.2.3 数据格式的统一和转换

数据格式的统一和转换是确保数据整洁、一致的重要步骤。它包括统一日期时间格式、文本大小写、数值格式等。Pandas提供了大量的函数和方法来帮助我们完成这些转换。

下面展示如何将日期时间字符串统一转换为标准日期时间格式:

```python

import pandas as pd

# 创建一个包含不同日期格式的DataFrame

data = pd.DataFrame({

'Date': ['01-01-2021', '2021-01-01', 'January 1st, 2021']

})

# 使用Pandas的to_datetime函数转换日期格式

data['Date'] = pd.to_datetime(data['Date'], errors='coerce')

print(data)

# 设置日期为DataFrame的索引

data.set_index('Date', inplace=True)

print(data)

```

在这个示例中,我们首先使用`pd.to_datetime()`函数将不同格式的日期字符串统一转换成标准的日期时间格式。`errors='coerce'`参数会在转换失败时设置为NaT(Not a Time),这允许我们处理非标准或错误的日期格式。然后,我们将日期设置为DataFrame的索引,有助于后续的数据分析和处理。

在数据格式转换时,需要特别注意数据类型的一致性和数据的准确性。不同数据类型之间进行运算前,必须保证它们的一致性,否则可能会引发错误。

## 3.3 实际案例分析

### 3.3.1 从真实数据集出发

为了深入理解数据清洗在实际场景中的应用,我们可以使用一个真实的数据集进行演示。这里我们以一个关于客户信息的数据集为例,演示如何应用上述方法进行数据清洗。

首先,我们需要加载数据集并进行初步的探索:

```python

import pandas as pd

# 加载数据集

df = pd.read_csv('customer_data.csv')

# 初步探索数据集

print(df.head())

print(df.info())

```

通过`df.head()`和`df.info()`我们可以快速了解数据集的结构和数据类型,并查看前几行数据。

接下来,我们可以按照以下步骤进行数据清洗:

1. 缺失值处理

2. 异常值处理

3. 数据类型转换

4. 数据格式统一

### 3.3.2 数据清洗前后对比分析

进行数据清洗后,我们可以比较清洗前后的数据集,查看数据清洗的效果。

```python

# 数据清洗前

print(df.describe())

# 数据清洗后

df_cleaned = df.dropna().drop_duplicates()

df_cleaned = df_cleaned[df_cleaned['Age'] < 100] # 假设年龄不应该超过100岁

# 查看清洗后数据集的描述统计信息

print(df_cleaned.describe())

```

通过上述代码,我们首先进行了简单的统计分析,查看了数据集中数值型数据的分布情况。然后,我们删除了缺失值和重复行,并排除了异常的年龄值。再次运行描述统计,可以看到数据集更加整洁,统计结果也更加可靠。

通过对比分析,我们可以清晰地看到数据清洗对提升数据质量的重要性。清洗后的数据更适合进行数据分析和建模,可以显著提高后续分析任务的准确性和效率。

# 4. 高级数据清洗技巧和最佳实践

## 4.1 使用正则表达式进行文本清洗

正则表达式,也被称为“regex”,是处理文本和数据的有力工具,特别是在数据清洗过程中处理各种不规则的字符串。通过正则表达式,我们可以轻易地识别和匹配特定的文本模式,进行有效的文本提取和替换操作。

### 4.1.1 正则表达式的基础应用

正则表达式的构成由普通字符(如字母和数字)以及特殊字符(称为“元字符”)组成。这些元字符在正则表达式中具有特殊的含义,例如:`.`、`*`、`?`、`+`、`^`、`$`、`{}`、`[]` 和 `()` 等。

#### 示例代码

```python

import re

# 定义一个待清洗的文本字符串

text = "This is a sample string with several numbers: 1, 2, 3, and 4."

# 使用正则表达式来查找文本中的所有数字

numbers = re.findall(r'\d+', text)

print(numbers)

```

#### 参数说明与逻辑分析

在上面的代码段中,`re.findall` 函数用于找到文本中所有匹配正则表达式 `\d+` 的部分。`\d` 是一个特殊的字符类,用来匹配任何数字,而 `+` 是一个量词,表示匹配一个或多个前面的字符(在本例中为数字)。因此 `\d+` 匹配一个或多个连续数字的序列。

### 4.1.2 实战:从复杂文本中提取所需数据

假定我们有以下包含日期和时间信息的字符串,需要从中提取出具体的时间信息。

#### 示例代码

```python

import re

text = "Event on 2023-03-14 at 15:30:00"

# 使用正则表达式提取日期和时间

date_match = re.search(r'(\d{4}-\d{2}-\d{2})\s+at\s+(\d{2}:\d{2}:\d{2})', text)

if date_match:

date = date_match.group(1)

time = date_match.group(2)

print(f"Date: {date}, Time: {time}")

```

#### 参数说明与逻辑分析

在 `re.search` 函数中,我们使用了一个正则表达式,其包含两组括号用于分组匹配特定的日期和时间。`\d{4}` 表示匹配四位数字(年),`\d{2}` 表示匹配两位数字(月和日),`\s+` 匹配一个或多个空白字符,`at` 是我们想要匹配的固定文本。使用 `group(1)` 和 `group(2)` 是为了获取匹配的特定分组数据。

## 4.2 数据整合和特征工程

数据整合和特征工程是数据清洗过程中的高级步骤,它涉及到多数据源的合并以及在数据分析前对特征进行选择和构造。

### 4.2.1 多数据源合并的技巧

整合来自不同数据源的数据是数据分析中常见的需求。在进行数据合并时,我们需要解决不同数据源之间的对齐问题,常见的方法包括基于索引的合并和基于某些共同键值的合并。

#### 示例代码

```python

import pandas as pd

# 创建两个示例数据集

df1 = pd.DataFrame({

'ID': [1, 2, 3],

'Name': ['Alice', 'Bob', 'Charlie'],

'Data1': [100, 200, 300]

})

df2 = pd.DataFrame({

'ID': [2, 3, 4],

'Name': ['Bob', 'Charlie', 'David'],

'Data2': [100, 200, 300]

})

# 使用merge函数合并数据

merged_df = pd.merge(df1, df2, on='ID', how='inner')

print(merged_df)

```

#### 参数说明与逻辑分析

在此代码中,`pd.merge` 函数用于合并两个DataFrame对象。`on='ID'` 参数指定了两个DataFrame合并的键值列,而 `how='inner'` 参数指定了合并的方式,即内连接(只合并那些在两个数据集中都存在的键值)。

### 4.2.2 特征选择和构造的策略

特征选择是指从现有特征中选择对预测模型最有贡献的特征,这可以提高模型的预测性能并降低过拟合的风险。而特征构造则是通过已有特征的组合和转换创建新的特征。

#### 示例代码

```python

import numpy as np

# 假设有一个包含特征和标签的数据集

X = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

y = np.array([0, 1, 0])

# 构造新的特征,例如将第一和第二个特征相加

X_new_feature = X[:, 0] + X[:, 1]

# 现在数据集X有了新的特征维度

X_new = np.hstack((X, X_new_feature[:, np.newaxis]))

print(X_new)

```

#### 参数说明与逻辑分析

上述代码中,我们首先创建了一个简单的数据集 `X` 和对应的标签 `y`。接着,我们构造了一个新特征,即将数据集中的第一和第二个特征相加。使用 `np.hstack` 函数,我们将新特征作为一列添加到原始特征集中,形成了一个新的数据集 `X_new`。

## 4.3 数据清洗的自动化与监控

随着数据量的增加,数据清洗的过程需要自动化和监控来确保数据的质量和一致性。

### 4.3.1 数据清洗流程的自动化实现

自动化数据清洗流程可以使用脚本和调度工具实现,以提高数据处理的效率和可靠性。

#### 示例代码

```python

import pandas as pd

from datetime import datetime

# 假设我们需要每天清洗一次数据文件

def automate_data_cleaning(input_file_path, output_file_path):

# 读取数据

df = pd.read_csv(input_file_path)

# 执行数据清洗步骤,例如处理缺失值

df.fillna(method='ffill', inplace=True)

# 转换时间格式

df['Date'] = pd.to_datetime(df['Date'])

# 保存清洗后的数据

df.to_csv(output_file_path, index=False)

print(f"Data cleaning and saving complete at {datetime.now()}")

# 设置输入输出文件路径

input_file = "data_input.csv"

output_file = "data_cleaned.csv"

# 调用自动化清洗函数

automate_data_cleaning(input_file, output_file)

```

#### 参数说明与逻辑分析

在上面的示例中,我们创建了一个函数 `automate_data_cleaning`,该函数读取一个CSV文件,执行数据清洗操作,并保存清洗后的数据。通过设置一个固定的输入和输出路径,并在需要的时候调用这个函数,可以实现数据清洗流程的自动化。

### 4.3.2 监控数据清洗过程中的关键指标

监控数据清洗过程可以帮助我们及时发现并解决问题,确保数据清洗的质量。关键指标可能包括清洗时间、清洗前后的数据量变化、以及特殊问题的出现频率等。

#### 示例代码

```python

# 记录数据清洗前后的数据量

initial_count = len(df)

cleaned_count = len(df.dropna())

# 计算清洗效率

efficiency = cleaned_count / initial_count * 100

# 记录清洗所消耗的时间

start_time = datetime.now()

# 假设这是数据清洗的函数

clean_data(df)

end_time = datetime.now()

# 计算消耗时间

cleaning_time = (end_time - start_time).total_seconds()

# 打印关键指标

print(f"Data cleaning efficiency: {efficiency:.2f}%, Data cleaning time: {cleaning_time:.2f} seconds.")

```

#### 参数说明与逻辑分析

在上述代码段中,我们计算了数据清洗的效率,即清洗后数据量与原始数据量的百分比,以及数据清洗操作的总耗时。这些关键指标能帮助我们评估清洗过程的性能和资源消耗。通过定期监控这些指标,我们可以在问题初现时就采取相应的措施。

通过以上章节的内容,我们已经逐步深入了高级数据清洗技巧和最佳实践的多个方面。从文本的正则表达式清洗,到数据整合和特征工程的高级应用,再到自动化数据清洗流程的实现与监控,这些内容均是数据处理领域的重要组成部分,对于任何希望在数据科学和工程方面进一步提升的IT从业者来说都是必修课程。

# 5. Python数据清洗工具的拓展应用

在当今的数据驱动世界,数据清洗已经成为数据分析、机器学习和人工智能等领域的基石。Python作为一门强大的编程语言,提供了众多用于数据处理的工具和库,如Pandas、NumPy、SciPy等。本章将深入探讨Python数据清洗工具的拓展应用,并比较这些工具在不同场景下的使用。

## 5.1 数据清洗工具的比较与选择

在进行数据清洗时,选择合适的工具至关重要。不同的工具可能在功能、性能和易用性上有很大的不同。本节将探讨如何比较和选择最合适的Python数据清洗工具。

### 5.1.1 常见Python清洗工具的功能对比

Python社区提供了多个用于数据清洗的工具,其中最流行的包括:

- **Pandas**: 以表格的形式处理数据,拥有强大的数据结构DataFrame,支持多种数据源和格式,擅长处理时间序列数据。

- **NumPy**: 在数值计算领域拥有优势,其数组结构在处理大规模数值数据时表现出色,适用于科学计算。

- **SciPy**: 为科学计算提供了一系列功能强大的函数库,常用于图像处理和信号处理等高级数据清洗任务。

- **Scikit-learn**: 主要用于机器学习,但其预处理模块也可以用于数据清洗。

以下是这些工具在数据清洗功能上的一些对比表格:

| 工具 | 数据结构支持 | 处理速度 | 数据源支持 | 其他特性 |

|-----------|--------------|----------|------------|----------------------------|

| Pandas | DataFrame | 较快 | 多样 | 时间序列、缺失值处理等 |

| NumPy | 数组 | 非常快 | 主要是数值 | 数值计算效率高 |

| SciPy | 多样 | 快 | 多样 | 高级数学计算和信号处理 |

| Scikit-learn | 数组/矩阵 | 快 | 多样 | 提供了预处理和机器学习算法 |

### 5.1.2 选择合适工具的决策因素

选择合适的Python数据清洗工具应考虑以下因素:

- **数据类型**:是否处理的是数值型数据、时间序列数据、文本数据等。

- **数据量大小**:不同的工具在处理大规模数据时的效率和能力各不相同。

- **功能需求**:是否需要进行复杂的数据转换、特征工程等。

- **性能需求**:对数据处理速度的要求如何,是否需要并行计算等。

- **易用性**:代码编写和维护的难易程度,是否有大量的使用文档和社区支持。

决策树的mermaid流程图如下:

```mermaid

graph TD

A[开始选择工具] --> B[数据类型判断]

B -->|数值型| C[选择NumPy]

B -->|时间序列| D[选择Pandas]

B -->|文本型| E[选择Scikit-learn]

B -->|复杂结构| F[选择SciPy]

C --> G[考虑其他因素]

D --> G

E --> G

F --> G

G -->|数据量小| H[简单场景工具]

G -->|数据量大| I[大数据处理工具]

H --> J[最终选择]

I --> J

J --> K[结束选择过程]

```

## 5.2 集成数据清洗与分析工作流

集成数据清洗与分析流程不仅能够提高工作效率,而且还能保持数据处理的连贯性和一致性。本节将讨论如何构建端到端的数据处理工作流,并结合数据分析库进行高级应用。

### 5.2.1 构建端到端的数据处理工作流

构建端到端的数据处理工作流通常包括以下步骤:

1. **数据导入**:将数据从各种来源导入到工作环境中。

2. **初步检查**:分析数据的基本统计信息,检查数据类型和数据量。

3. **数据清洗**:处理缺失值、异常值、重复记录,以及数据格式和类型的转换。

4. **数据转换**:进行数据的归一化、标准化或其他形式的转换以满足分析需求。

5. **特征工程**:根据分析目标构造或选择特征。

6. **数据分析**:利用统计方法和机器学习模型进行数据分析。

7. **结果输出**:将处理后的数据和分析结果导出到文件、数据库或可视化工具。

### 5.2.2 结合数据分析库的高级应用

在数据清洗完成后,通常需要进行数据分析或应用机器学习模型。在这个环节,可以将清洗后的数据与如Scikit-learn、TensorFlow、PyTorch等库结合进行进一步的分析和应用。

例如,使用Scikit-learn进行数据分析的步骤可能如下:

```python

from sklearn.preprocessing import StandardScaler

from sklearn.decomposition import PCA

from sklearn.cluster import KMeans

# 假设data_cleaned是已经清洗好的数据集

X = data_cleaned[['feature1', 'feature2', 'feature3']] # 选择部分特征

# 数据标准化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# PCA降维

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X_scaled)

# 聚类分析

kmeans = KMeans(n_clusters=3)

clusters = kmeans.fit_predict(X_pca)

# 将聚类结果添加到原始数据中进行分析

data_cleaned['cluster'] = clusters

```

以上步骤展示了如何将清洗后的数据进行标准化处理,进行降维,并执行聚类分析。每个步骤的逻辑和参数将在代码块后进行详细说明。

在本章中,我们详细探讨了Python数据清洗工具的拓展应用,比较了不同工具的优劣,并通过构建端到端的数据处理工作流和结合高级数据分析库的应用,展示了一个数据清洗到分析的完整流程。这些内容旨在为读者提供一套系统的数据清洗方法论,以适应各种数据分析和机器学习的实际应用需求。

# 6. 数据清洗的挑战与未来展望

随着信息技术的飞速发展,大数据分析已经深入到了我们生活的方方面面。然而,在享受大数据带来的便利的同时,数据质量问题也日益凸显,特别是在处理大规模数据集时。数据清洗作为解决数据质量问题的重要手段,其在实际应用中面临了诸多挑战,同时也孕育着未来的发展机遇。

## 6.1 面临的挑战与应对策略

### 6.1.1 大数据环境下的数据清洗问题

在大数据环境下,数据清洗面临着前所未有的挑战。首先是数据量的问题。现代企业每天都会产生和收集海量的数据,如何在保证数据清洗质量的同时,有效地处理这些数据,是一个亟待解决的问题。此外,数据类型的多样性也是一个挑战。数据不仅有结构化的数字和文字,还有半结构化的日志文件,甚至是无结构的图像和视频等。数据清洗工具和方法需要能够适应不同类型的数据源。

### 6.1.2 解决方案与最佳实践

为了应对大数据环境下的数据清洗挑战,我们可以采取如下策略:

- **分布式数据清洗**:利用分布式计算框架如Apache Hadoop或Apache Spark进行数据清洗,可以有效处理大规模数据集。

- **机器学习辅助清洗**:引入机器学习算法,对数据模式进行学习,自动识别并处理异常值和缺失值。

- **标准化和自动化**:通过标准化的数据清洗流程和自动化工具,提高清洗效率,减少人为错误。

## 6.2 数据清洗的未来发展趋势

### 6.2.1 人工智能在数据清洗中的应用前景

人工智能(AI)技术正在逐步改变数据清洗领域。通过训练机器学习模型,我们可以使机器能够识别数据中的模式和异常,自主完成数据清洗的任务。这不仅能够大幅减少人工干预,而且能够处理更复杂的数据清洗问题。例如,深度学习算法在图像和语音数据清洗中已经展现出巨大潜力。

### 6.2.2 开源社区对数据清洗的影响

开源社区在推动数据清洗技术发展方面起到了至关重要的作用。许多开源的数据清洗工具和库,如Apache NiFi、Talend和Pandas等,都拥有活跃的社区和不断更新的资源,使得数据清洗技术能够迅速迭代和优化。此外,开源精神还鼓励了技术创新,为数据清洗领域带来了更多可能性。

在未来的数据清洗领域中,我们可以预见人工智能与开源社区将发挥更大的作用,推动数据清洗技术不断向前发展。而挑战与机遇并存,数据清洗将继续在信息时代扮演不可或缺的角色。

0

0