【工作流程与效率】:Anaconda环境集成外部数据源的优化策略

发布时间: 2024-12-10 01:45:47 阅读量: 7 订阅数: 11

python数据分析师带配套开发环境和工具

# 1. Anaconda环境与外部数据源集成概述

Anaconda是当今IT领域和数据科学中使用最广泛的Python发行版之一,它提供了一个集成的环境,可以方便地进行数据分析、科学计算等任务。在这一章中,我们将概述Anaconda环境如何与外部数据源集成,为后续章节中更深入的技术讨论和实践操作打下基础。

## 1.1 Anaconda环境概览

Anaconda提供了一个包含数百个科学包的分发版,它使用conda作为包管理器,并允许用户创建和管理多个独立的环境。这种环境管理方式使得开发者可以在不同的项目间切换,而不用担心包版本冲突的问题。

## 1.2 数据集成的必要性

数据集成是数据分析、机器学习和人工智能等领域不可或缺的一部分。它涉及从不同的源中提取数据,将数据转换成统一的格式,并加载到一个目标系统中。在Anaconda环境中集成外部数据源,不仅可以提高开发效率,还能通过优化数据处理流程来增强数据处理能力。

## 1.3 集成外部数据源的挑战

尽管Anaconda已经提供了强大的数据处理能力,但与外部数据源集成时仍面临着一些挑战。这包括但不限于数据格式的不一致性、数据质量和完整性的检查、以及性能优化等问题。在后续章节中,我们将详细介绍如何克服这些挑战,并使用Anaconda来高效地集成外部数据源。

# 2. 理论基础 - 数据源集成的技术原理

### 2.1 数据集成的定义与重要性

#### 2.1.1 理解数据集成的基本概念

数据集成是将不同来源、格式、特点的数据在逻辑上或物理上有机地结合在一起,形成一个统一且一致的数据视图的过程。这个过程在数据仓库构建、大数据分析、业务智能(BI)以及其他需要跨数据源操作的场景中至关重要。数据集成的目标是确保数据的可访问性、一致性、准确性和时效性,以便为各种业务决策提供支持。

在技术层面,数据集成通常包括数据抽取、转换和加载(ETL)的操作。抽取指的是从源数据源获取数据的过程,转换涉及到清洗、校验、格式化等步骤,加载则是将转换后的数据存放到目标系统的过程。数据集成的挑战在于处理各种数据的异构性,如数据格式不一、数据质量参差不齐、数据更新频率不同等问题。

#### 2.1.2 数据集成在数据分析中的作用

在数据分析的语境下,数据集成是将分散在不同地方的数据集中起来,以形成一个统一的分析视图的基础工作。有效的数据集成能够提高数据处理效率,增强数据的可用性和价值。高质量的数据集成可以减少数据孤岛现象,避免因数据重复、冲突或不一致性而产生的错误决策。

数据集成还在数据挖掘、机器学习等领域发挥重要作用。它为算法模型提供了丰富的数据源,是训练准确预测模型的先决条件。此外,集成后的数据可以用于报告生成、监控指标、数据可视化等,从而在组织内实现数据驱动的文化。

### 2.2 数据源集成的常用技术

#### 2.2.1 ETL过程解析

ETL(抽取Extract、转换Transform、加载Load)是数据集成的核心过程。抽取是从各个数据源中获取数据,转换是对数据进行清洗、校验、格式化等处理,加载则是将数据放入数据仓库、数据湖或其他目标系统。

- **抽取**:抽取需要解决数据源异构性问题,如数据库类型、API接入、数据格式(CSV、JSON、XML等)等。

- **转换**:转换是数据集成中最复杂的部分,包括数据清洗、数据类型转换、数据标准化、缺失值处理、数据聚合和连接等操作。

- **加载**:加载阶段需考虑数据加载的效率和目标存储系统的特性,如批量加载和增量加载策略。

#### 2.2.2 数据集成工具和框架

数据集成工具和框架提供了可视化的操作界面和预定义的组件,以降低数据集成的复杂性。一些流行的数据集成工具包括Talend、Informatica、Pentaho等。而Apache NiFi、Apache Airflow等是开源的数据集成框架,提供灵活的管道管理。

选择合适的数据集成工具或框架需要考虑以下因素:

- 支持的源系统和目标系统的类型

- 集成的复杂性,即工具是否能够处理复杂的数据转换和业务规则

- 性能,包括处理数据的速度和可扩展性

- 系统的维护和易用性

- 成本,包括购买成本和运维成本

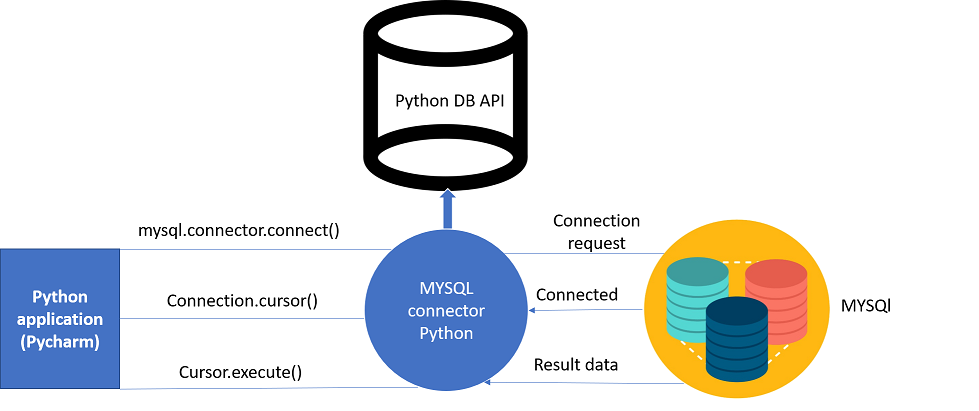

#### 2.2.3 数据库连接技术对比

数据库连接技术允许不同的数据库系统之间进行数据交换和集成。常用的数据库连接技术包括JDBC、ODBC、OLE DB和数据库连接器。

- **JDBC (Java Database Connectivity)**:允许Java应用连接和操作各种类型的数据库,遵循SQL标准,应用广泛。

- **ODBC (Open Database Connectivity)**:Microsoft开发的接口,支持多种编程语言和操作系统,但主要适用于Windows系统。

- **OLE DB**:Microsoft提供的底层数据库访问技术,支持多种数据源。

- **数据库连接器**:针对特定数据库提供的连接器,如PostgreSQL JDBC驱动或MySQL Connector/J。

每种技术都有其特定的使用场景和优势,选择时应考虑所用编程语言、数据库系统、性能要求等因素。

### 2.3 数据同步与转换机制

#### 2.3.1 数据同步的基本策略

数据同步是指保持两个或多个数据源内容一致的过程。同步策略主要分为全量同步和增量同步。

- **全量同步**:将所有数据从一个数据源复制到另一个数据源,适用于数据源首次同步或者数据源内容很少变化的情况。

- **增量同步**:只同步自上次同步以来发生变化的数据,提高了同步效率,适用于数据频繁变更的情况。

增量同步常用的策略包括基于时间戳的变更追踪、基于日志文件的变更捕获等。实施数据同步时需要考虑同步频率、同步一致性级别、网络带宽和同步中断的处理等问题。

#### 2.3.2 数据转换技术与工具

数据转换是对数据进行格式化、清洗、校验、转换等操作的过程。常见的数据转换技术包括数据映射、数据清洗规则应用、数据类型转换、复杂的数据转换函数等。

一些数据集成工具提供了可视化的设计界面来定义数据转换规则,例如在Talend中,用户可以通过拖拽组件和设置组件参数的方式来配置转换规则。还有一些数据集成框架提供了编程式的转换方法,比如Apache NiFi的FlowFile属性转换、JSONPath表达式等。

#### 2.3.3 数据质量保证方法

数据质量保证是指确保数据的准确、完整、一致和可靠的过程。数据质量的保障通常包括以下几个方面:

- **数据清洗**:移除或纠正数据中的错误和不一致性。

- **数据校验**:通过规则验证数据的有效性,如检查格式、范围、引用完整性等。

- **数据监控**:实时跟踪数据的质量状态,及时发现并处理数据质量问题。

- **数据治理**:制定数据治理政策和流程,确保数据的规范使用。

保障数据质量的工具包括数据质量检查工具、元数据管理工具和数据治理平台,例如Informatica的数据质量管理套件提供了复杂的数据清洗、校验和监控功能。

接下来的章节将探讨如何在实际环境中,使用Anaconda进行数据集成的操作方法和技巧,以及如何优化数据集成的性能。

# 3. 实践操作 - Anaconda环境下的数据集成方法

## 3.1 使用Anaconda管理包和环境

### 3.1.1 Anaconda包管理器的使用

Anaconda提供了一个强大的包管理器,称为conda,它使得安装、更新和管理Python包变得非常容易。conda不仅限于Python包,还支持包括R语言包在内的多种编程语言的包管理。在Anaconda环境下,我们可以利用conda来创建、保存和切换不同的开发环境,这对于数据集成项目至关重要。

首先,使用conda安装包的基本命令如下:

```bash

conda install package_name

```

此命令会安装最新的包版本到当前激活的环境中。如果要安装特定版本的包,可以使用:

```bash

conda install package_name=version

```

若要创建一个新的环境,可以使用以下命令:

```bash

conda create -n new_env_name package1 package2

```

该命令会创建一个名为`new_env_name`的新环境,并安装`package1`和`package2`。

### 3.1.2 创建和配置虚拟环境

创建虚拟环境是隔离项目依赖的有效手段。在数据集成项目中,不同的数据源可能会需要不同版本的库,使用虚拟环境可以避免版本冲突。

要激活或切换到一个环境,使用命令

0

0