Apache Hadoop:分布式计算与大文件系统详解

需积分: 10 132 浏览量

更新于2024-09-11

收藏 159KB DOCX 举报

Hadoop技术介绍

Hadoop是一个由Apache软件基金会开发的分布式系统基础架构,主要用于处理大规模数据集并支持高容错性和高数据传输速率。它的名字源于创建者Doug Cutting的儿子为一个棕色大象玩具取的名字,选择这个名字的标准是简短、易于发音和拼写,没有特定含义,以符合其简洁的设计初衷。

起源:

Hadoop最初是在2005年由Apache作为其Lucene项目(一个全文搜索引擎库)的子项目Nutch中被引入的。灵感来源于Google的两个关键技术:MapReduce,一种编程模型用于并行处理大量数据;以及Google File System (GFS),一个分布式文件系统。2006年,MapReduce和Nutch Distributed FileSystem (NDFS) 被整合到现在的Hadoop项目中,标志着其核心组件的形成。

Hadoop分布式架构:

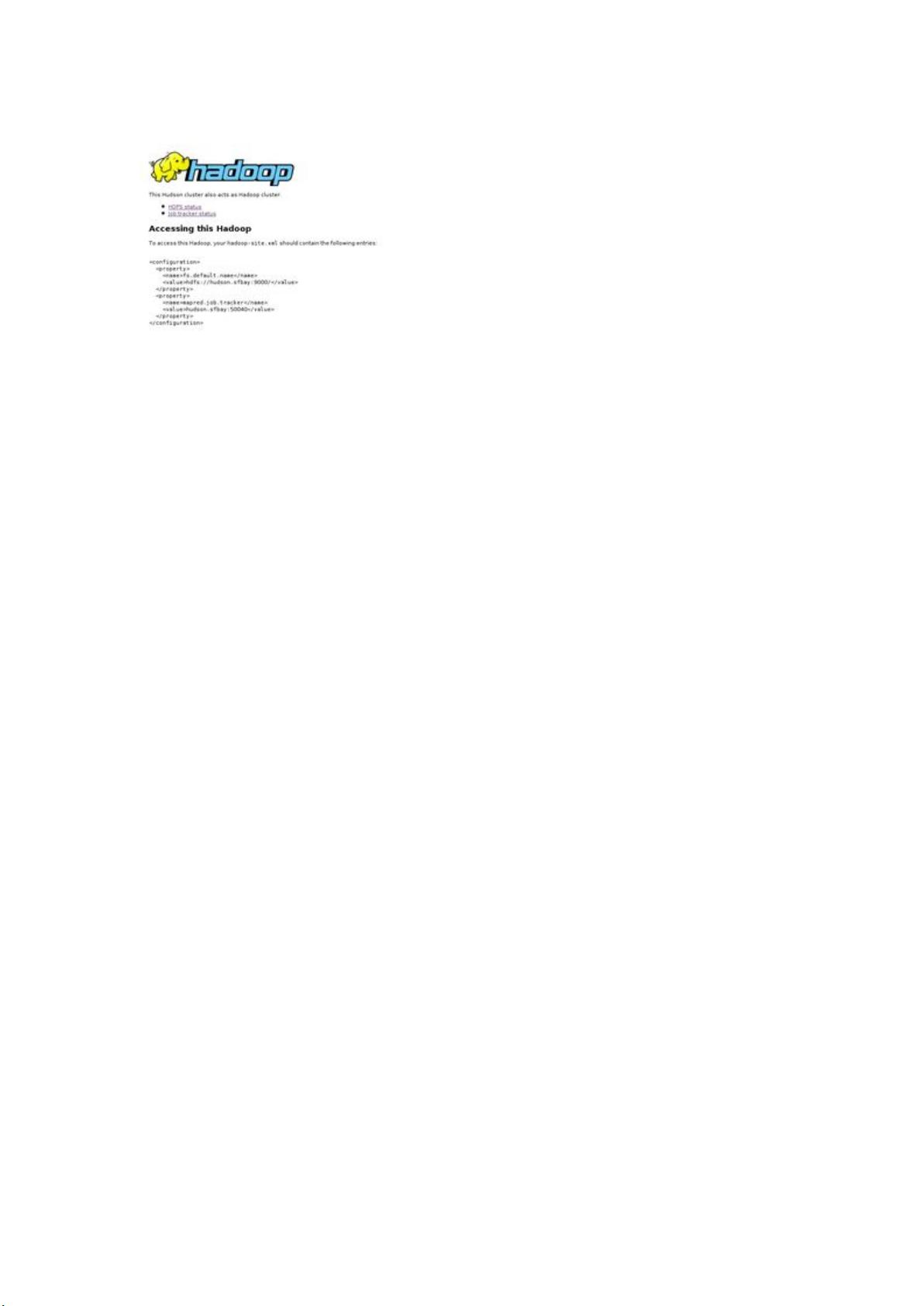

Hadoop的核心组件包括Hadoop Distributed File System (HDFS) 和 MapReduce。HDFS是一个高容错性、成本效益高的分布式文件系统,设计用于在廉价硬件上运行,并通过高吞吐量提供对大容量数据集的访问。它允许以流式方式访问文件系统,放宽了传统的POSIX要求。

HDFS组成部分:

1. NameNode: 是HDFS的名称节点,负责管理文件系统的命名空间和客户端的元数据。

2. DataNode: 存储实际的数据块,每个DataNode保存多个复制的数据块,确保数据的冗余和可靠性。

文件操作:

在Hadoop中,用户可以编写简单的Java程序执行各种文件操作,如读取、写入和删除文件,而无需关注底层的分布式细节。这些操作通常通过Hadoop API完成。

Linux集群与集群系统:

Hadoop适用于Linux集群环境,利用多台机器的计算和存储资源协同工作。集群系统包括主节点(Master)和工作节点(Worker),共同执行任务。

开源实现:

Hadoop的成功在于其开源性质,吸引了众多社区的贡献和支持。许多商业公司如Cloudera和Hortonworks提供了基于Hadoop的商业化产品和服务,以满足不同场景的需求。

子项目和研究:

除了核心的Hadoop,还有许多子项目和相关的研究,比如YARN(Yet Another Resource Negotiator)负责任务调度,HBase和Hive等提供不同的数据存储和查询方案。

EasyHadoop和认证:

EasyHadoop是一个简化Hadoop部署和管理的工具,而Cloudera和Hortonworks则提供企业级Hadoop平台的认证和培训。

Hadoop信息安全:

随着数据安全的重要性日益提升,Hadoop生态系统也发展了如Hadoop Security框架等组件,以保障数据的隐私和完整性。

总结:

Hadoop技术凭借其分布式处理能力、高可用性和成本效益,已经成为大数据处理领域的重要基石。无论是学术研究、企业数据分析还是云计算服务,Hadoop都发挥着不可或缺的作用。随着技术的不断演进,Hadoop生态系统仍在持续扩展和完善,以适应不断变化的IT需求。

2017-11-01 上传

2021-10-14 上传

2024-03-05 上传

2021-10-03 上传

2013-11-21 上传

2013-10-15 上传

2014-08-17 上传

mingxiao301

- 粉丝: 0

- 资源: 2

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析