优化Pandas内存使用:减少大数据集的内存占用

需积分: 34 29 浏览量

更新于2024-07-18

收藏 1.69MB PDF 举报

"本文将介绍如何使用pandas处理大数据时有效减少内存占用,通过选择合适的列数据类型,甚至可实现90%的内存节省。我们将使用一个包含130年美国职业棒球比赛记录的数据集作为示例进行讲解。"

在处理大数据时,pandas库是一个常用的选择,尤其在数据清洗、探索和分析方面。然而,当数据量超过100MB,性能问题和内存不足可能会成为挑战。虽然工具如Spark能处理更大的数据集(100GB到多个TB),但它们通常需要更强大的硬件,并且在数据预处理和探索方面没有pandas那样丰富的功能。

本文将关注如何优化pandas的内存使用,特别是对于中等大小的数据集。关键在于选择合适的数据类型,这能显著降低DataFrame的内存占用。例如,如果数据集中包含大量的整数,将它们从`int64`转换为`int32`或`uint32`可以节约一半的内存,因为这些类型占用的位数较少。同样,对于日期和时间数据,使用`datetime64[ns]`而不是`object`类型也可以大大节省空间。

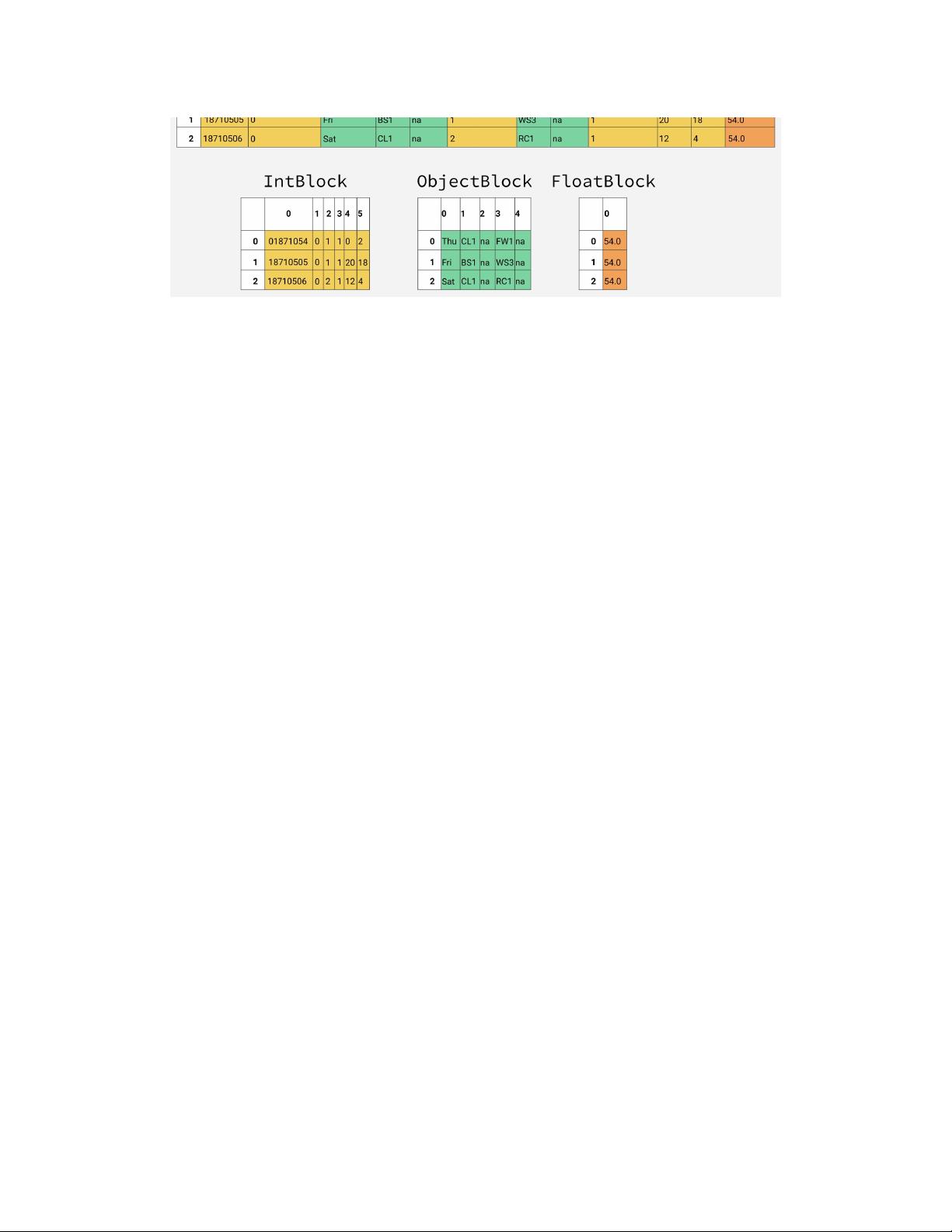

以130年的棒球比赛记录为例,这些数据最初来自Retrosheet,原始数据分布在127个CSV文件中。每个文件可能包含比赛详情、球员信息等,这些数据如果不做处理,可能会占用大量内存。通过读取数据并检查每列的数据类型,我们可以识别出哪些列可以转换为更节省内存的类型。

例如,如果比赛日期列当前是字符串类型(`object`),将其转换为日期时间类型(`datetime64[ns]`)可以大幅减小内存占用。对于只包含非负整数的计数列,如击打次数,将`int64`转换为`uint32`即可。此外,对于只包含有限选项的分类数据,如球员位置,可以使用`category`类型,这会用整数来表示类别,进一步节省内存。

除了数据类型转换,还可以通过以下方法优化内存使用:

1. **分块读取数据**:使用`pandas.read_csv()`的`chunksize`参数分块加载数据,这样可以在内存中一次处理一部分数据,而不是一次性加载所有数据。

2. **压缩存储**:设置DataFrame的`__index_level_0__`和`__index_level_1__`属性的`dtype`为`category`,并启用`compression`选项,如`'gzip'`或`'lz4'`,以压缩保存的数据。

3. **减少复制**:使用`inplace=True`参数修改原数据,避免创建新的DataFrame副本。

4. **删除无用的列**:在分析过程中,及时删除不再需要的列,以释放内存。

5. **使用稀疏数据结构**:对于大部分元素为零的矩阵,可以使用`SparseArray`或`SparseDataFrame`,它们仅存储非零值,从而节省大量内存。

通过这些策略,我们可以有效地管理和减少pandas处理大数据时的内存消耗,让分析过程更加高效。对于那些因内存限制而无法处理的大数据集,这些技巧可能是继续工作的关键。

2020-09-19 上传

2020-12-26 上传

2020-09-20 上传

2020-09-22 上传

2020-09-20 上传

2024-05-29 上传

2017-05-05 上传

点击了解资源详情

dmx302797897

- 粉丝: 0

- 资源: 5

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载