Hadoop入门指南:从安装到MapReduce实践

"深入学习Hadoop大数据处理的指南"

在大数据处理领域,Hadoop是一个至关重要的工具,它提供了处理海量数据的能力。本资源旨在帮助初学者快速深入地理解Hadoop的原理,通过简单易懂的方式介绍其工作模式。作者在多个平台上分享了相关教程,包括CSDN主页、豆瓣主页和新浪博客,方便读者进一步学习和交流。

首先,学习Hadoop的起点是安装。在开始之前,你需要一个合适的操作系统,通常选择Linux环境,因为Hadoop与开源社区的其他工具兼容性更好。接着,你需要了解不同版本的Hadoop,并根据需求选择合适的版本下载。安装过程中,Java JDK是必备的,因为Hadoop依赖Java运行。然后,按照指导安装Hadoop,包括配置环境变量、设置SSH和rsync,以便于集群通信。完成安装后,启动Hadoop服务并进行简单的测试,如运行Hadoop自带的示例程序,以确保系统正常运行。

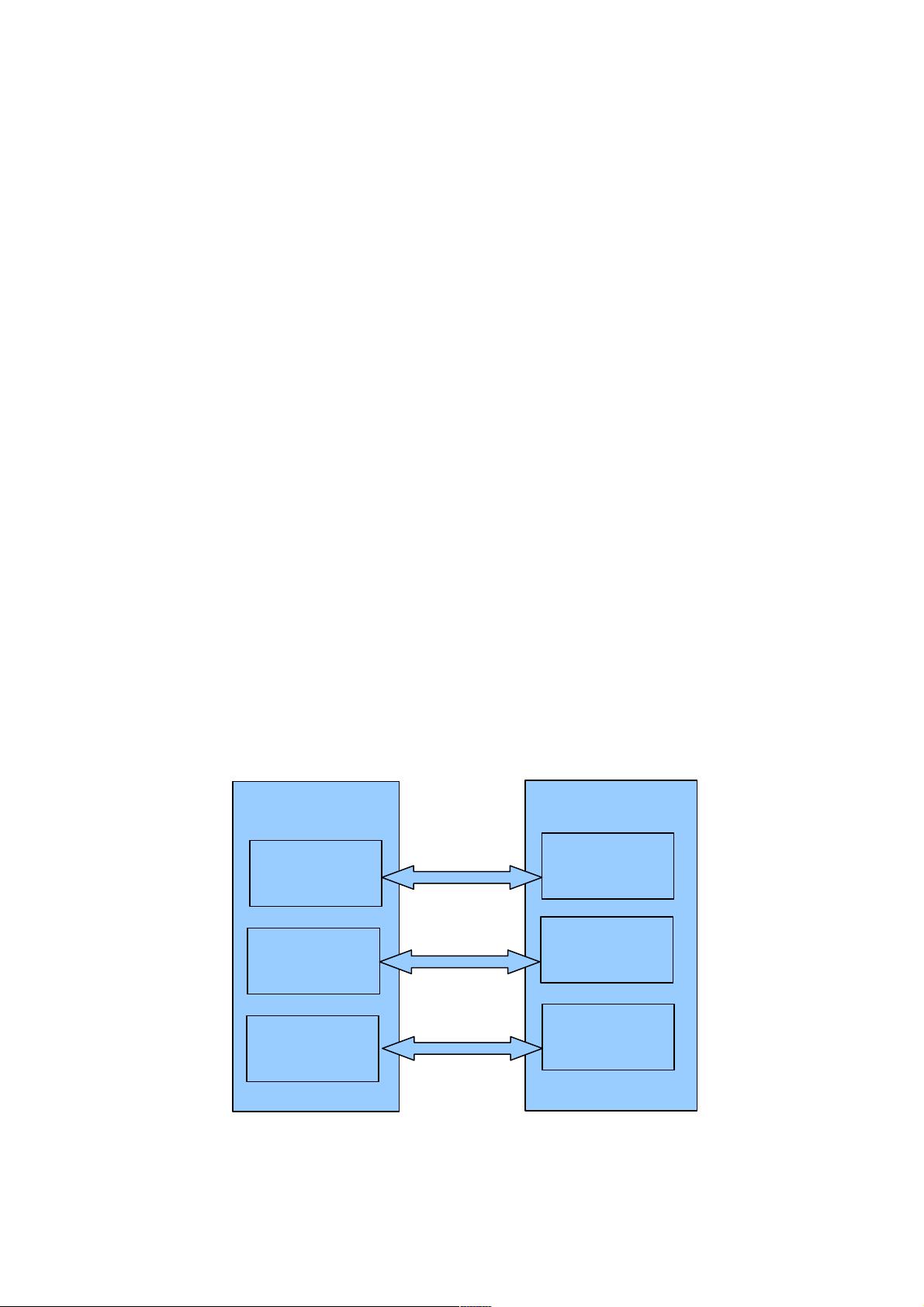

接下来,进入实际编程阶段,通过编写第一个MapReduce程序来理解Hadoop的核心概念。MapReduce是一种分布式计算模型,由Google提出,用于大规模数据集的并行处理。Hadoop将其实现,使得开发者可以编写处理大数据的程序。在这个过程中,你将学习到Map函数和Reduce函数的基本用法,以及如何统计词频作为实例。程序通常包含Mapper和Reducer两个阶段,通过编译、打包成JAR文件,然后提交到Hadoop集群执行,最后查看输出结果。

Hadoop分布式文件系统(HDFS)是Hadoop生态中的基石,提供高容错性和可扩展性的存储。文件系统从头说起,讲解了传统文件系统与HDFS的区别。在HDFS中,你可以将本地文件复制到分布式文件系统,这通过编写Java程序实现,包括定义文件路径、编写源代码、编译、打包和运行。此外,学习如何删除HDFS中的文件和读取文件内容同样重要,这些操作也是通过编写特定的Java程序完成的。

通过这个资源,你将能够掌握Hadoop的基本安装步骤,理解MapReduce的工作原理,以及如何在HDFS上进行基本的文件操作。这些知识对于从事大数据处理、数据分析和数据挖掘的人员来说至关重要,能够帮助他们构建处理大规模数据的基础。随着对Hadoop的深入理解和实践,你将能够应对更复杂的数据挑战,从而在大数据时代中发挥关键作用。

xiaoaikeke

- 粉丝: 0

- 资源: 9

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升