Apache Spark 2.0.2 中文编程与部署指南

需积分: 20 68 浏览量

更新于2024-07-15

收藏 4.23MB PDF 举报

"Apache Spark 2.0.2 中文文档.pdf 是由ApacheCN组织编译的一份详细指南,旨在帮助用户理解和使用Apache Spark 2.0.2版本。文档覆盖了Spark的各个方面,包括Spark的概述、编程指南、部署方法以及更多的进阶主题。"

Apache Spark是一个用于大规模数据处理的开源集群计算系统,它设计的目标是提供一个通用、快速且易用的平台。在Spark 2.0.2版本中,主要的知识点包括:

1. **Spark概述**:这部分介绍了Spark的基本概念,强调其核心特性,如内存计算、弹性、容错性和多工作负载支持。Spark支持多种编程语言,如Java、Scala、Python和R,以及它的关键组件,如Spark SQL、Spark Streaming、MLlib(机器学习库)和GraphX(图处理)。

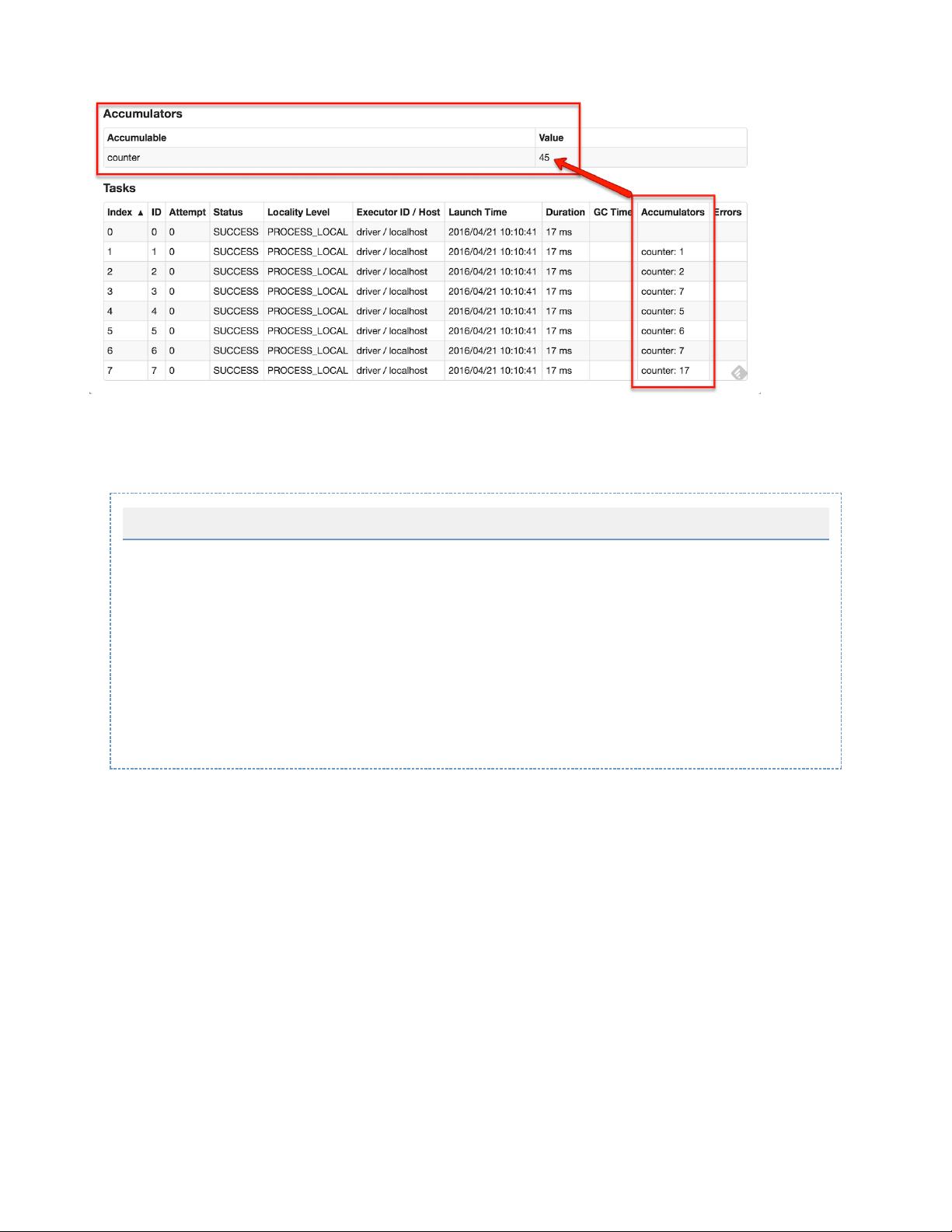

2. **编程指南**:这部分详细解释了如何编写Spark应用程序。快速入门章节展示了如何设置环境并运行第一个Spark程序。Spark编程指南详细介绍了RDD(弹性分布式数据集)、DataFrame和Dataset的使用,以及如何进行并行计算、数据持久化和使用共享变量。

- **RDD**:RDD是Spark的基础数据结构,它是不可变的、分区的记录集合,支持并行操作。

- **DataFrame和Dataset**:在Spark 2.0中引入,提供了更高级别的抽象,支持SQL查询和面向对象编程,适用于结构化和半结构化数据。

3. **SparkStreaming**:Spark Streaming是Spark的一个模块,用于处理实时数据流。它将数据流分解为微批次,然后使用Spark的核心API处理这些批次,实现低延迟的流处理。

4. **部署**:这部分详细阐述了在不同集群环境中部署Spark应用的步骤,包括Spark Standalone、Mesos和YARN。每个集群模式的配置和提交应用的方法都有所介绍。

- **Spark Standalone**:Spark自带的独立集群管理模式,适合小规模或测试环境。

- **Spark on Mesos**:在Mesos集群上运行Spark,利用Mesos的资源调度。

- **Spark on YARN**:在Hadoop的YARN(Yet Another Resource Negotiator)上运行Spark,充分利用Hadoop生态系统的资源管理。

5. **更多**:这部分涵盖了Spark的高级话题,如配置、监控、优化、作业调度、安全性和硬件配置。此外,还包括如何构建Spark项目,以及版本说明和贡献者信息。

- **Spark配置**:讲解了如何自定义Spark的行为,通过配置文件调整性能和行为。

- **Spark监控**:介绍了如何使用Spark的Web UI和其他工具来监控应用的运行状态。

- **优化指南**:提供了性能调优的最佳实践和策略,以提高Spark应用的效率。

6. **版本说明**:提供了关于Spark 2.0.0版本的主要更新和改进,这对于理解新版本的功能和迁移旧版本的应用至关重要。

7. **贡献者和联系我们**:这部分列出了项目的贡献者,并提供了如何加入ApacheCN社区和参与Spark项目的方式。

这份中文文档是学习和开发Spark应用的重要资源,无论你是初学者还是经验丰富的开发者,都能从中受益。通过深入阅读和实践,可以掌握Spark的核心概念和技术,从而在大数据处理领域游刃有余。

2018-01-10 上传

201 浏览量

2018-09-01 上传

2018-11-26 上传

2018-02-05 上传

点击了解资源详情

点击了解资源详情

l410505

- 粉丝: 0

- 资源: 4