NVIDIA Tesla GPU架构解析:从Tesla到Fermi

需积分: 0 135 浏览量

更新于2024-06-30

收藏 3.41MB PDF 举报

"Tesla GPU架构分析4"

在深入探讨Tesla GPU架构之前,我们先理解GPU的基本概念。GPU,即Graphics Processing Unit,是专门设计用于加速图形和图像处理的处理器。它在处理大量并行计算任务时表现出色,尤其是在3D图形渲染和现代计算应用中。NVIDIA在1999年引入GPU的概念,通过GeForce256芯片将其推向市场。

GPU与CPU之间存在显著差异。CPU作为中央处理器,负责执行各种计算和控制任务,具备较高的单线程性能和通用性。它包含ALU(算术逻辑单元)、Cache(高速缓存)和总线,用于管理和处理计算机的指令和数据。相比之下,GPU则专注于图形和并行计算,其架构设计允许同时处理大量数据,尤其适合于复杂的数学和几何运算,如3D游戏中的场景渲染。

接下来,我们详细讨论Tesla架构。Tesla最初并非设计为传统的图形处理芯片,而是面向计算应用,支持NVIDIA的CUDA计算平台。2008年的Tesla架构包含了7个Texture/Processor Clusters(TPC),每个TPC由两个Stream Multiprocessors(SM)组成。每个SM又包含6个Streaming Processors(SP),2个Special Function Units(SFU),以及L1缓存、多线程指令获取单元、常量缓存和共享内存等组件。这样的设计使得Tesla能够在高性能计算领域展现出强大的计算能力。

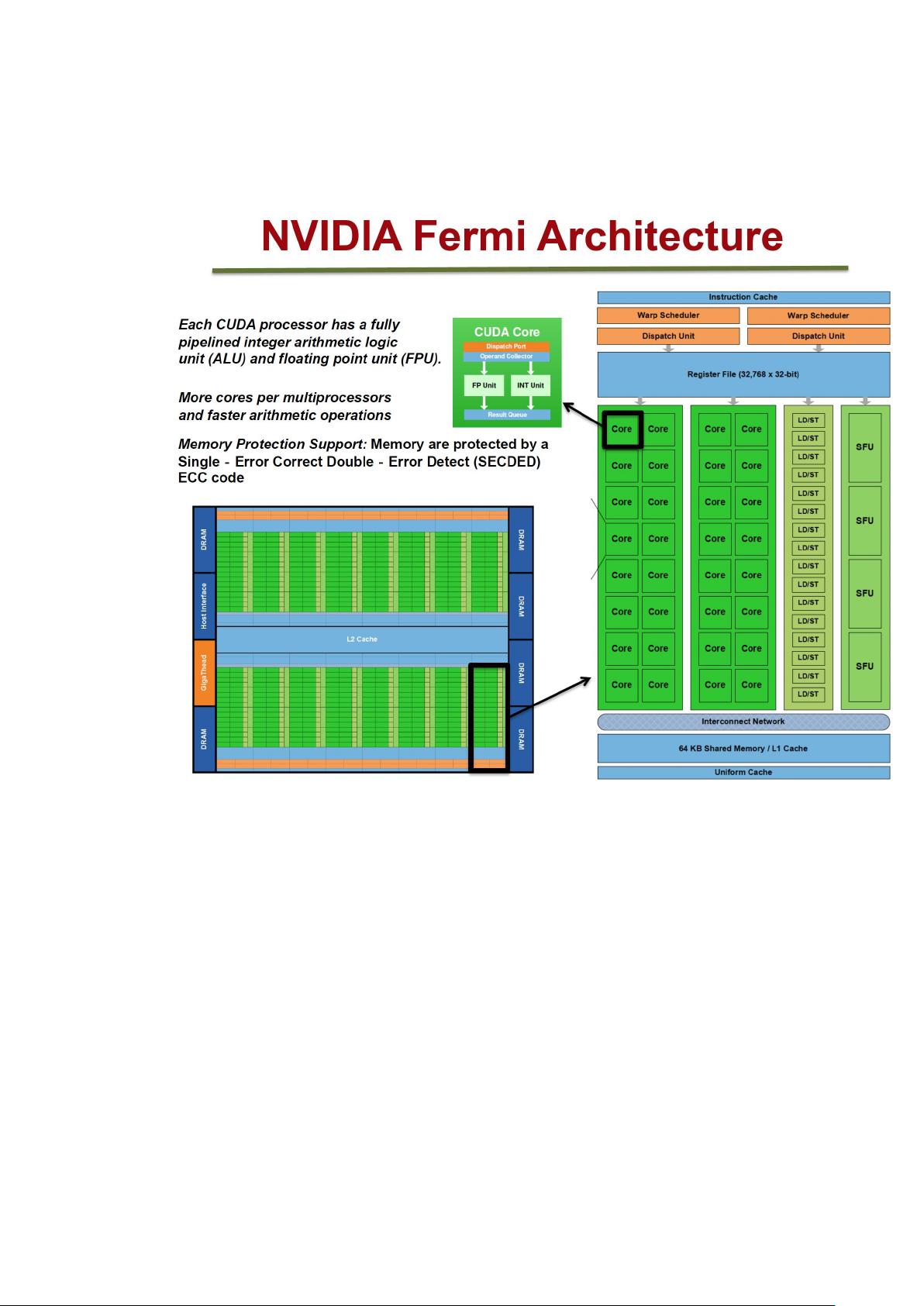

进入2010年,NVIDIA推出了Fermi架构,这是Tesla架构的一个重要进化。Fermi不仅保留了Tesla的并行处理能力,还增强了对双精度浮点运算的支持,提升了在科学计算和工程应用中的性能。Fermi架构引入了更多的SM,每个SM包含更多的CUDA cores,以及改进的缓存层次结构,进一步优化了数据访问速度和能效。

Tesla GPU架构以其高度并行的处理能力,为科学计算、机器学习、深度学习等领域提供了强大的硬件基础。随着技术的发展,后续的Kepler、Maxwell、Pascal、Volta和Turing等架构在Tesla的基础上不断演进,提升了GPU的性能和功能,使其在现代计算环境中扮演着不可或缺的角色。无论是嵌入式系统还是高端数据中心,GPU都已经成为加速计算的关键组件。

2022-08-04 上传

106 浏览量

2022-08-08 上传

2022-08-08 上传

2022-08-04 上传

2022-08-04 上传

2022-08-08 上传

点击了解资源详情

点击了解资源详情

lirumei

- 粉丝: 74

最新资源

- 误差传播与算法稳定性:比较与稳定性分析

- VC图书管理系统源代码学习版

- ArcGIS Server 9.2 安装指南 for .NET Framework

- Linux初学者词汇与术语详解

- S3C44B0X上嵌入式实时系统中TCP/IP协议栈LwIP设计与实现

- 深入理解Linux内核源代码

- C++编程思想:标准库与高级主题

- Java Servlet API 2.1a中文翻译文档

- Sun Java程序员310-055考试实战:序列化与异常处理

- PADS PowerPCB电路设计规范与流程详解

- C/C++编程规范指南

- 汇编语言设计详解:习题答案、指令解析与操作技巧

- IEEE电脑鼠走迷宫算法解析与竞赛规则

- 精通蓝牙应用开发:短距离互联实战指南

- C#与.NET框架下的数据结构实战

- ITPUB程序开发版电子杂志:Java入门与PHP5新特性探索