Python实现BP神经网络回归预测模型详解

"这篇文章主要讲解了如何使用Python实现BP(Backpropagation)神经网络回归预测模型,通过修改传统的用于分类的BP神经网络,将其转化为适用于回归任务的模型。作者指出,传统的BP网络通常使用Sigmoid激活函数,但因其输出范围有限(0-1之间),不适合作为回归模型。因此,模型的调整包括移除输出层的非线性转换或用线性函数f(x)=x替代Sigmoid。文章提供了相关的Python代码实现,包括定义损失函数、网络结构以及权重初始化方法。"

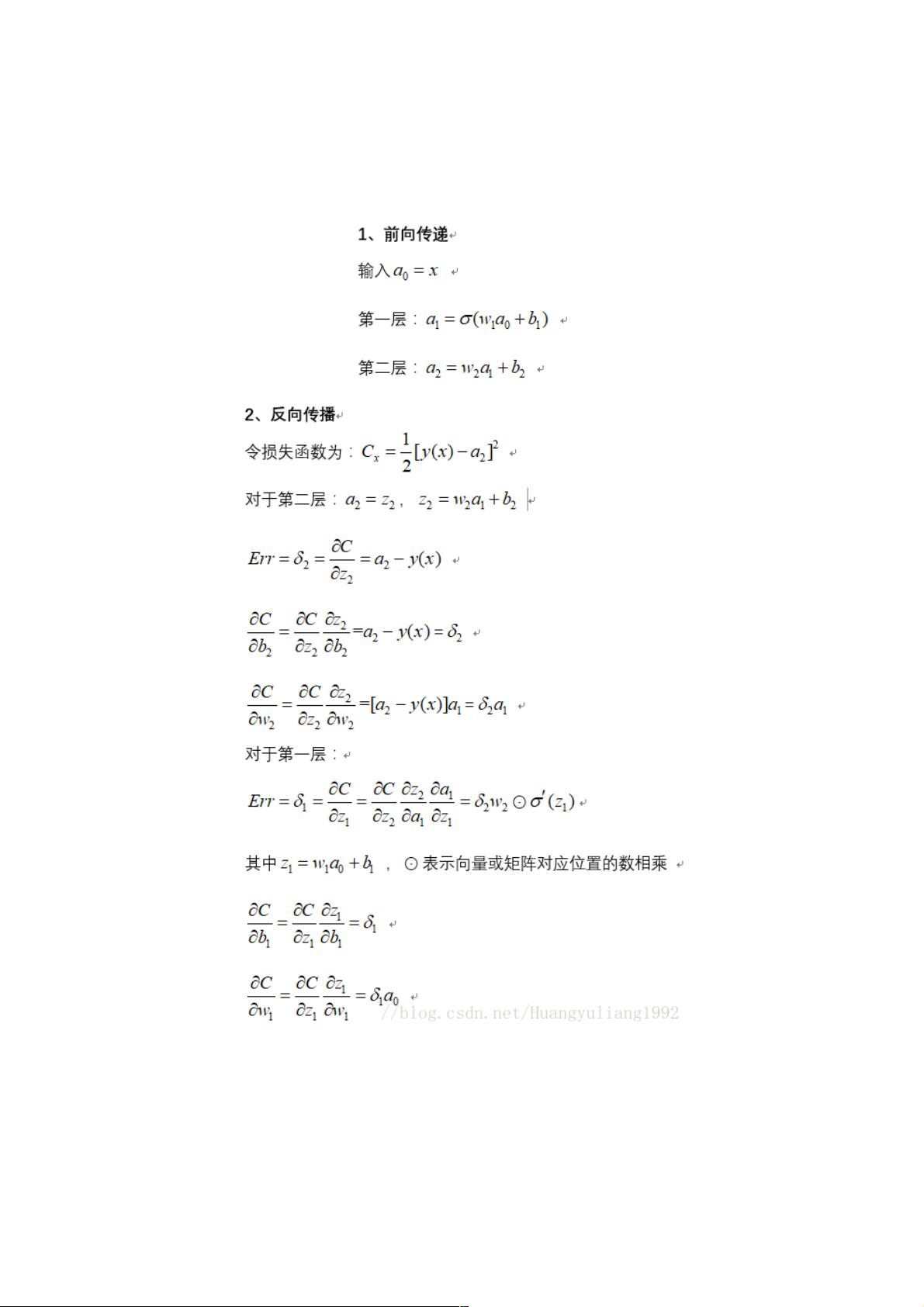

在Python中实现BP神经网络回归预测模型,首先要理解BP神经网络的基本原理,它是通过反向传播算法更新权重和偏置,以最小化损失函数。在传统的BP神经网络中,通常采用Sigmoid或 Tanh 函数作为激活函数,这些函数将输入映射到一个有限区间,适合二分类或多分类问题。然而,对于回归任务,我们希望模型能够预测连续的数值,因此需要更广泛的输出范围。

文章中的模型修改关键在于输出层的改变,用线性函数f(x)=x替换Sigmoid。线性函数的输出范围没有限制,这使得模型可以适应更大范围的预测值。此外,模型还涉及了成本函数的选择,这里使用的是交叉熵成本函数,虽然通常用于分类任务,但在回归问题中也能提供梯度信息。

在代码实现部分,可以看到`CrossEntropyCost`类定义了交叉熵损失函数和对应的梯度计算。`Network`类是核心网络结构,包含了权重和偏置的初始化,其中`default_weight_initializer`方法使用了随机高斯分布初始化权重,这有助于网络训练跳出局部最优解。另外,还有一个未完整展示的`large_weight_initializer`方法,可能用于更大幅度的权重初始化,以增加网络学习初期的多样性。

为了训练和使用这个回归模型,我们需要提供训练数据,包括输入特征和对应的期望输出。通过迭代更新权重,模型会逐渐学习到输入与输出之间的关系,从而进行预测。训练过程通常包含前向传播(计算预测值)和反向传播(更新权重)两个步骤。实际应用中,还需要考虑正则化和优化算法,如梯度下降、随机梯度下降(SGD)或Adam等,以提高模型的泛化能力和训练效率。

这篇文章提供的Python实现展示了如何调整BP神经网络以适应回归任务,并给出了基础的网络结构和损失函数实现。通过理解并实践这个模型,读者可以进一步掌握神经网络在回归预测中的应用,并在此基础上进行更多的模型优化和改进。

相关推荐

weixin_38626075

- 粉丝: 7

最新资源

- Heroku Postgres银行研究项目学习指南

- Linux Socket编程实战示例源码分析

- screen_capture_lite:面向多平台的高效屏幕捕获解决方案

- W7系统64位PS缩略图补丁终极解决方案

- 实现下拉菜单与复选框功能的JS代码示例

- 基于Jetty实现的简易乒乓球Websocket服务器教程

- 366商城触屏版登录注册网站模板源码分享

- Symfony应用中TCPDF捆绑包的使用与安装指南

- MSP430 自升级程序电脑端软件下载指南

- 华为项目管理工具与方法论揭秘

- MATLAB阶次分析工具包:实践学习与应用

- Windows环境下的sed命令使用详解

- IOS平台SQLiteHelper工具的使用指南

- SwisiDad: 便捷的Java图形拖放库

- Symfony工作流管理:PHPMentorsWorkflowerBundle介绍

- Qt环境下自定义String类的方法与实践