大数据ETL技术方案详解

110 浏览量

更新于2024-06-18

收藏 4.11MB DOCX 举报

"该文档是关于大数据ETL技术的详细方案,共110页,涵盖了ETL的基本概念、常用工具、具体操作步骤、不同场景的应用以及常见问题解答。"

ETL(Extract, Transform, Load)是大数据处理的核心环节,用于从不同的数据源抽取数据,经过清洗、转换后,加载到目标数据存储中。本方案首先介绍了ETL的基本概念,包括其直接通过JDBC连接源和目标数据的优势,如数据不落地、逐条数据验证与清理,以及增量抽取的条件。

文档详述了多种ETL工具的使用方法:

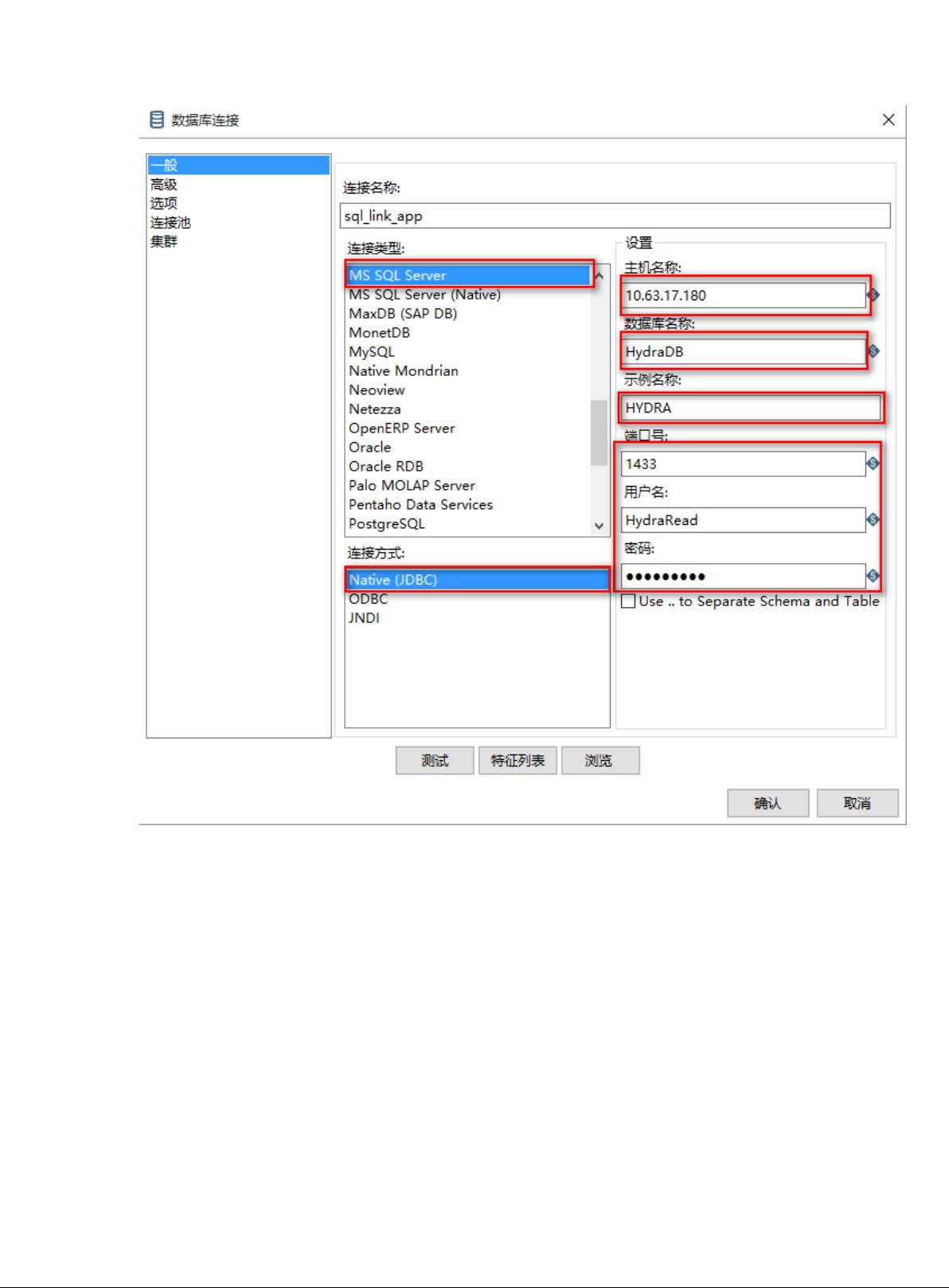

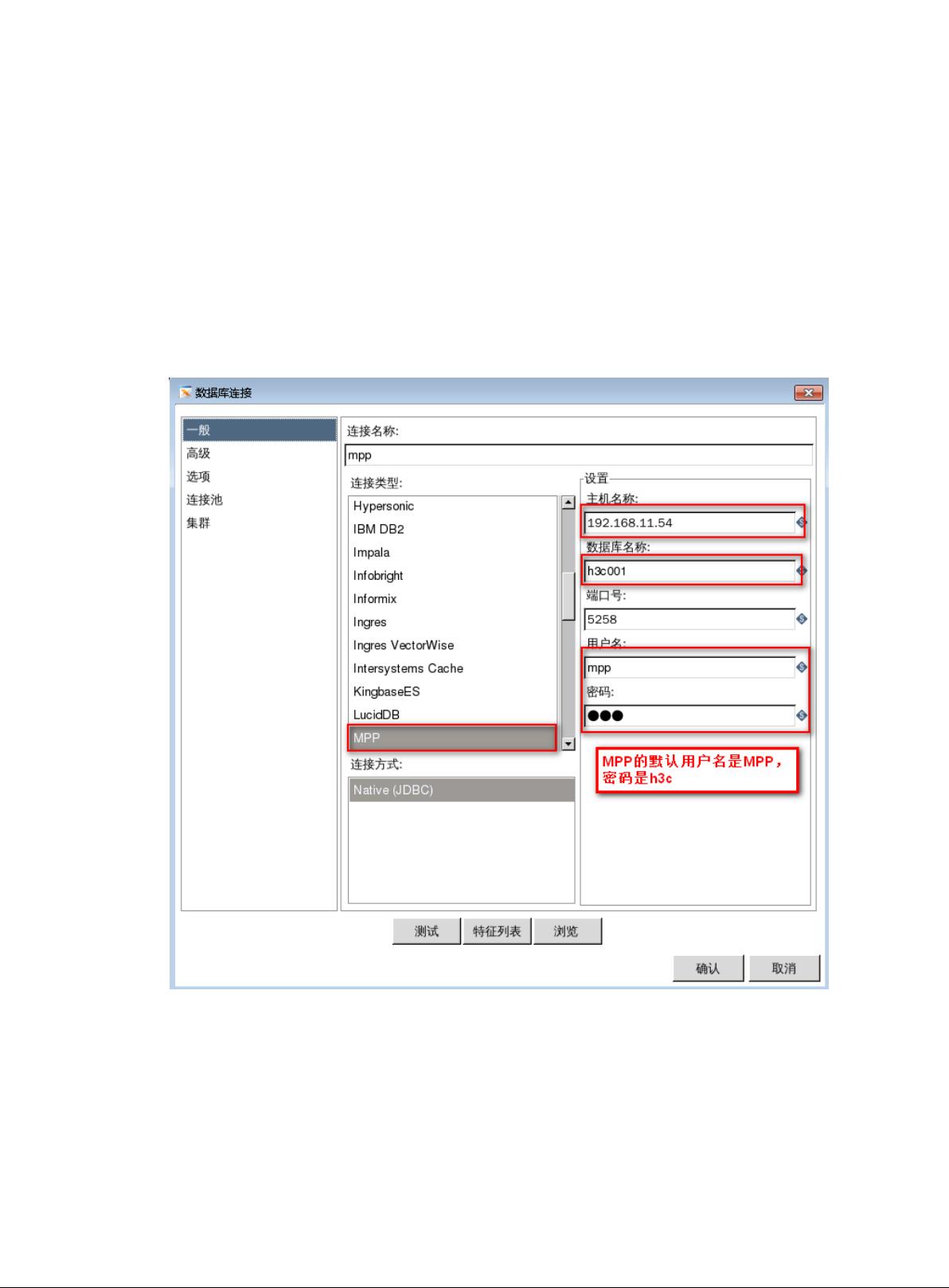

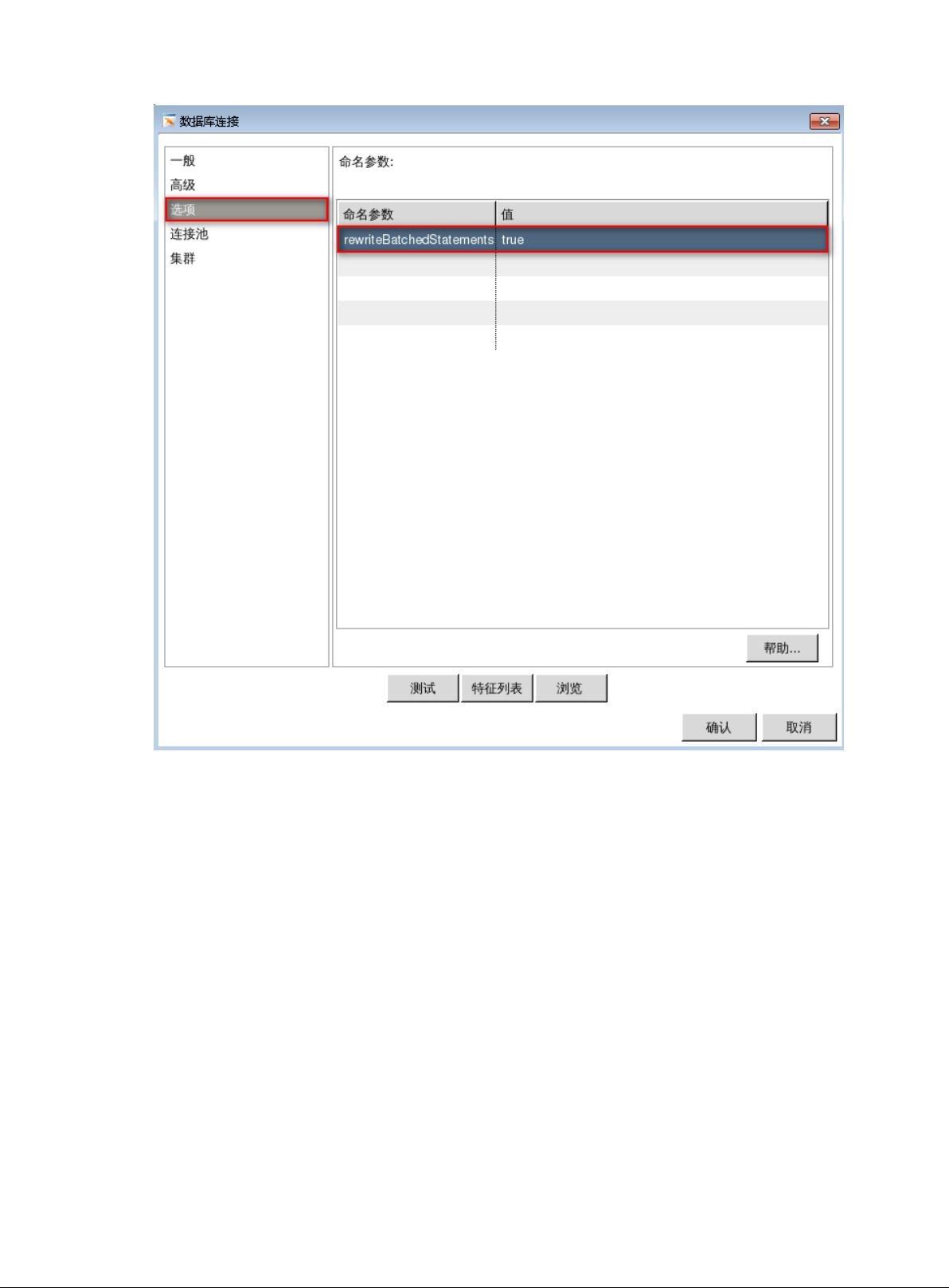

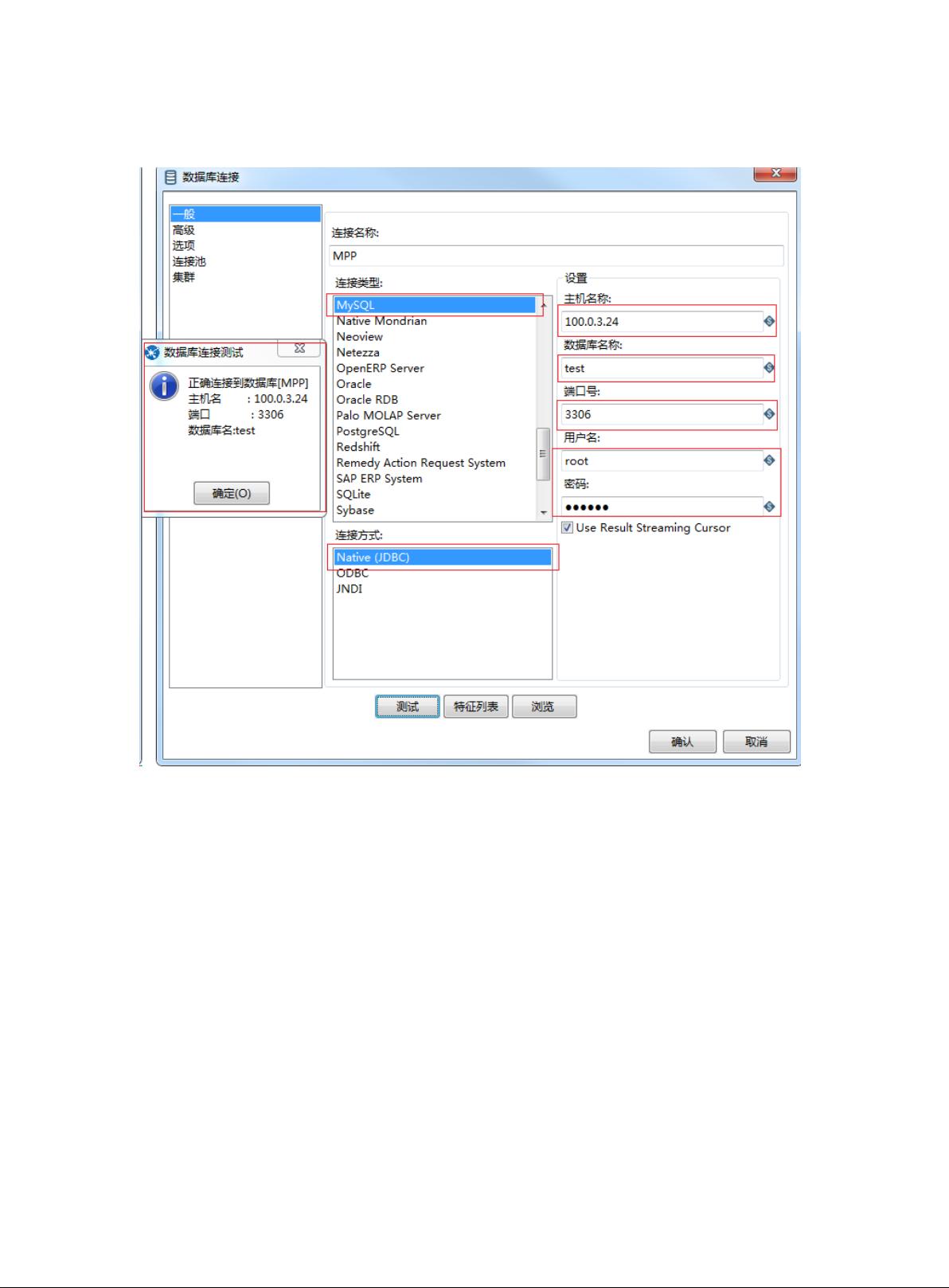

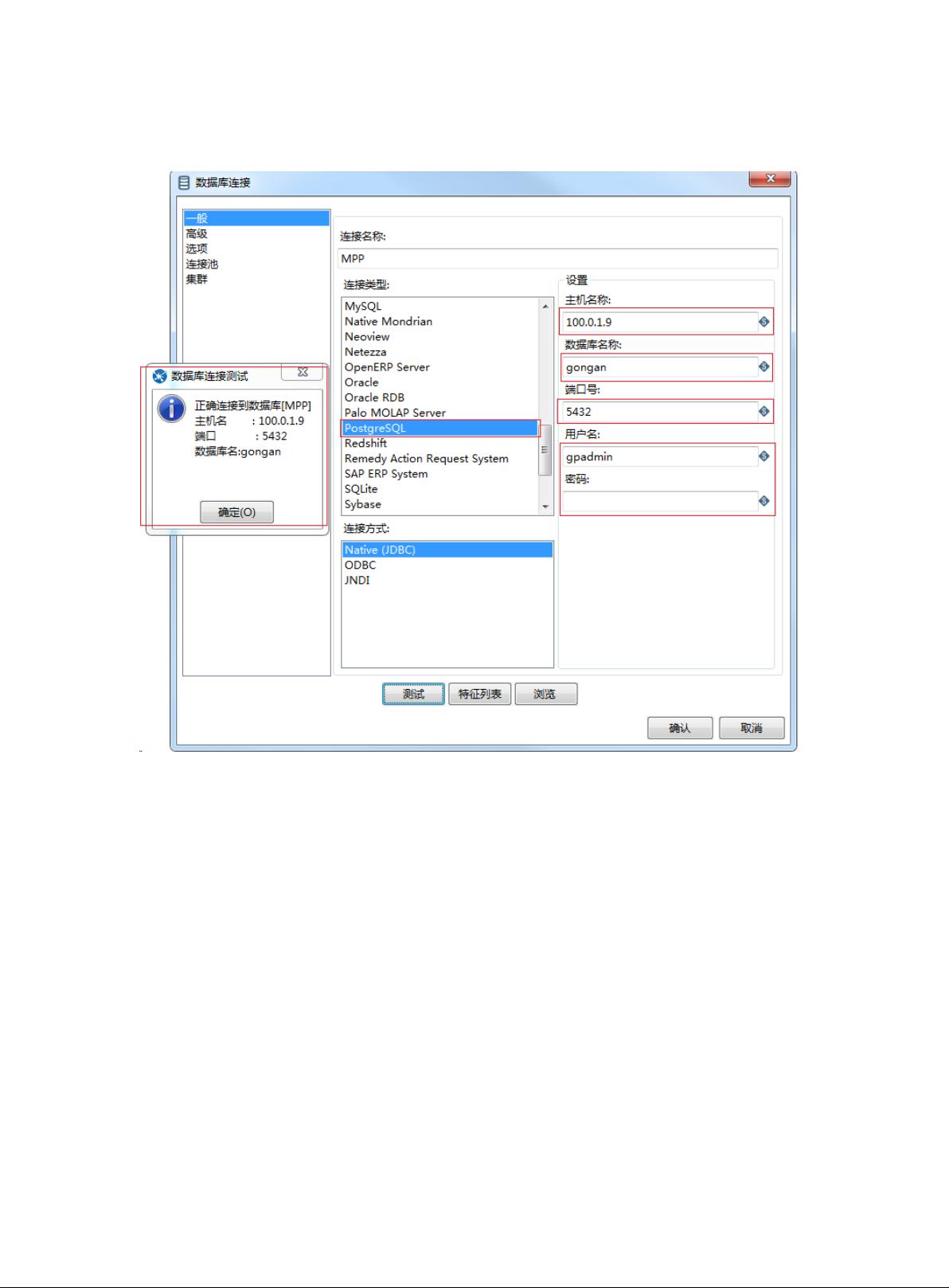

1. Kettle:Kettle是一个开源的数据集成工具,支持多种数据源的连接,包括介绍、配置数据源等步骤。

2. Sqoop:Sqoop是一个用于在Hadoop和传统关系型数据库之间传输数据的工具,本方案中提到无需安装ORC客户端即可使用。

3. OratoMPP:主要用于从Oracle数据库导出数据到文件,包括工具简介、客户端安装及使用教程。

4. 数据库自带工具:如SQL Server Management Studio、MySQL和PostgreSQL的数据导出功能,提供了详细的操作指南。

接着,文档阐述了数据加载的不同方法,包括将文件加载到MPP、HDFS和Hive中,针对这些操作提供了具体的步骤指导。

在场景应用部分,方案分别讨论了结构化全量和增量数据导入到MPP中的多种方法,包括Kettle的各种导入策略以及MPP工具OratoMPP和dispatch的使用。此外,还详细讲解了ETL数据到Hadoop的流程,涵盖了结构化和非结构化数据的导入,以及增量数据的处理。

最后,FAQ部分提供了解决常见问题的方法,如获取MPP工具、SQL建表语句,处理Kettle错误中断、SQLServer数据导出编码问题,以及与换行符、MPP数据类型的有关问题。MPP数据类型包括数值、字符、二进制和日期时间类型,并给出它们的特性。

这份110页的大数据ETL技术方案是全面而深入的,适合于希望了解和掌握ETL工具和流程的IT从业者参考学习。

2023-10-12 上传

2021-10-14 上传

2021-10-24 上传

2022-11-29 上传

2020-06-05 上传

2023-09-14 上传

公众号:智慧方案文库

- 粉丝: 3073

- 资源: 1万+

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常