小样本统计学习理论与支持向量机综述

需积分: 0 189 浏览量

更新于2024-08-04

收藏 319KB PDF 举报

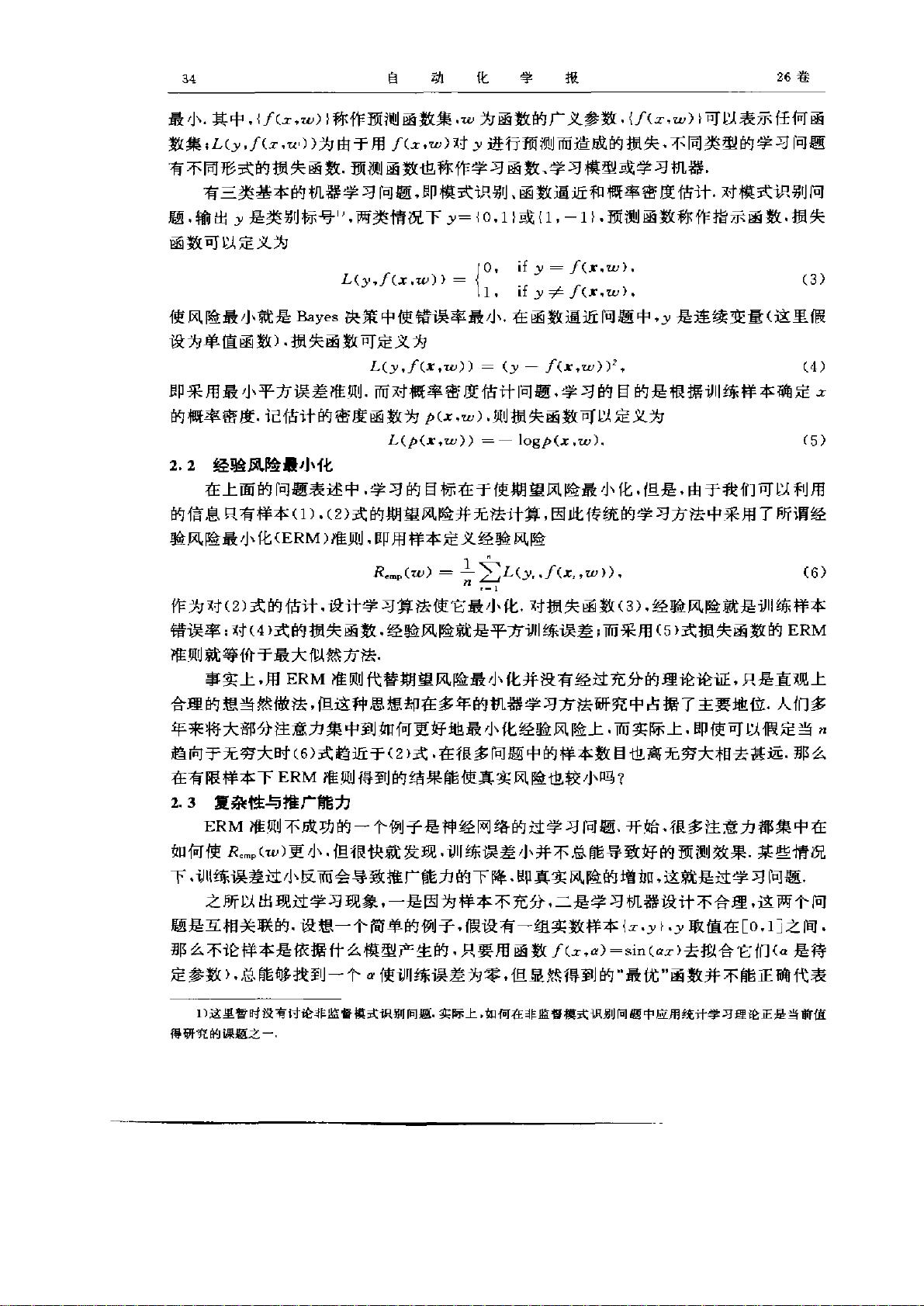

本文主要探讨了统计学习理论(Statistical Learning Theory, SLT)与支持向量机(Support Vector Machine, SVM)这两个在信息技术领域的重要概念。统计学习理论是Vapnik等人提出的一种针对小样本问题的统计理论,它突破了传统统计方法依赖大量样本的局限,关注在样本量有限的情况下,如何发掘和利用数据中的统计规律以及设计有效的学习策略。

SLT为机器学习提供了一个强大的理论基础,它强调了在有限样本条件下进行模型构建的有效性和稳健性。通过SLT,我们可以理解如何在复杂的数据环境中,通过有限的数据集来训练模型并做出准确的预测。支持向量机作为SLT的代表性成果,是一种特殊的机器学习算法,它通过找到数据中的最优决策边界或超平面,将数据分类,同时最大化类别间的间隔,从而提高泛化能力,特别适合处理高维空间和非线性问题。

SVM的特点在于其“最大间隔”原则,这使得它在面对噪声数据和小样本集时仍能保持较高的分类性能。另外,SVM还具有良好的可解释性,可以转化为解析形式,便于理解和应用。由于其出色的性能和广泛的应用性,SVM已经成为国际机器学习研究领域的热点,被广泛应用于图像识别、文本分类、生物信息学等多个领域。

本文的作者张学恭教授希望通过这篇综述,引导国内的学术界更加关注统计学习理论和支持向量机的研究,促进国内在这两个方向上的深入发展和应用。通过深入理解SLT的基本原理、优势和局限性,以及SVM的实际操作技巧,科研人员可以更好地应对实际问题,推动人工智能技术的进步。

统计学习理论与支持向量机不仅革新了传统统计分析的方法,也为解决小样本学习问题提供了有力工具。对于任何从事机器学习或数据分析工作的专业人士来说,掌握这两种理论和技术都是非常关键的,它们将继续引领未来人工智能领域的前沿研究和发展。

2023-05-18 上传

2009-09-28 上传

2021-09-24 上传

2023-07-16 上传

2023-12-03 上传

2023-07-02 上传

2024-08-27 上传

2023-07-31 上传

2023-12-12 上传

Java徐师兄

- 粉丝: 1522

- 资源: 2309

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器