半监督神经机器翻译:基于变分信息瓶颈的语料扩充策略

版权申诉

82 浏览量

更新于2024-06-27

收藏 1.6MB DOCX 举报

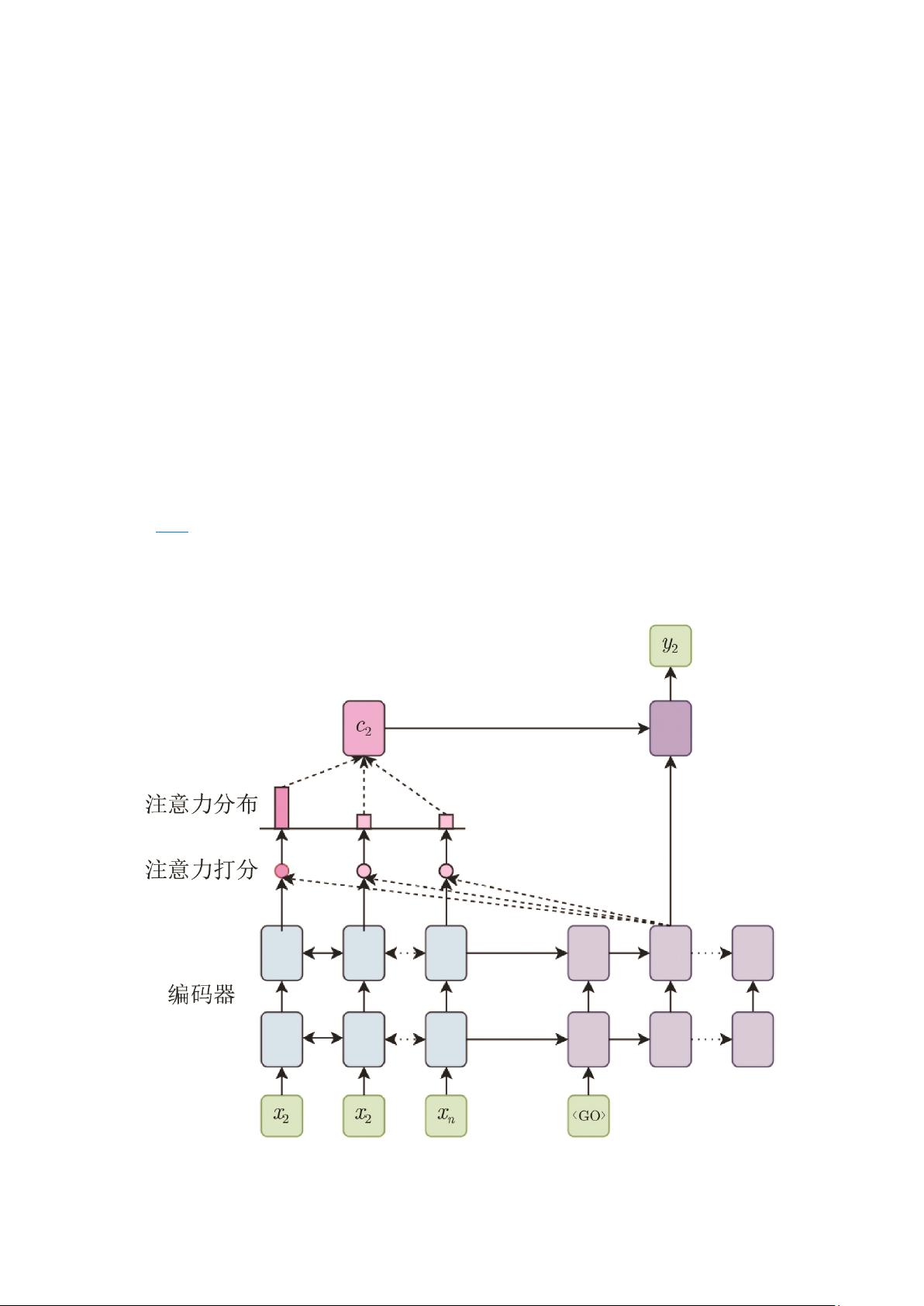

随着神经机器翻译(NMT)技术的快速发展,特别是基于注意力机制的模型引入后,NMT在翻译准确性和效率上已经超越了传统的统计机器翻译(SMT),成为了自然语言处理领域的研究焦点。然而,对于低资源语言对来说,平行语料的不足限制了变分方法(如贝叶斯推断和深度学习中的变分推理)的优势发挥。因此,半监督神经机器翻译(Semi-supervised NMT)作为一种有效策略,利用单语和少量平行数据来解决这个问题变得尤为重要。

半监督NMT主要通过两种策略来利用单语数据:1)语料扩充和再训练:首先,利用小规模平行语料训练基础NMT模型,然后使用回译技术将大量单语文本转化为伪平行数据,这些扩展后的数据进一步参与到模型的重新训练中,以增强模型的泛化能力。这种方法依赖于基础模型的质量,而基础模型的性能可以通过深度神经网络和注意力机制的结合来优化。

2)联合训练:利用自编码器等技术,同时输入平行语料和单语语料进行联合训练,这样可以更好地利用两种类型的数据,从而提升翻译模型的整体性能。值得注意的是,传统的基础模型优化往往集中在深层神经网络和在解码阶段应用注意力机制,以捕捉不同层次的语法和语义信息。例如,层级注意力机制通过不同层级神经网络的上下文表示,让低层网络负责词汇和浅层语法,而高层网络则关注更复杂的句法结构和语义理解。

然而,现有的层级注意力机制研究大多局限于层内融合,这可能限制了模型的灵活性和表达能力。为了进一步提升基础模型的性能,未来的研究可以探索更先进的注意力机制设计,比如跨层交互、动态注意力分配等,以便更有效地整合不同层次的特征信息。此外,集成强化学习或者迁移学习方法也可能有助于在有限的平行数据条件下,优化半监督NMT的训练过程。

总结来说,基于变分信息瓶颈的半监督神经机器翻译旨在解决低资源环境下平行数据不足的问题,通过创新的语料扩充策略和多层次注意力机制,以期在保持翻译效果的同时,减少对大量平行语料的依赖。随着研究的深入,这种混合式学习方法有望推动神经机器翻译技术在更多语言对上的广泛应用。

2019-11-25 上传

2024-09-06 上传

2023-02-23 上传

2022-11-29 上传

2022-11-04 上传

罗伯特之技术屋

- 粉丝: 4441

- 资源: 1万+

最新资源

- SSM Java项目:StudentInfo 数据管理与可视化分析

- pyedgar:Python库简化EDGAR数据交互与文档下载

- Node.js环境下wfdb文件解码与实时数据处理

- phpcms v2.2企业级网站管理系统发布

- 美团饿了么优惠券推广工具-uniapp源码

- 基于红外传感器的会议室实时占用率测量系统

- DenseNet-201预训练模型:图像分类的深度学习工具箱

- Java实现和弦移调工具:Transposer-java

- phpMyFAQ 2.5.1 Beta多国语言版:技术项目源码共享平台

- Python自动化源码实现便捷自动下单功能

- Android天气预报应用:查看多城市详细天气信息

- PHPTML类:简化HTML页面创建的PHP开源工具

- Biovec在蛋白质分析中的应用:预测、结构和可视化

- EfficientNet-b0深度学习工具箱模型在MATLAB中的应用

- 2024年河北省技能大赛数字化设计开发样题解析

- 笔记本USB加湿器:便携式设计解决方案