梯度提升决策树(GBDT)原理解析

需积分: 44 7 浏览量

更新于2024-07-18

2

收藏 1.28MB PDF 举报

"GBDT的介绍PPT涵盖了监督学习的关键概念,特别是回归树和集成(我们学习什么),以及梯度提升(我们如何学习)的细节。主要内容包括监督学习的元素,如训练样本的表示、模型预测、参数学习、目标函数、损失函数和正则化。特别提到了线性模型、岭回归、Lasso回归以及梯度提升的原理。"

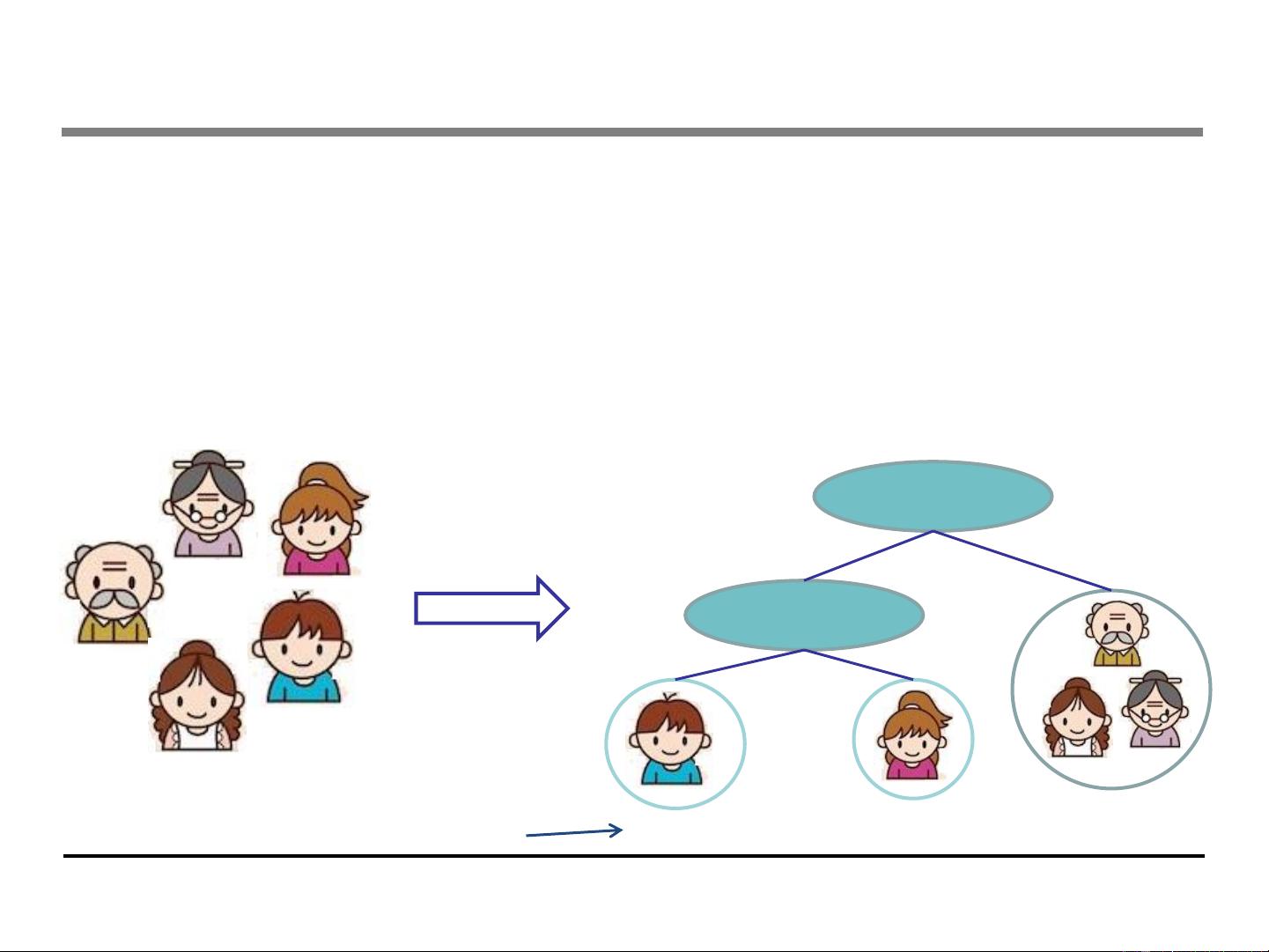

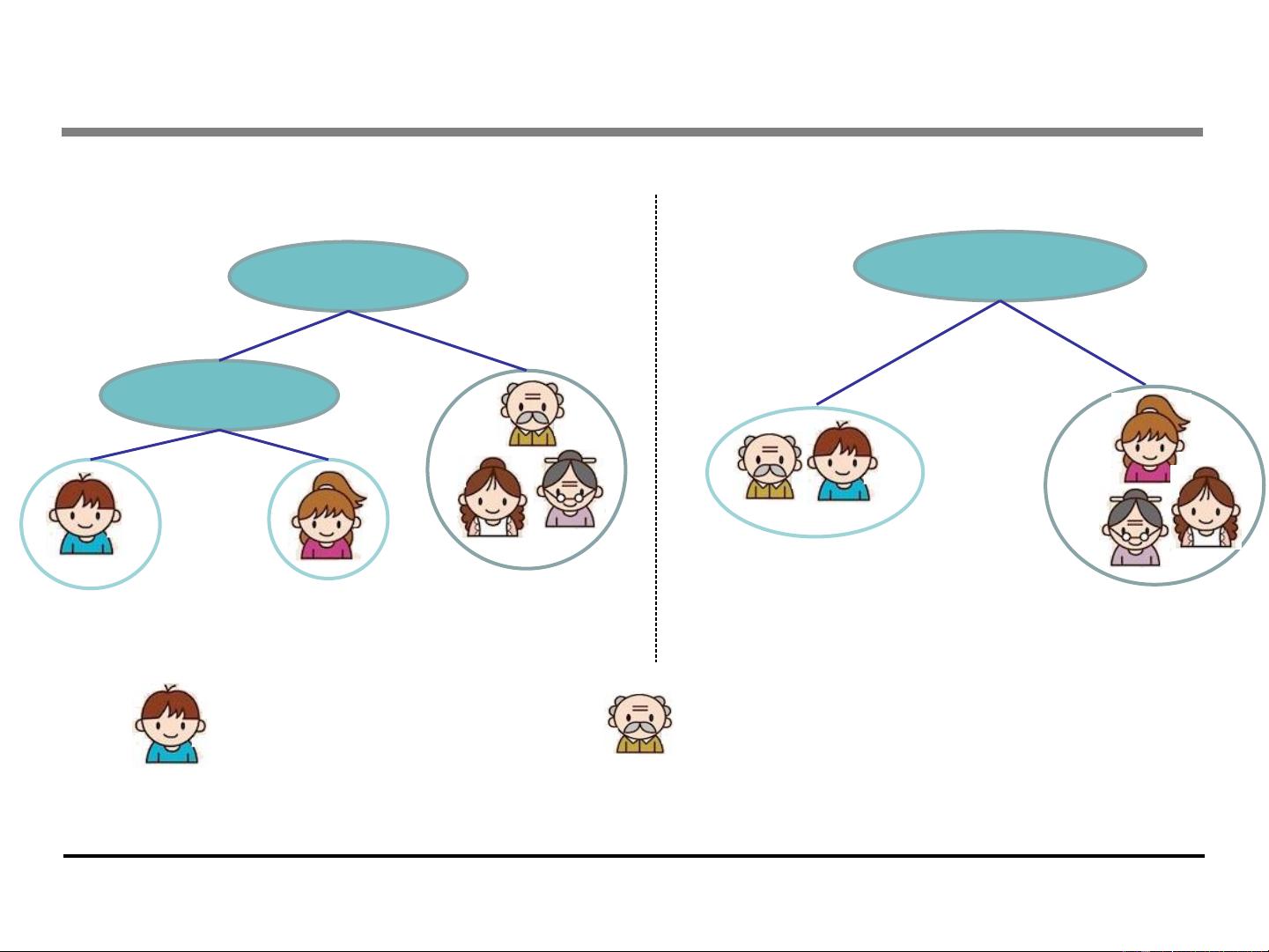

在机器学习领域,GBDT(Gradient Boosting Decision Tree)是一种强大的集成学习方法,它通过迭代地添加弱预测器来构建一个强预测模型。这个PPT深入介绍了GBDT的基础知识。

首先,监督学习是机器学习的一个主要分支,其目标是从已标记的数据中学习规律,以对未知数据进行预测。在监督学习中,每个样本由特征向量表示,而模型则是根据这些特征进行预测的函数。例如,线性模型可以是简单的线性回归或逻辑回归,它们分别用于连续值预测和分类问题。

线性模型的预测分数可以根据任务的不同有不同的解释。在回归问题中,预测分数就是预期的数值;而在二分类的逻辑回归中,它是实例为正类的概率。其他模型如排名问题中,预测分数可能是实例的排名得分。

接下来,目标函数是衡量模型预测效果好坏的指标,通常包括损失函数和正则化项。损失函数如平方损失(MSE)用于回归问题,衡量模型预测与真实值之间的差异;而逻辑损失(对数似然损失)用于分类问题,衡量模型预测概率与实际类别的一致性。正则化则控制模型的复杂度,防止过拟合。L2正则化(Ridge回归)通过惩罚模型参数的平方和来防止过大权重,而L1正则化(Lasso回归)能诱导模型产生稀疏解,即部分参数为0。

最后,GBDT的核心是梯度提升算法。它通过迭代地构建决策树,每次迭代都专注于纠正前一轮模型的残差,从而逐步提高整体预测性能。这种方法不仅能够处理非线性关系,还具有很好的泛化能力,常用于各种机器学习竞赛和实际应用中。

这个PPT为理解GBDT提供了一个全面的框架,包括了从基本的监督学习概念到高级的梯度提升技术,是学习和理解GBDT的宝贵资源。

821 浏览量

270 浏览量

671 浏览量

2627 浏览量

1149 浏览量

2015-09-30 上传

174 浏览量

生命的激流

- 粉丝: 1

最新资源

- DirectX高级动画技术探索

- Fedora 10安装指南:从升级到Yum配置

- 2009考研数学大纲解析:数一关键考点与连续函数详解

- OMRON CS1D: 双CPU可编程控制器提升系统可靠性

- Linux初学者指南:操作系统的入门与优化

- 嵌入式硬件工程师宝典:全面指南与设计艺术

- 中国UTN-SMGIP 1.2:短信网关接口协议详解

- 网上图书馆管理系统的需求分析与设计详解

- BEA Tuxedo入门教程:Jolt组件与编程详解

- X3D虚拟现实技术入门与教程

- 项目监控:关键活动与流程及问题应对

- JSP调用JavaBean实现Web数据库访问:JDBC-ODBC桥接Access

- 项目规划详解:目标、流程与关键步骤

- Oracle数据库教程:从基础到实践

- InstallShield快速入门指南:打造专业Windows安装程序

- SQL优化技巧:提升查询速度