Hadoop大数据开发基础教程:从Java安装到集群搭建

版权申诉

140 浏览量

更新于2024-06-26

收藏 7.37MB PPTX 举报

"Hadoop大数据开发基础完整版教学教程涵盖了从Java环境配置到Hadoop完全分布式集群搭建的全过程。"

本文将深入讲解Hadoop大数据开发的基础知识,包括Java的安装和配置,以及如何搭建Hadoop完全分布式集群。首先,我们讨论了Java Development Kit (JDK)的重要性,它是Java应用程序开发的基础,同时也是Hadoop开发不可或缺的部分。在Windows环境下,安装JDK需要改变安装目录,配置环境变量如JAVA_HOME、CLASSPATH和Path。配置完成后,通过命令提示符验证环境变量设置是否正确。

对于Linux系统,JDK的安装通常通过RPM包管理器完成,例如使用"rpm –ivh jdk-7u80-linux-x64.rpm"命令。配置环境变量的方法与Windows类似,但需要注意的是,Linux系统中可能需要编辑环境变量文件,如/etc/profile或~/.bashrc。

接下来,我们转向Hadoop的安装与配置。在搭建Hadoop完全分布式集群时,通常需要至少四台虚拟机,分别作为master节点(包含NameNode和ResourceManager)和三个slave节点(DataNodes和TaskTrackers)。每台虚拟机应分配适当的硬件资源,如内存、硬盘空间和CPU核心,并设置固定的IP地址。在master节点上,除了安装JDK之外,还需要关闭防火墙并安装必要的辅助软件。

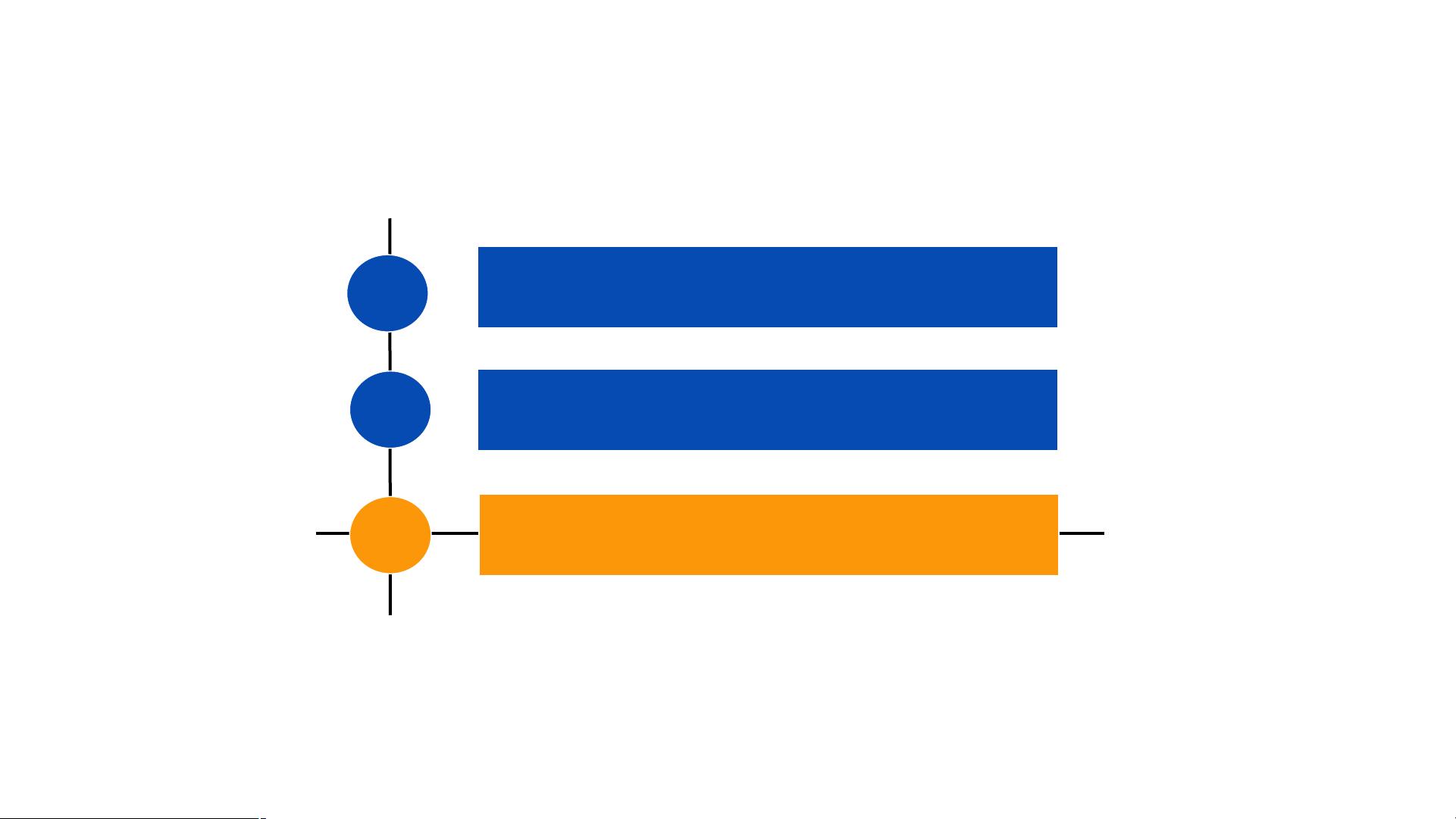

集群搭建的关键步骤包括:

1. 配置SSH无密码登录:确保所有节点之间可以无需输入密码地进行SSH通信。

2. 分发Hadoop二进制文件:将Hadoop安装包复制到所有节点,并解压到相同目录。

3. 修改配置文件:如hdfs-site.xml和yarn-site.xml,配置NameNode、DataNode、ResourceManager和NodeManager的相关参数。

4. 初始化HDFS:在master节点上格式化NameNode。

5. 启动Hadoop服务:按照DataNode、Secondary NameNode、NodeManager、ResourceManager、NameNode的顺序依次启动各服务。

在所有这些步骤完成后,通过Hadoop提供的命令行工具,如hadoop fs -ls和jps,可以检查Hadoop集群是否正常运行。这只是一个基础的Hadoop集群搭建过程,实际生产环境中可能涉及更复杂的配置,如高可用性设置、安全认证等。理解并掌握这些基础知识对于Hadoop开发者来说至关重要,因为它们构成了大数据处理和分析平台的基础架构。

2023-03-24 上传

2023-03-25 上传

2021-10-05 上传

2021-09-23 上传

2021-10-14 上传

智慧安全方案

- 粉丝: 3815

- 资源: 59万+

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析