GPU服务器选择指南:五大基本原则解析

"选择GPU服务器的五大基本原则"

选择GPU服务器是一项关键的决策,因为它直接影响到人工智能、深度学习和高性能计算任务的效率和效果。在评估和选择GPU服务器时,有五个重要的基本原则需要考虑:

1. **考虑业务应用先选择GPU型号**:不同的GPU型号适合不同的应用场景。例如,NVIDIA V100 GPU因其强大的计算能力,常用于大规模深度学习训练和高性能计算任务。对于需要快速响应时间的实时应用,可能需要选择更高效能的GPU型号。

2. **考虑服务器的使用场景及数量(边缘/中心)**:边缘计算服务器通常需要低功耗、轻量级的GPU,以适应有限的空间和电源条件,而数据中心服务器则可以使用更高性能的GPU,如NVIDIA的DGX系列,它们专为大规模并行计算设计。

3. **考虑客户自身的目标使用人群及IT运维能力**:企业应根据其技术团队的技能和经验来选择GPU服务器。例如,如果团队熟悉NVIDIA的CUDA平台,那么选择支持CUDA的GPU会更有优势。同时,也要考虑维护和升级的复杂性,确保IT团队能够有效地管理服务器。

4. **考虑服务器配套软件的价值以及服务的价值**:除了硬件,软件和服务也是重要的考量因素。例如,NVIDIA的DGX系统不仅提供了高性能的GPU,还包含优化的软件栈和全面的技术支持,这对于加速AI开发和部署至关重要。

5. **考虑整体GPU集群系统的成熟度及工程效率**:评估GPU服务器时,要考虑整个集群的集成度和扩展性。一个成熟的GPU集群系统能确保高效的数据传输和任务调度,提高工程效率。

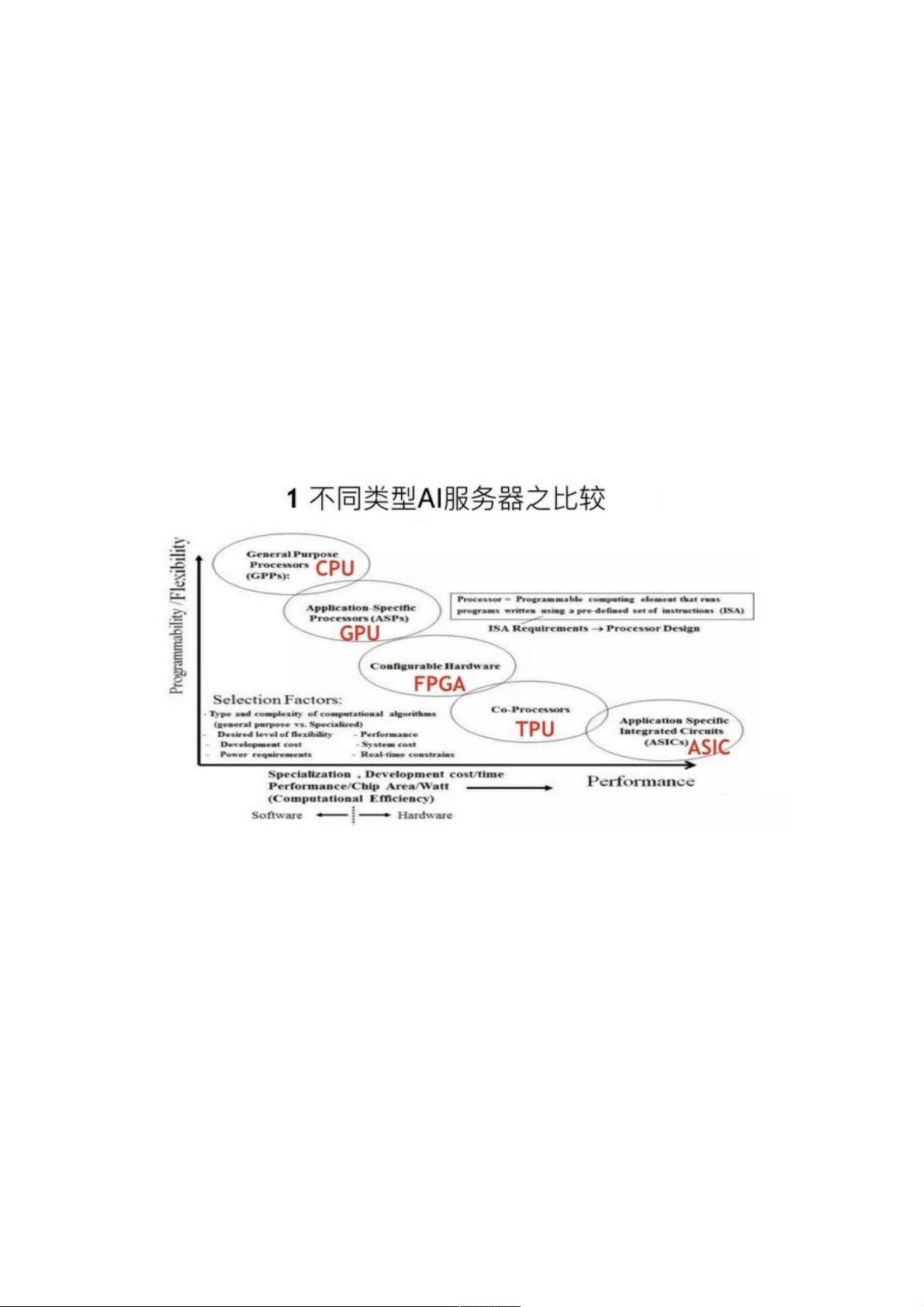

在GPU服务器的类型比较中,CPU、GPU、FPGA和ASIC各有优势。CPU擅长通用计算,FPGA和ASIC则在特定任务中提供高性能和低功耗,而GPU则在可编程性和性能之间找到了平衡,特别适合于深度学习和大规模并行计算。例如,NVIDIA的DGX-1、DGX-2和DGX Station都是针对不同需求设计的GPU服务器解决方案,其中DGX系统利用NV-Link提供了高速的GPU间通信,极大地提高了计算效率。

在实际选择过程中,还需要综合考虑功耗、成本、可扩展性、兼容性以及未来的升级路径。例如,NV-Link接口的GPU提供更高的带宽,适合于需要大量数据交换的应用,而传统PCI-e总线接口的GPU可能更适合预算有限或对带宽要求不那么高的场景。

选择GPU服务器时,需要全面分析业务需求、技术环境和长远规划,确保所选服务器能够满足当前及未来的工作负载,同时提供最佳的性价比和运营效率。

2021-02-18 上传

2018-04-28 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-10-30 上传

weixin_38660051

- 粉丝: 5

- 资源: 923

最新资源

- 新代数控API接口实现CNC数据采集技术解析

- Java版Window任务管理器的设计与实现

- 响应式网页模板及前端源码合集:HTML、CSS、JS与H5

- 可爱贪吃蛇动画特效的Canvas实现教程

- 微信小程序婚礼邀请函教程

- SOCR UCLA WebGis修改:整合世界银行数据

- BUPT计网课程设计:实现具有中继转发功能的DNS服务器

- C# Winform记事本工具开发教程与功能介绍

- 移动端自适应H5网页模板与前端源码包

- Logadm日志管理工具:创建与删除日志条目的详细指南

- 双日记微信小程序开源项目-百度地图集成

- ThreeJS天空盒素材集锦 35+ 优质效果

- 百度地图Java源码深度解析:GoogleDapper中文翻译与应用

- Linux系统调查工具:BashScripts脚本集合

- Kubernetes v1.20 完整二进制安装指南与脚本

- 百度地图开发java源码-KSYMediaPlayerKit_Android库更新与使用说明