Heritrix web信息抽取优化:多线程提升爬取速度

下载需积分: 11 | PDF格式 | 2.7MB |

更新于2024-08-11

| 144 浏览量 | 举报

"基于Heritrix的web信息抽取优化与实现 (2012年)"

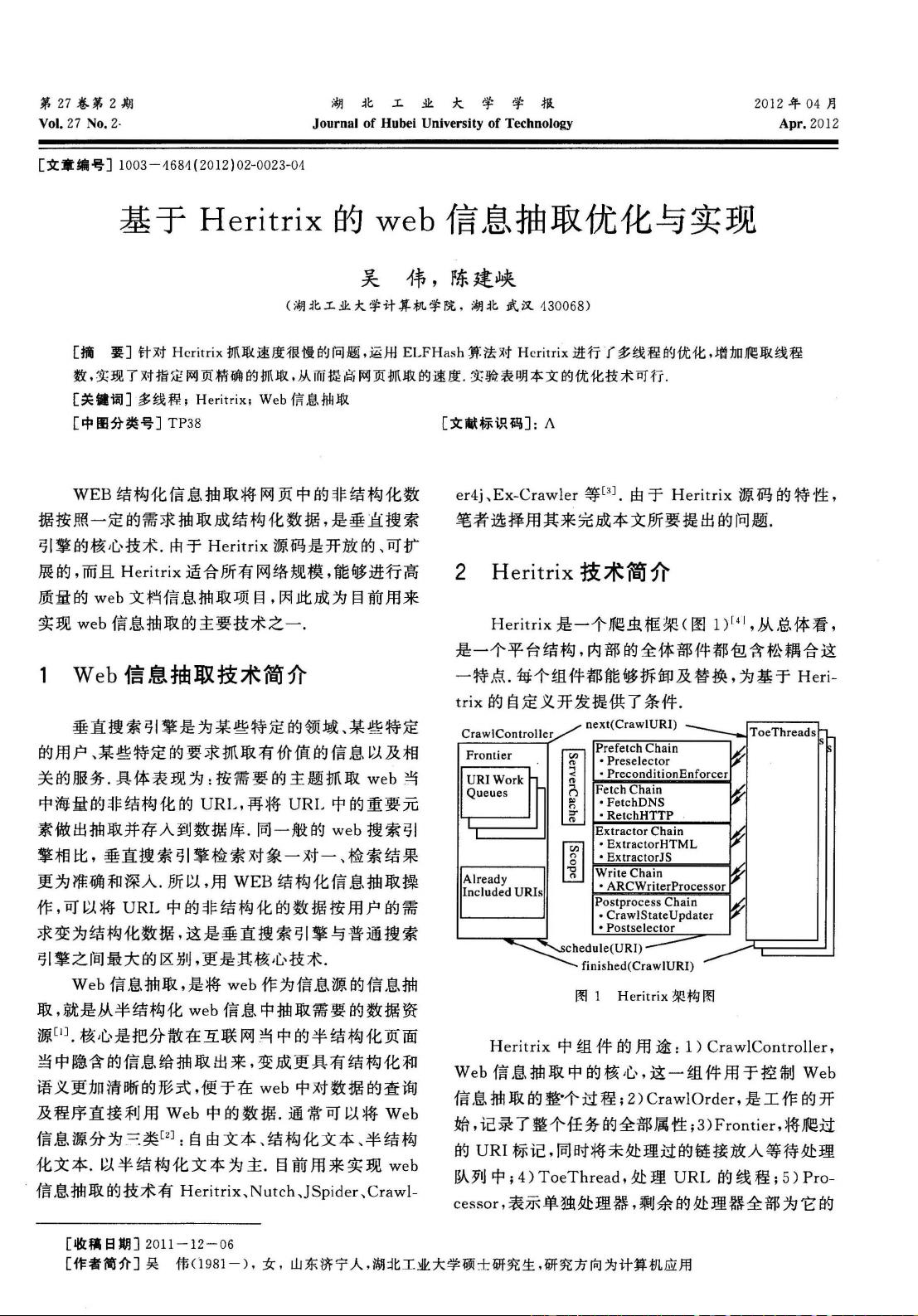

本文主要探讨了如何针对Heritrix web爬虫的性能瓶颈进行优化,以提高网页抓取速度。Heritrix是一个开源、可扩展的网络爬虫工具,适用于各种规模的网络抓取项目,尤其适用于构建高质量的Web信息抽取系统。然而,Heritrix在默认情况下抓取速度较慢,这限制了其在大规模数据抓取中的效率。

作者吴伟和陈建峡提出了采用ELFHash算法对Heritrix进行多线程优化的方法。ELFHash是一种常用的哈希算法,通过它来分配爬取任务,可以有效提升爬虫的并发处理能力。通过增加爬取线程的数量,Heritrix能够并行处理更多的网页,从而加快抓取速度,实现对指定网页的精准抓取。

Web信息抽取技术是将非结构化的网页数据转换为结构化数据的关键过程,特别对于垂直搜索引擎来说,这项技术至关重要。垂直搜索引擎专注于特定领域,提供更精确和深度的搜索结果。而普通的Web搜索引擎则服务于广泛的主题,检索范围更广但可能不够精细。

Web信息抽取主要涉及自由文本、结构化文本和半结构化文本的处理,其中半结构化文本是最常见的类型。现有的Web信息抽取工具有Heritrix、Nutch、JSpider、Crawler4j和Ex-Crawler等。Heritrix因其源码的开放性和可扩展性,成为了本文优化的对象。

实验结果显示,通过运用多线程优化和ELFHash算法,Heritrix的网页抓取速度得到了显著提升,证明了该优化技术的可行性。这一成果对于需要高效抓取大量网页信息的项目具有重要的实践意义,有助于提升整体的Web信息处理效率。

文章深入研究了Web信息抽取技术,特别是针对Heritrix爬虫的优化策略,为提升Web爬取速度提供了有效的解决方案。这对于开发垂直搜索引擎或其他依赖于大量网络数据的应用来说,具有重要的参考价值。

相关推荐

weixin_38602098

- 粉丝: 3

最新资源

- MATLAB实现自适应遗传算法优化目标函数

- STM32F101xx中文数据手册完整指南

- 布鲁诺创建Java软件工程II课程存储库

- CSS制作摇动按钮动画教程

- 金泫雅黑色电脑主题 win7版深度体验

- 浪漫自然主题青葱菊花PPT模板下载

- 在线辅导项目开发指南:代码优化与环境配置

- 技嘉GA-z87 hd3黑苹果配置教程与config.plist详解

- QQ超级皮肤v5.8.5.0:保存2014QQ风格的终极解决方案

- 粉色杜鹃花PPT模板免费下载

- ListaLigada 主文件解析:示例名单与最终结果

- 2011年教师节主题PPT模板免费下载

- SFSchemaParser: 轻松将Salesforce模式XML转化为CSV文件

- Python深度学习研究与实践指南

- 黑幕降临电脑主题,夜色中的惊悚动漫桌面体验

- REST API自动化测试工具:rest-client与Postman的比较