英特尔OpenVINO环境配置全攻略:加速CPU神经网络推理

需积分: 0 153 浏览量

更新于2024-08-03

收藏 1.42MB PDF 举报

"英特尔OpenVINO推理框架的环境配置教程主要涵盖了从下载安装包到配置环境变量、模型优化器的全过程。此教程适用于基于英特尔NUC或x86架构CPU的设备,旨在利用OpenVINO工具包实现神经网络模型的CPU加速。"

OpenVINO全称为Open Visual Inference and Neural Network Optimization,是英特尔开发的一款用于深度学习推理的工具包。它支持多种硬件平台,包括CPU、GPU、FPGA等,通过优化神经网络模型,提高在嵌入式和边缘计算设备上的运行效率。

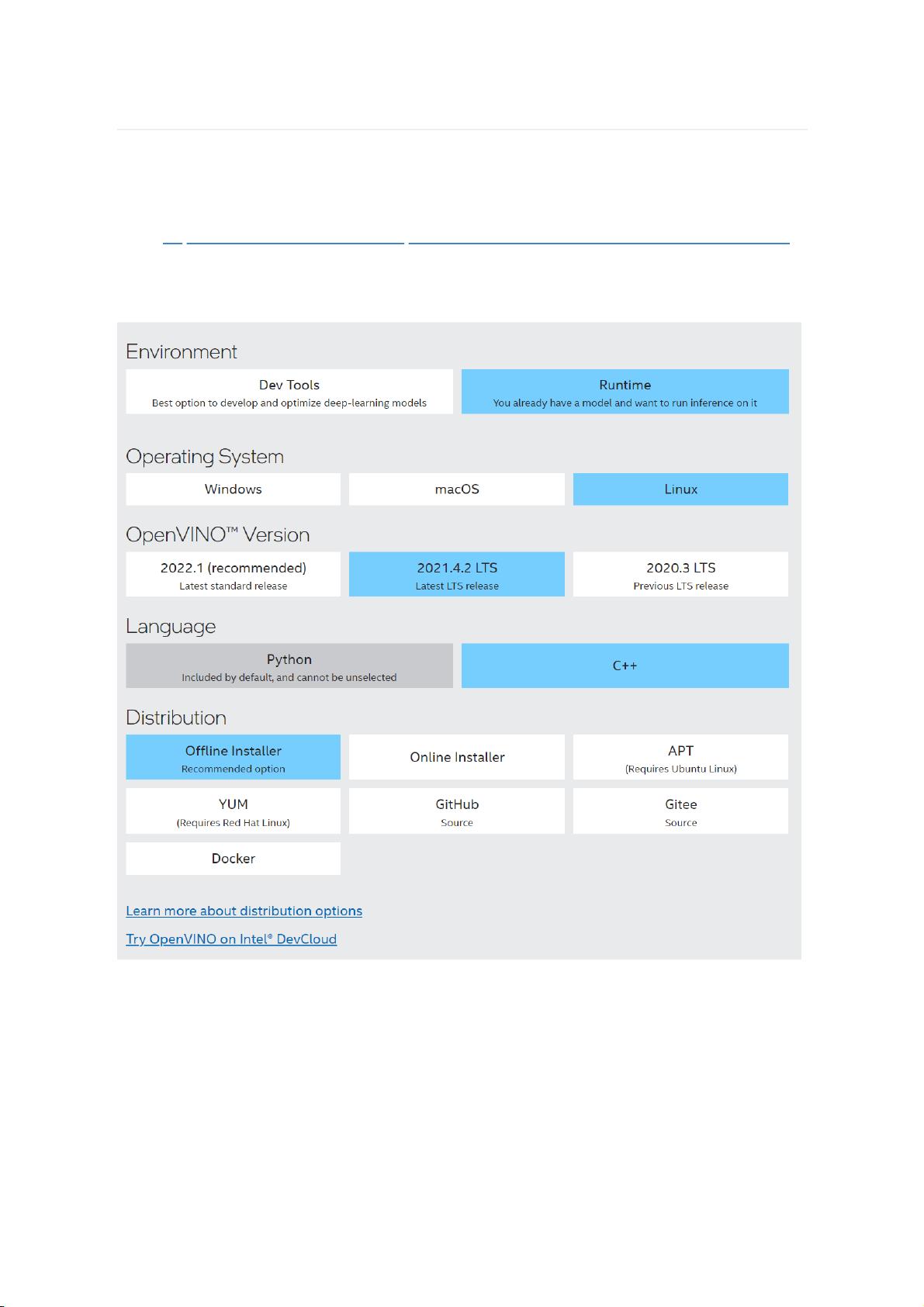

1. **下载OpenVINO安装包**:

- 访问官方网站<https://software.intel.com/en-us/openvino-toolkit/choose-download/free-download-linux>,注册并获取下载链接和SerialNumber以激活软件。

- 根据你的操作系统选择合适的版本进行下载。

2. **安装OpenVINO**:

- 解压缩下载的安装包到非中文路径下。

- 遇到问题时,可以参考官方安装教程<https://docs.openvino.ai/latest/openvino_docs_install_guides_installing_openvino_linux_header.html>。

- 通过带有GUI的安装方式进行,跟随向导进行操作,自定义安装路径通常为`/opt/intel/`。

3. **安装依赖组件**:

- 安装OpenVINO可能需要的一些额外库和组件,确保系统环境满足最低要求。

4. **配置环境变量**:

- 安装完成后,打开新终端,如果看到与OpenVINO相关的环境变量设置,表明安装成功。

- 使用`vim`编辑`.bashrc`文件,将OpenVINO的`setupvars.sh`脚本添加到文件末尾,保存并退出。

5. **配置模型优化器(Model Optimizer)**:

- 模型优化器是OpenVINO的重要组成部分,用于将预训练的模型转换为Inference Engine可读的IR(Intermediate Representation)格式。

- 运行`install_openvino_dependencies.sh`脚本来安装模型优化器的先决条件。

- 在`install_prerequisites`目录下执行命令配置所有支持的框架。

6. **验证安装**:

- 安装完成后,通过运行示例项目或自己的模型进行测试,确保OpenVINO能够正确地加速推理过程。

7. **使用OpenVINO进行推理**:

- 开发者可以使用Inference Engine API,结合已优化的模型,在目标平台上运行推理任务。

- 支持多种编程语言如Python、C++,并且提供了丰富的示例代码和API文档。

8. **注意事项**:

- 在安装过程中,确保遵循官方文档的指示,处理可能出现的权限问题或其他错误。

- 定期更新OpenVINO到最新版本,以获取性能提升和新功能。

通过以上步骤,开发者能够在英特尔NUC或x86架构的CPU上配置好OpenVINO环境,充分利用硬件资源,高效地执行神经网络模型的推理任务。

438 浏览量

2022-08-03 上传

点击了解资源详情

248 浏览量

190 浏览量

449 浏览量

1059 浏览量

240 浏览量

点击了解资源详情

南城落叶

- 粉丝: 22

最新资源

- VC++挂机锁功能源码解析与下载

- 织梦公司企业通用HTML项目资源包介绍

- Flat-UI:Bootstrap风格的扁平化前端框架

- 打造高效动态的JQuery横向纵向菜单

- 掌握cmd命令:Windows系统下的命令提示符操作指南

- 在Linux系统中实现FTP客户端与服务器的C语言编程教程

- Ubuntu Budgie桌面环境安装全攻略:一键部署

- SAS9.2完整教程:掌握程序与数据集操作

- 精英K8M800-M2主板BIOS更新指南

- OkSocket:Android平台上的高效Socket通信框架

- 使用android SurfaceView绘制人物动画示例

- 提升效率的桌面快捷方式管理工具TurboLaunch

- 掌握AJAX与jQuery技术的全面指南

- Pandora-Downloader:结合Flask实现Pandora音乐下载及管理

- 基于RNN的Twitter情感预测模型:英文推文情绪分析

- 使用Python脚本合并具有相同前缀的PDF文件

已收录资源合集

已收录资源合集