深度学习驱动的视频显著性预测:DeepVS与OM-CNN与SS-ConvLSTM方法

122 浏览量

更新于2024-06-20

收藏 1.32MB PDF 举报

深度学习方法在视频显著性预测中的应用已经成为计算机视觉领域的热点话题,特别是在北京航空航天大学的研究团队的努力下。他们的研究聚焦于如何通过深度学习技术来准确预测视频中哪些区域最能吸引人类的视觉注意力。这项工作主要由赖江、麦旭、铁流和明朗四位研究人员合作完成,并且他们建立了一个名为LEDOV的大规模眼动跟踪视频数据库,包含了32名受试者的数据,这为理解人类注意力的规律提供了宝贵的数据基础。

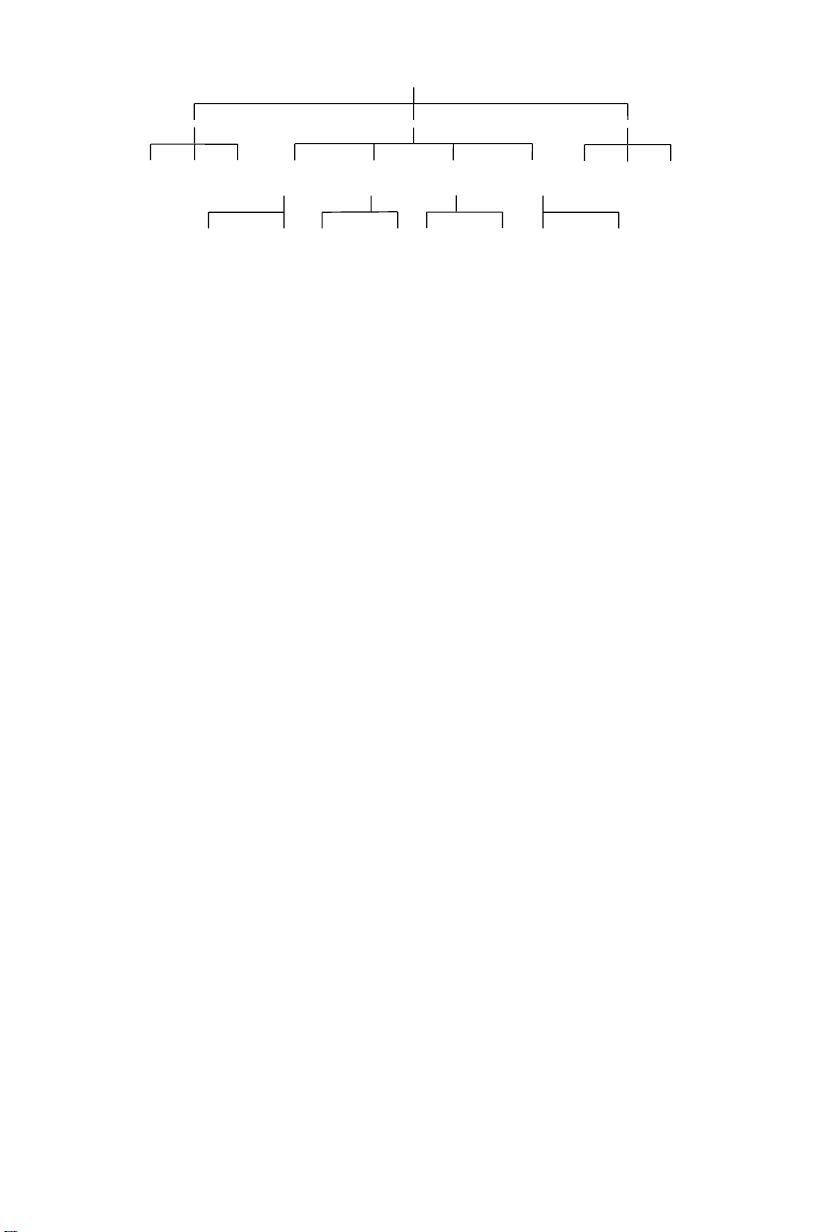

在他们的新方法DeepVS中,关键创新在于设计了一种名为对象到运动卷积神经网络(OM-CNN)。OM-CNN结合了对象子网的空间特征和运动子网的时间特征,引入了跨网掩码和层次特征归一化,旨在捕捉移动物体和移动部分对人类注意力的影响。这一设计反映出人类注意力往往更容易被动态的事物所吸引。

此外,研究人员还观察到人类的注意力在视频帧之间存在平滑的显著性过渡,这与HVS的中心凹机制相呼应。为此,他们提出了显着结构的卷积长短时记忆(SS-ConvLSTM)网络,利用OM-CNN提取的特征作为输入,能够生成视频帧间的显著性图,考虑到注意力图在连续帧之间的转移,同时考虑到了中心偏置的结构化输出。

与传统基于特征集成的视频显著性预测方法相比,DeepVS采用深度学习的方式,实现了端到端的学习,显著提高了预测精度。然而,尽管在图像显著性预测上取得了显著进展,但将深度学习应用于视频领域的研究仍相对较少,这表明DeepVS在该领域具有突破性的意义。

这篇论文不仅介绍了DeepVS的具体架构和技术细节,还强调了它在视频显著性预测任务中的潜在应用价值,特别是在视频压缩、动作识别和图像字幕生成等领域。通过LEDOV数据库和深度学习模型的结合,研究人员希望能够更精确地模拟和预测人类视觉系统的注意力行为,为未来视觉处理和人机交互提供新的视角和工具。

2018-05-17 上传

2021-09-19 上传

点击了解资源详情

2023-03-25 上传

2021-08-19 上传

2021-08-18 上传

2022-12-01 上传

2021-08-18 上传

2022-12-16 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- LockComputer_src.zip_单片机开发_C/C++_

- chanl:Common Lisp的基于通道的可移植并发

- uberAgent-crx插件

- paperless_meeting:山东大学项目实训无纸化会务系统

- CIS580-游戏1

- go-librato:成为Librato指标的客户端

- torch_scatter-2.0.7-cp38-cp38-macosx_10_9_x86_64whl.zip

- coinpaprika-api-swift-client:此库提供了在Swift中使用Coinpaprika.com API的便捷方法

- SerialPortTest.zip_串口编程_C#_

- AVRLCD-开源

- Helium 10-crx插件

- torch_cluster-1.5.9-cp37-cp37m-macosx_10_14_x86_64whl.zip

- ZPD

- crypto_compare:适用于Python的CryptoCompare.com API客户端

- EightNumbers.zip_Java编程_Java_

- file-structures:Go的文件结构(B + Tree,BTree)