理解感知器:从神经元到激活函数

75 浏览量

更新于2024-06-20

收藏 1.17MB PPTX 举报

"感知器-神经元模型与训练方法"

感知器是神经网络的基本构建单元,它模拟生物神经元的工作原理。在神经网络中,每个感知器接收多个输入信号,这些信号代表样本的不同特征,例如x1, x2, ..., xm。通过加权求和这些输入信号,并加上一个偏置项b,感知器可以对输入数据进行初步处理。权重w1, w2, ..., wm对应于每个输入特征的重要性,它们决定了输入信号对最终输出的影响程度。

感知器的数学模型可以表示为:

\[ \sigma(\sum_{i=1}^{m} w_i x_i + b) \]

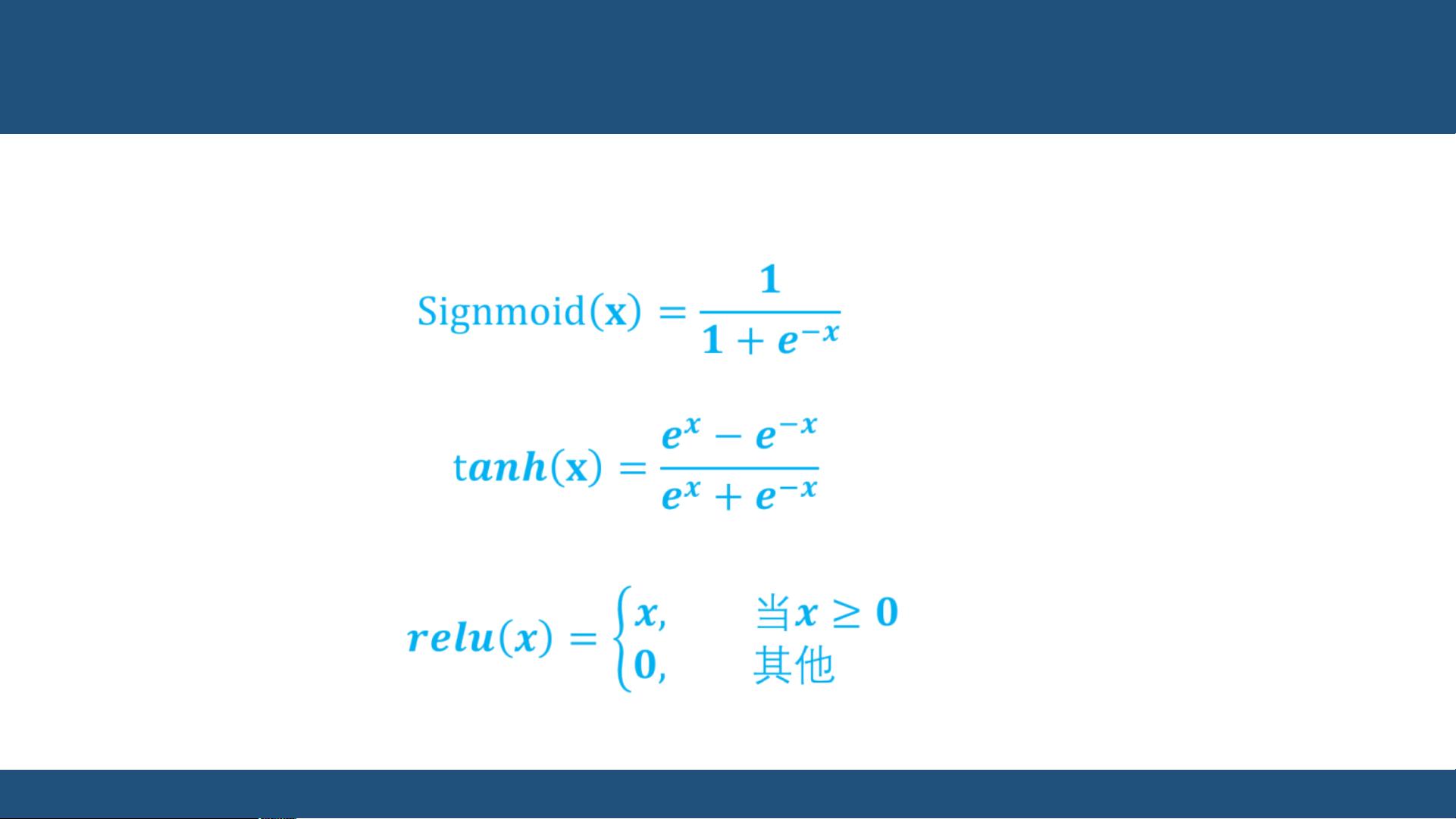

其中,σ是激活函数,它将加权求和的结果转化为输出。激活函数是感知器引入非线性的重要手段,因为它允许模型不仅能够处理线性可分问题,还能处理更复杂的非线性问题。常见的激活函数有sigmoid、tanh和ReLU。

1. Sigmoid函数(\(\sigma(x) = \frac{1}{1+e^{-x}}\))将任何实数值映射到(0, 1)区间,常用于二分类问题,因为它的输出可以解释为概率。

2. Tanh函数(\(\tanh(x) = \frac{e^x - e^{-x}}{e^x + e^{-x}}\))将值映射到(-1, 1),使得其输出中心化在0,这在某些情况下可能比sigmoid更优。

3. ReLU函数(\(\text{ReLU}(x) = \max(0, x)\))将所有小于0的输入设置为0,大于等于0的输入保持不变,它的导数简单且在正区间上恒为1,这有助于解决梯度消失问题,广泛应用于卷积神经网络。

感知器的训练通常采用监督学习方法,这意味着我们有一组带有标记的训练样本,即特征向量x和对应的正确输出y。训练的目标是调整权重w和偏置b,使模型能够准确预测给定输入的标记。在回归问题中,模型试图学习输入与输出之间的连续关系,如逻辑回归,它虽然名字中有“回归”,但实际上是用于解决二分类问题的一种监督学习算法。

无监督学习则不依赖于标记数据,它试图从原始数据中发现内在的结构或模式。聚类是一种常见的无监督学习方法,通过相似性度量将数据分组成不同的类别。半监督学习则介于两者之间,它利用少量标记数据和大量未标记数据来训练模型,通过聚类等方法为未标记数据创建虚拟标记,从而扩大有标记数据的规模。

在实际应用中,感知器作为简单的神经网络单元,常被用作深度学习模型的基础层。PyTorch等深度学习框架提供了便利的接口来实现和训练感知器,用户可以通过这些框架轻松地搭建和优化感知器模型,以解决各种实际问题,如图像识别、自然语言处理等。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-06-03 上传

2016-07-02 上传

2021-09-20 上传

2016-07-02 上传

2021-05-30 上传

LinlyZhai

- 粉丝: 172

- 资源: 9

最新资源

- hearthstone_battlegrounds_simulator

- resilient-microservices-dotnet-polly:此仓库包含有关Code Maze的“使用Polly在.NET中创建弹性微服务”文章的源代码。

- my-java-explore:对jdk的一些探索

- AWS Console Shape Shifter-crx插件

- HesaiLidar_General_ROS:PandarXT PandarQT Pandar64 Pandar40P Pandar40M Pandar20A Pandar20B的ROS驱动程序

- homework1_:第一次作业

- 图形包装器:包装器改进了Matlab图形组件。-matlab开发

- 蓝色科技商务下载PPT模板

- pb untag-crx插件

- 音乐生活娱乐网站模板是一款html5模板,适合娱乐休闲类网站模板下载。.zip

- Sensente.github.io

- spg框架

- 绚丽的夜空流星雨动画下载PPT模板

- 零基础学keil5安装教程(超详细) keil5mdk安装步骡

- valet-dashboard

- 团队项目2