Transformer详解:自注意力机制与深度学习应用

需积分: 0 196 浏览量

更新于2024-06-30

1

收藏 3.19MB PPTX 举报

Transformer是一种革命性的神经网络架构,最初由 Vaswani 等人在2017年的论文《Attention is All You Need》中提出,主要用于自然语言处理(NLP)任务,如机器翻译和文本生成。它基于自注意力机制(Self-Attention),这是一个核心组件,允许模型关注输入序列中的不同部分,而非仅仅依赖于固定长度的上下文窗口。

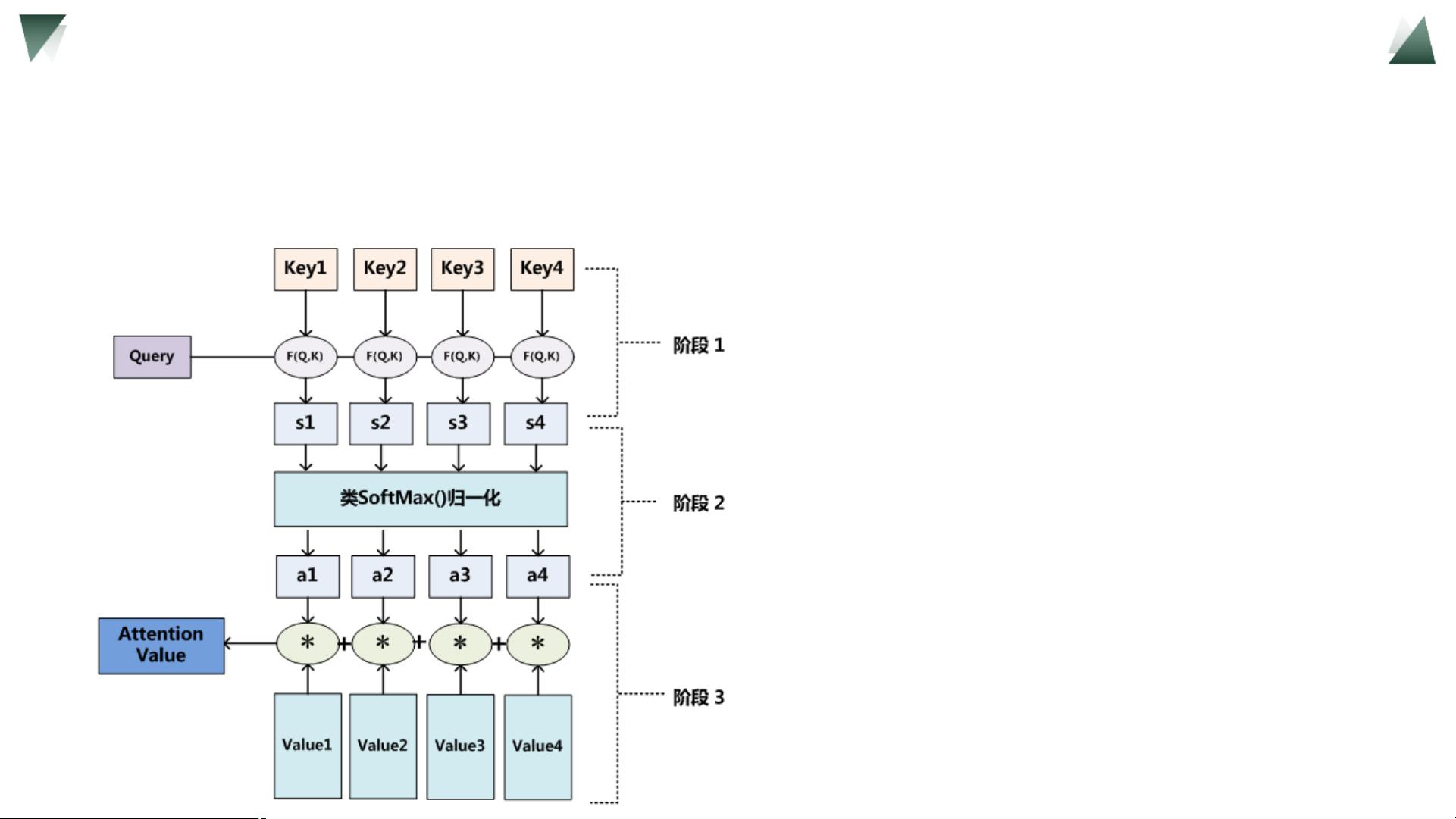

在Transformer组会上,汇报人杨威于2022年9月14日讨论了Self-attention的原理。Self-attention的基本思想是,每个输入元素(称为query,用Q表示)都会与其他所有元素(称为key,用K表示)进行点积计算,生成一个注意力得分。这个得分经过softmax函数处理,使得得分被归一化,以便所有元素的总和为1,反映了query对其他元素的“注意力”程度。同时,每个元素还关联着一个值(value,用V表示),这些值会在根据注意力得分加权后相加,形成对query的响应。

在更复杂的模型中,如Transformer,Q、K和V通常会被映射到不同的特征空间,通过线性变换(例如,用WQ、WK和WV表示)来提高模型的表达能力。这样做的目的是为了使模型能够更好地捕捉输入的不同方面,并且允许对于输入的不同部分赋予不同的注意力权重。

与传统的循环神经网络(RNN)如LSTM不同,Transformer避免了长序列处理中的梯度消失和梯度爆炸问题,因为它具有并行计算的能力,可以直接处理整个序列,无需逐个时间步进行计算。然而,当Self-Attention模型应用于大规模数据时,softmax层可能会导致softmax分配过于集中在某个最大值上,特别是当某些维度的值数量级较大时,这可能导致梯度消失问题。为了解决这个问题,研究人员通常采用技巧如添加正则化项或使用其他注意力机制变体,如位置编码或多头注意力(Multi-Head Attention),来平衡模型的性能和训练稳定性。

Transformer组会PPT的核心内容涵盖了Transformer模型的自注意力机制,包括其计算流程(查询、键和值的交互)、如何利用softmax进行注意力分布以及如何通过变换和多头注意力改善模型的性能。此外,它还强调了Transformer在处理长序列依赖问题上的优势,以及与传统模型如LSTM的比较。

2021-04-22 上传

2024-06-18 上传

2009-09-23 上传

2022-04-23 上传

2024-01-22 上传

2023-11-02 上传

威威的程序人生

- 粉丝: 6

- 资源: 4

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用