Hadoop源代码解析:分布式计算基础

需积分: 41 126 浏览量

更新于2024-07-27

收藏 5.99MB PDF 举报

“Hadoop源代码分析(完整版).pdf”主要探讨了Google的分布式计算基础设施以及Apache Hadoop项目,这些技术在云计算和分布式领域具有重要地位。文件提到了Google的五篇核心技术论文,包括GoogleCluster、Chubby、GFS、BigTable和MapReduce,这些技术后来在Apache Hadoop中得到了实现,分别对应为ZooKeeper、HDFS、HBase和Hadoop MapReduce。此外,文件还提及了类似思想的开源项目,如Facebook的Hive。

在Hadoop项目中,HDFS(Hadoop Distributed File System)作为分布式文件系统是基础,它提供了API来隐藏底层的本地文件系统或分布式文件系统,甚至支持像Amazon S3这样的在线存储系统。这种设计导致了复杂的包间依赖关系,尤其是因为HDFS和MapReduce紧密关联。MapReduce是处理大规模数据的计算框架,它依赖于HDFS来存储和处理数据。

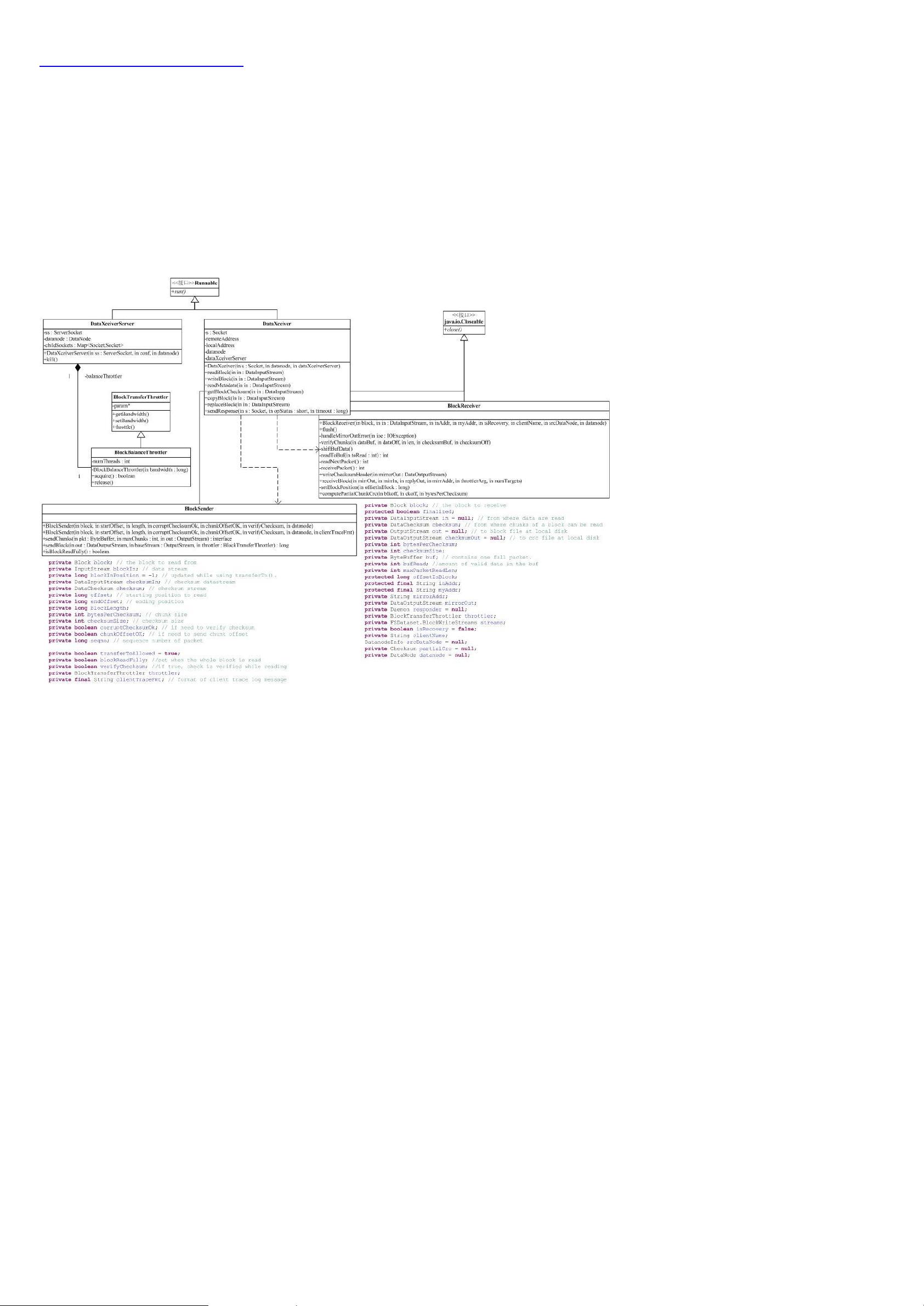

Hadoop的包结构和依赖关系图显示了一个蜘蛛网状的结构,其中conf包用于读取系统配置,依赖于fs包以实现文件系统操作。关键组件集中在图中的蓝色部分,这部分是分析的重点。

接下来,文件对Hadoop的各个包进行了功能分析,例如,tool包提供了命令行工具,如DistCp和archive,mapred包涉及MapReduce的实现。通过对这些核心组件的深入理解,可以更好地掌握Hadoop如何在分布式环境中处理和存储大数据。

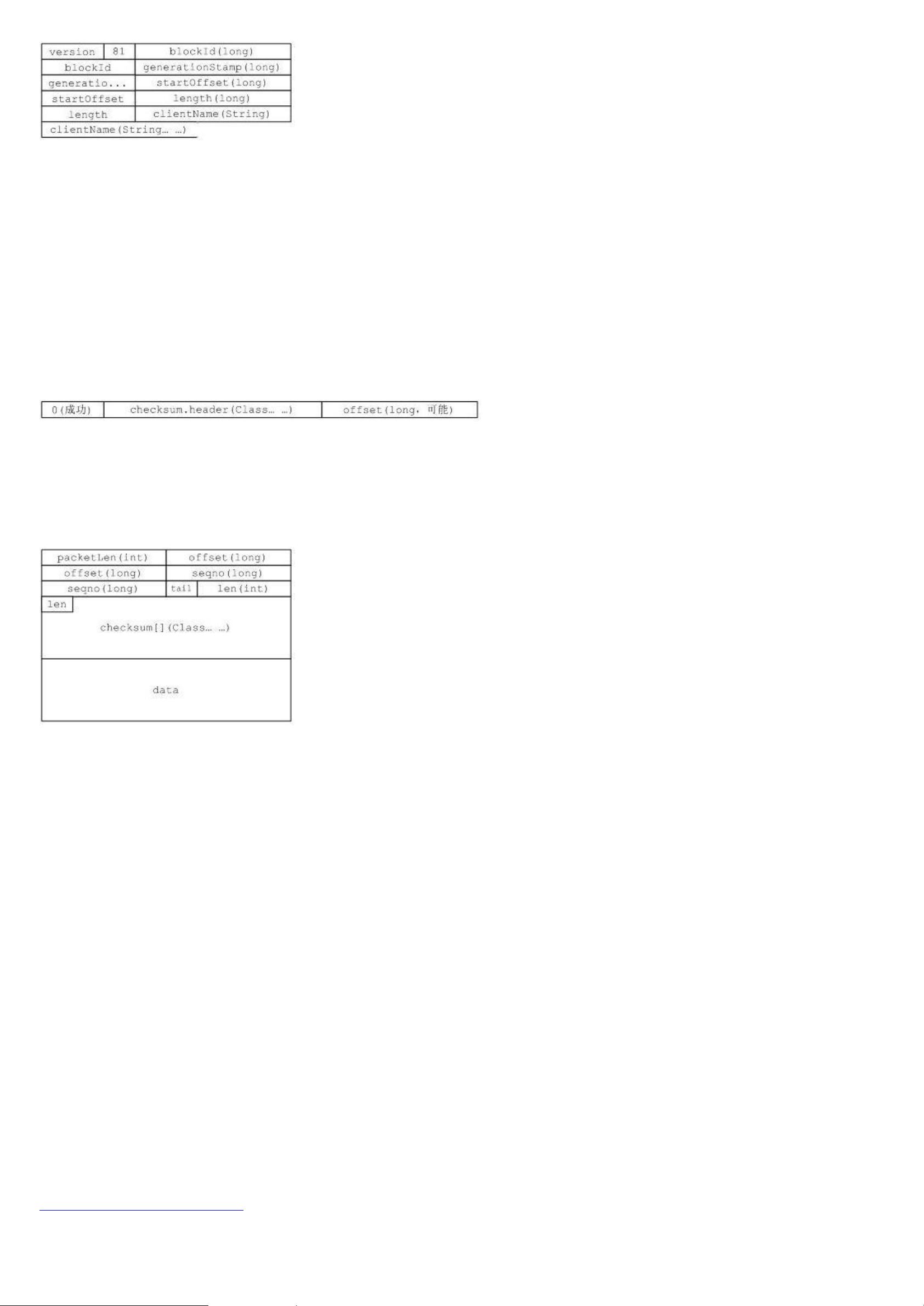

Hadoop源代码分析涵盖了HDFS的内部工作原理,包括数据块的分布、副本策略、数据读写流程,以及MapReduce的作业生命周期管理、任务调度、数据分片和并行处理机制等。HDFS的设计目标是高容错性和高吞吐量,而MapReduce则简化了大规模数据处理的编程模型,使得开发者可以专注于映射和化简两个阶段的逻辑,而无需关心底层的分布式执行细节。

这份资源对于理解分布式计算、云存储和大数据处理的实践有着重要的价值,特别是对于那些想要深入了解Hadoop架构和实现细节的IT专业人士来说。通过源代码分析,读者能够学习到如何利用Hadoop解决实际问题,以及如何优化和调整Hadoop集群的性能。

2017-06-18 上传

2011-11-22 上传

2020-10-31 上传

2018-02-27 上传

2011-10-25 上传

2013-01-22 上传

2018-10-11 上传

2017-05-14 上传

JessonLv

- 粉丝: 52

- 资源: 92

最新资源

- Control App for ESI MAYA22 USB:这是ESI MAYA22 USB音频接口的控制应用程序-开源

- phonebook_backend:电话簿的后端React APP

- CHIP8

- learn-mysql

- form-data-helper:替换 FormData 对象的 Javascript 插件。 用例

- 行业分类-设备装置-同步媒体处理.zip

- link-rest-dropwizard:一个简单的项目,演示将LinkRest与Dropwizard一起使用

- MediaPcInstaller:将grub2,Lakka和OpenElec安装到磁盘并设置为启动

- v-date-picker

- flutter-disenos-seccion8:Flutter课程的全新第8节

- 易语言聊天菜单源码-易语言

- Methods-of-collecting-and-processing-data-from-the-Internet

- 行业分类-设备装置-可高效稳定拔除钢结构体钢板桩的水利湖泊防洪堤修建机.zip

- welcome:xyao99的主页!

- request-api:简单的要求

- certifiacte-generator:在线证书生成器