机器学习中的关键数学概念:李普希茨连续性与逻辑斯蒂函数

需积分: 3 63 浏览量

更新于2024-08-03

收藏 429KB PDF 举报

"本文主要介绍了机器学习中涉及的高等数学概念,包括李普希茨连续性、logistic函数及其应用,以及一些常见的神经网络激活函数,如softplus、ReLU和绝对值函数。这些知识点在构建和分析机器学习模型时起到关键作用。"

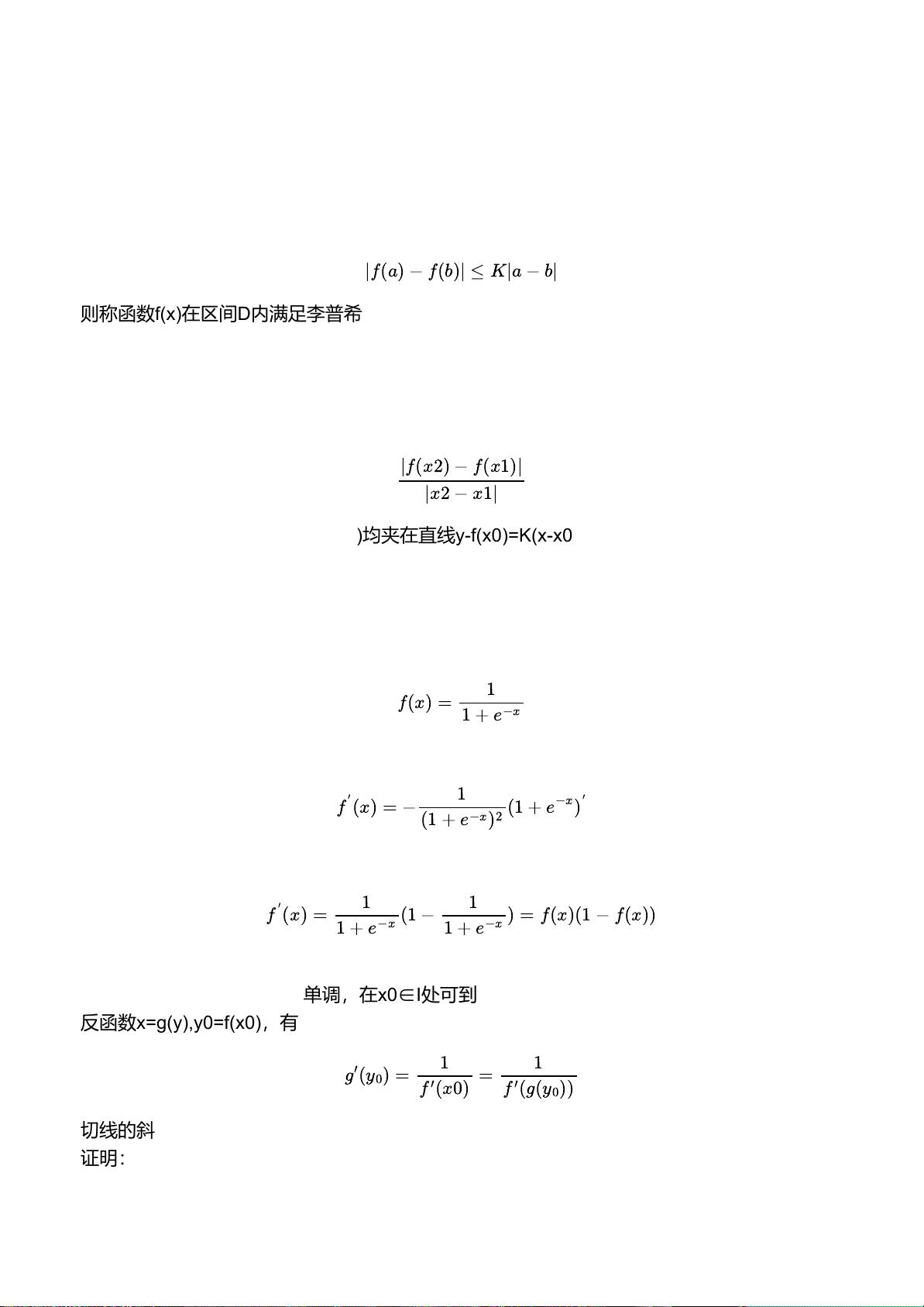

一、李普希茨连续性

在机器学习中,理解函数的连续性和稳定性至关重要,因为这直接影响到算法的收敛性和预测性能。李普希茨连续性是一种更强的连续性形式,它限制了函数变化速率的最大值。如果一个函数f(x)在区间D内满足李普希茨条件,即存在常数K,使得对于区间内的任意两点a和b,函数值差的绝对值不超过K乘以它们横坐标差的绝对值,那么f(x)就是一个李普希茨连续函数。李普希茨常数K反映了函数局部变化的幅度,K<1的函数是压缩映射,有助于保证算法的稳定性和收敛性。

二、logistic函数

logistic函数,也称为sigmoid函数,是机器学习中的重要组成部分,特别是在神经网络中作为激活函数使用。它的表达式为f(x) = 1 / (1 + e^(-x))。通过对logistic函数进行求导,我们可以得到其导数f'(x) = f(x) * (1 - f(x)),这个性质使得它在优化过程中具有良好的可微性。同时,logistic函数的反函数导数与其原函数的导数互为倒数,这在计算反向传播时非常有用。

三、神经网络激活函数

1. softplus函数:作为ReLU函数(最大值为0的线性函数)的平滑近似,其表达式为f'(x) = ln(1 + e^x)。它的导数是logistic函数,使得它在x=0处连续,避免了ReLU函数在0处的导数不连续问题。

2. ReLU函数:定义为f(x) = {x, x > 0; 0, x ≤ 0},在x=0处不可导,但其简单性和非线性特性使其成为深度学习中广泛应用的激活函数,有助于解决梯度消失问题。

3. 绝对值函数:定义为f(x) = |x|,在x=0处不可导,但在其他点上导数为1(当x>0)或-1(当x<0)。在正则化项中使用绝对值函数可以帮助惩罚模型参数的大小,促进模型的泛化能力。

4. 符号函数:定义为f(x) = {1, x > 0; -1, x < 0},其导数为阶跃函数,虽然在机器学习中不常用作激活函数,但在某些信号处理和分类任务中可能会出现。

这些函数在机器学习中的应用不仅限于作为激活函数,还涉及到损失函数、正则化项等重要组件的设计,对于理解和改进机器学习模型的性能至关重要。通过深入理解这些数学概念,可以更好地优化模型,提高预测准确性和泛化能力。

111 浏览量

142 浏览量

点击了解资源详情

336 浏览量

215 浏览量

566 浏览量

335 浏览量

2024-07-18 上传

2021-10-26 上传

Sɪʟᴇɴᴛ໊ོ5329

- 粉丝: 936

最新资源

- 初学者入门必备!Visual C++开发的连连看小程序

- C#实现SqlServer分页存储过程示例分析

- 西门子工业网络通信例程解读与实践

- JavaScript实现表格变色与选中效果指南

- MVP与Retrofit2.0相结合的登录示例教程

- MFC实现透明泡泡效果与文件操作教程

- 探索Delphi ERP框架的核心功能与应用案例

- 爱尔兰COVID-19案例数据分析与可视化

- 提升效率的三维石头制作插件

- 人脸C++识别系统实现:源码与测试包

- MishMash Hackathon:Python编程马拉松盛事

- JavaScript Switch语句练习指南:简洁注释详解

- C语言实现的通讯录管理系统设计教程

- ASP.net实现用户登录注册功能模块详解

- 吉时利2000数据读取与分析教程

- 钻石画软件:从设计到生产的高效解决方案