ONNX:多框架神经网络交换格式与部署指南

需积分: 9 81 浏览量

更新于2024-08-04

收藏 701KB DOCX 举报

ONNX(Open Neural Network Exchange)是一个开放的、跨框架的机器学习模型交换标准,它的出现旨在解决深度学习框架之间互操作性和模型部署的兼容性问题。ONNX的核心理念是通过一种通用的计算图格式,使得不同的深度学习框架如CNTK、Caffe2、Theano、TensorFlow、PyTorch和Chainer等能够共享模型定义,从而简化模型在不同平台上的迁移和部署。

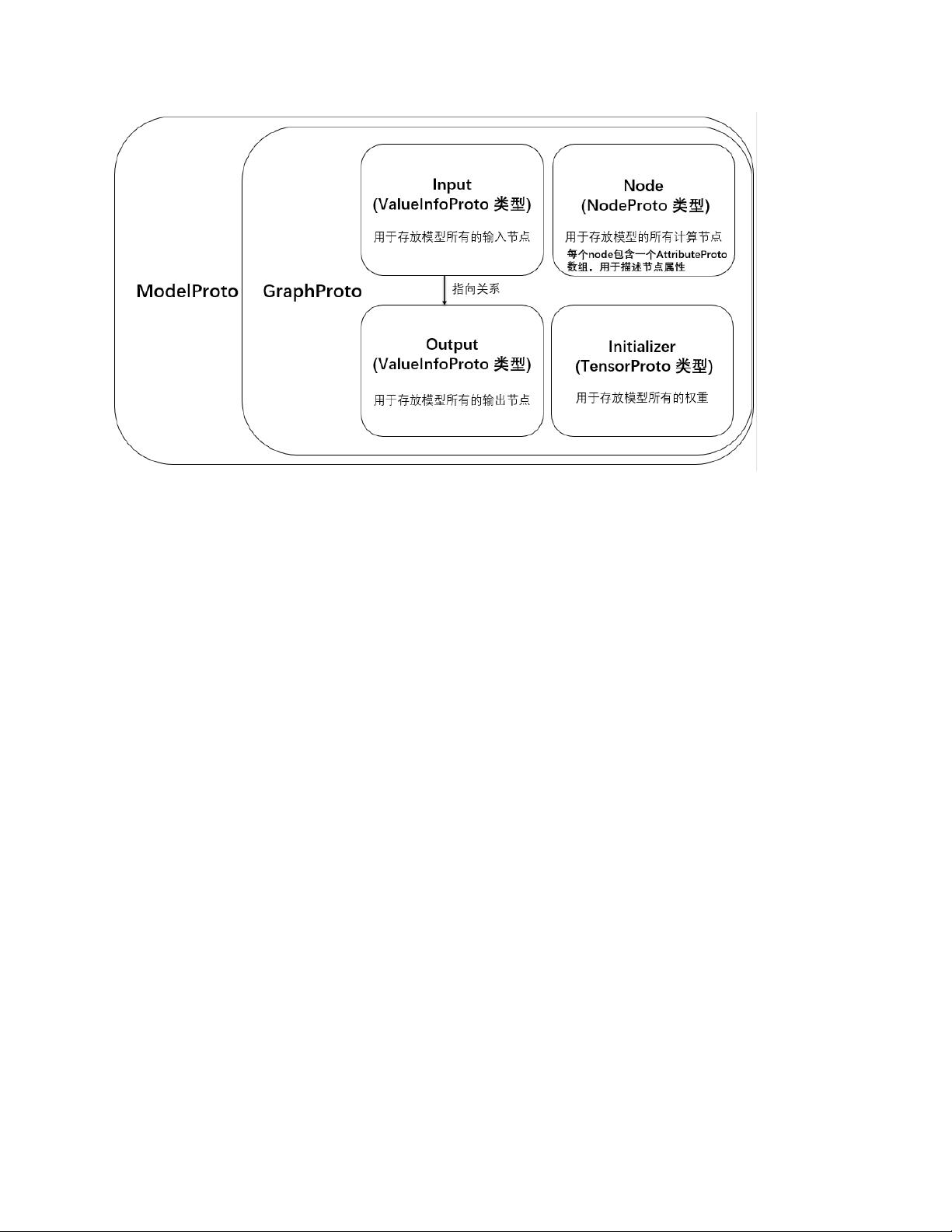

ONNX协议的基础是使用Google的Protocol Buffers(简称Protobuf)二进制格式进行模型的序列化。Protobuf是一种轻量级的数据交换格式,通过定义结构化的数据类型,使得数据能够在不同的系统间以紧凑的二进制形式传输,同时保持数据结构的一致性。ONNX协议定义了一系列标准化的节点(ops)和数据类型,这些节点代表了神经网络中的各种运算和层,如线性层、卷积层、激活函数等。

在ONNX模型中,关键元素包括:

1. **模型结构**:ONNX模型描述了神经网络的拓扑结构,包括输入和输出张量(tensor)、运算符的连接顺序和参数设置。这些信息对于理解和执行模型至关重要。

2. **权重和参数**:模型的权重存储在网络的各个层中,包括权重矩阵、偏置值等。这些数值反映了神经网络的训练结果,用于实际的推理过程。

3. **计算图**:ONNX采用静态图的形式来表示模型,这意味着整个计算流程在模型构建时就已经确定,这与动态图(如PyTorch)有所不同。静态图更利于优化和跨平台部署。

4. **通用性**:ONNX的设计目标是让开发者能够在任何支持ONNX的环境中部署模型,无论其原始框架如何。这意味着开发者可以利用现有的工具链对模型进行简化、优化和量化,以适应不同的硬件需求。

学习ONNX涉及以下几个步骤:

- **入门**:了解ONNX的基本概念、协议和数据结构,学习如何将现有模型导出为ONNX格式。

- **转换**:熟悉如何使用ONNX工具(如onnxmltools、onnx-simplifier和optimizer)将模型从一种框架转换到另一种框架,或优化模型以提高性能。

- **使用**:理解如何在新的环境中加载和运行ONNX模型,比如在Python环境中使用onnxruntime或TensorFlow Serving。

ONNX通过提供统一的模型描述语言和通用计算图,降低了深度学习模型在不同框架之间的迁移壁垒,提升了模型的可移植性和部署效率,是推动AI技术广泛应用的关键技术之一。

2021-02-05 上传

2021-05-25 上传

2021-04-28 上传

2023-07-13 上传

2021-10-01 上传

2018-07-16 上传

2021-02-05 上传

2024-03-03 上传

Ysn0719

- 粉丝: 626

- 资源: 19

最新资源

- 单片机串口通信仿真与代码实现详解

- LVGL GUI-Guider工具:设计并仿真LVGL界面

- Unity3D魔幻风格游戏UI界面与按钮图标素材详解

- MFC VC++实现串口温度数据显示源代码分析

- JEE培训项目:jee-todolist深度解析

- 74LS138译码器在单片机应用中的实现方法

- Android平台的动物象棋游戏应用开发

- C++系统测试项目:毕业设计与课程实践指南

- WZYAVPlayer:一个适用于iOS的视频播放控件

- ASP实现校园学生信息在线管理系统设计与实践

- 使用node-webkit和AngularJS打造跨平台桌面应用

- C#实现递归绘制圆形的探索

- C++语言项目开发:烟花效果动画实现

- 高效子网掩码计算器:网络工具中的必备应用

- 用Django构建个人博客网站的学习之旅

- SpringBoot微服务搭建与Spring Cloud实践