线性代数在机器学习中的应用

需积分: 0 53 浏览量

更新于2024-08-05

收藏 536KB PDF 举报

"线性代数是数学的重要分支,在机器学习和深度学习中有着广泛应用,如矩阵分解和神经网络模型。核心概念包括标量、向量、矩阵和张量。线性代数运算涵盖转置、广播、乘法、范数等,并涉及到单位矩阵、逆矩阵等特殊矩阵以及对角矩阵的概念。"

线性代数中的基本概念:

1. 标量(Scaler):简单的数值,是数学中最基础的元素。

2. 向量(Vector):一组按特定顺序排列的数,通常以行或列的形式表示,是线性代数的基本构建块。

3. 矩阵(Matrix):二维数组,每个元素由两个索引定位,矩阵运算广泛用于数据变换和线性方程组求解。

4. 张量(Tensor):多维数组,扩展了向量和矩阵的概念,常在深度学习中处理多维数据。

关键运算和性质:

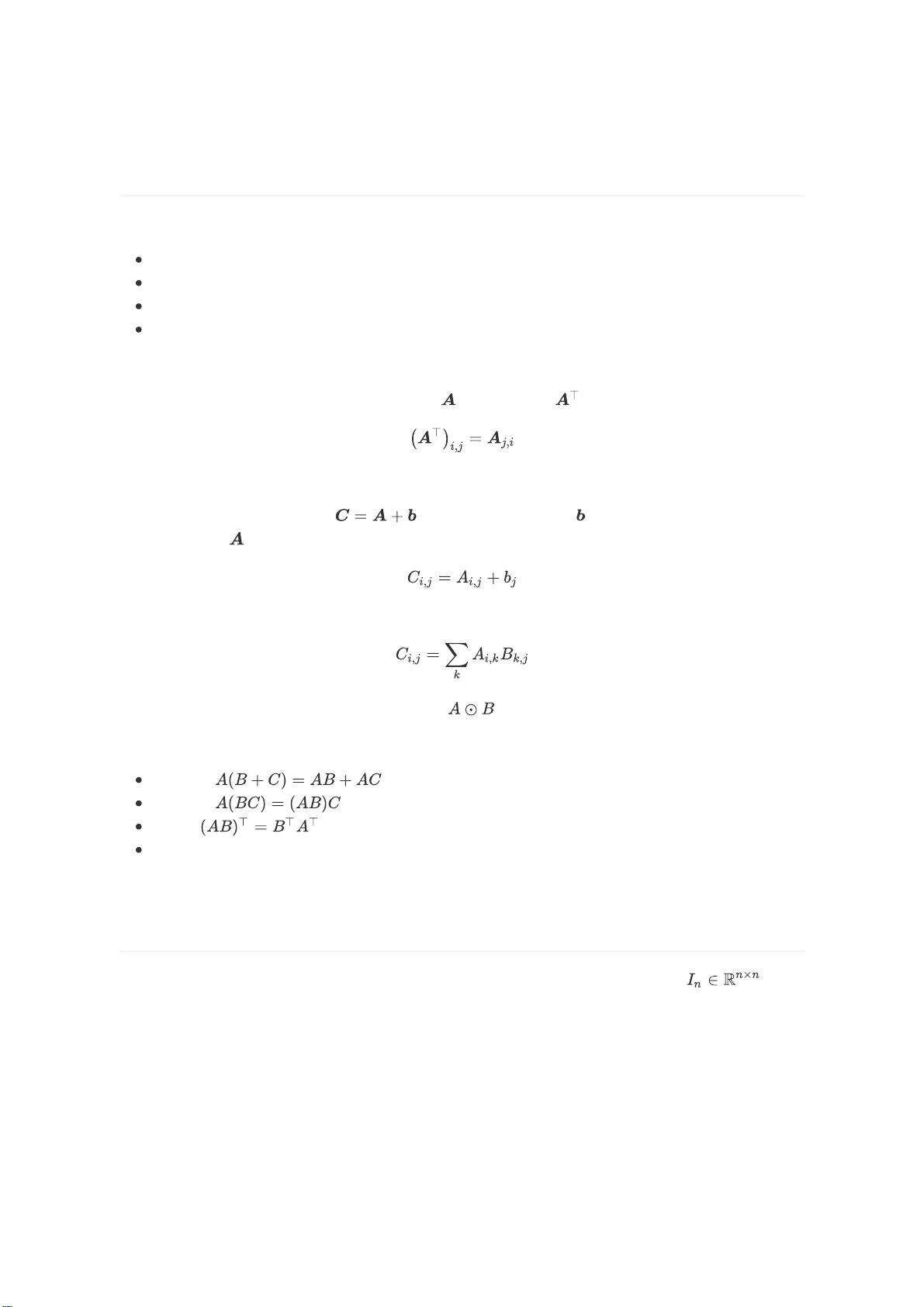

1. 转置(Transpose):矩阵的转置是沿着对角线翻转,对于列向量,转置变成行向量。

2. 广播(Broadcasting):在向量和矩阵相加时,系统自动将向量扩展以匹配矩阵的形状,简化运算。

3. 乘法:包括点积(内积)和Hadamard乘积。点积是行与列对应元素相乘后求和;Hadamard乘积是对应元素相乘。

4. 乘法性质:乘法满足分配率、结合率和转置规则,但一般不满足交换律。

5. 单位矩阵(Identity Matrix):主对角线元素为1,其余为0,与任何矩阵相乘都不会改变原始矩阵。

6. 逆矩阵(Inverse Matrix):如果存在,逆矩阵乘以原矩阵得到单位矩阵,是解决线性方程组的关键。

范数与距离:

1. 范数(Norm):衡量向量大小的函数,如

范数(欧几里得范数)、

范数(曼哈顿范数)和

范数(无穷范数)。

2. 平方

范数:常用作正则化项,衡量模型复杂度,其导数仅依赖于单个元素,方便优化。

3.

范数:区分接近零的元素和真正为零的元素,常用于稀疏数据表示。

4. 点积与范数关系:两个向量的点积可以用范数表示,揭示向量间的角度信息。

特殊矩阵类型:

1. 对角矩阵(Diagonal Matrix):只有主对角线上的元素非零,可以由向量生成,与向量的乘法运算简单直接。

这些概念构成了线性代数的基础,是理解和应用机器学习算法的关键。通过深入理解这些概念及其运算规则,我们可以更好地解决实际问题,如优化模型参数、分析数据结构和构建有效的预测系统。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-08 上传

2021-10-01 上传

2021-10-01 上传

2021-09-30 上传

2021-10-02 上传

2021-10-18 上传

嗨了伐得了

- 粉丝: 26

- 资源: 290

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率