深度解析卷积运算在推理中的优势与实现

需积分: 5 3 浏览量

更新于2024-06-28

收藏 1.32MB PDF 举报

《深度学习推理中的卷积分析入门资料》是一份于2016年6月24日发布的技术文档,由Scott Gray编撰,来自Nervana Systems,该公司的标志是“让机器更智能”。这份文件主要探讨了卷积运算在深度学习模型推理阶段的关键概念和技术细节。

文档的核心焦点在于理解卷积层在计算过程中的高效实现,特别是针对小型神经网络(SmallN)的直接卷积(Direct Convolution)。它涉及以下几个关键点:

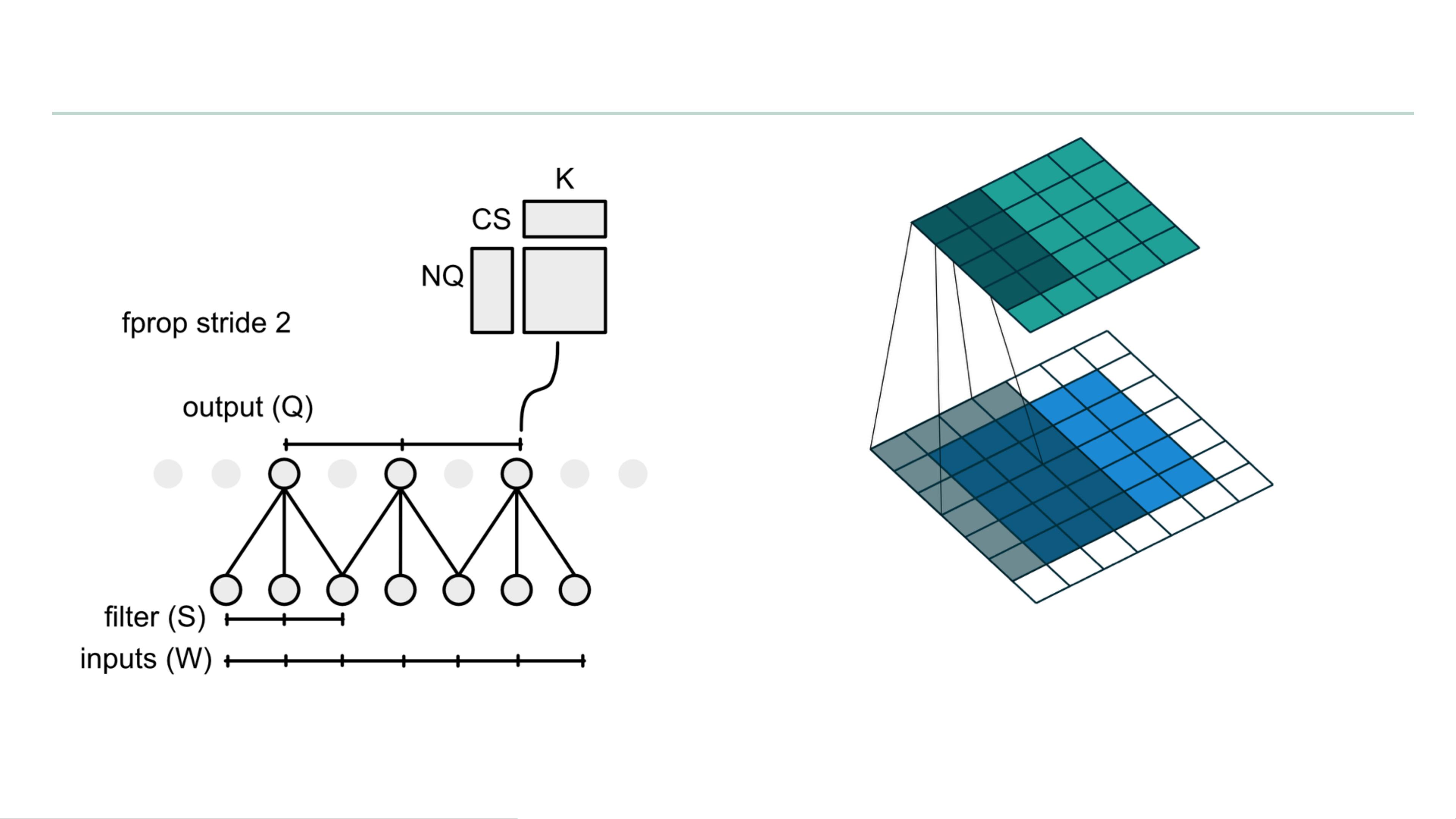

1. **直接卷积**:该方法强调在内层切片上进行计算,并利用矩阵乘法(GEMM)操作。这种设计考虑了数据布局,通常采用C、H、W、N(通道、高度、宽度和批大小)的顺序,以最小化切片逻辑,最大化连续访问内存,同时利用滤波器之间的重叠区域以提高性能。

2. **小神经网络的直接卷积(无超级块划分)**:介绍了一个简单的卷积公式,计算输入特征图(fprop)时,如何根据输入尺寸(W)、滤波器大小(S)、填充(pad)、步长(stride)来确定输出特征图的索引(Q)和权重的索引(wi)。

3. **小神经网络的直接卷积(带超级块划分)**:当涉及到更大的内存优化策略时,文档还讨论了超级块划分如何进一步提升性能,通过将大块数据组织在一起处理。

4. **反向传播(Bprop)**:对于去卷积(deconvolution)或反向传播,提供了更新偏置项的方法,其中pad'、Wi的计算与正向传播略有不同,涉及调整填充值和位置。

5. **膨胀卷积(Dilated Filters)**:膨胀卷积通过增大滤波器的步距(rate),保持相同的感受野(receptive field),但减少了实际参数的数量。文档展示了膨胀卷积的计算公式,其中S'是原始步距经过膨胀后的值。

这份文档不仅介绍了理论概念,还可能包含具体的代码示例和对性能影响的评估,使得读者能够深入理解如何在实践中优化卷积操作,尤其是在资源有限的硬件上实现高效的深度学习推理。通过阅读这份资料,初学者和专业人士都可以获得关于卷积层在深度学习中如何高效运作的宝贵见解。

2018-03-04 上传

2018-04-15 上传

2011-12-21 上传

2020-01-02 上传

2022-05-17 上传

2024-06-30 上传

2021-09-20 上传

承让@

- 粉丝: 8

- 资源: 380

最新资源

- WPF渲染层字符绘制原理探究及源代码解析

- 海康精简版监控软件:iVMS4200Lite版发布

- 自动化脚本在lspci-TV的应用介绍

- Chrome 81版本稳定版及匹配的chromedriver下载

- 深入解析Python推荐引擎与自然语言处理

- MATLAB数学建模算法程序包及案例数据

- Springboot人力资源管理系统:设计与功能

- STM32F4系列微控制器开发全面参考指南

- Python实现人脸识别的机器学习流程

- 基于STM32F103C8T6的HLW8032电量采集与解析方案

- Node.js高效MySQL驱动程序:mysqljs/mysql特性和配置

- 基于Python和大数据技术的电影推荐系统设计与实现

- 为ripro主题添加Live2D看板娘的后端资源教程

- 2022版PowerToys Everything插件升级,稳定运行无报错

- Map简易斗地主游戏实现方法介绍

- SJTU ICS Lab6 实验报告解析