最大熵方法在自然语言处理中的应用

需积分: 34 79 浏览量

更新于2024-07-21

收藏 1.79MB PDF 举报

"本文探讨了一种基于最大熵的方法在自然语言处理中的应用。作者通过引入最大熵模型,提出了一种最大似然方法来自动构建这些模型,并详细阐述了如何高效地实现这一方法,以自然语言处理中的多个问题为例进行说明。"

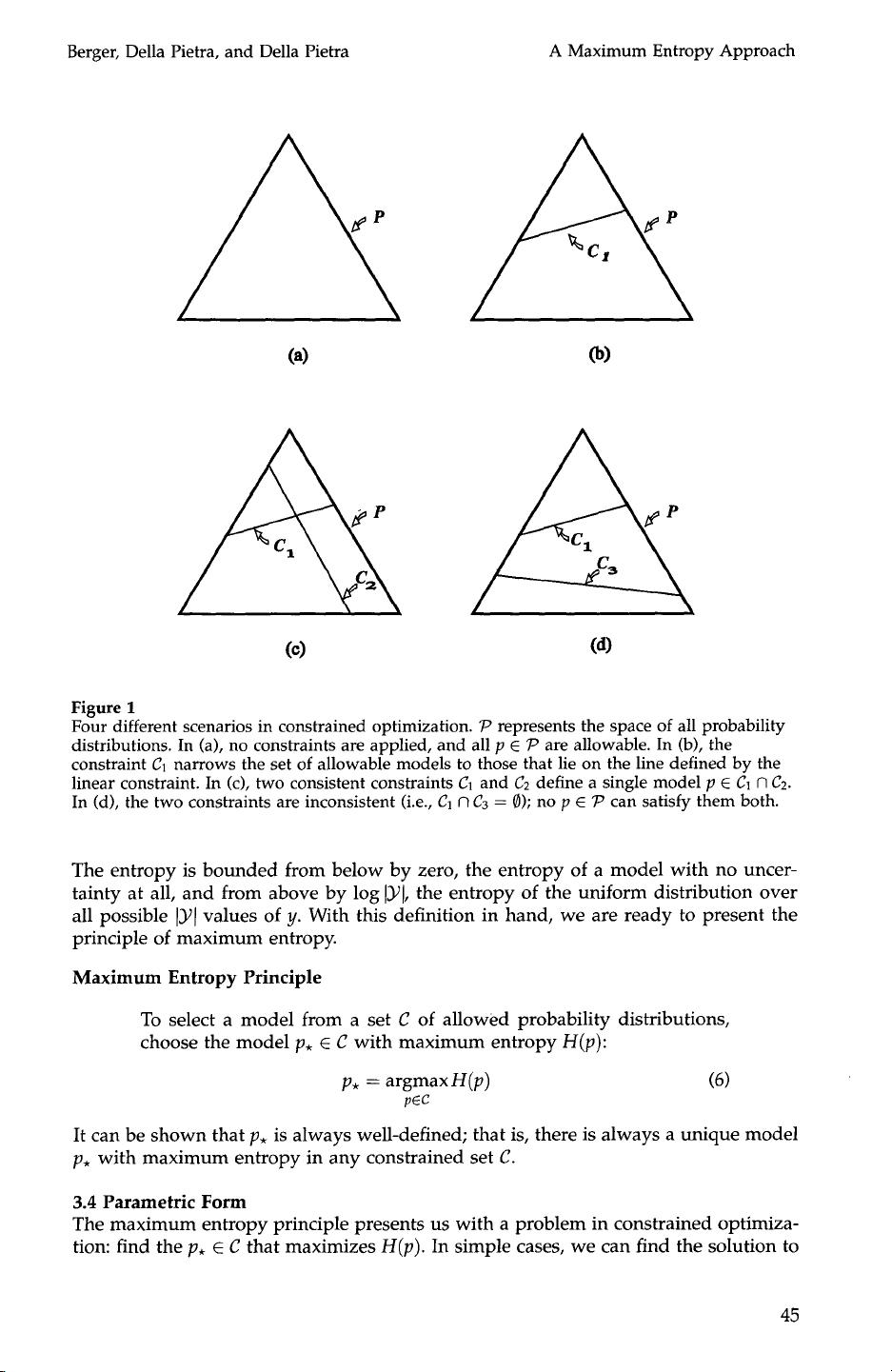

在自然语言处理(NLP)领域,最大熵模型是一种广泛应用的统计建模技术。这个概念虽然历史悠久,但直到计算机计算能力显著增强后,才得以广泛应用于实际的统计估计和模式识别问题。最大熵模型的核心思想是,在所有可能的概率分布中,选择最不确定(即熵最大)的那个分布,同时满足已知的约束条件。这种方法确保了模型的泛化能力和避免过拟合。

1. 最大熵模型的理论基础

最大熵原理源于信息论,由香农提出,它主张在所有可能的分布中选择熵最大的那个,以反映我们对系统的无知程度。在NLP中,这意味着在满足特定先验知识或观察数据的条件下,模型选择的是最不偏见、最不确定的预测。

2. 最大似然估计

在构建最大熵模型时,通常采用最大似然估计法。这种方法要求找到使得数据出现概率最大的模型参数。在NLP任务中,这通常涉及计算词汇、短语或其他语言特征的频率,然后调整模型参数以最大化这些特征在训练数据中出现的概率。

3. 自动构建模型

论文中提到的自动构建最大熵模型的方法,涉及到对大量语言数据的分析和学习。这可能包括词频统计、n-gram模型、条件随机场等技术,通过迭代优化过程确定模型参数,以最佳地匹配训练数据。

4. 效率优化

在实际应用中,如何高效地实现最大熵模型至关重要。这可能涉及使用如拉普拉斯平滑、特征选择和剪枝等技术,以减少计算复杂性和防止过拟合。此外,高效的数值优化算法,如梯度下降法或L-BFGS,也被用于寻找最优模型参数。

5. 应用实例

在NLP中,最大熵模型常用于句法分析、词性标注、情感分析、命名实体识别等多种任务。论文中可能列举了如词性标注的例子,展示如何利用最大熵模型来预测给定词汇在句子中的角色。

6. 结论与未来工作

作者可能讨论了这种方法的优势和局限性,以及未来可能的研究方向。例如,如何结合深度学习方法进一步提升模型性能,或者如何处理大规模数据和高维度特征等问题。

"A Maximum Entropy Approach to Natural Language Processing"这篇论文深入探讨了最大熵模型在NLP中的应用,提供了构建和优化这些模型的实用方法,并通过具体示例展示了其在解决自然语言问题上的有效性。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2015-07-30 上传

2021-04-28 上传

2022-01-03 上传

2021-02-10 上传

2023-01-06 上传

2021-03-22 上传