Spark on Yarn集群详细搭建指南

需积分: 49 156 浏览量

更新于2024-09-08

收藏 572KB DOCX 举报

"Spark on Yarn集群搭建手册旨在详述如何在Yarn上构建Spark集群,以优化大数据处理。本文档适用于对Spark和Hadoop有基础认知的学习者,特别是使用Ubuntu 16.04 LTS和CentOS 7操作系统的环境。搭建过程中涉及的主要软件版本包括Scala 2.10.6、Hadoop 2.7.2、Spark 1.6.1-bin-hadoop2.6以及Java 1.8.0_77。硬件环境包括一个Master节点和两个Slave节点,具有相似的配置。"

Spark on Yarn集群的搭建流程:

1. **软件环境准备**:

在所有节点上安装相同版本的软件,包括Ubuntu或CentOS操作系统、Scala、Hadoop、Spark以及Java。确保所有软件版本与Hadoop的版本兼容,因为Spark需要与Hadoop共同运行。

2. **配置hosts文件**:

更新每台机器的`/etc/hosts`文件,添加所有节点的IP地址和主机名映射。这有助于集群内的节点间通信。如果配置错误,可能导致集群启动失败。

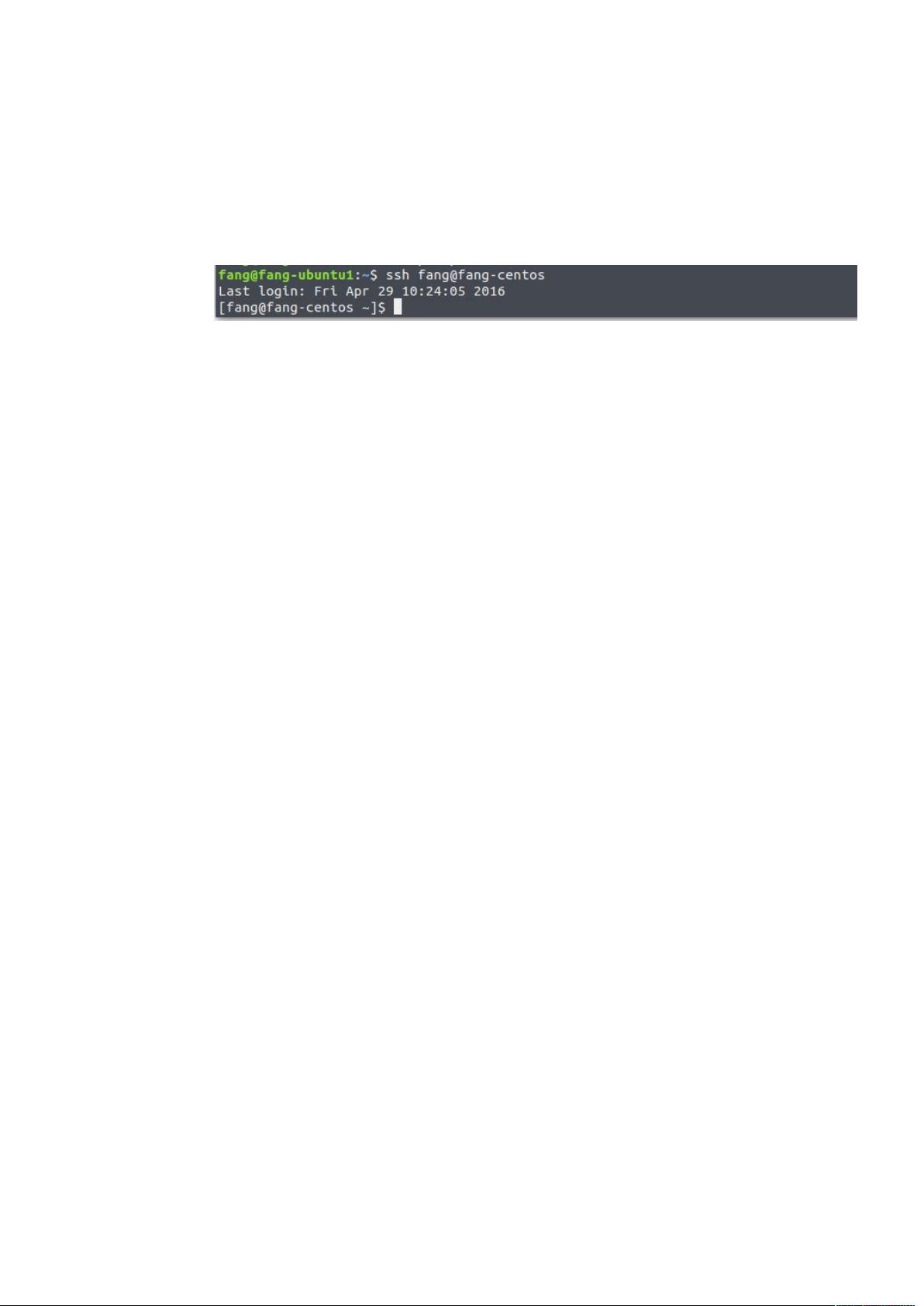

3. **设置SSH免密码登录**:

安装SSH服务器(如OpenSSH)并在所有节点上生成SSH密钥对。通过`ssh-keygen -t rsa`命令生成公钥和私钥,然后使用`scp`命令将公钥传输到Master节点。在Master节点上,将所有节点的公钥合并到`~/.ssh/authorized_keys`文件中,以便无需密码即可在节点间进行SSH访问。

4. **安装Hadoop**:

首先安装Hadoop并配置HDFS和YARN。在所有节点上配置`core-site.xml`、`hdfs-site.xml`、`yarn-site.xml`和`mapred-site.xml`等配置文件。这些配置文件会定义Hadoop集群的存储和计算策略。

5. **配置Spark**:

下载Spark并解压到指定目录。修改Spark的配置文件`spark-defaults.conf`,设置`spark.master`为`yarn-client`或`yarn-cluster`,表明Spark将运行在Yarn之上。同时,根据Hadoop的安装路径调整`spark.yarn.jar`等参数。

6. **启动和验证**:

启动Hadoop的NameNode、DataNode、ResourceManager和NodeManager服务。然后,在Spark的bin目录下,使用`spark-submit`命令提交一个简单的Spark程序,测试Spark on Yarn集群是否正常运行。

7. **监控和维护**:

通过Hadoop的Web UI监控HDFS和YARN的状态,通过Spark的Web UI监控Spark作业的执行情况。定期检查日志文件,以确保没有错误或警告信息。

8. **故障排查**:

如果遇到问题,首先检查配置文件是否有误,如hosts文件、SSH设置、Hadoop和Spark的配置。其次,查看日志文件定位错误,根据错误信息进行相应的解决。

在实践中,搭建Spark on Yarn集群可能需要根据具体环境和需求进行调整。理解每个组件的作用和配置选项是成功部署的关键。此外,保持软件更新和安全是运维中的重要环节,定期升级和修补漏洞能确保集群的稳定性和安全性。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-10-15 上传

2022-10-15 上传

2021-05-18 上传

2023-07-27 上传

2023-04-26 上传

2021-01-07 上传

Nonowiwi

- 粉丝: 1

- 资源: 2

最新资源

- 25175员工工资管理系统 2.0 build20111230

- DragonFace_V2_2_3_20150122.rar

- docker-compose-pi-hole:我的pihole docker-compose设置

- AE音频可视化43.zipae轨道音频可视化模板文件,专门用于制作二次元音乐播放视频 视频剪辑必备 压缩文件解压即可,winal

- online-Question-Answer_Django

- f793gp.zip 夜间节能上网,畅通应用工程,实际上很好用,呱呱叫

- 自动开关机系统原理图及PCB

- GC jQuery UI theme switcher:jQuery插件提供了一个jQuery UI对话框来更改UI主题CSS-开源

- ahmedabadexplorer:适用于Ahmedabad人民的完整城市指南应用程序

- javastream源码-kafka_spark_gazebo:简单的Java源代码,用于在Gazebo/ROS实现之上运行ApacheKaf

- 网奇cms网站管理系统 5.7

- marlene353.github.io

- 公司股东合作协议.zip

- PDF Logo Remover 1.0.rar

- matlab路由协议源码-wagtailcodeblock:带有实时PrismJS语法突出显示的WagtailCMS的StreamField代

- 基于python开发的贸易数据查询软件v1.0下载