深入解析Hadoop源码:分布式存储与MapReduce框架

需积分: 10 170 浏览量

更新于2024-07-21

1

收藏 6.2MB PDF 举报

Hadoop代码分析深入探讨了Google的分布式云计算核心技术在Apache Hadoop框架中的应用和实现。Hadoop项目起源于对Google Cluster、Chubby、GFS、BigTable和MapReduce这五项关键技术的模仿和开源。其中:

1. Chubby被Apache的ZooKeeper所继承,提供了分布式环境下的统一命名服务,确保数据的一致性。

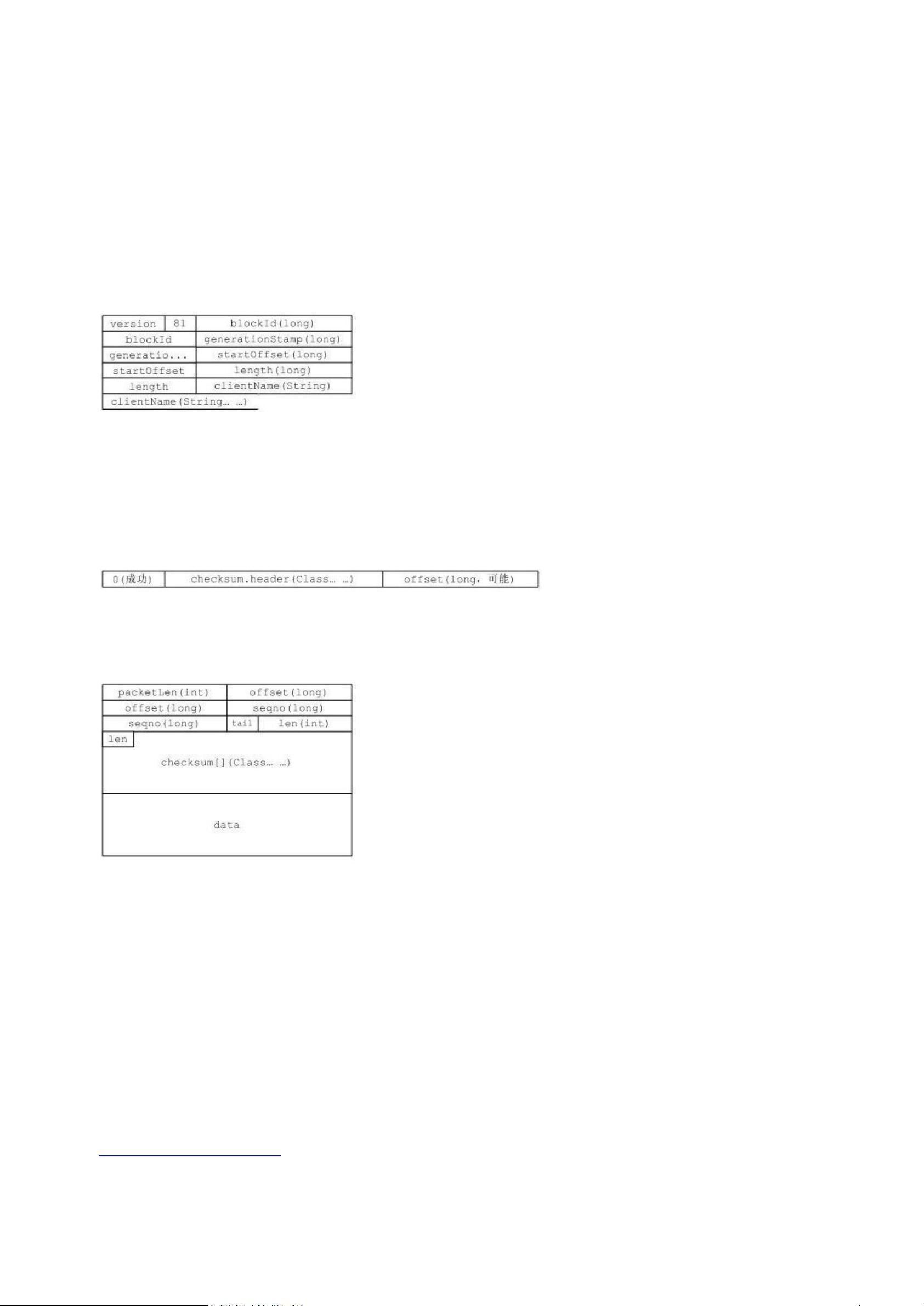

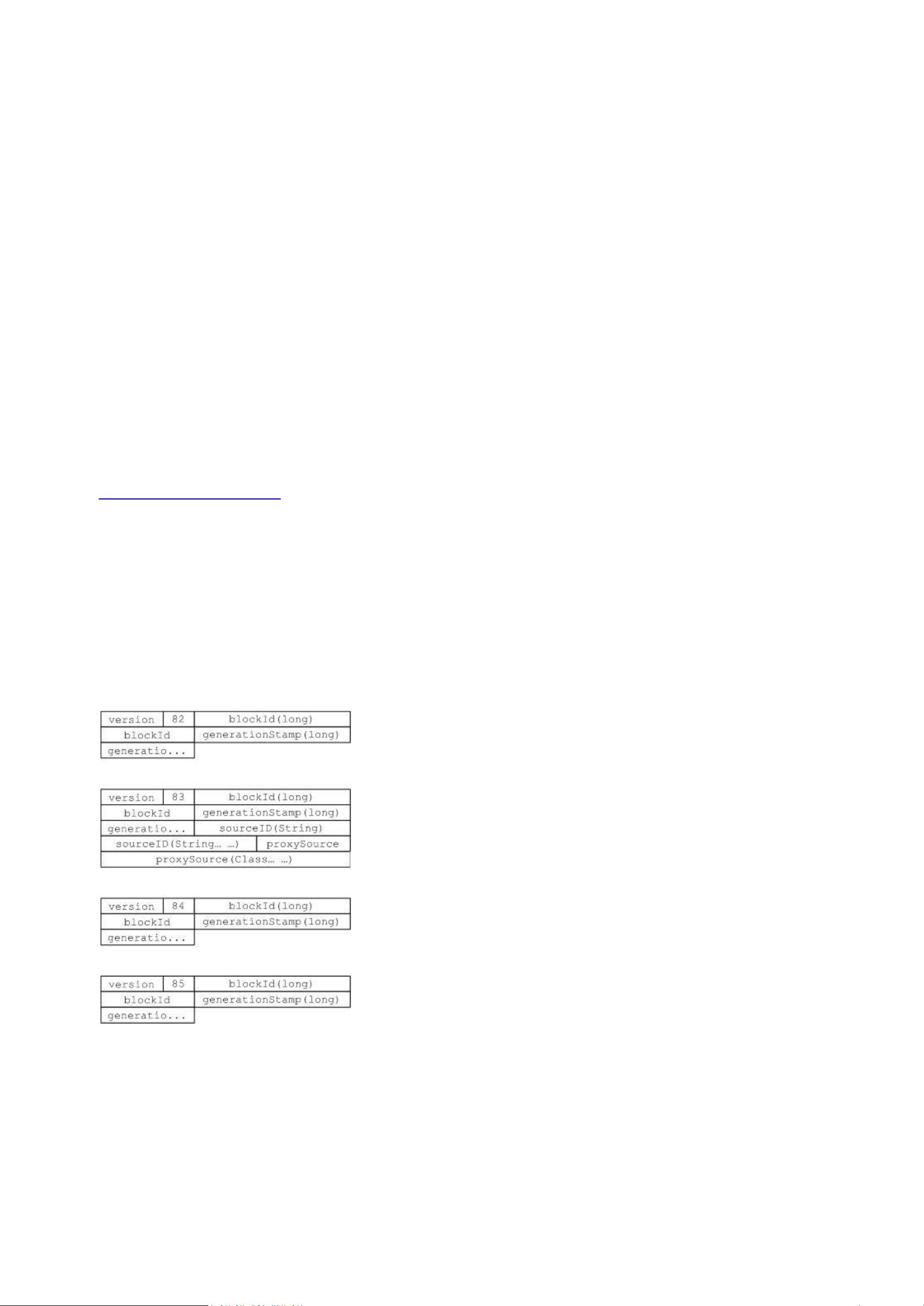

2. Google File System (GFS)的理念被转化为Hadoop Distributed File System (HDFS),它是一个高可用、高扩展性的分布式文件系统,为大数据处理提供存储支持。

3. BigTable的概念演化成了HBase,一个分布式列式数据库,适合海量数据的查询和管理。

4. MapReduce的实现则是Hadoop的核心组件,负责分布式任务的调度和执行,通过其编程模型简化了大规模数据处理的复杂性。

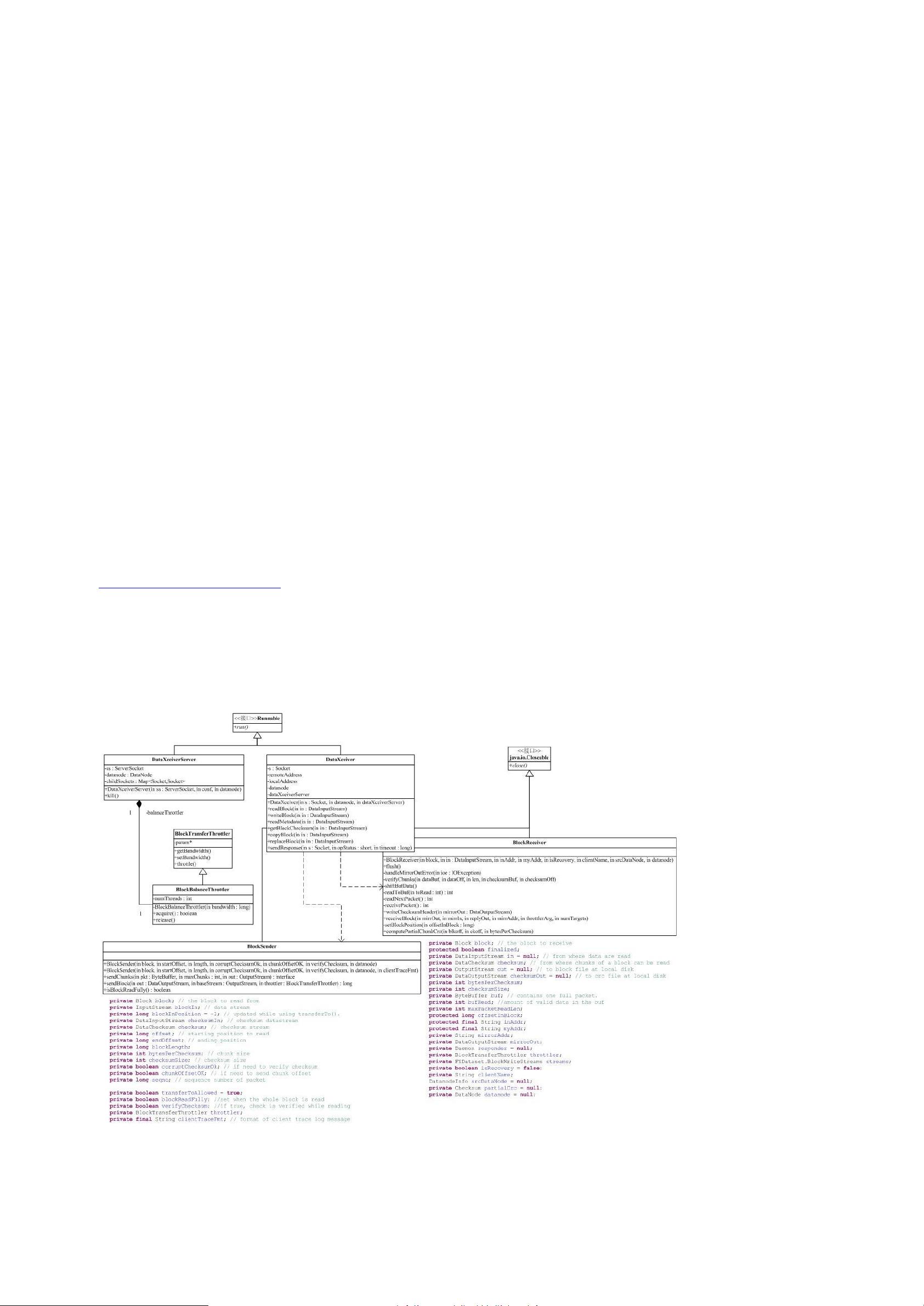

Hadoop包间的依赖关系复杂,因为HDFS作为一个基础模块,提供了API来隐藏底层实现细节,使得不同层次的功能可以无缝集成。例如,conf包依赖于fs包,因为系统配置的读取涉及到了文件系统操作,而fs包进一步抽象了文件系统功能,形成了一种网状的依赖结构。

Hadoop的关键部分主要集中在图中的蓝色区域,即HDFS和MapReduce。对于HDFS的分析,有助于理解其他基于Hadoop的系统,因为它构成了整个框架的基石。而MapReduce则包含了编程接口和分布式计算引擎,是Hadoop的灵魂。

后续的Hadoop源代码分析将分别对各个包的功能进行深入剖析,包括提供实用工具的tool包,以及与数据处理、文件操作等紧密相关的其他组件。通过对Hadoop源代码的逐个模块研究,开发者可以更好地掌握Hadoop的工作原理,优化性能,以及如何扩展和定制这一强大的大数据处理框架。

773 浏览量

2016-09-09 上传

2022-03-12 上传

2011-05-21 上传

107 浏览量

2022-06-06 上传

2021-03-04 上传

2012-06-19 上传

2011-09-01 上传

2024-12-22 上传

青山酒旗

- 粉丝: 3

- 资源: 12