Hadoop源代码深度解析:HDFS与MapReduce核心技术

需积分: 41 195 浏览量

更新于2024-07-27

收藏 5.99MB PDF 举报

Hadoop源代码分析主要关注的是Google开源的大数据处理框架,特别是其核心组件Hadoop MapReduce和分布式文件系统HDFS。这些技术在Google内部被用于构建高效、可扩展的计算平台,随后被Apache社区采纳并发展为Hadoop项目,成为了大数据处理领域的重要基石。

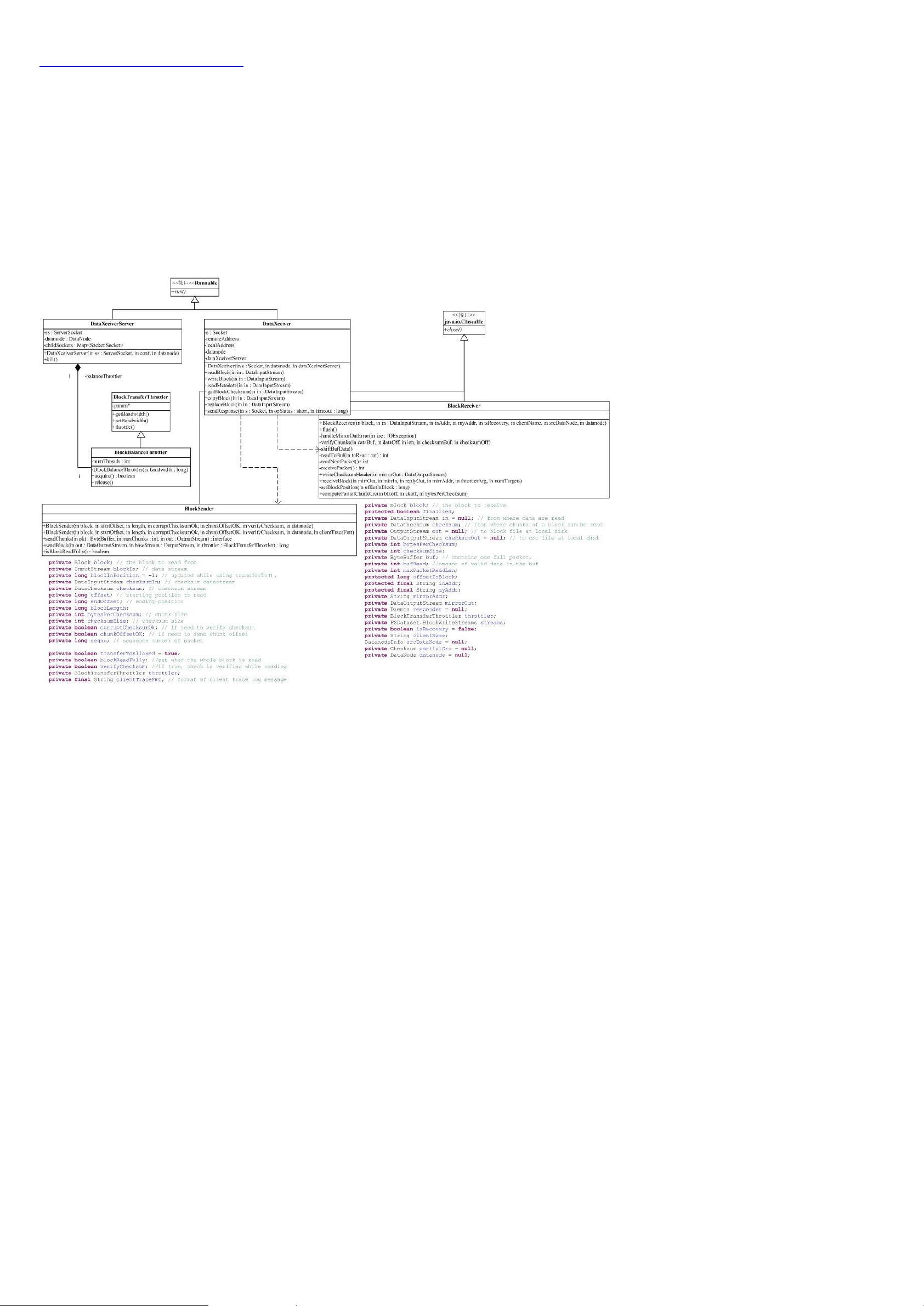

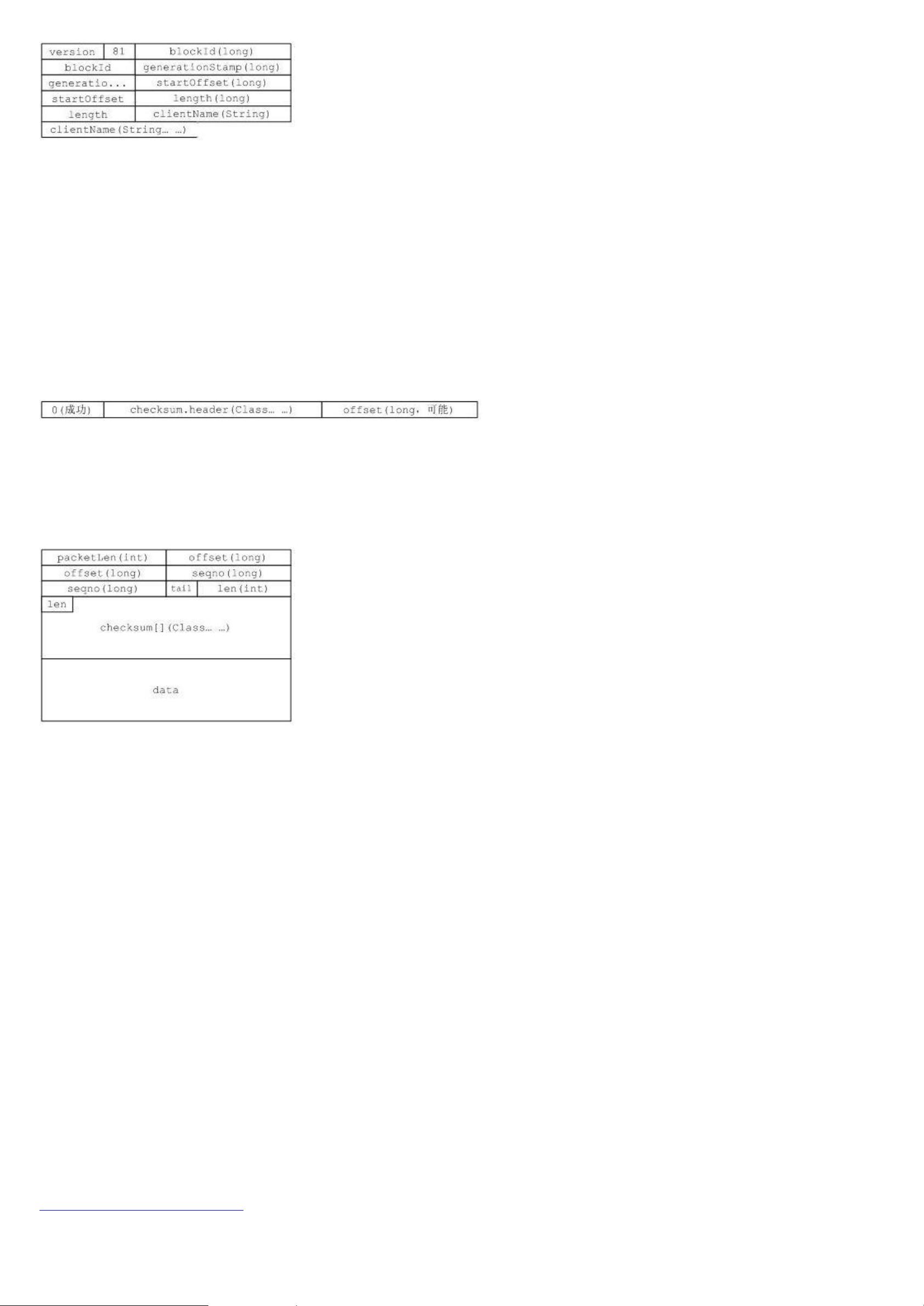

GoogleCluster、Chubby、GFS、BigTable和MapReduce这五篇文章详细介绍了Google的分布式计算技术,其中Chubby、GFS、BigTable分别对应了Apache Hadoop中的ZooKeeper、HDFS和HBase。HDFS作为分布式文件系统,提供了分布式环境下的文件存储和访问能力,它是Hadoop生态系统的基础。由于HDFS的通用性和接口设计,它能够支持多种底层存储,如本地文件系统和云存储服务,这导致了Hadoop包之间的依赖关系相对复杂。

在Hadoop的顶层结构中,图示显示了关键模块的依赖关系,包括工具包(如DistCp和archive等)、MapReduce框架本身以及与HDFS紧密相关的模块。Hadoop的核心部分,如蓝色区域所示,着重在于分布式文件系统和分布式计算引擎的设计与实现。这部分代码分析有助于理解如何在集群环境中管理和处理大规模数据,同时保证了系统的容错性和性能优化。

深入分析Hadoop源代码,开发者可以学习到如何设计高效的分布式系统,包括负载均衡、数据复制、错误检测和恢复机制,以及如何利用抽象接口隐藏底层复杂性。此外,Hadoop的编程模型(如MapReduce的工作流程)也为开发者提供了处理海量数据的强大工具。Facebook的Hive也是基于类似思想的开源项目,但专注于更高级的数据查询和分析。

通过研究Hadoop源代码,开发人员不仅可以提升对分布式计算和数据存储的理解,还可以借此优化自己的应用程序,使其能够在Hadoop生态中无缝运行。同时,这也有助于应对不断变化的技术趋势和大数据处理的挑战。

2022-03-12 上传

2013-01-13 上传

2013-10-11 上传

2011-05-21 上传

madao_00191980

- 粉丝: 2

- 资源: 4

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载