大数据处理技术演进:从Hadoop到Storm实时架构

需积分: 18 153 浏览量

更新于2024-08-24

收藏 1.38MB PDF 举报

"大数据处理技术架构的演进"

大数据处理技术随着互联网应用的发展经历了显著的变化,尤其是对于实时性需求的提升。本文主要讨论了Hadoop离线处理架构的局限性和Storm实时处理架构的优势,以及在实际项目中如何进行架构的转变以满足实时业务需求。

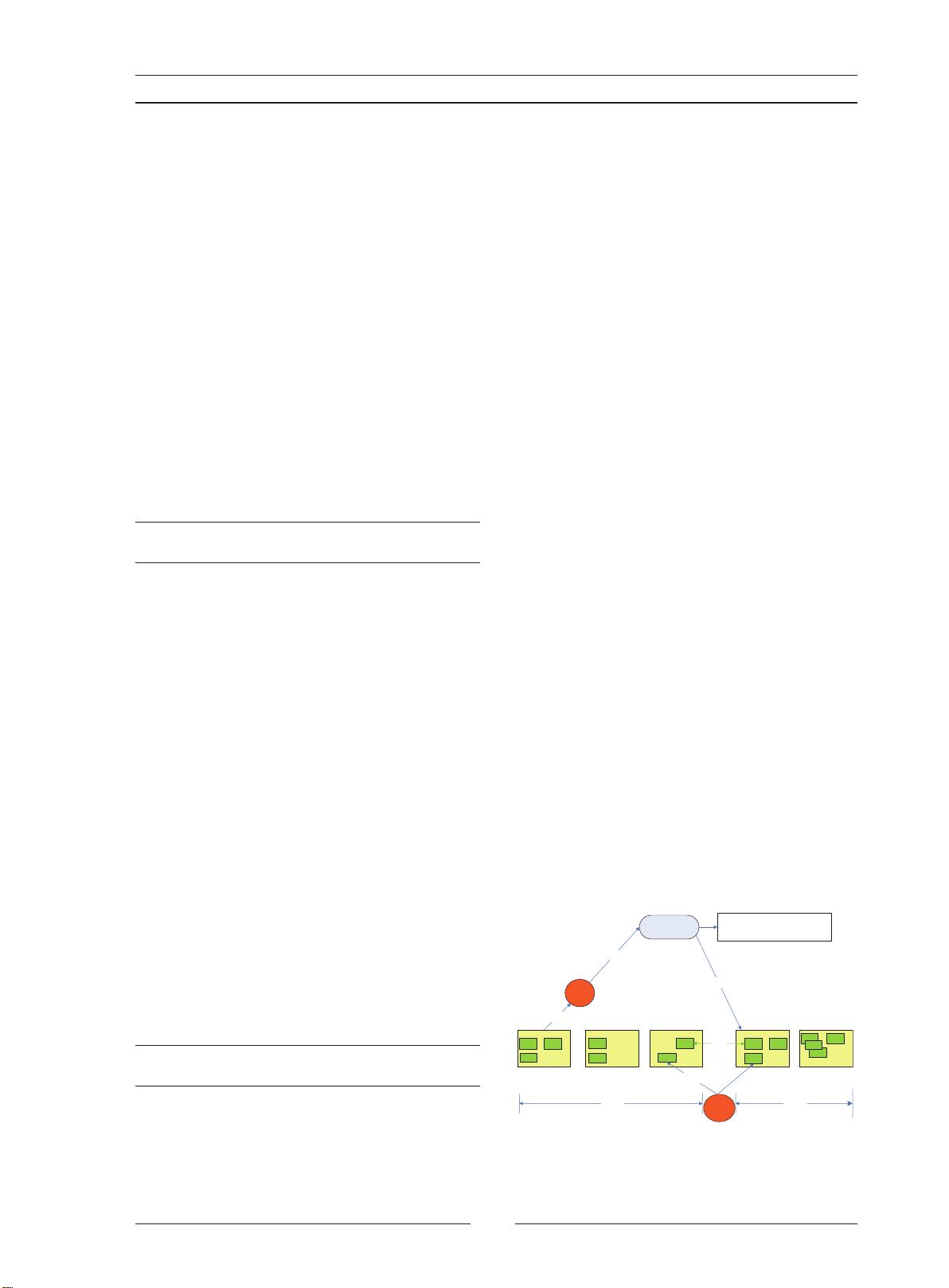

Hadoop是大数据处理领域的里程碑,它基于GFS和MapReduce的理念,通过分布式计算解决了大规模数据处理的问题。Hadoop架构的核心是HDFS和MapReduce。HDFS是一个主从结构的文件系统,NameNode作为主节点管理文件系统的元数据,而Datanodes则存储实际的数据块。这种设计使得Hadoop能处理PB级别的数据,但其批量处理的特性导致在实时性方面存在不足。

随着Web2.0时代的到来,如微博等应用的出现,对数据处理的实时性提出了更高的要求。Hadoop在处理这些实时需求时表现出明显的瓶颈,主要体现在以下几个方面:

1. 批量处理:Hadoop的计算模型是基于批量数据输入和输出的,这使得它无法快速响应实时查询或流式数据处理。

2. 延迟问题:由于Hadoop需要等待数据完全收集并进行批量处理,因此在处理时间敏感的业务时,延迟问题尤为突出。

3. 效率限制:在数据更新频繁的场景下,Hadoop需要频繁地重读和重写数据,这降低了处理效率。

为解决这些问题,Twitter开发了Storm实时处理框架。Storm采用流式处理模式,能够持续处理无界数据流,提供低延迟的实时计算。与Hadoop不同,Storm处理数据是连续不断的,一旦数据到达,就会立即进行处理,无需等待数据集的完整收集。

在实施架构变更过程中,关键的技术包括:

1. 数据迁移:从Hadoop迁移到Storm可能涉及到大量数据的迁移,需要考虑数据的完整性和一致性。

2. 流处理设计:在Storm中,需要重新设计数据处理流程,确保实时性和准确性。

3. 性能优化:针对实时处理,需要对系统进行性能调优,如减少延迟、提高吞吐量等。

4. 故障恢复:实时系统需要强大的容错机制,确保在节点故障时仍能保持服务的连续性。

通过实验验证,采用Storm实时处理架构可以有效提高大数据处理的实时性,满足业务需求。然而,选择合适的架构取决于具体业务场景,例如,对于历史数据分析或离线任务,Hadoop仍然是一个高效的选择。

大数据处理技术架构的演进反映了技术对业务需求的适应性变化。从Hadoop的离线处理到Storm的实时处理,不仅揭示了技术的进步,也体现了对数据处理实时性追求的不断提升。随着技术的不断演进,未来可能会有更多适应各种业务场景的处理架构出现,以满足多样化的数据处理需求。

2021-08-15 上传

2019-04-04 上传

2021-01-27 上传

2021-02-20 上传

2021-01-19 上传

2022-08-04 上传

2021-09-27 上传

2022-06-18 上传

2020-10-26 上传

weixin_38747025

- 粉丝: 129

- 资源: 1108

最新资源

- WordPress作为新闻管理面板的实现指南

- NPC_Generator:使用Ruby打造的游戏角色生成器

- MATLAB实现变邻域搜索算法源码解析

- 探索C++并行编程:使用INTEL TBB的项目实践

- 玫枫跟打器:网页版五笔打字工具,提升macOS打字效率

- 萨尔塔·阿萨尔·希塔斯:SATINDER项目解析

- 掌握变邻域搜索算法:MATLAB代码实践

- saaraansh: 简化法律文档,打破语言障碍的智能应用

- 探索牛角交友盲盒系统:PHP开源交友平台的新选择

- 探索Nullfactory-SSRSExtensions: 强化SQL Server报告服务

- Lotide:一套JavaScript实用工具库的深度解析

- 利用Aurelia 2脚手架搭建新项目的快速指南

- 变邻域搜索算法Matlab实现教程

- 实战指南:构建高效ES+Redis+MySQL架构解决方案

- GitHub Pages入门模板快速启动指南

- NeonClock遗产版:包名更迭与应用更新