深度学习中的BN层详解:加速训练,缓解梯度消失

需积分: 0 155 浏览量

更新于2024-08-05

收藏 1.13MB PDF 举报

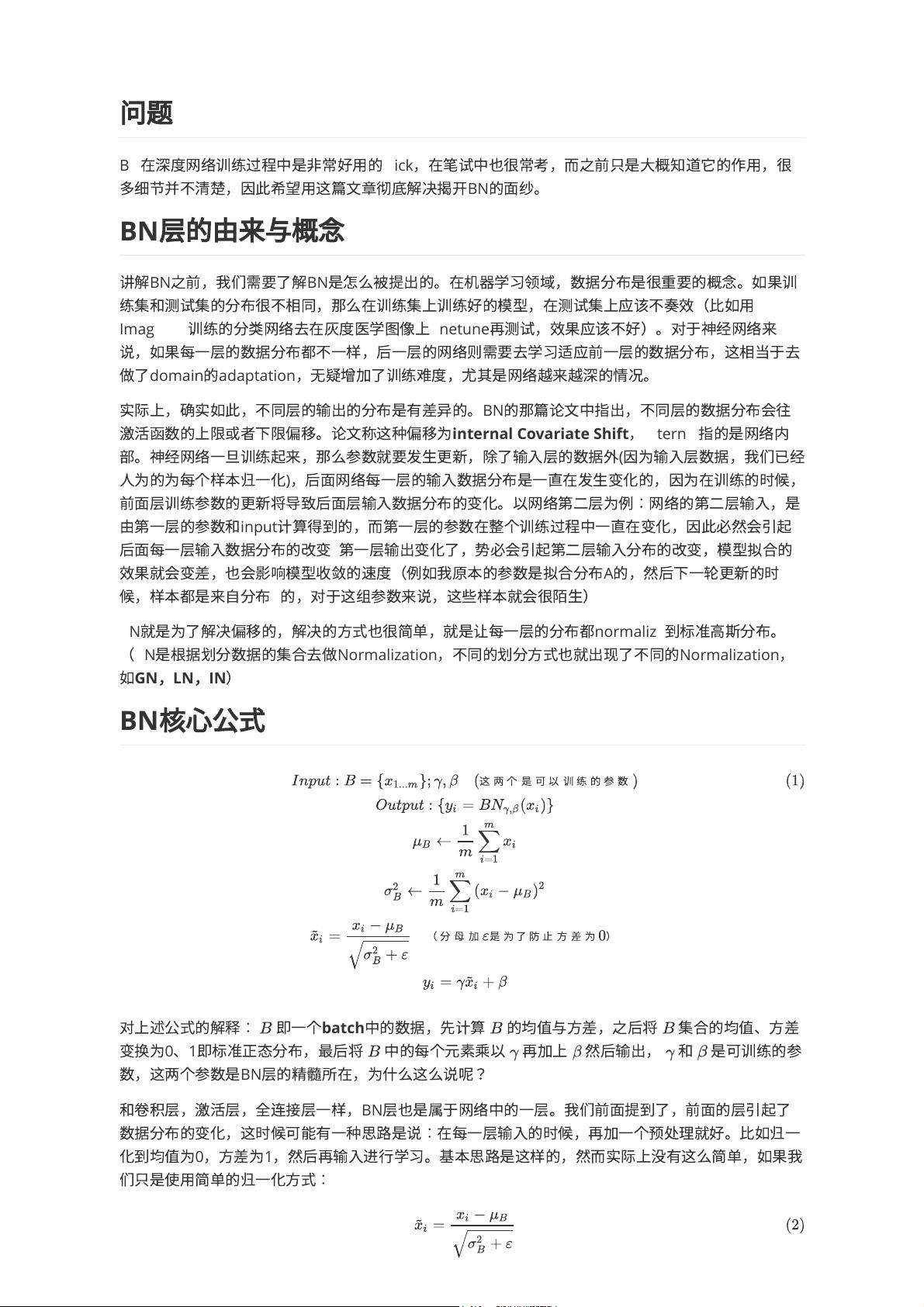

"这篇文章主要探讨了BN层(Batch Normalization层)在深度学习中的作用,以及它是如何解决内部协变量转移(internal Covariate Shift)问题的。BN层通过规范化每一层的数据分布,使得网络能够更快地训练,并防止梯度消失。文章还提到了BN层的核心公式,以及可训练的参数伽马(γ)和贝塔(β)的作用。"

深度学习中,BN层的引入是为了解决一系列关键问题。首先,BN层有助于防止梯度消失,这对于深度神经网络至关重要,尤其是在使用如Sigmoid这样的饱和激活函数时,梯度消失可能导致网络难以训练。通过标准化输入,BN层可以确保梯度在反向传播过程中的稳定性,从而更有效地训练深层网络。

其次,BN层能加速训练过程,并允许使用更大的学习率。在没有BN的情况下,由于数据分布的变化,网络需要调整权重以适应新的分布,这可能导致训练速度减慢。BN层通过保持每层输入数据的标准化,减少了这种适应的需求,使得网络可以使用更大的学习率进行训练,从而提高训练效率。

BN层的核心在于它对数据进行的规范化处理。对于每个批次(batch)的数据,BN层首先计算其均值和方差,然后将数据转换到标准正态分布(均值为0,方差为1),这一步称为批标准化。随后,通过可训练的参数γ和β,可以调整规范化后的数据分布,使得网络能够在保持标准化的同时,适应特定任务的特性。γ可以放大或缩小特征的尺度,而β则可以移动特征的中心位置。

除了批标准化,还有其他类型的规范化方法,如Group Normalization (GN)、Layer Normalization (LN)和Instance Normalization (IN)。它们分别以不同的方式处理数据的集合,以适应不同场景的需求。

BN层是深度学习中一个非常重要的技术,它提高了模型的训练速度,增强了模型的泛化能力,并帮助解决了深度网络中常见的训练难题。理解并熟练应用BN层,对于提升模型性能和优化训练流程具有重大意义。

2021-12-18 上传

2022-06-05 上传

2020-01-14 上传

2020-09-16 上传

2024-03-18 上传

2021-03-02 上传

2010-01-17 上传

2019-03-20 上传

2022-08-04 上传

琉璃纱

- 粉丝: 19

- 资源: 298

最新资源

- 掌握压缩文件管理:2工作.zip文件使用指南

- 易语言动态版置入代码技术解析

- C语言编程实现电脑系统测试工具开发

- Wireshark 64位:全面网络协议分析器,支持Unix和Windows

- QtSingleApplication: 确保单一实例运行的高效库

- 深入了解Go语言的解析器组合器PARC

- Apycula包安装与使用指南

- AkerAutoSetup安装包使用指南

- Arduino Due实现VR耳机的设计与编程

- DependencySwizzler: Xamarin iOS 库实现故事板 UIViewControllers 依赖注入

- Apycula包发布说明与下载指南

- 创建可拖动交互式图表界面的ampersand-touch-charts

- CMake项目入门:创建简单的C++项目

- AksharaJaana-*.*.*.*安装包说明与下载

- Arduino天气时钟项目:源代码及DHT22库文件解析

- MediaPlayer_server:控制媒体播放器的高级服务器