Hadoop源代码分析:分布式文件系统和MapReduce实现解析

需积分: 9 136 浏览量

更新于2024-07-25

收藏 5.91MB DOC 举报

Hadoop 源代码分析完整版

Hadoop 是一个开源的分布式计算系统,由 Apache 开发,用于处理大规模数据的存储和处理。Hadoop 的核心组件包括 HDFS(Hadoop Distributed File System)和 MapReduce。HDFS 是一个分布式文件系统,用于存储大规模数据,而 MapReduce 是一个计算框架,用于处理大规模数据。

**HDFS(Hadoop Distributed File System)**

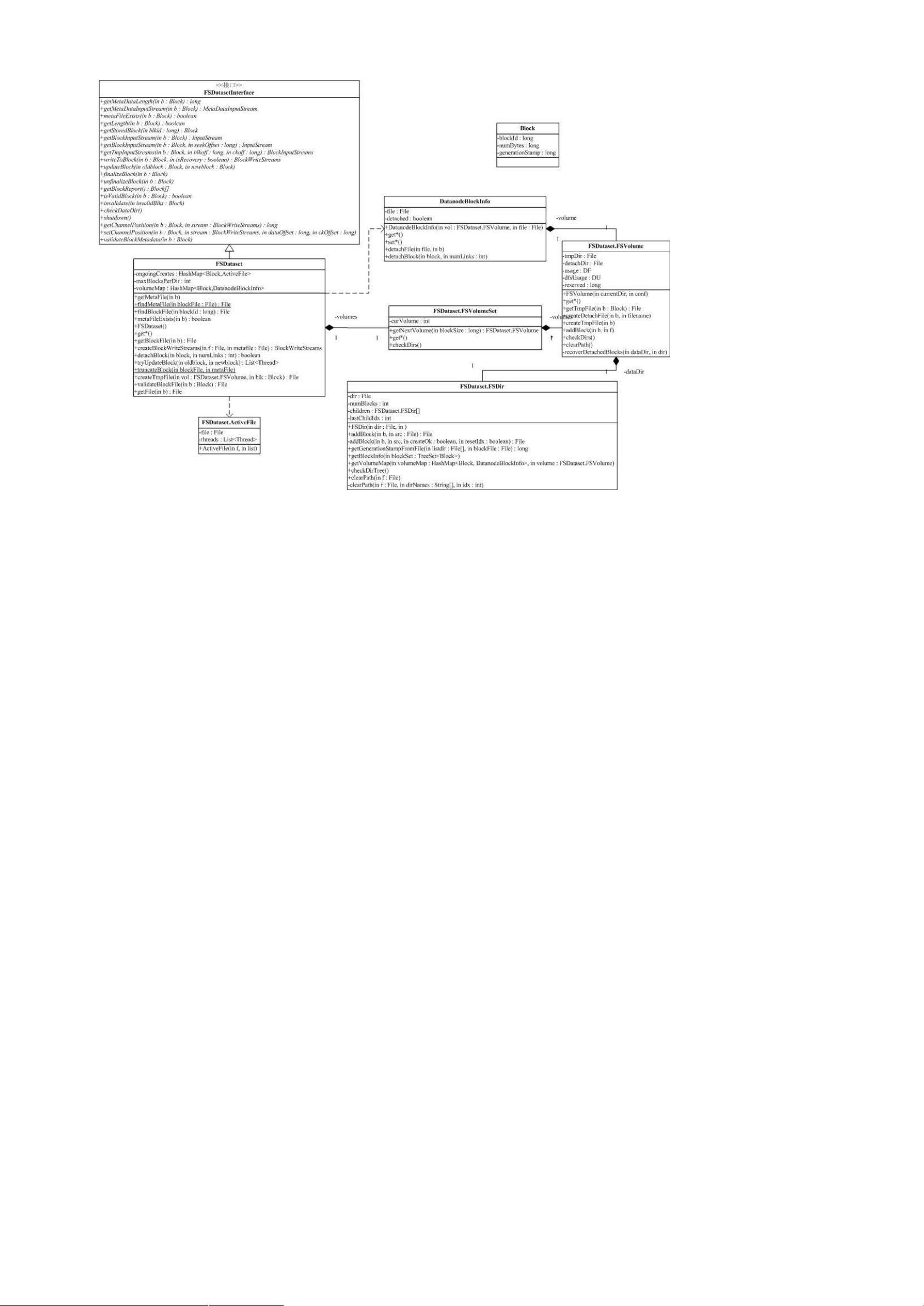

HDFS 是 Hadoop 的核心组件之一,用于存储大规模数据。HDFS 是一个分布式文件系统,能够存储大量数据,具有高可用性和高可扩展性。HDFS 由两部分组成:NameNode 和 DataNode。NameNode 负责维护文件系统的命名空间,而 DataNode 负责存储文件数据。

HDFS 的架构如下:

* NameNode:维护文件系统的命名空间,负责文件的创建、删除和修改。

* DataNode:存储文件数据,负责数据的读取和写入。

* Client:提供了访问 HDFS 的接口,用户可以通过 Client 来访问 HDFS。

HDFS 的特点包括:

* 高可用性:HDFS 能够自动地冗余数据,以便在出现故障时能够快速恢复。

* 高可扩展性:HDFS 能够水平扩展,以便处理大规模数据。

* 高性能:HDFS 能够提供高性能的数据读写操作。

**MapReduce**

MapReduce 是 Hadoop 的另一个核心组件,用于处理大规模数据。MapReduce 是一个计算框架,能够将复杂的计算任务分解成小规模的任务,以便并行处理。MapReduce 的架构如下:

* Mapper:负责将输入数据分解成小规模的任务。

* Reducer:负责将 Mapper 的输出结果合并成最终结果。

* JobTracker:负责调度 MapReduce 任务,负责任务的分配和监控。

MapReduce 的特点包括:

* 高可扩展性:MapReduce 能够水平扩展,以便处理大规模数据。

* 高性能:MapReduce 能够提供高性能的计算操作。

* 高可靠性:MapReduce 能够自动地处理故障,以便提供高可靠性的计算服务。

**Hadoop 的关键部分**

Hadoop 的关键部分集中于蓝色部分,包括 HDFS 和 MapReduce。HDFS 负责存储大规模数据,而 MapReduce 负责处理大规模数据。

**Hadoop 的依赖关系**

Hadoop 的依赖关系比较复杂,原因是 HDFS 提供了一个分布式文件系统,该系统提供 API,可以屏蔽本地文件系统和分布式文件系统,甚至象 Amazon S3 这样的在线存储系统。这就造成了分布式文件系统的实现,或者是分布式文件系统的底层的实现,依赖于某些貌似高层的功能。功能的相互引用,造成了蜘蛛网型的依赖关系。

一个典型的例子就是包 conf,conf 用于读取系统配置,它依赖于 fs,主要是读取配置文件的时候,需要使用文件系统,而部分的文件系统的功能,在包 fs 中被抽象了。

**Hadoop 的应用**

Hadoop 的应用非常广泛,包括:

* 数据分析:Hadoop 能够处理大规模数据,用于数据分析和挖掘。

* 数据存储:Hadoop 能够存储大规模数据,用于数据仓库和数据挖掘。

* 云计算:Hadoop 能够提供云计算服务,用于大规模数据的处理和存储。

Hadoop 是一个功能强大且灵活的分布式计算系统,能够处理大规模数据,具有高可用性、高可扩展性和高性能的特点。

2022-03-12 上传

2021-09-06 上传

6675 浏览量

2012-01-05 上传

773 浏览量

2013-09-12 上传

2013-10-23 上传

2022-06-18 上传

奋斗de蜗牛

- 粉丝: 0

- 资源: 7

最新资源

- NIST REFPROP问题反馈与解决方案存储库

- 掌握LeetCode习题的系统开源答案

- ctop:实现汉字按首字母拼音分类排序的PHP工具

- 微信小程序课程学习——投资融资类产品说明

- Matlab犯罪模拟器开发:探索《当蛮力失败》犯罪惩罚模型

- Java网上招聘系统实战项目源码及部署教程

- OneSky APIPHP5库:PHP5.1及以上版本的API集成

- 实时监控MySQL导入进度的bash脚本技巧

- 使用MATLAB开发交流电压脉冲生成控制系统

- ESP32安全OTA更新:原生API与WebSocket加密传输

- Sonic-Sharp: 基于《刺猬索尼克》的开源C#游戏引擎

- Java文章发布系统源码及部署教程

- CQUPT Python课程代码资源完整分享

- 易语言实现获取目录尺寸的Scripting.FileSystemObject对象方法

- Excel宾果卡生成器:自定义和打印多张卡片

- 使用HALCON实现图像二维码自动读取与解码