自定义Pytorch全连接层:nn.Module实践

173 浏览量

更新于2024-08-29

1

收藏 485KB PDF 举报

PyTorch是一个广泛使用的深度学习框架,其神经网络工具箱torch.nn为构建和训练深度学习模型提供了强大的支持。在这个章节中,主要关注的是如何利用torch.nn.Module来创建自定义的神经网络层,如全连接层(也称为线性层)。

4.1 nn.Module

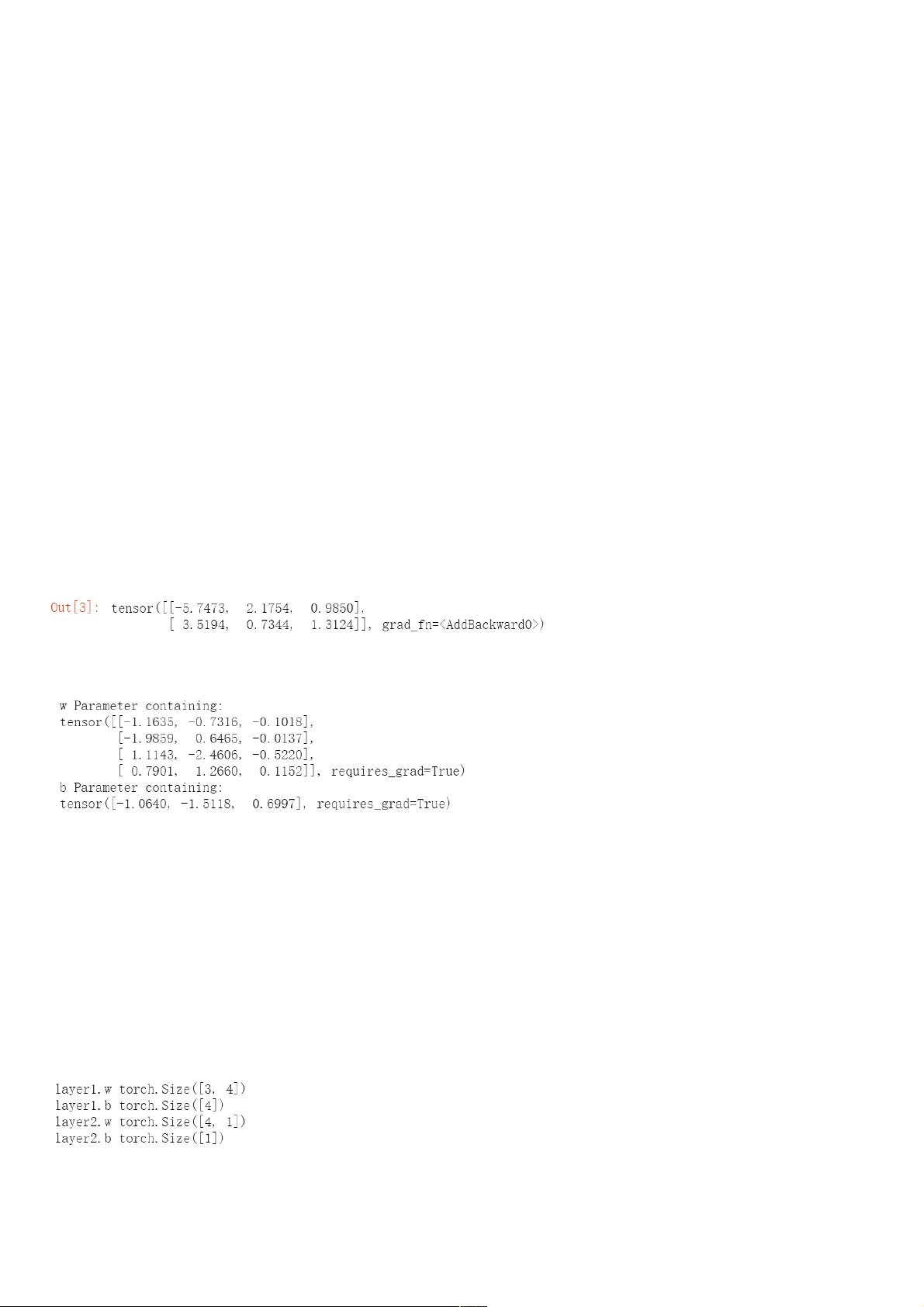

`nn.Module` 是 `torch.nn` 模块的核心,它是一个抽象基类,用于表示深度学习模型中的每个可训练组件。通过继承 `nn.Module`,开发者可以方便地定义新的层,并利用框架提供的便利功能,如自动求导、参数管理等。在 `nn.Module` 中,重要的概念包括:

1. 构造方法 (`__init__`):

- 类中的构造方法带有双下划线,这是Python的特殊语法,表示它是魔术方法,会在实例化时被解释器自动调用。

- `super(Linear, self).__init__()` 表示子类 `Linear` 继承自 `nn.Module`,并调用父类的构造方法初始化。

- 在构造方法中,开发者需要明确指定可学习的参数,例如权重 `w` 和偏置 `b`。这些参数通过 `nn.Parameter` 包装,使得它们可以被框架跟踪并更新。

2. 参数管理:

- `nn.Parameter` 是 `nn.Module` 的一个重要特性,它将 `torch.Tensor` 转换为可训练的参数,即在反向传播中可以自动调整的变量。`nn.Parameter` 要求其内部的 `Variable` 具备 `requires_grad` 属性,以便在梯度计算时考虑。

3. 前向传播 (`forward`):

- 这是每个自定义层的核心函数,接收输入 `x`,对其进行处理(如矩阵乘法 `.mm()`),然后添加偏置 `self.b.expand_as(x)`,最后返回处理后的输出。

- `expand_as(x)` 方法确保了偏置与输入张量具有相同的形状,以便进行有效的矩阵运算。

4. 实例化和使用:

- 通过创建 `Linear` 类的实例,如 `layer = Linear(in_features, out_features)`,我们可以创建一个具体的全连接层对象。实例化时,`in_features` 和 `out_features` 分别代表输入特征维度和输出维度。

通过理解 `nn.Module` 的工作原理和如何创建自定义层,开发者可以更高效地构建复杂的神经网络结构,如多层感知机(MLP)、卷积神经网络(CNN)或循环神经网络(RNN)。此外,`torch.nn` 提供了诸如激活函数、池化层、批量归一化等功能,使得构建现代深度学习模型变得更加简单。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-07-23 上传

点击了解资源详情

2021-05-27 上传

2021-04-29 上传

2018-11-28 上传

2019-09-07 上传

weixin_38716563

- 粉丝: 5

- 资源: 871

最新资源

- Sentinel-1.8.1

- GU620:毕设-----在MODBUS协议下android与控制器GU620的通信

- Perthon Python-to-Perl Source Translator-开源

- dev-portfolio

- CourseaHTML

- URL缩短器:使用JavaScript,Node.js,MongoDB和Express的URL缩短器

- 【Java毕业设计】java毕业设计,ssm毕业设计,在线考试管理系统,源码带论文.zip

- dbR:数据库和R

- CaptainsBacklog:Scrum开发人员培训

- Android-Network-Service-Discovery:Android NSD 易学项目..

- quynhhgoogoo:描述

- maven-hadoop-java-wordcount-template:这是一个 Maven Hadoop Java 项目模板。 这个样板框架代码包含一个 Driver、一个 Mapper 和一个 Reducer,可以用你的代码修改(它们包含经典的 wordcount 示例)

- 【Java毕业设计】java 基于Spring Boot2.X的后台权限管理系统,适合于学习Spring Boot开.zip

- python实例-14 名言查询.zip源码python项目实例源码打包下载

- Book_Search

- dictionary-project